Seleção de câmera para Azure IoT Edge vision AI

Um dos componentes mais críticos em um sistema de visão computacional é a câmera. A câmera deve capturar e apresentar imagens que os modelos de inteligência artificial (IA) ou aprendizado de máquina (ML) possam avaliar e identificar corretamente. Este artigo fornece uma compreensão aprofundada de diferentes tipos de câmeras, recursos e considerações.

Tipos de câmaras

Os tipos de câmera incluem varredura de área, varredura de linha e câmeras inteligentes incorporadas. Existem muitos fabricantes diferentes para essas câmeras. Selecione um fornecedor que atenda às suas necessidades específicas.

Câmaras de varredura de área

As câmeras de varredura de área geram uma imagem de câmera tradicional. Esta câmera normalmente tem uma matriz de sensores de pixel. A câmera captura uma imagem 2D e a envia para o hardware do Azure IoT Edge para avaliação.

As câmeras de varredura de área olham para uma grande área e são boas para detetar alterações. Exemplos de cargas de trabalho que podem usar câmeras de varredura de área são a segurança no local de trabalho ou a deteção ou contagem de objetos em um ambiente.

Câmeras de varredura de linha

Uma câmera de varredura de linha tem uma única fileira de sensores lineares de pixel. A câmera tira imagens de 1 pixel de largura em rápida sucessão, junta-as em um fluxo de vídeo e envia o fluxo para o dispositivo IoT Edge para processamento.

As câmeras de varredura de linha são boas para cargas de trabalho de visão em que os itens estão passando pela câmera ou precisam ser girados para detetar defeitos. A câmera de varredura de linha produz um fluxo contínuo de imagem para avaliação. Exemplos de cargas de trabalho que funcionam melhor com câmeras de varredura de linha são:

- Deteção de defeitos de itens em peças que estão se movendo em uma correia transportadora

- Cargas de trabalho que exigem rotação para ver um objeto cilíndrico

- Cargas de trabalho que exigem rotação

Câmaras inteligentes incorporadas

Uma câmara inteligente incorporada é um sistema autónomo e autónomo que pode processar e adquirir imagens. As câmeras inteligentes incorporadas podem usar uma varredura de área ou uma câmera de varredura de linha para capturar imagens, embora uma câmera inteligente de varredura de linha seja rara. Essas câmeras geralmente têm uma porta de saída RS232 ou Ethernet, para que possam se integrar diretamente a um controlador lógico programável (PLC) ou outro controlador IoT industrial (IIoT).

Características da câmara

Há vários recursos a considerar ao selecionar uma câmera para uma carga de trabalho de visão. As seções a seguir discutem o tamanho, a resolução e a velocidade do sensor. Outras características da câmara a considerar incluem:

- Seleção de lentes

- Distância focal

- Monocromático ou profundidade de cor

- Profundidade estéreo

- Acionadores

- Tamanho físico

- Suporte

Os fabricantes de câmeras podem ajudá-lo a entender quais recursos específicos seu aplicativo requer.

Tamanho do sensor

O tamanho do sensor é um dos fatores mais importantes para avaliar em uma câmera. O sensor é o hardware dentro de uma câmera que captura o alvo e o converte em sinais, que então produzem uma imagem. O sensor contém milhões de fotodetectores semicondutores chamados fotossítios.

Uma maior contagem de megapixels nem sempre resulta em uma imagem melhor. Por exemplo, uma câmara com 12 milhões de fotosites e um sensor de 1 polegada produz uma imagem mais clara e nítida do que uma câmara com 12 milhões de fotosites e um sensor de 1/2 polegadas. As câmeras para cargas de trabalho de visão computacional geralmente têm tamanhos de sensor entre 1/4 e 1 polegada. Alguns casos podem exigir sensores muito maiores.

Escolha sensores maiores se a sua carga de trabalho de visão tiver:

- Necessidade de medições de precisão

- Condições de menor luminosidade

- Tempos de exposição mais curtos ou itens em movimento rápido

Resolução

A resolução é outro fator importante na seleção da câmera. Você precisa de câmeras de resolução mais alta se sua carga de trabalho:

- Deve identificar características finas, como a escrita em um chip de circuito integrado

- Está tentando detetar rostos

- Necessidade de identificar veículos à distância

As imagens a seguir mostram o problema com o uso da resolução errada para um determinado caso de uso. Ambas as imagens foram tiradas a 20 metros de distância do carro. As pequenas caixas vermelhas representam um pixel.

A seguinte imagem foi tirada com 480 pixels horizontais:

A seguinte imagem foi tirada com 5184 pixels horizontais:

Velocidade

Se a sua carga de trabalho de visão requer a captura de muitas imagens por segundo, dois fatores são importantes. O primeiro fator é a velocidade da conexão da interface da câmera. O segundo fator é o tipo de sensor. Os sensores vêm em dois tipos, dispositivos acoplados à carga (CCD) e sensores de pixel ativo (CMOS). Os sensores CMOS têm uma leitura direta dos fotosites, por isso normalmente oferecem uma taxa de quadros mais alta.

Posicionamento da câmara

Os itens que você precisa capturar em sua carga de trabalho de visão determinam os locais e ângulos para o posicionamento da câmera. A localização da câmera também pode interagir com o tipo de sensor, tipo de lente e tipo de corpo da câmera. Dois dos fatores mais críticos para determinar o posicionamento da câmera são a iluminação e o campo de visão.

Iluminação da câmara

Em uma carga de trabalho de visão computacional, a iluminação é fundamental para o posicionamento da câmera. Você pode aplicar várias condições de iluminação diferentes. Condições de iluminação que são úteis para uma carga de trabalho de visão podem produzir efeitos indesejáveis em uma carga de trabalho diferente.

Existem vários tipos de iluminação comuns para cargas de trabalho de visão computacional:

- A iluminação direta é a condição de iluminação mais comum. A fonte de luz é projetada no objeto a ser capturado.

- A iluminação de linha é um único conjunto de luzes mais usado com câmeras de varredura de linha. A iluminação da linha cria uma única linha de luz no foco da câmera.

- A iluminação difusa ilumina um objeto, mas evita sombras severas. A iluminação difusa é usada principalmente em torno de objetos especulares, ou reflexivos.

- A iluminação axial difusa é frequentemente usada com objetos altamente reflexivos, ou para evitar sombras na parte a capturar.

- A iluminação traseira é usada atrás do objeto, produzindo uma silhueta do objeto. A iluminação traseira é mais útil para medições, deteção de bordas ou orientação de objetos.

- A iluminação de grade personalizada é uma condição de iluminação estruturada que estabelece uma grade de luz no objeto. A projeção de grade conhecida fornece medições mais precisas de componentes, peças e posicionamento do item.

- A iluminação estroboscópica é usada para peças móveis de alta velocidade. O strobe deve estar em sincronia com a câmera para tirar um congelamento do objeto para avaliação. A iluminação estroboscópica ajuda a evitar efeitos de desfocagem de movimento.

- A iluminação de campo escuro usa várias luzes com ângulos diferentes para a peça a ser capturada. Por exemplo, se a peça estiver deitada sobre uma correia transportadora, as luzes estarão em um ângulo de 45 graus em relação à correia. A iluminação de campo escuro é mais útil com objetos claros altamente reflexivos e é comumente usada para deteções de riscos de lentes.

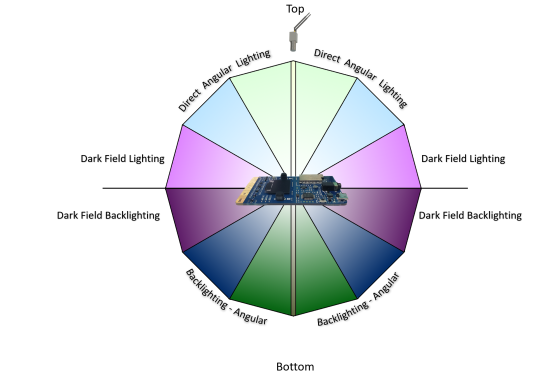

A figura a seguir demonstra o posicionamento angular das fontes de luz:

Campo de visão

Ao planejar uma carga de trabalho de visão, você precisa saber sobre o campo de visão (FOV) dos objetos que está avaliando. FOV desempenha um papel na seleção de câmeras, seleção de sensores e configuração de lentes. Os componentes FOV incluem:

- Distância aos objetos. Por exemplo, o objeto está sendo monitorado em uma correia transportadora com a câmera dois metros acima dela, ou através de um estacionamento? Sensores de câmera e configurações de lente são diferentes para diferentes distâncias.

- Área de cobertura. A área que a visão computacional está tentando monitorar é pequena ou grande? Esse fator se correlaciona diretamente com a resolução, lente e tipo de sensor da câmera.

- Direção do sol. Se a carga de trabalho de visão computacional estiver ao ar livre, você deve considerar a direção do sol ao longo do dia. O ângulo do sol à medida que se move pode afetar o modelo de visão computacional. Se a câmera receber luz solar direta na lente, ela pode ficar cega até que o ângulo do sol mude. Se o sol projeta uma sombra sobre o objeto que está sendo monitorado, o objeto pode estar obscurecido.

- Ângulo da câmera para os objetos. Se a câmera for muito alta ou muito baixa, ela pode perder os detalhes que a carga de trabalho está tentando capturar.

Interface de comunicação

Ao planejar uma carga de trabalho de visão computacional, é importante entender como a saída da câmera interage com o resto do sistema. Há várias maneiras padrão de as câmeras se comunicarem com dispositivos IoT Edge:

O Real Time Streaming Protocol (RTSP) é um protocolo de rede de nível de aplicativo que controla servidores de streaming de vídeo. O RTSP transfere dados de vídeo em tempo real da câmera para o ponto de extremidade de computação do IoT Edge por meio de uma conexão TCP/IP.

Open Network Video Interface Forum (ONVIF) é um fórum global e aberto da indústria que desenvolve padrões abertos para câmeras baseadas em IP. Esses padrões descrevem a comunicação entre câmeras IP e sistemas a jusante, interoperabilidade e código aberto.

As câmeras conectadas ao Universal Serial Bus (USB) se conectam pela porta USB diretamente ao dispositivo de computação IoT Edge. Essa conexão é menos complexa, mas limita a distância que a câmera pode ser localizada do dispositivo IoT Edge.

A Camera Serial Interface (CSI) inclui vários padrões da Mobile Industry Processor Interface (MIPI) Alliance. CSI descreve como se comunicar entre uma câmera e um processador host. CSI-2, lançado em 2005, tem várias camadas:

- Camada física (C-PHY ou D-PHY)

- Camada de fusão de faixa

- Camada de protocolo de baixo nível

- Camada de conversão de pixel para byte

- Camada de aplicação

CSI-2 v3.0 adicionou suporte para profundidade de cor RAW-24, Unified Serial Link e Smart Region of Interest.

Contribuidores

Este artigo é mantido pela Microsoft. Foi originalmente escrito pelos seguintes contribuidores.

Autor principal:

- Keith Hill - Brasil | Gerente de PM Sênior

Para ver perfis não públicos do LinkedIn, inicie sessão no LinkedIn.

Próximos passos

Comentários

Brevemente: Ao longo de 2024, vamos descontinuar progressivamente o GitHub Issues como mecanismo de feedback para conteúdos e substituí-lo por um novo sistema de feedback. Para obter mais informações, veja: https://aka.ms/ContentUserFeedback.

Submeter e ver comentários