Monitorizar a atividade de cópia

APLICA-SE A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Gorjeta

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange tudo, desde a movimentação de dados até ciência de dados, análises em tempo real, business intelligence e relatórios. Saiba como iniciar uma nova avaliação gratuitamente!

Este artigo descreve como monitorar a execução da atividade de cópia nos pipelines do Azure Data Factory e Synapse. Ele se baseia no artigo de visão geral da atividade de cópia que apresenta uma visão geral da atividade de cópia. Você também pode monitorar atividades de cópia geradas com a Ferramenta Copiar Dados, bem como Excluir atividades usando a mesma abordagem.

Monitorizar visualmente

Depois de criar e publicar um pipeline, você pode associá-lo a um gatilho ou iniciar manualmente uma execução ad hoc. Você pode monitorar todas as execuções de pipeline nativamente na experiência do usuário. Saiba mais sobre o monitoramento em geral em Monitorar visualmente os pipelines do Azure Data Factory e do Sinapse.

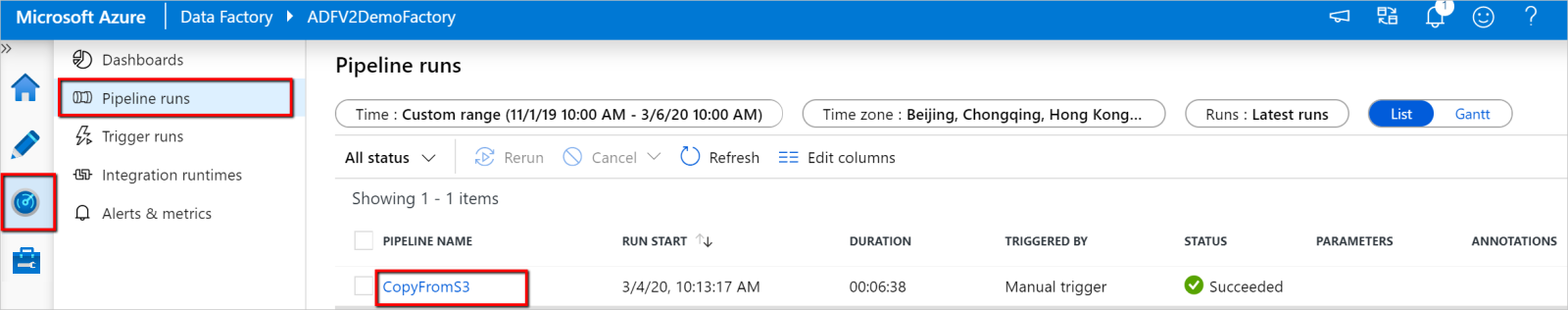

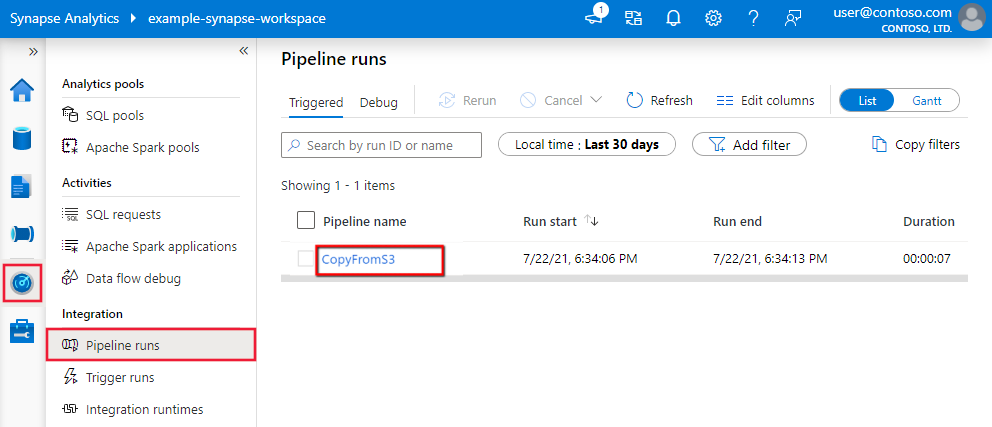

Para monitorar a execução da atividade de cópia, vá para a interface do usuário do Data Factory Studio ou do Azure Synapse Studio para sua instância de serviço. Na guia Monitor, você verá uma lista de execuções de pipeline, clique no link de nome do pipeline para acessar a lista de atividades executadas no pipeline executado.

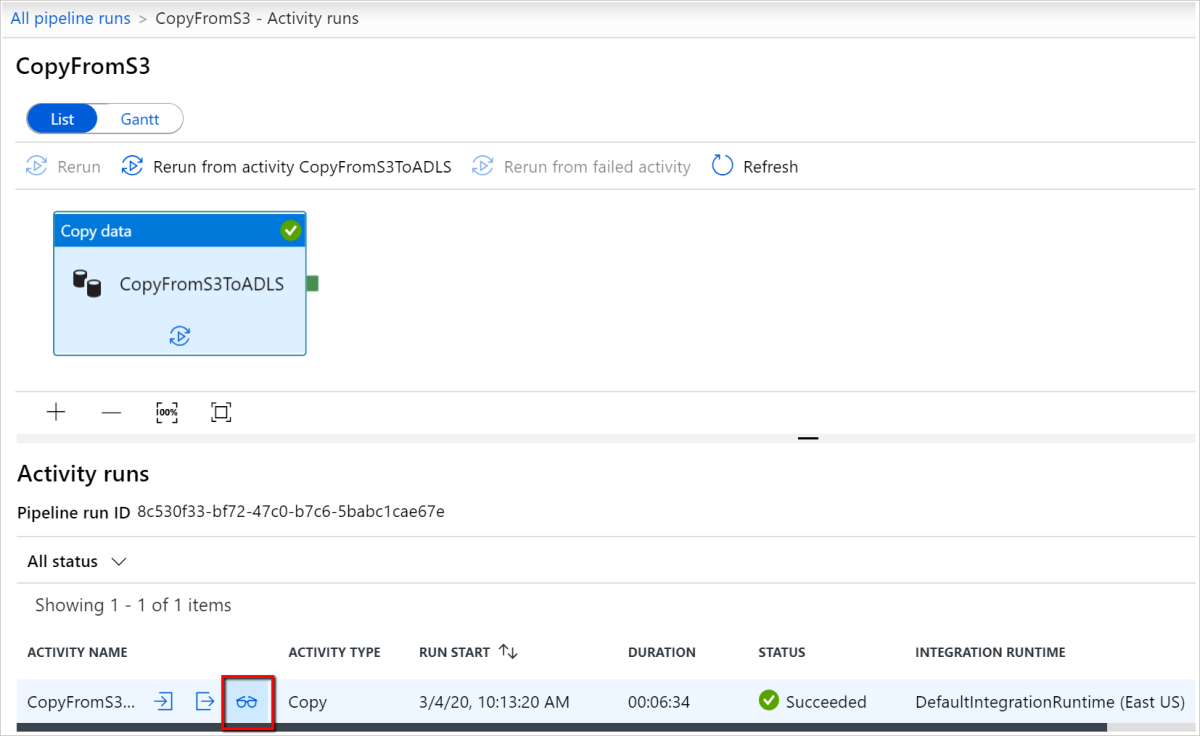

Nesse nível, você pode ver links para copiar entrada, saída e erros da atividade (se a execução da atividade de cópia falhar), bem como estatísticas como duração/status. Clicar no botão Detalhes (óculos) ao lado do nome da atividade de cópia fornecerá detalhes detalhados sobre a execução da atividade de cópia.

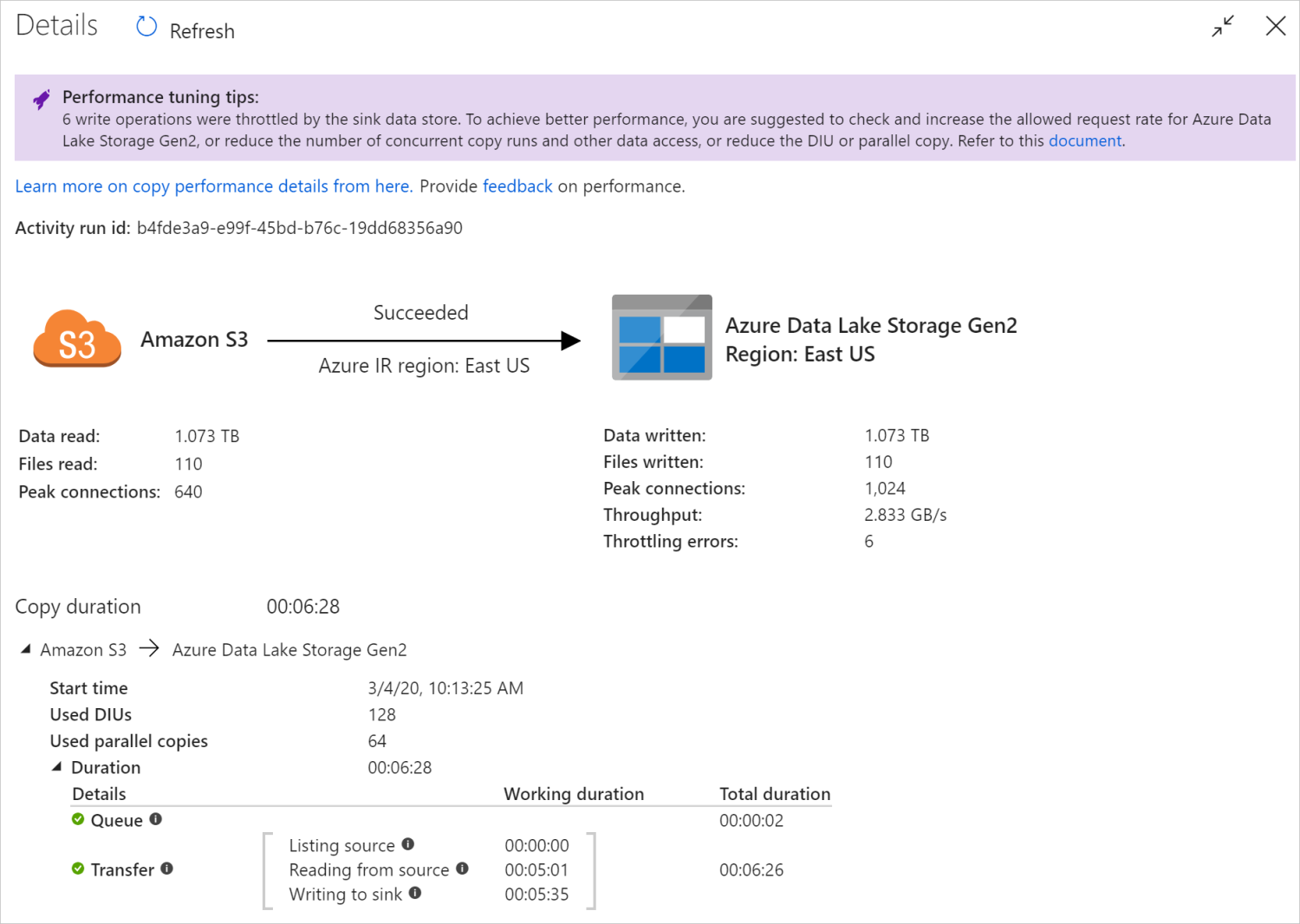

Nesta visualização de monitoramento gráfico, o serviço apresenta as informações de execução da atividade de cópia, incluindo volume de dados/gravados, número de arquivos/linhas de dados copiados da origem para o coletor, taxa de transferência, as configurações aplicadas para o cenário de cópia, etapas pelas quais a atividade de cópia passa com durações e detalhes correspondentes e muito mais. Consulte esta tabela sobre cada métrica possível e sua descrição detalhada.

Em alguns cenários, ao executar uma atividade de cópia, você verá "Dicas de ajuste de desempenho" na parte superior da exibição de monitoramento da atividade de cópia, conforme mostrado no exemplo. As dicas informam o gargalo identificado pelo serviço para a execução de cópia específica, juntamente com sugestões sobre o que alterar para aumentar a taxa de transferência da cópia. Saiba mais sobre dicas de ajuste de desempenho automático.

Os detalhes e durações de execução inferiores descrevem as principais etapas pelas quais sua atividade de cópia passa, o que é especialmente útil para solucionar problemas de desempenho da cópia. O gargalo da sua execução de cópia é aquele com maior duração. Consulte Solucionar problemas de desempenho da atividade de cópia para saber o que cada estágio representa e as diretrizes detalhadas para solução de problemas.

Exemplo: copiar do Amazon S3 para o Azure Data Lake Storage Gen2

Monitore programaticamente

Os detalhes de execução da atividade de cópia e as características de desempenho também são retornados na seção Copy Activity run run result>Output, que é usada para renderizar a exibição de monitoramento da interface do usuário. A seguir está uma lista completa de propriedades que podem ser retornadas. Você verá apenas as propriedades aplicáveis ao seu cenário de cópia. Para obter informações sobre como monitorar a atividade executada programaticamente em geral, consulte Monitorar programaticamente um pipeline do Azure Data Factory ou Synapse.

| Property name | Description | Unidade de produção |

|---|---|---|

| dadosLer | A quantidade real de dados lidos da fonte. | Valor Int64, em bytes |

| dataWritten | A montagem real de dados gravados/comprometidos no coletor. O tamanho pode ser diferente do tamanho, pois relaciona como cada armazenamento de dataRead dados armazena os dados. |

Valor Int64, em bytes |

| ficheirosLer | O número de arquivos lidos da fonte baseada em arquivo. | Valor Int64 (sem unidade) |

| ficheirosEscrito | O número de arquivos gravados/confirmados no coletor baseado em arquivo. | Valor Int64 (sem unidade) |

| ficheirosIgnorado | O número de arquivos ignorados da fonte baseada em arquivo. | Valor Int64 (sem unidade) |

| dataConsistencyVerification | Detalhes da verificação de consistência de dados, onde você pode ver se os dados copiados foram verificados para serem consistentes entre o armazenamento de origem e de destino. Saiba mais neste artigo. | Matriz |

| sourcePeakConnections | Número máximo de conexões simultâneas estabelecidas para o armazenamento de dados de origem durante a execução da atividade de cópia. | Valor Int64 (sem unidade) |

| sinkPeakConnections | Número máximo de conexões simultâneas estabelecidas para o armazenamento de dados do coletor durante a execução da atividade de cópia. | Valor Int64 (sem unidade) |

| linhasLer | Número de linhas lidas a partir da fonte. Essa métrica não se aplica ao copiar arquivos como estão sem analisá-los, por exemplo, quando os conjuntos de dados de origem e coletor são do tipo de formato binário ou outro tipo de formato com configurações idênticas. | Valor Int64 (sem unidade) |

| linhasCopiadas | Número de linhas copiadas para o coletor. Essa métrica não se aplica ao copiar arquivos como estão sem analisá-los, por exemplo, quando os conjuntos de dados de origem e coletor são do tipo de formato binário ou outro tipo de formato com configurações idênticas. | Valor Int64 (sem unidade) |

| linhasIgnorado | Número de linhas incompatíveis que foram ignoradas. Você pode permitir que linhas incompatíveis sejam ignoradas definindo enableSkipIncompatibleRow como true. |

Valor Int64 (sem unidade) |

| copyDuration | Duração da execução da cópia. | Valor Int32, em segundos |

| de transferência de dados | Taxa de transferência de dados, calculada por dataRead dividido por copyDuration. |

Número de ponto flutuante, em KBps |

| sourcePeakConnections | Número máximo de conexões simultâneas estabelecidas para o armazenamento de dados de origem durante a execução da atividade de cópia. | Valor Int32 (sem unidade) |

| sinkPeakConnections | Número máximo de conexões simultâneas estabelecidas para o armazenamento de dados do coletor durante a execução da atividade de cópia. | Valor Int32 (sem unidade) |

| sqlDwPolyBase | Se o PolyBase é usado quando os dados são copiados para o Azure Synapse Analytics. | Boolean |

| redshiftDescarregar | Se UNLOAD é usado quando os dados são copiados do Redshift. | Boolean |

| hdfsDistcp | Se o DistCp é usado quando os dados são copiados do HDFS. | Boolean |

| effectiveIntegrationRuntime | O tempo de execução de integração (IR) ou tempos de execução usados para alimentar a atividade executada, no formato <IR name> (<region if it's Azure IR>). |

Texto (string) |

| usedDataIntegrationUnits | As Unidades de Integração de Dados eficazes durante a cópia. | Valor Int32 |

| usadosParallelCopies | O parallelCopies efetivo durante a cópia. | Valor Int32 |

| logPath | Caminho para o log de sessão de dados ignorados no armazenamento de blob. Consulte Tolerância a falhas. | Texto (string) |

| execuçãoDetalhes | Mais detalhes sobre os estágios pelos quais a atividade Copiar passa e as etapas correspondentes, durações, configurações e assim por diante. Não recomendamos que você analise esta seção porque ela pode mudar. Para entender melhor como ele ajuda você a entender e solucionar problemas de desempenho de cópia, consulte a seção Monitorar visualmente . | Matriz |

| perfRecomendação | Copie dicas de ajuste de desempenho. Consulte Dicas de ajuste de desempenho para obter detalhes. | Matriz |

| faturamentoReferência | O consumo de faturamento para a execução dada. Saiba mais em Monitorar o consumo no nível de execução de atividade. | Object |

| durationInQueue | Duração da fila em segundos antes que a atividade de cópia comece a ser executada. | Object |

Exemplo:

"output": {

"dataRead": 1180089300500,

"dataWritten": 1180089300500,

"filesRead": 110,

"filesWritten": 110,

"filesSkipped": 0,

"sourcePeakConnections": 640,

"sinkPeakConnections": 1024,

"copyDuration": 388,

"throughput": 2970183,

"errors": [],

"effectiveIntegrationRuntime": "DefaultIntegrationRuntime (East US)",

"usedDataIntegrationUnits": 128,

"billingReference": "{\"activityType\":\"DataMovement\",\"billableDuration\":[{\"Managed\":11.733333333333336}]}",

"usedParallelCopies": 64,

"dataConsistencyVerification":

{

"VerificationResult": "Verified",

"InconsistentData": "None"

},

"executionDetails": [

{

"source": {

"type": "AmazonS3"

},

"sink": {

"type": "AzureBlobFS",

"region": "East US",

"throttlingErrors": 6

},

"status": "Succeeded",

"start": "2020-03-04T02:13:25.1454206Z",

"duration": 388,

"usedDataIntegrationUnits": 128,

"usedParallelCopies": 64,

"profile": {

"queue": {

"status": "Completed",

"duration": 2

},

"transfer": {

"status": "Completed",

"duration": 386,

"details": {

"listingSource": {

"type": "AmazonS3",

"workingDuration": 0

},

"readingFromSource": {

"type": "AmazonS3",

"workingDuration": 301

},

"writingToSink": {

"type": "AzureBlobFS",

"workingDuration": 335

}

}

}

},

"detailedDurations": {

"queuingDuration": 2,

"transferDuration": 386

}

}

],

"perfRecommendation": [

{

"Tip": "6 write operations were throttled by the sink data store. To achieve better performance, you are suggested to check and increase the allowed request rate for Azure Data Lake Storage Gen2, or reduce the number of concurrent copy runs and other data access, or reduce the DIU or parallel copy.",

"ReferUrl": "https://go.microsoft.com/fwlink/?linkid=2102534 ",

"RuleName": "ReduceThrottlingErrorPerfRecommendationRule"

}

],

"durationInQueue": {

"integrationRuntimeQueue": 0

}

}

Conteúdos relacionados

Veja os outros artigos da Atividade de cópia:

Comentários

Brevemente: Ao longo de 2024, vamos descontinuar progressivamente o GitHub Issues como mecanismo de feedback para conteúdos e substituí-lo por um novo sistema de feedback. Para obter mais informações, veja: https://aka.ms/ContentUserFeedback.

Submeter e ver comentários