Obter feedback sobre a qualidade de um aplicativo agentic

Importante

Esta funcionalidade está em Pré-visualização Pública.

Este artigo mostra como usar o aplicativo de revisão Databricks para coletar feedback sobre a qualidade do seu aplicativo agentic de revisores humanos.

O Mosaic AI Agent Evaluation permite que os desenvolvedores avaliem de forma rápida e confiável a qualidade, o custo e a latência de seu aplicativo de IA generativa. Os recursos de Avaliação de Agentes são unificados entre as fases de desenvolvimento, preparação e produção do ciclo de vida do LLMops.

A Avaliação de Agentes faz parte da nossa oferta Mosaic AI Agent Framework que foi projetada para ajudar os desenvolvedores a implantar aplicativos de IA generativa de alta qualidade. Aplicativos de alta qualidade são aqueles em que a saída é avaliada como precisa, segura e controlada.

O que acontece numa avaliação humana?

O aplicativo de revisão permite que você colete feedback de suas partes interessadas especializadas sobre seu aplicativo. Isso ajuda a garantir a qualidade e a segurança das respostas que fornece.

Há três maneiras de coletar comentários usando o aplicativo de avaliações. Partes interessadas especializadas:

- Converse com o bot do aplicativo e forneça feedback sobre essas conversas.

- Forneça feedback sobre logs históricos de outros usuários.

- Forneça feedback sobre quaisquer rastreamentos selecionados e saídas do agente.

No aplicativo de revisão Databricks, o LLM é encenado em um ambiente onde as partes interessadas especializadas podem interagir com ele - em outras palavras, ter uma conversa, fazer perguntas e assim por diante.

Requisitos

Para usar o aplicativo de revisão para avaliação humana de um aplicativo agentic, você precisa ter a seguinte configuração:

- As tabelas de inferência devem ser habilitadas no ponto de extremidade que está servindo ao agente. Isso permite que o aplicativo de revisão colete e registre dados sobre o aplicativo agentic.

- Acesso ao espaço de trabalho do aplicativo de revisão para cada revisor humano. Consulte a próxima seção, Configurar permissões de aplicativo de revisão.

Configurar permissões para o espaço de trabalho do aplicativo de revisão

Se os revisores já tiverem acesso ao espaço de trabalho que contém o aplicativo de revisão, você não precisará fazer nada.

Se os revisores ainda não tiverem acesso, os administradores de conta poderão usar o provisionamento SCIM no nível da conta para sincronizar usuários e grupos automaticamente do seu provedor de identidade para sua conta do Azure Databricks. Você também pode registrar manualmente esses usuários e grupos enquanto configura identidades no Databricks. Isso permite que eles sejam incluídos como revisores elegíveis. Consulte Sincronizar usuários e grupos do seu provedor de identidade.

from databricks.agents import set_permissions

from databricks.agents.entities import PermissionLevel

set_permissions(model_fqn, ["user.name@databricks.com"], PermissionLevel.CAN_QUERY)

Para novos clientes do Public Preview que tenham problemas para conceder aos revisores acesso ao aplicativo de avaliação, entre em contato com sua equipe de conta de banco de dados para habilitar esse recurso.

Fornecer instruções aos revisores

Escreva texto personalizado para as instruções exibidas para os revisores e envie-o conforme mostrado no exemplo de código a seguir:

from databricks.agents import set_review_instructions, get_review_instructions

set_review_instructions(uc_model_name, "Thank you for testing the bot. Use your domain expertise to evaluate and give feedback on the bot's responses, ensuring it aligns with the needs and expectations of users like yourself.")

get_review_instructions(uc_model_name)

Visão geral da interface do usuário do aplicativo de revisão

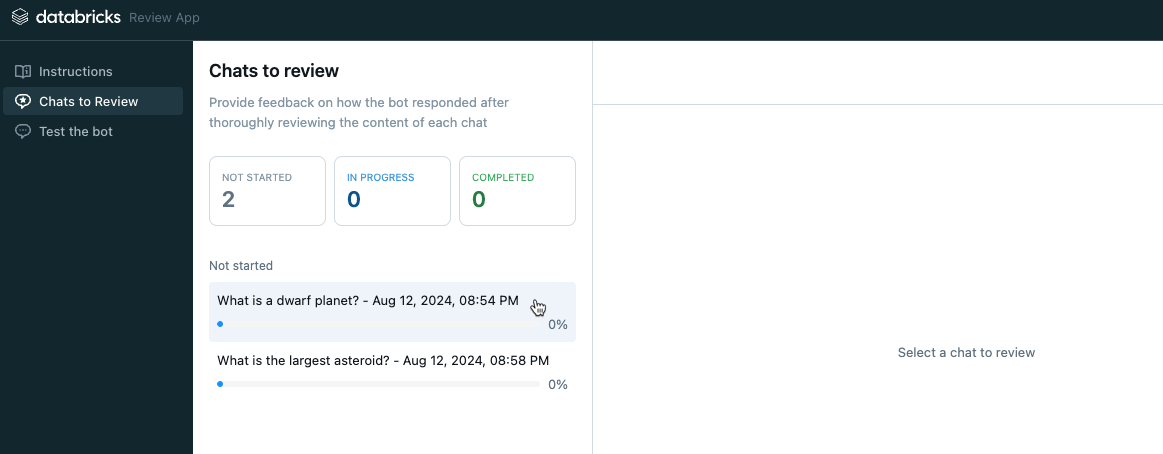

O fluxo de trabalho básico para uma avaliação de especialistas no aplicativo de revisão:

Abra o URL do aplicativo de revisão fornecido.

Analise os chats pré-preenchidos.

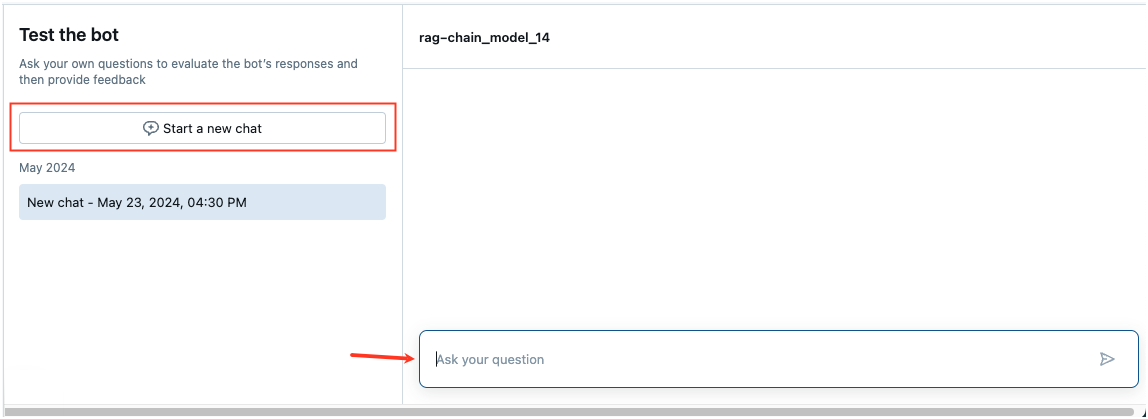

Converse com o bot e envie avaliações de suas respostas.

Opções para realizar uma avaliação com os detentores de interesse

Especialistas conversam com o aplicativo de avaliações

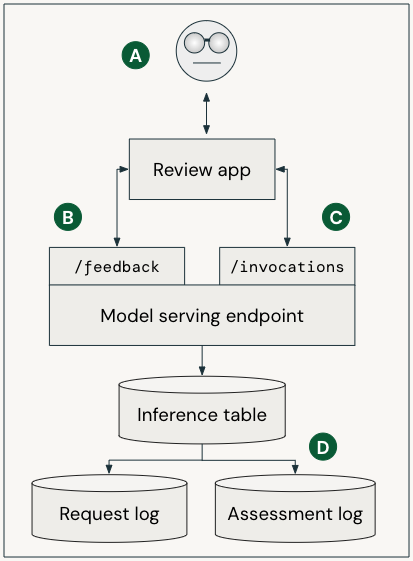

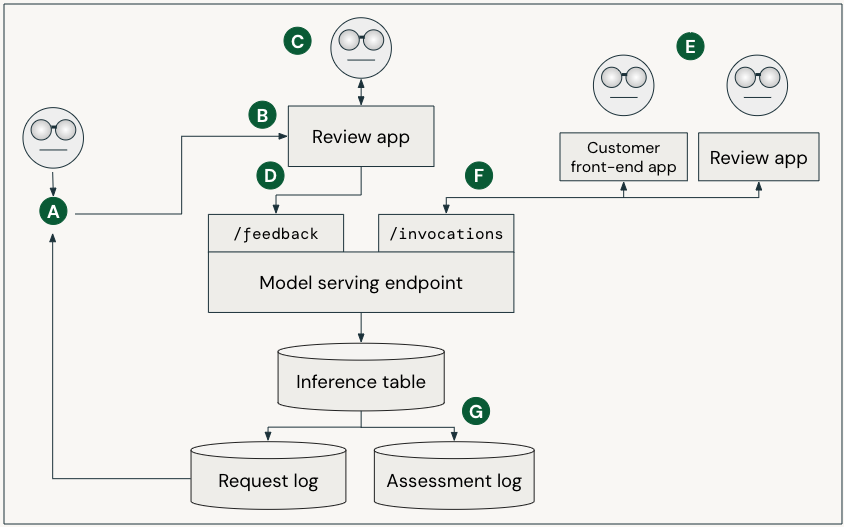

Para usar essa opção, chame deploy_model(…) e defina as permissões corretas. O diagrama a seguir mostra como essa opção funciona.

A. Conversas com partes interessadas especializadas com o aplicativo agentic B. Feedback sobre a resposta C. Solicitação/resposta do aplicativo D. Solicitação/resposta do aplicativo + rastreamento + feedback

Especialistas analisam registos

Para usar essa opção, primeiro implante seu aplicativo agentic usando deploy_model(…)o . Depois que os usuários interagem com a API REST ou o aplicativo de revisão, você pode carregar esses rastreamentos de volta no aplicativo de revisão usando o código a seguir.

from databricks.agents import enable_trace_reviews

enable_trace_reviews(

model_name=model_fqn,

request_ids=[

"52ee973e-0689-4db1-bd05-90d60f94e79f",

"1b203587-7333-4721-b0d5-bba161e4643a",

"e68451f4-8e7b-4bfc-998e-4bda66992809",

],

)

Use valores da request_id coluna da tabela de logs de solicitação.

Nota

Se você tiver o Firewall de Armazenamento do Azure habilitado, entre em contato com sua equipe de conta do Azure Databricks para habilitar tabelas de inferência para seus pontos de extremidade.

Um. enable_trace_reviews([request_id]) B. Chats carregados C. Conversas com partes interessadas especializadas com o aplicativo D. Comentários sobre a resposta E. Solicitações de uso de aplicativo front-end ou uso de revisão do aplicativo F. Solicitação/resposta do aplicativo G. Solicitação/resposta do aplicativo + rastreamento + feedback

Executar a avaliação na tabela de logs de solicitação

O bloco de anotações a seguir ilustra como usar os logs do aplicativo de revisão como entrada para uma execução de avaliação usando mlflow.evaluate()o .

Executar avaliação no bloco de anotações de logs de solicitação

Limitação

Se você implantar um aplicativo sem iniciar nenhuma revisão usando a enable_trace_reviews chamada e tiver CAN_MANAGE permissões para a implantação, o serviço retornará uma NO_PERMISSIONS resposta ao invocar o get_permissions ponto de extremidade. Este é um problema conhecido e os níveis de permissão apropriados estão sendo mantidos em todo o sistema.

Ao usar a enable_trace_reviews funcionalidade para gerar artefatos de revisão, confirme se todos os usuários receberam as permissões necessárias para realizar revisões ou gerenciá-las. Para fazer isso, use a set_permissions API.

Comentários

Brevemente: Ao longo de 2024, vamos descontinuar progressivamente o GitHub Issues como mecanismo de feedback para conteúdos e substituí-lo por um novo sistema de feedback. Para obter mais informações, veja: https://aka.ms/ContentUserFeedback.

Submeter e ver comentários