Capturar dados dos Hubs de Eventos no formato Parquet

Este artigo explica como utilizar o editor sem código para capturar automaticamente dados de transmissão em fluxo nos Hubs de Eventos numa conta Azure Data Lake Storage Gen2 no formato Parquet.

Pré-requisitos

Um espaço de nomes Hubs de Eventos do Azure com um hub de eventos e uma conta Azure Data Lake Storage Gen2 com um contentor para armazenar os dados capturados. Estes recursos têm de estar acessíveis publicamente e não podem estar protegidos por uma firewall ou numa rede virtual do Azure.

Se não tiver um hub de eventos, crie um ao seguir as instruções do Início Rápido: Criar um hub de eventos.

Se não tiver uma conta Data Lake Storage Gen2, crie uma ao seguir as instruções em Criar uma conta de armazenamento

Os dados nos Hubs de Eventos têm de ser serializados no formato JSON, CSV ou Avro. Para fins de teste, selecione Gerar dados (pré-visualização) no menu esquerdo, selecione Dados de ações para o conjunto de dados e, em seguida, selecione Enviar.

Configurar uma tarefa para capturar dados

Utilize os seguintes passos para configurar uma tarefa do Stream Analytics para capturar dados no Azure Data Lake Storage Gen2.

No portal do Azure, navegue para o seu hub de eventos.

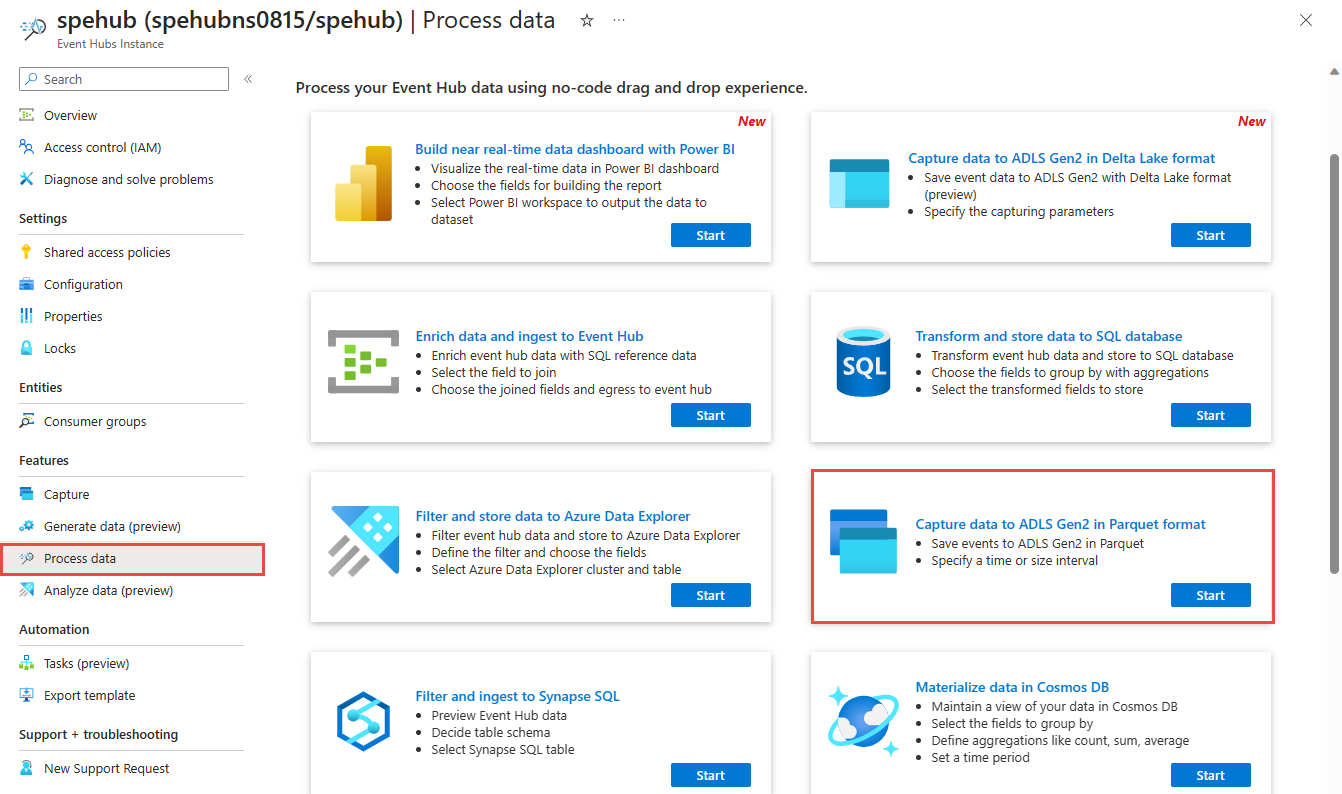

No menu esquerdo, selecione Processar Dados em Funcionalidades. Em seguida, selecione Iniciar no cartão Capturar dados para o ADLS Gen2 no formato Parquet .

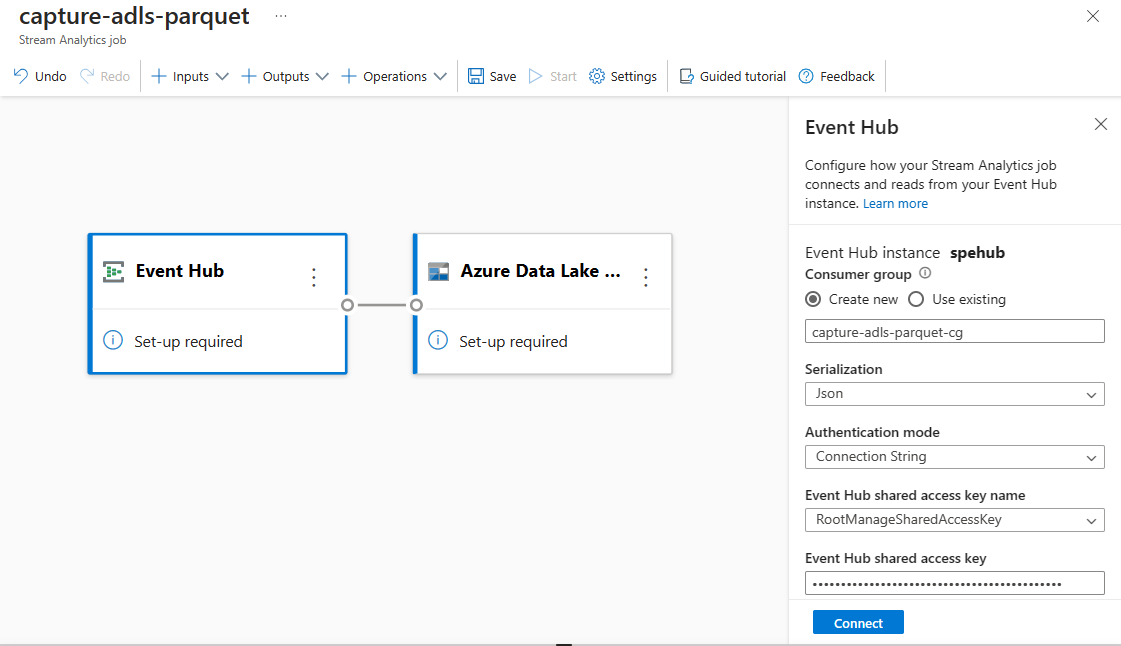

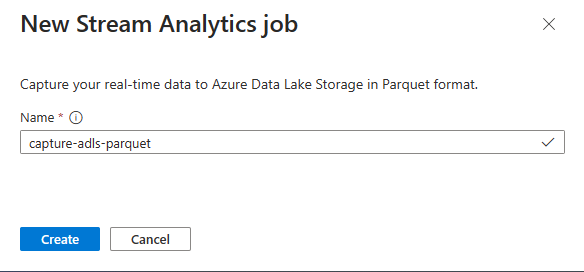

Introduza um nome para a tarefa do Stream Analytics e, em seguida, selecione Criar.

Especifique o tipo de Serialização dos seus dados nos Hubs de Eventos e o método de Autenticação que a tarefa utiliza para ligar aos Hubs de Eventos. Em seguida, selecione Ligar.

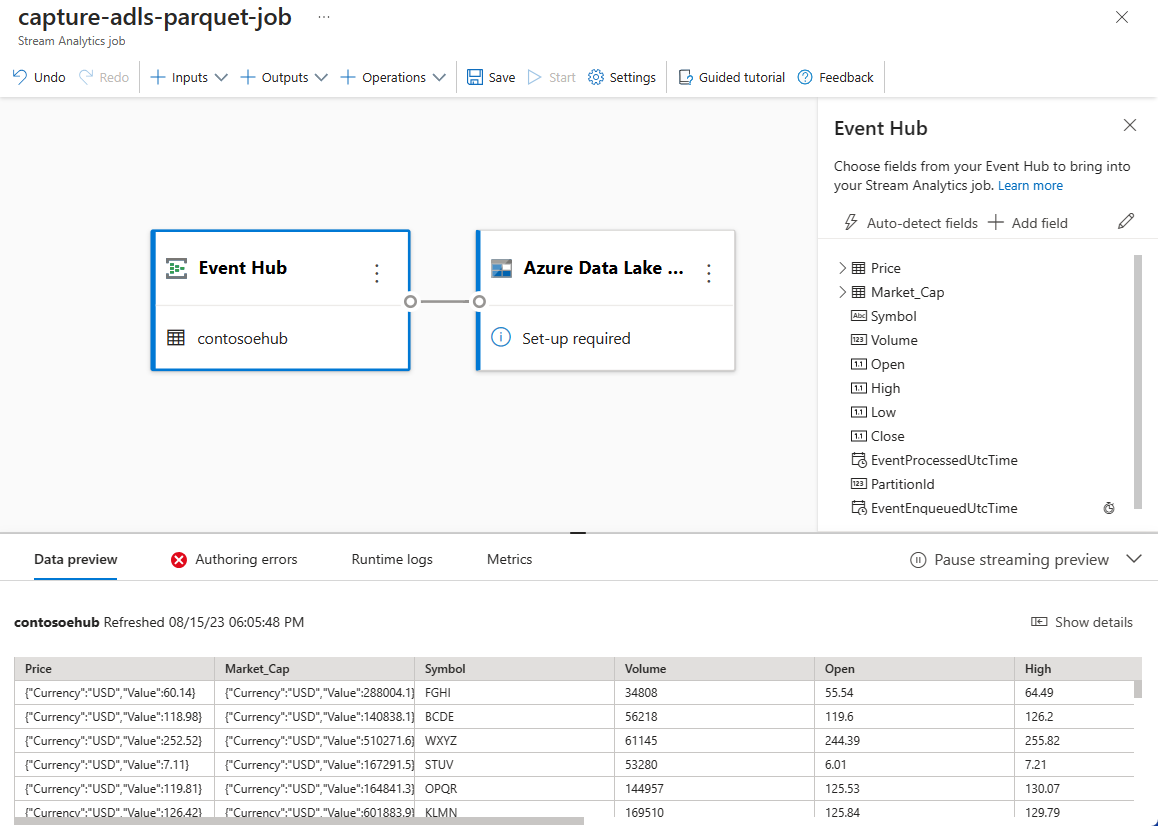

Quando a ligação for estabelecida com êxito, verá:

Campos que estão presentes nos dados de entrada. Pode selecionar Adicionar campo ou selecionar o símbolo de três pontos junto a um campo para remover, mudar o nome ou alterar o nome.

Um exemplo dinâmico de dados recebidos na tabela Pré-visualização de dados na vista de diagrama. É atualizado periodicamente. Pode selecionar Colocar em pausa a pré-visualização da transmissão em fluxo para ver uma vista estática da entrada de exemplo.

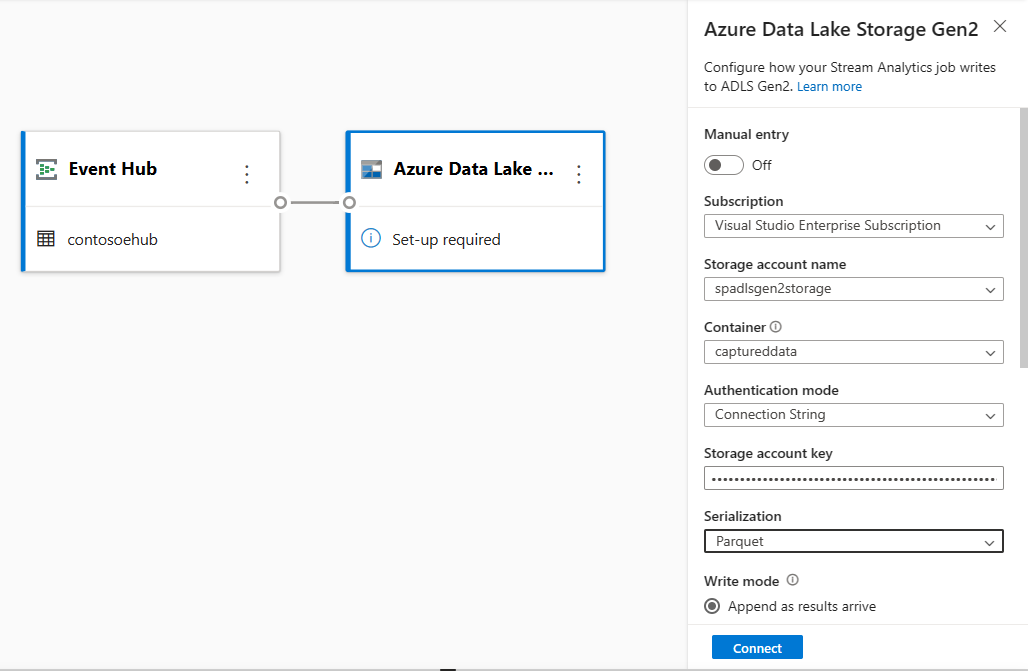

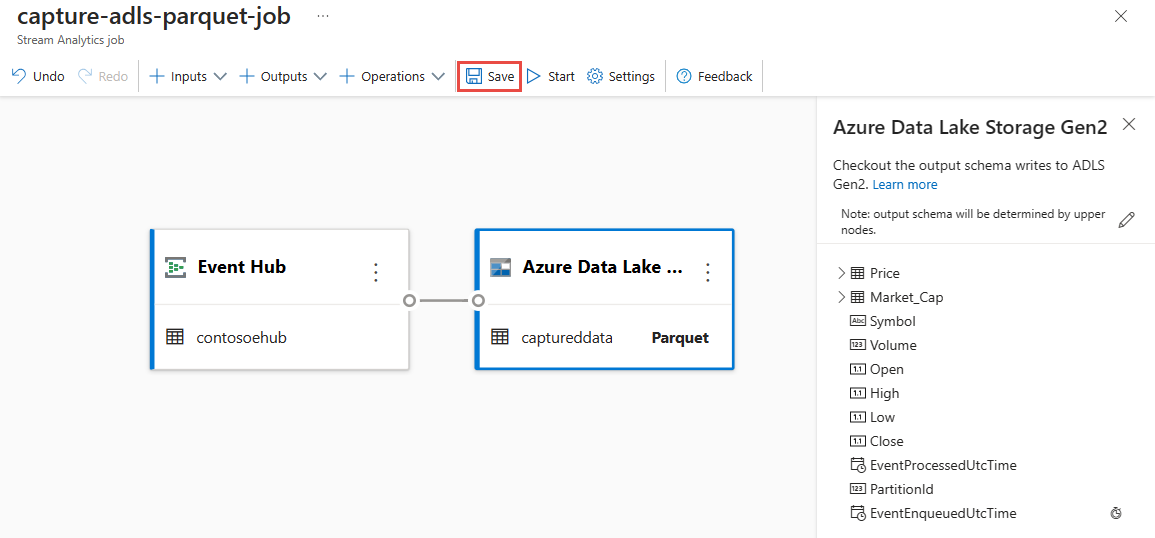

Selecione o mosaico Azure Data Lake Storage Gen2 para editar a configuração.

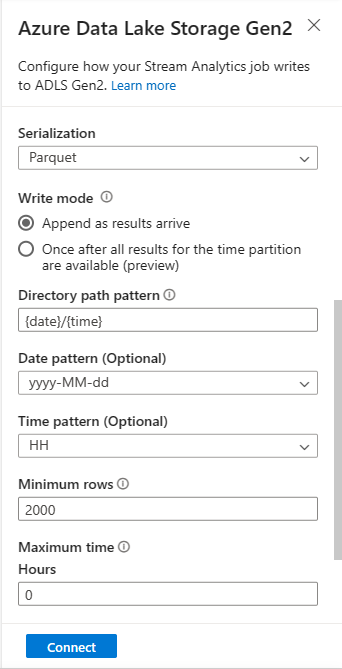

Na página de configuração do Azure Data Lake Storage Gen2, siga estes passos:

Selecione a subscrição, o nome da conta de armazenamento e o contentor no menu pendente.

Assim que a subscrição estiver selecionada, o método de autenticação e a chave da conta de armazenamento devem ser preenchidos automaticamente.

Selecione Parquet para Formato de serialização .

Para os blobs de transmissão em fluxo, espera-se que o padrão do caminho do diretório seja um valor dinâmico. É necessário que a data faça parte do caminho do ficheiro para o blob , referenciado como

{date}. Para saber mais sobre os padrões de caminho personalizado, veja Criação de partições de saída de blobs personalizadas do Azure Stream Analytics.Selecione Ligar

Quando a ligação for estabelecida, verá os campos que estão presentes nos dados de saída.

Selecione Guardar na barra de comandos para guardar a configuração.

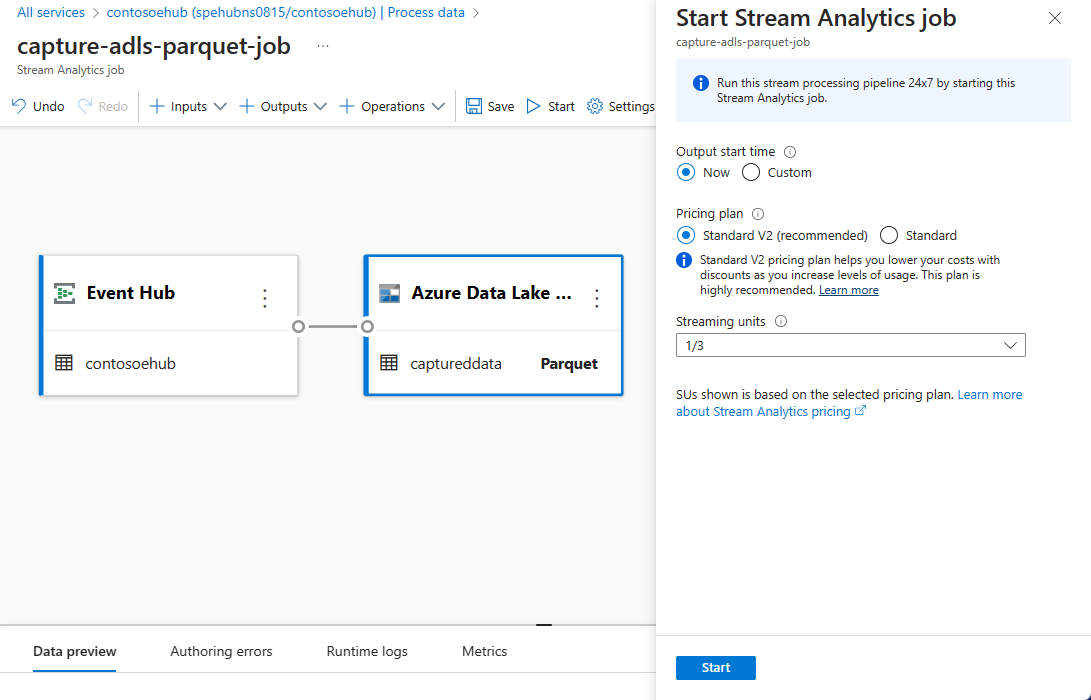

Selecione Iniciar na barra de comandos para iniciar o fluxo de transmissão em fluxo para capturar dados. Em seguida, na janela Iniciar tarefa do Stream Analytics:

Escolha a hora de início da saída.

Selecione o plano de preços.

Selecione o número de Unidades de Transmissão em Fluxo (SU) com que a tarefa é executada. A SU representa os recursos de computação alocados para executar uma tarefa do Stream Analytics. Para obter mais informações, veja Unidades de Transmissão em Fluxo no Azure Stream Analytics.

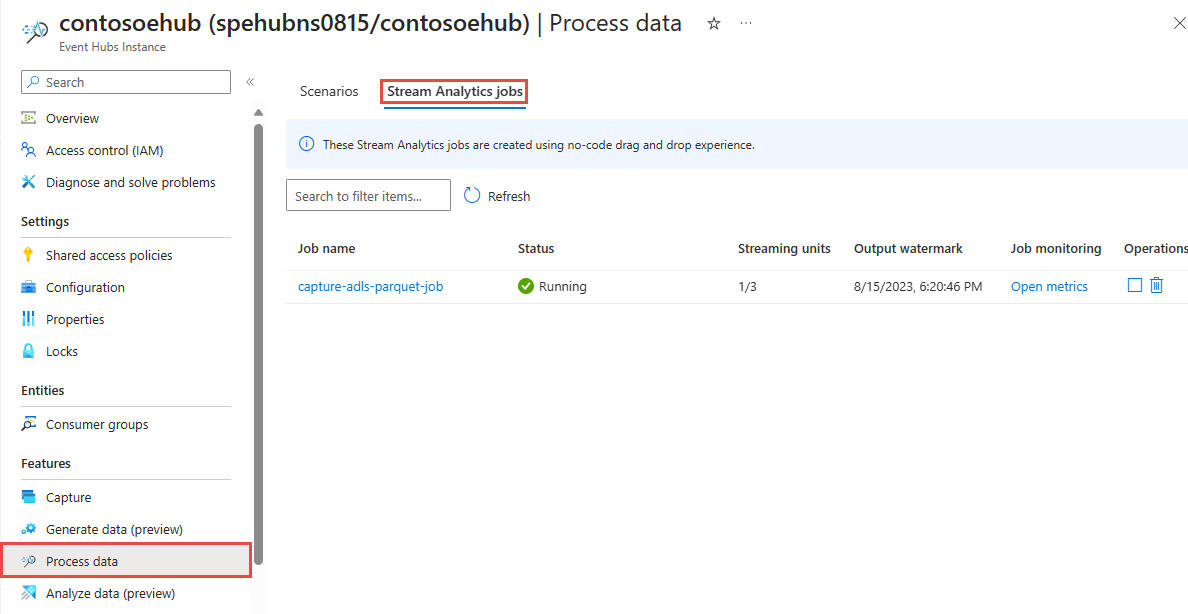

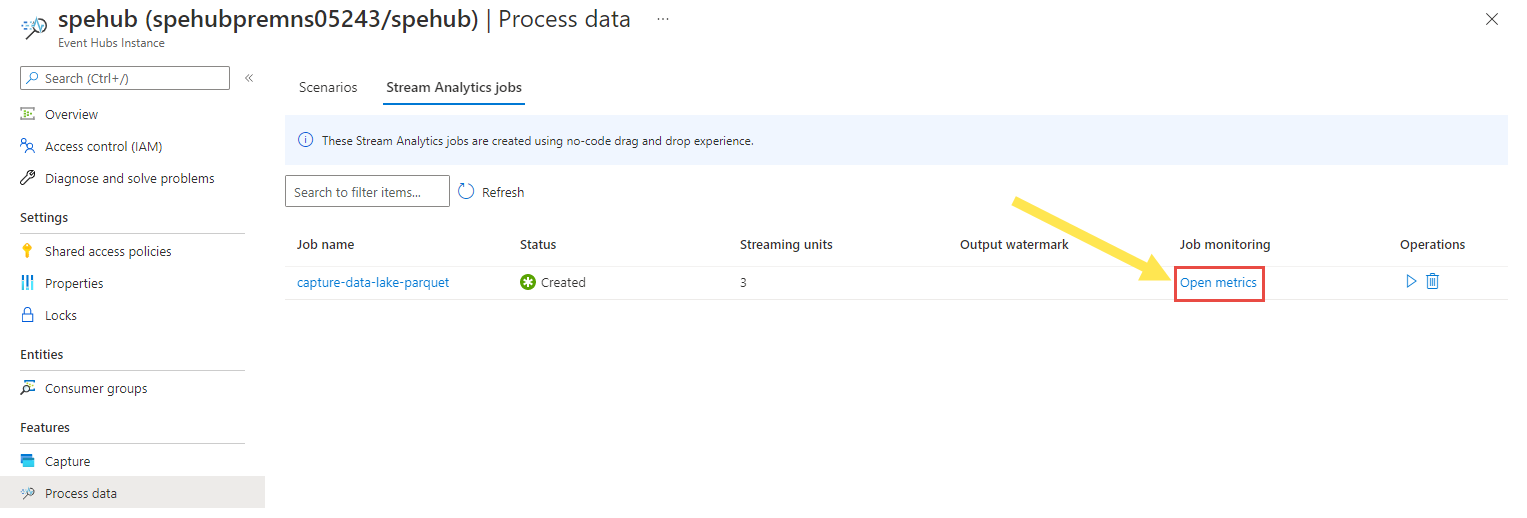

Deverá ver a tarefa do Stream Analytics no separador da tarefa do Stream Analytics da página Processar dados do seu hub de eventos.

Verificar a saída

Na página instância dos Hubs de Eventos do hub de eventos, selecione Gerar dados, selecione Dados de ações para o conjunto de dados e, em seguida, selecione Enviar para enviar alguns dados de exemplo para o hub de eventos.

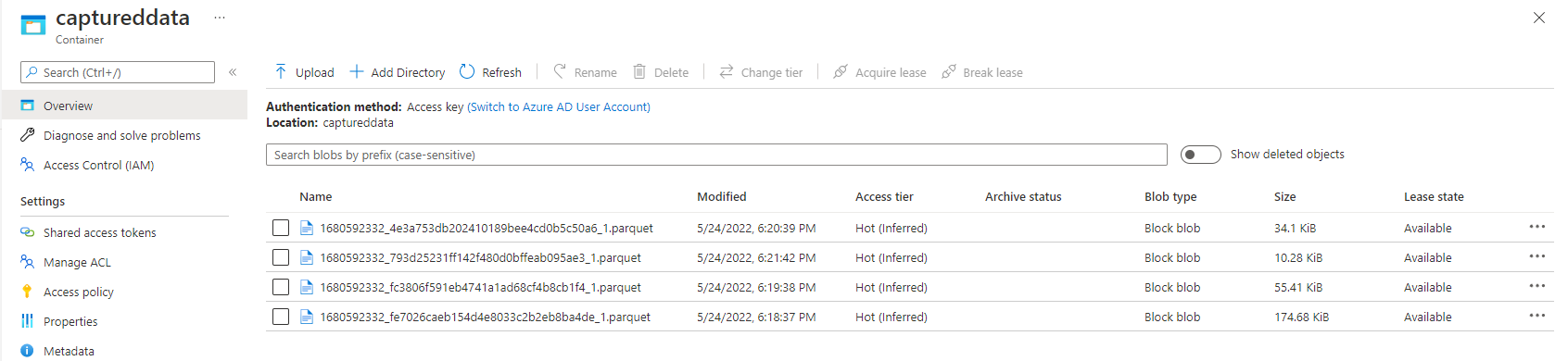

Verifique se os ficheiros Parquet são gerados no contentor Azure Data Lake Storage.

Selecione Processar dados no menu esquerdo. Mude para o separador Tarefas do Stream Analytics . Selecione Abrir métricas para monitorizá-la.

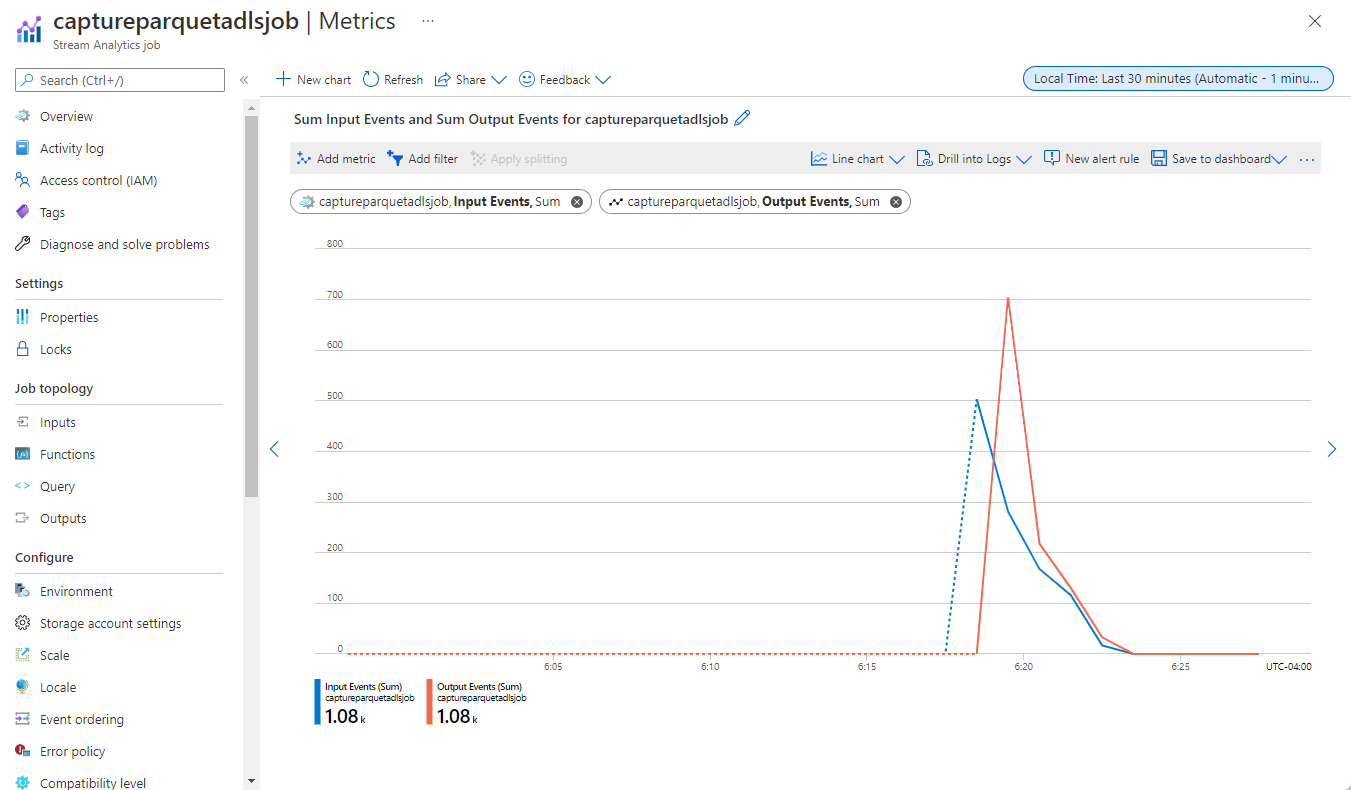

Eis uma captura de ecrã de exemplo das métricas que mostram eventos de entrada e saída.

Passos seguintes

Agora já sabe como utilizar o editor de código no Stream Analytics para criar uma tarefa que captura dados dos Hubs de Eventos para Azure Data Lake Storage Gen2 no formato Parquet. Em seguida, pode saber mais sobre o Azure Stream Analytics e como monitorizar a tarefa que criou.