Visão geral da máquina virtual da série HBv3

Aplica-se a: ✔️ VMs ✔️ Linux VMs ✔️ do Windows Conjuntos ✔️ de escala flexíveis Conjuntos de balanças uniformes

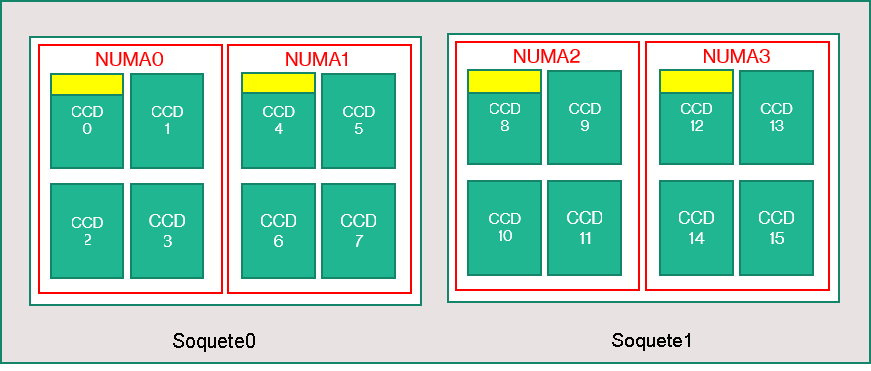

Um servidor da série HBv3 possui 2 * 64 núcleos EPYC 7V73X CPUs para um total de 128 núcleos físicos "Zen3" com AMD 3D V-Cache. Multithreading simultâneo (SMT) está desativado no HBv3. Esses 128 núcleos são divididos em 16 seções (8 por soquete), cada seção contendo 8 núcleos de processador com acesso uniforme a um cache L3 de 96 MB. Os servidores HBv3 do Azure também executam as seguintes configurações do AMD BIOS:

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

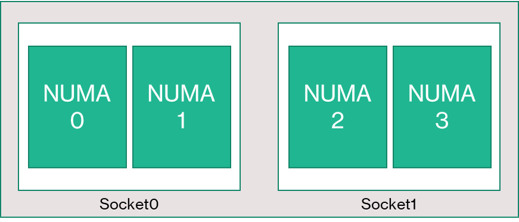

Como resultado, o servidor inicializa com 4 domínios NUMA (2 por soquete). Cada domínio tem 32 núcleos de tamanho. Cada NUMA tem acesso direto a 4 canais de DRAM física operando a 3.200 MT / s.

Para fornecer espaço para o hipervisor do Azure operar sem interferir com a VM, reservamos 8 núcleos físicos por servidor.

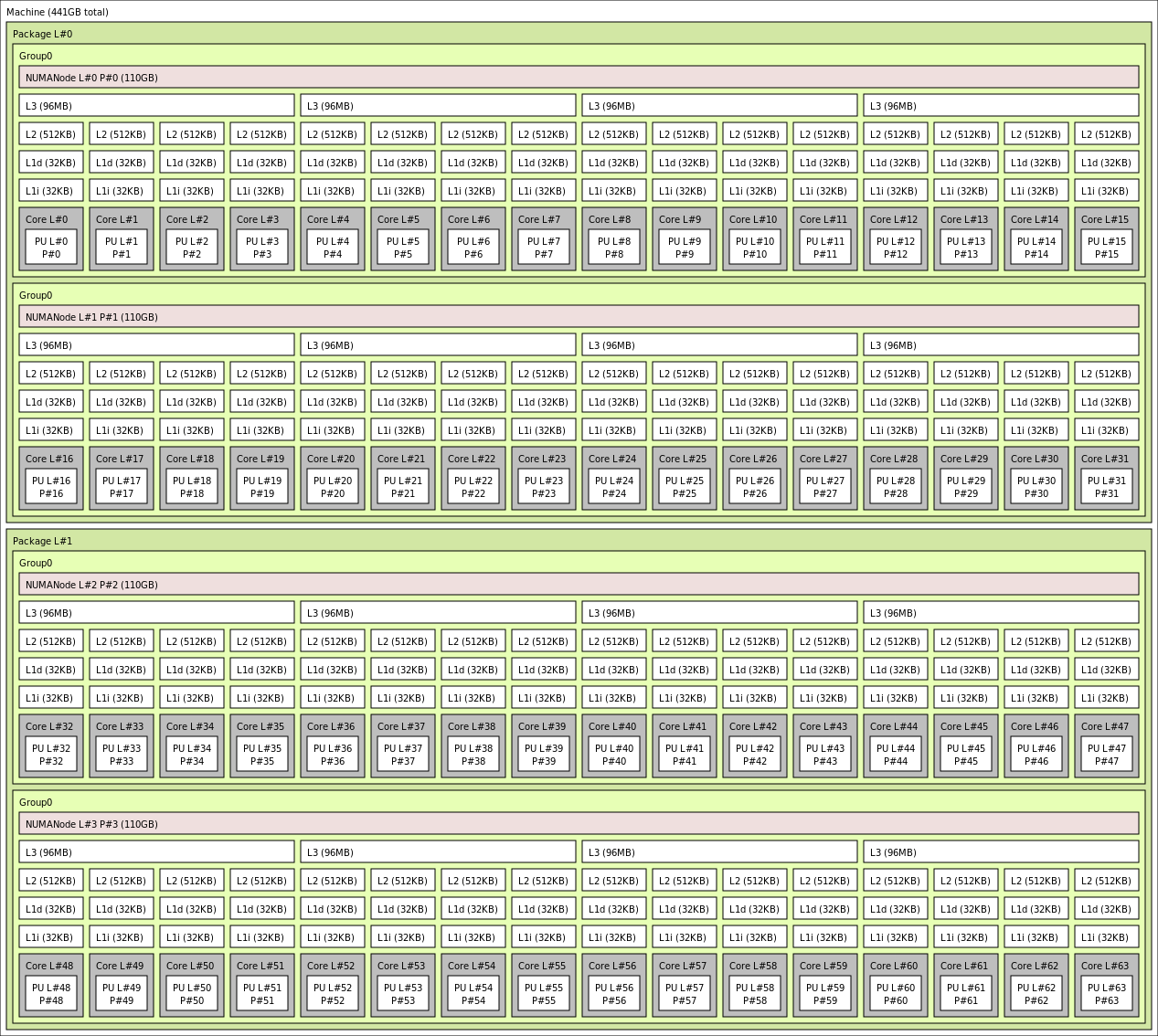

Topologia de VM

O diagrama a seguir mostra a topologia do servidor. Reservamos esses 8 núcleos de host do hipervisor (amarelo) simetricamente em ambos os soquetes de CPU, pegando os 2 primeiros núcleos de CCDs (Core Complex Dies) específicos em cada domínio NUMA, com os núcleos restantes para a VM da série HBv3 (verde).

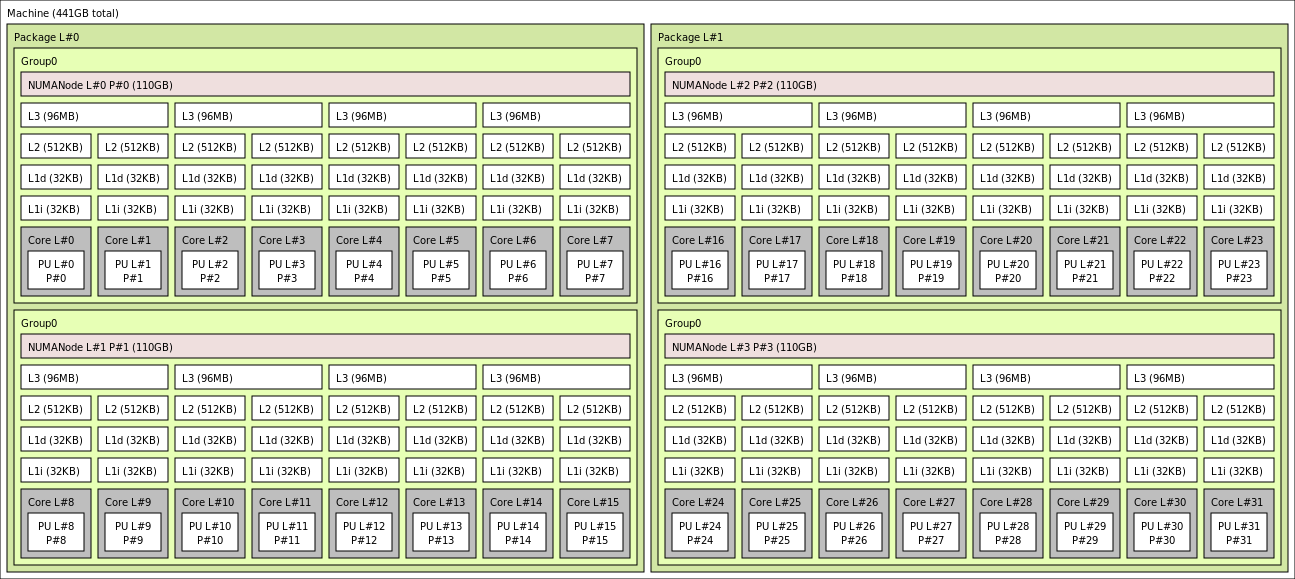

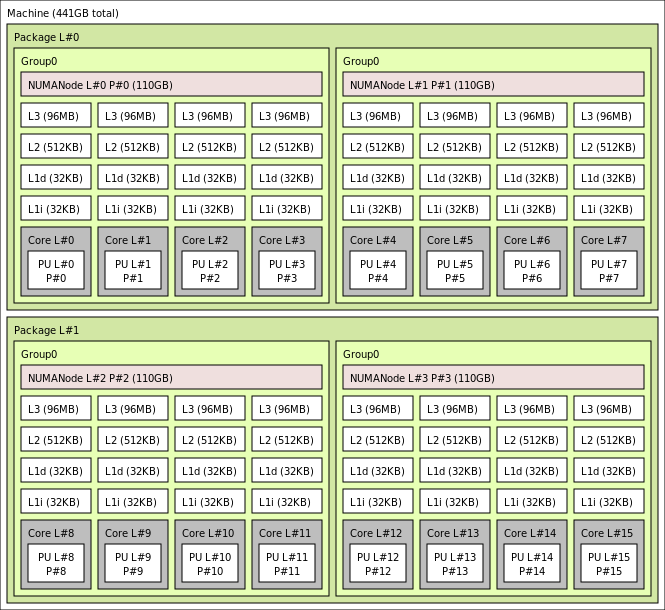

O limite CCD não é equivalente a um limite NUMA. No HBv3, um grupo de quatro CCDs consecutivos (4) é configurado como um domínio NUMA, tanto no nível do servidor host quanto em uma VM convidada. Assim, todos os tamanhos de VM HBv3 expõem 4 domínios NUMA que aparecem para um sistema operacional e aplicativo, conforme mostrado. 4 domínios NUMA uniformes, cada um com um número diferente de núcleos, dependendo do tamanho específico da VM HBv3.

Cada tamanho de VM HBv3 é semelhante em layout físico, recursos e desempenho de uma CPU diferente da série AMD EPYC 7003, da seguinte maneira:

| Tamanho da VM da série HBv3 | Domínios NUMA | Núcleos por domínio NUMA | Semelhança com AMD EPYC |

|---|---|---|---|

| Standard_HB120rs_v3 | 4 | 30 | EPYC 7773X de soquete duplo |

| Standard_HB120-96rs_v3 | 4 | 24 | Tomada dupla EPYC 7643 |

| Standard_HB120-64rs_v3 | 4 | 16 | EPYC 7573X de soquete duplo |

| Standard_HB120-32rs_v3 | 4 | 8 | EPYC 7373X de soquete duplo |

| Standard_HB120-16rs_v3 | 4 | 4 | EPYC 72F3 de soquete duplo |

Nota

Os tamanhos de VM de núcleos restritos reduzem apenas o número de núcleos físicos expostos à VM. Todos os ativos compartilhados globais (RAM, largura de banda de memória, cache L3, conectividade GMI e xGMI, InfiniBand, rede Ethernet do Azure, SSD local) permanecem constantes. Isso permite que um cliente escolha um tamanho de VM mais adequado a um determinado conjunto de necessidades de carga de trabalho ou licenciamento de software.

O mapeamento NUMA virtual de cada tamanho de VM HBv3 é mapeado para a topologia NUMA física subjacente. Não há nenhuma abstração potencialmente enganosa da topologia de hardware.

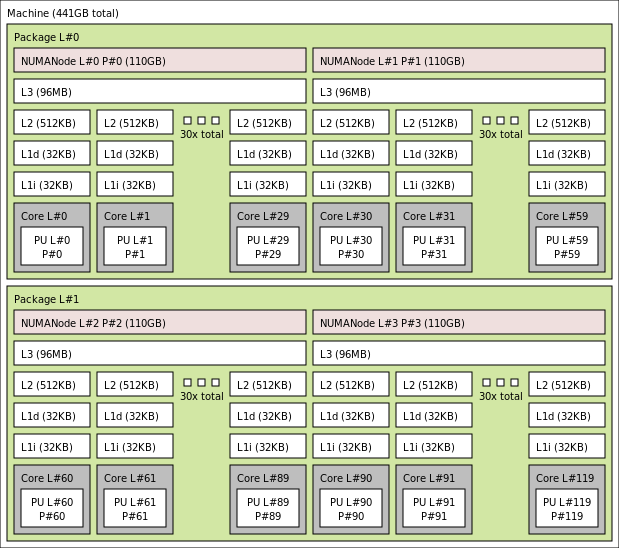

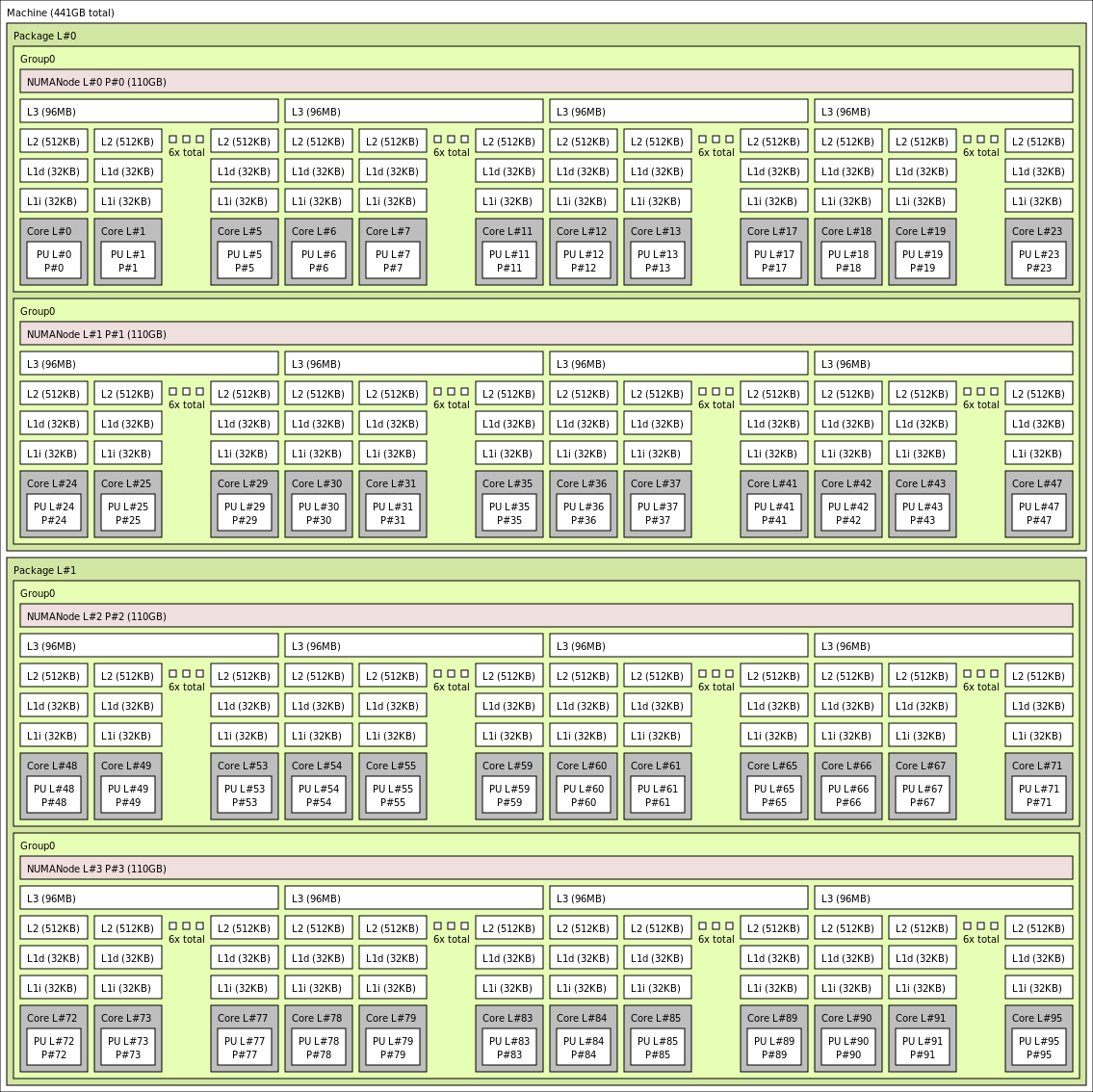

A topologia exata para os vários tamanhos de VM HBv3 aparece da seguinte forma usando a saída de lstopo:

lstopo-no-graphics --no-io --no-legend --of txt

Clique para visualizar a saída lstopo para Standard_HB120rs_v3

Clique para visualizar a saída lstopo para Standard_HB120rs-96_v3

Clique para visualizar a saída lstopo para Standard_HB120rs-64_v3

Clique para ver a saída lstopo para Standard_HB120rs-32_v3

Clique para visualizar a saída lstopo para Standard_HB120rs-16_v3

Rede InfiniBand

As VMs HBv3 também apresentam adaptadores de rede Nvidia Mellanox HDR InfiniBand (ConnectX-6) operando a até 200 Gigabits/seg. A NIC é passada para a VM via SRIOV, permitindo que o tráfego de rede ignore o hipervisor. Como resultado, os clientes carregam drivers padrão Mellanox OFED em VMs HBv3 como se fossem um ambiente bare metal.

As VMs HBv3 suportam Roteamento Adaptativo, o Transporte Conectado Dinâmico (DCT, juntamente com transportes RC e UD padrão) e o descarregamento baseado em hardware de coletivos MPI para o processador integrado do adaptador ConnectX-6. Esses recursos melhoram o desempenho, a escalabilidade e a consistência do aplicativo, e o uso deles é recomendado.

Armazenamento temporário

As VMs HBv3 apresentam 3 dispositivos SSD fisicamente locais. Um dispositivo é pré-formatado para servir como um arquivo de paginação e apareceu em sua VM como um dispositivo "SSD" genérico.

Dois outros SSDs maiores são fornecidos como dispositivos NVMe de bloco não formatados via NVMeDirect. Como o dispositivo NVMe de bloco ignora o hipervisor, ele tem maior largura de banda, IOPS mais alta e menor latência por IOP.

Quando emparelhado em uma matriz distribuída, o SSD NVMe fornece até 7 GB/s de leitura e 3 GB/s de gravação, e até 186.000 IOPS (leituras) e 201.000 IOPS (gravações) para profundidades de fila profundas.

Especificações de hardware

| Especificações de hardware | VMs da série HBv3 |

|---|---|

| Núcleos | 120, 96, 64, 32 ou 16 (SMT desativado) |

| CPU | AMD EPYC 7V73X |

| Freqüência da CPU (não-AVX) | 3,0 GHz (todos os núcleos), 3,5 GHz (até 10 núcleos) |

| Memória | 448 GB (RAM por núcleo depende do tamanho da VM) |

| Disco Local | 2 * 960 GB NVMe (bloco), 480 GB SSD (arquivo de página) |

| Infiniband | 200 Gb/s Mellanox ConnectX-6 HDR InfiniBand |

| Rede | Ethernet de 50 Gb/s (40 Gb/s utilizável) SmartNIC de segunda geração do Azure |

Especificações de software

| Especificações de software | VMs da série HBv3 |

|---|---|

| Tamanho máximo do trabalho MPI | 36.000 núcleos (300 VMs em um único conjunto de escala de máquina virtual com singlePlacementGroup=true) |

| Suporte MPI | HPC-X, Intel MPI, OpenMPI, MVAPICH2, MPICH |

| Estruturas adicionais | UCX, libfabric, PGAS |

| Suporte de armazenamento do Azure | Discos Standard e Premium (máximo 32 discos) |

| Suporte de SO para SRIOV RDMA | RHEL 7.9+, Ubuntu 18.04+, SLES 15.4, WinServer 2016+ |

| SO recomendado para desempenho | Windows Server 2019+ |

| Suporte ao Orchestrator | Azure CycleCloud, Azure Batch, AKS; Opções de configuração de cluster |

Nota

O Windows Server 2012 R2 não é suportado no HBv3 e em outras VMs com mais de 64 núcleos (virtuais ou físicos). Para obter mais detalhes, consulte Sistemas operacionais convidados Windows suportados para Hyper-V no Windows Server.

Importante

Este documento faz referência a uma versão de lançamento do Linux que está se aproximando ou em Fim da Vida Útil (EOL). Por favor, considere atualizar para uma versão mais atual.

Próximos passos

- Leia sobre os anúncios mais recentes, exemplos de carga de trabalho HPC e resultados de desempenho nos Blogs da Comunidade de Tecnologia de Computação do Azure.

- Para obter uma exibição de arquitetura de nível superior da execução de cargas de trabalho HPC, consulte Computação de alto desempenho (HPC) no Azure.