Nota

O acesso a esta página requer autorização. Podes tentar iniciar sessão ou mudar de diretório.

O acesso a esta página requer autorização. Podes tentar mudar de diretório.

Este tutorial explora a integração do padrão RAG usando modelos Open AI e capacidades de pesquisa vetorial numa aplicação .NET. A aplicação de exemplo realiza pesquisas vetoriais em dados personalizados armazenados no Azure Cosmos DB para MongoDB e refina ainda mais as respostas usando modelos de IA generativa, como GPT-35 e GPT-4. Nas secções seguintes, irá configurar uma aplicação de exemplo e explorar exemplos de código chave que demonstram estes conceitos.

Pré-requisitos

- .NET 8.0

- Uma conta do Azure

- Um serviço Azure Cosmos DB for MongoDB vCore

- Um serviço Azure Open AI

- Implementar modelo

text-embedding-ada-002para embeddings - Implementação do modelo

gpt-35-turbopara conclusões de chat

- Implementar modelo

Visão geral da aplicação

A aplicação Cosmos Recipe Guide permite-lhe realizar pesquisas vetoriais e baseadas em IA contra um conjunto de dados de receitas. Pode procurar diretamente as receitas disponíveis ou pedir à aplicação os nomes dos ingredientes para encontrar receitas relacionadas. A aplicação e as secções seguintes guiam-no pelo seguinte fluxo de trabalho para demonstrar este tipo de funcionalidade:

Carregar dados de exemplo para uma base de dados do Azure Cosmos DB para MongoDB.

Crie embeddings e um índice vetorial para os dados de amostra carregados usando o modelo Azure OpenAI

text-embedding-ada-002.Realize uma pesquisa de similaridade vetorial com base nas solicitações do utilizador.

Utilize o modelo de conclusão do Azure OpenAI

gpt-35-turbopara compor respostas mais significativas com base nos dados dos resultados de pesquisa.

Introdução

Clone o seguinte repositório do GitHub:

git clone https://github.com/microsoft/AzureDataRetrievalAugmentedGenerationSamples.gitNa pasta C#/CosmosDB-MongoDBvCore , abra o ficheiro CosmosRecipeGuide.sln .

No ficheiro appsettings.json, substitua os seguintes valores de configuração pelos valores do Azure OpenAI e do Azure CosmosDB para MongoDB.

"OpenAIEndpoint": "https://<your-service-name>.openai.azure.com/", "OpenAIKey": "<your-API-key>", "OpenAIEmbeddingDeployment": "<your-ADA-deployment-name>", "OpenAIcompletionsDeployment": "<your-GPT-deployment-name>", "MongoVcoreConnection": "<your-Mongo-connection-string>"Inicie a aplicação pressionando o botão Iniciar no topo do Visual Studio.

Explore a aplicação

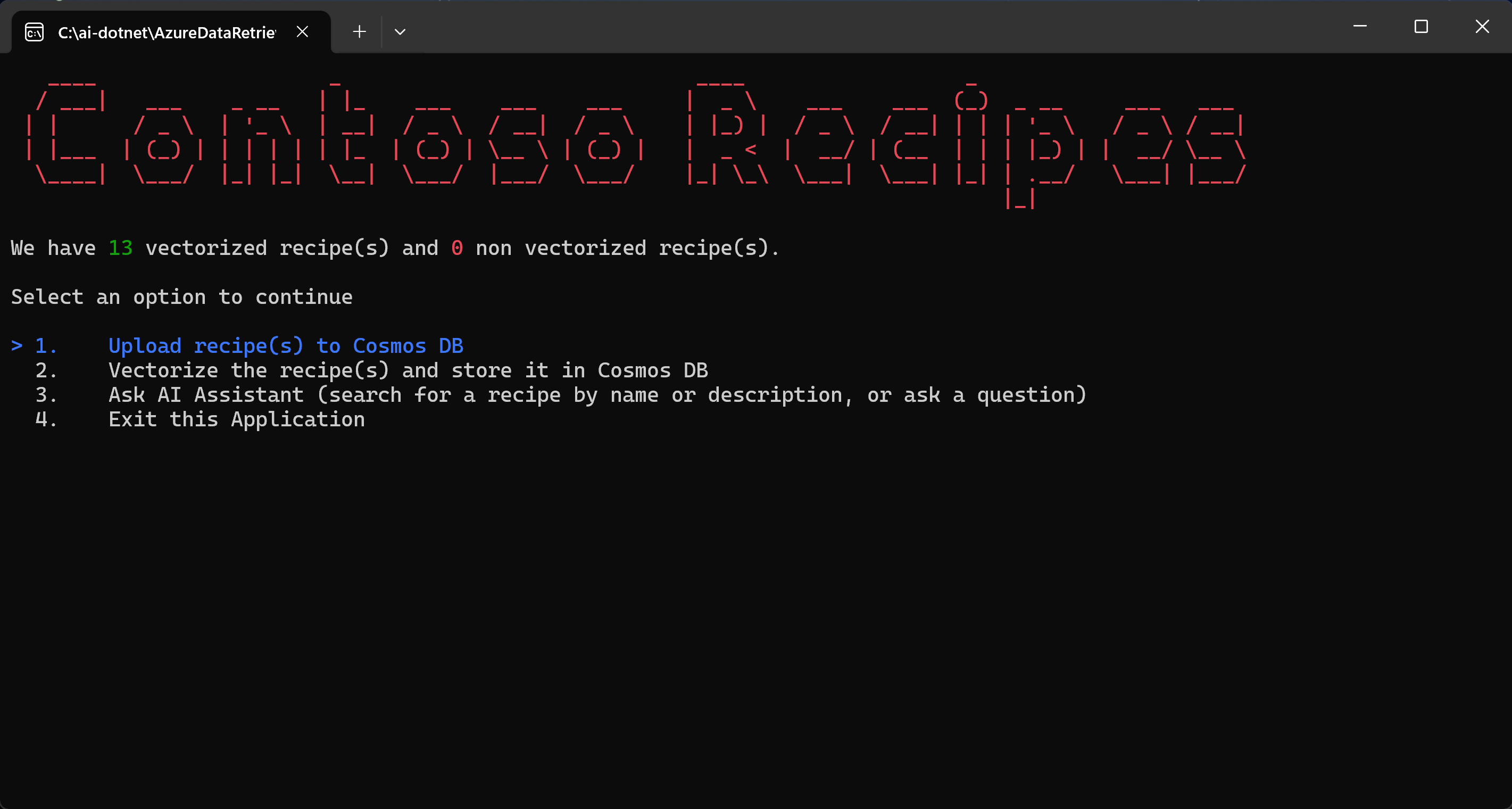

Quando executa a aplicação pela primeira vez, ela liga-se ao Azure Cosmos DB e informa que ainda não há receitas disponíveis. Siga os passos apresentados pela aplicação para iniciar o fluxo de trabalho principal.

Selecione Carregar receita(s) para o Cosmos DB e pressione Enter. Este comando lê ficheiros JSON de exemplo do projeto local e carrega-os para a conta do Cosmos DB.

O código da classe Utility.cs analisa os ficheiros JSON locais.

public static List<Recipe> ParseDocuments(string Folderpath) { List<Recipe> recipes = new List<Recipe>(); Directory.GetFiles(Folderpath) .ToList() .ForEach(f => { var jsonString= System.IO.File.ReadAllText(f); Recipe recipe = JsonConvert.DeserializeObject<Recipe>(jsonString); recipe.id = recipe.name.ToLower().Replace(" ", ""); recipes.Add(recipe); } ); return recipes; }O

UpsertVectorAsyncmétodo no ficheiro VCoreMongoService.cs carrega os documentos para o Azure Cosmos DB para o MongoDB.public async Task UpsertVectorAsync(Recipe recipe) { BsonDocument document = recipe.ToBsonDocument(); if (!document.Contains("_id")) { Console.WriteLine("UpsertVectorAsync: Document does not contain _id."); throw new ArgumentException("UpsertVectorAsync: Document does not contain _id."); } string? _idValue = document["_id"].ToString(); try { var filter = Builders<BsonDocument>.Filter.Eq("_id", _idValue); var options = new ReplaceOptions { IsUpsert = true }; await _recipeCollection.ReplaceOneAsync(filter, document, options); } catch (Exception ex) { Console.WriteLine($"Exception: UpsertVectorAsync(): {ex.Message}"); throw; } }Selecione Vetorizar a(s) receita(s) e guarde-as no Cosmos DB.

Os itens JSON carregados para o Cosmos DB não contêm embeddings e, por isso, não estão otimizados para RAG via pesquisa vetorial. Uma imersão é uma representação numérica densa em informação do significado semântico de um texto. As pesquisas vetoriais conseguem encontrar itens com embeddings contextualmente semelhantes.

O

GetEmbeddingsAsyncmétodo no ficheiro OpenAIService.cs cria uma incorporação para cada item na base de dados.public async Task<float[]?> GetEmbeddingsAsync(dynamic data) { try { EmbeddingsOptions options = new EmbeddingsOptions(data) { Input = data }; var response = await _openAIClient.GetEmbeddingsAsync(openAIEmbeddingDeployment, options); Embeddings embeddings = response.Value; float[] embedding = embeddings.Data[0].Embedding.ToArray(); return embedding; } catch (Exception ex) { Console.WriteLine($"GetEmbeddingsAsync Exception: {ex.Message}"); return null; } }O ficheiro VCoreMongoService.cs cria um índice vetorial, que permite a execução de pesquisas de similaridade vetorial.

public void CreateVectorIndexIfNotExists(string vectorIndexName) { try { //Find if vector index exists in vectors collection using (IAsyncCursor<BsonDocument> indexCursor = _recipeCollection.Indexes.List()) { bool vectorIndexExists = indexCursor.ToList().Any(x => x["name"] == vectorIndexName); if (!vectorIndexExists) { BsonDocumentCommand<BsonDocument> command = new BsonDocumentCommand<BsonDocument>( BsonDocument.Parse(@" { createIndexes: 'Recipe', indexes: [{ name: 'vectorSearchIndex', key: { embedding: 'cosmosSearch' }, cosmosSearchOptions: { kind: 'vector-ivf', numLists: 5, similarity: 'COS', dimensions: 1536 } }] }")); BsonDocument result = _database.RunCommand(command); if (result["ok"] != 1) { Console.WriteLine("CreateIndex failed with response: " + result.ToJson()); } } } } catch (MongoException ex) { Console.WriteLine("MongoDbService InitializeVectorIndex: " + ex.Message); throw; } }Selecione a opção Ask AI Assistant (procure uma receita por nome ou descrição, ou faça uma pergunta) na aplicação para executar uma consulta de utilizador.

A consulta do utilizador é convertida numa embedding usando o serviço Open AI e o modelo de embedding. A incorporação é então enviada para o Azure Cosmos DB para o MongoDB e é usada para realizar uma pesquisa vetorial. O

VectorSearchAsyncmétodo no ficheiro VCoreMongoService.cs realiza uma pesquisa vetorial para encontrar vetores próximos do vetor fornecido e retorna uma lista de documentos do Azure Cosmos DB para o MongoDB vCore.public async Task<List<Recipe>> VectorSearchAsync(float[] queryVector) { List<string> retDocs = new List<string>(); string resultDocuments = string.Empty; try { //Search Azure Cosmos DB for MongoDB vCore collection for similar embeddings //Project the fields that are needed BsonDocument[] pipeline = new BsonDocument[] { BsonDocument.Parse( @$"{{$search: {{ cosmosSearch: {{ vector: [{string.Join(',', queryVector)}], path: 'embedding', k: {_maxVectorSearchResults}}}, returnStoredSource:true }} }}"), BsonDocument.Parse($"{{$project: {{embedding: 0}}}}"), }; var bsonDocuments = await _recipeCollection .Aggregate<BsonDocument>(pipeline).ToListAsync(); var recipes = bsonDocuments .ToList() .ConvertAll(bsonDocument => BsonSerializer.Deserialize<Recipe>(bsonDocument)); return recipes; } catch (MongoException ex) { Console.WriteLine($"Exception: VectorSearchAsync(): {ex.Message}"); throw; } }O método

GetChatCompletionAsyncgera uma resposta melhorada para a conclusão de um chat, baseada no prompt do utilizador e nos resultados relacionados de pesquisa vetorial.public async Task<(string response, int promptTokens, int responseTokens)> GetChatCompletionAsync(string userPrompt, string documents) { try { ChatMessage systemMessage = new ChatMessage( ChatRole.System, _systemPromptRecipeAssistant + documents); ChatMessage userMessage = new ChatMessage( ChatRole.User, userPrompt); ChatCompletionsOptions options = new() { Messages = { systemMessage, userMessage }, MaxTokens = openAIMaxTokens, Temperature = 0.5f, //0.3f, NucleusSamplingFactor = 0.95f, FrequencyPenalty = 0, PresencePenalty = 0 }; Azure.Response<ChatCompletions> completionsResponse = await openAIClient.GetChatCompletionsAsync(openAICompletionDeployment, options); ChatCompletions completions = completionsResponse.Value; return ( response: completions.Choices[0].Message.Content, promptTokens: completions.Usage.PromptTokens, responseTokens: completions.Usage.CompletionTokens ); } catch (Exception ex) { string message = $"OpenAIService.GetChatCompletionAsync(): {ex.Message}"; Console.WriteLine(message); throw; } }A aplicação também utiliza engenharia de prompts para garantir que o serviço da OpenAI limite e formate as respostas para as receitas fornecidas.

//System prompts to send with user prompts to instruct the model for chat session private readonly string _systemPromptRecipeAssistant = @" You are an intelligent assistant for Contoso Recipes. You are designed to provide helpful answers to user questions about recipes, cooking instructions provided in JSON format below. Instructions: - Only answer questions related to the recipe provided below. - Don't reference any recipe not provided below. - If you're unsure of an answer, say ""I don't know"" and recommend users search themselves. - Your response should be complete. - List the Name of the Recipe at the start of your response followed by step by step cooking instructions. - Assume the user is not an expert in cooking. - Format the content so that it can be printed to the Command Line console. - In case there is more than one recipe you find, let the user pick the most appropriate recipe.";