Preços do Data Factory no Microsoft Fabric

O Data Factory no Microsoft Fabric fornece recursos de serviço de integração de dados elásticos e sem servidor criados para escala de nuvem. Não há poder de computação de tamanho fixo que você precise para planejar a carga de pico; em vez disso, você precisa especificar quais operações executar durante a criação de pipelines e fluxos de dados, o que se traduz em uma quantidade de Unidades de Capacidade de Malha consumidas, que você pode acompanhar ainda mais usando o aplicativo Microsoft Fabric Capacity Metrics para planejar e gerenciar suas métricas de consumo. Isso permite que você projete os processos ETL de uma maneira muito mais escalável. Além disso, o Data Factory, como outras experiências do Fabric, é cobrado em um plano baseado no consumo, o que significa que você paga apenas pelo que usar.

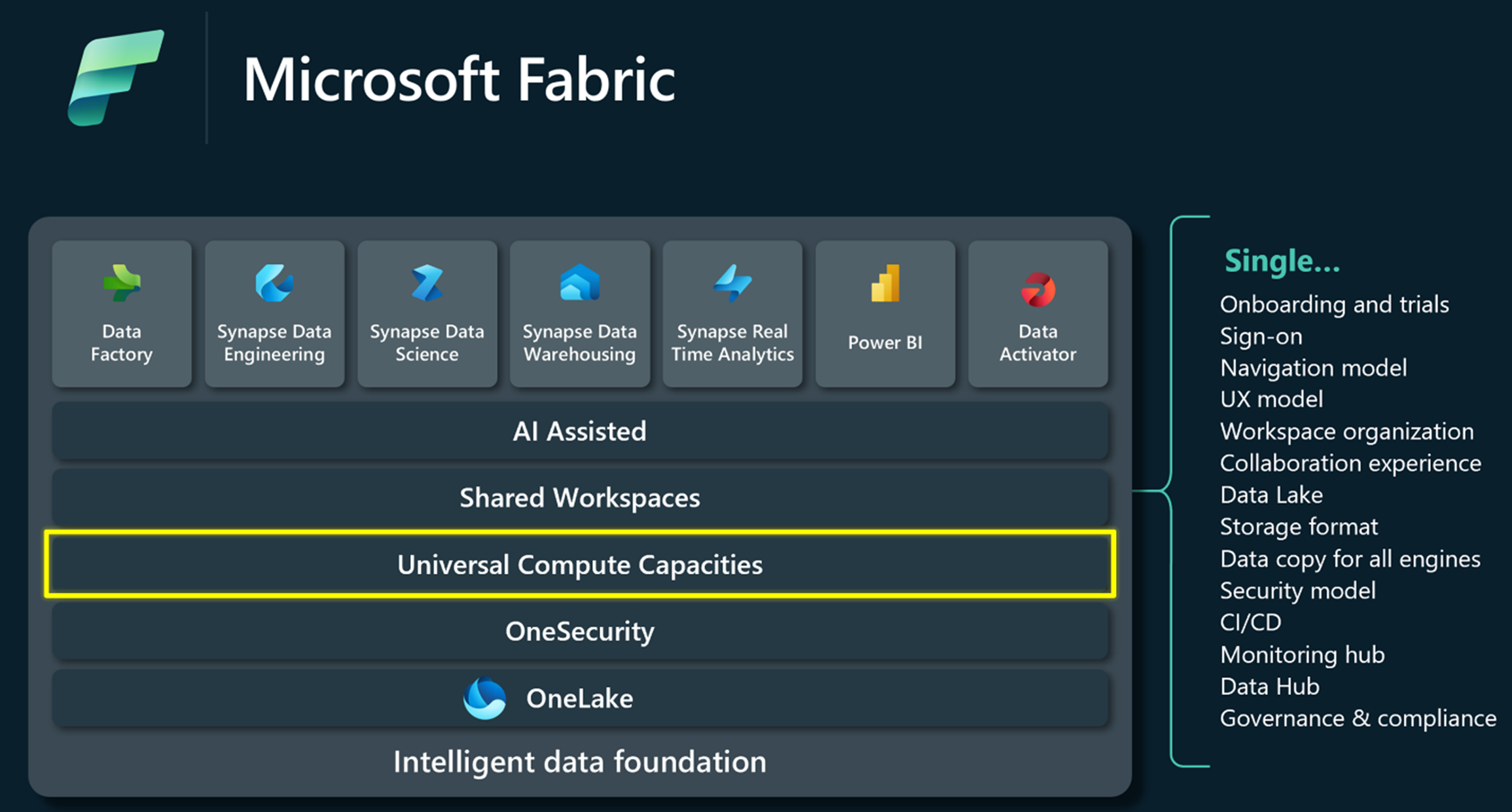

O Fabric é uma plataforma de dados unificada que oferece experiências compartilhadas, arquitetura, governança, conformidade e cobrança. As capacidades fornecem o poder de computação que impulsiona todas essas experiências. Eles oferecem uma maneira simples e unificada de dimensionar recursos para atender à demanda do cliente e podem ser facilmente aumentados com uma atualização de SKU.

Você pode gerenciar seus custos de execução do Fabric Data Factory facilmente com faturamento simplificado. Os usuários adicionais não exigem nenhum gerenciamento de custos por usuário, e você pode economizar dinheiro planejando e comprometendo as capacidades do Fabric para seus projetos de integração de dados com antecedência. Com a opção de pagamento conforme o uso, você pode facilmente escalar suas capacidades para cima e para baixo para ajustar seu poder de computação e pausar suas capacidades quando não estiverem em uso para economizar custos. Saiba mais sobre as capacidades do Fabric e o faturamento de uso.

Quer seja um cidadão ou um programador profissional, o Data Factory permite-lhe desenvolver soluções de integração de dados à escala empresarial com fluxos de dados e pipelines de dados da próxima geração. Estas experiências operam em múltiplos serviços com diferentes medidores de capacidade. Os pipelines de dados usam medidores de orquestração de dados e movimentação de dados, enquanto o Dataflow Gen2 usa computação padrão e computação de alta escala. Além disso, como outras experiências de malha, o medidor comum para consumo de armazenamento é o OneLake Storage.

Aqui estão alguns cenários de exemplo para a definição de preços de pipelines de dados:

- Carregue o Parquet de 1 TB em um data warehouse

- Carregue o Parquet de 1 TB em um data warehouse por meio de preparo

- Carregue arquivos CSV de 1 TB em uma tabela Lakehouse

- Carregue arquivos CSV de 1 TB em arquivos Lakehouse com cópia binária

- Carregue o Parquet de 1 TB em uma mesa Lakehouse

Aqui estão alguns exemplos de preços para o Dataflow Gen2: