Software e hardware (SH) integrado recursos e tecnologias

Aplica-se a: Windows Server 2022, Windows Server 2019, Azure Stack HCI, versões 21H2 e 20H2

Esses recursos têm componentes de software e hardware. O software está intimamente vinculado a recursos de hardware necessários para que o recurso funcione. Exemplos deles incluem VMMQ, VMQ, IPv4 Checksum Offload do lado de envio e RSS. Para saber mais, confira Requisitos de rede de host do Azure Stack HCI.

Dica

Os recursos de SH e HO estarão disponíveis se a NIC instalada oferecer suporte. As descrições dos recursos abaixo abordam como saber se a NIC dá suporte ao recurso.

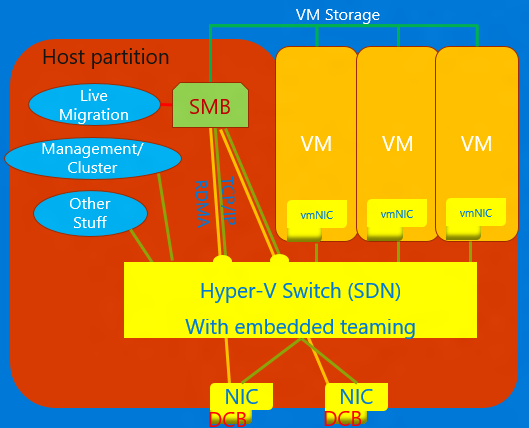

NIC convergida

A NIC convergida é uma tecnologia que permite que NICs virtuais no host Hyper-V exponham serviços RDMA a processos de host. Windows Server 2016 não requer mais NICs separadas para RDMA. O recurso NIC Convergida permite que as NICs Virtuais na partição host (vNICs) exponham o RDMA à partição do host e compartilhem a largura de banda das NICs entre o tráfego RDMA e a VM e outro tráfego TCP/UDP de maneira justa e gerenciável.

Gerencie a operação da NIC convergida por meio de VMM ou do PowerShell do Windows. Os cmdlets do PowerShell são os mesmos cmdlets usados para RDMA (veja abaixo).

Para usar a funcionalidade de NIC convergida:

Certifique-se de configurar o host para DCB.

Habilite o RDMA na NIC ou, no caso de uma equipe SET, as NICs estão associadas à opção Hyper-V.

Habilitar o RDMA nos vNICs designados para RDMA no host.

Para obter mais detalhes sobre RDMA e SET, consulte RDMA (Acesso remoto direto à memória) e SET (Agrupamento Inserido com Switch).

DCB (Data Center Bridging)

O DCB é um conjunto de padrões do IEEE (Instituto de Engenheiros Eletricistas e Eletrônicos) que permitem malhas convergentes em data centers. O DCB fornece gerenciamento de largura de banda baseado em fila de hardware em um host com cooperação do comutador adjacente. Todo o tráfego para armazenamento, rede de dados, IPC (comunicação entre processos) de cluster e gerenciamento compartilham a mesma infraestrutura de rede Ethernet. No Windows Server 2016, o DCB pode ser aplicado a qualquer NIC individualmente e NICs associadas à opção Hyper-V.

Para DCB, o Windows Server usa o PFC (controle de fluxo baseado em prioridade), padronizado no IEEE 802.1Qbb. O PFC cria uma malha de rede quase sem perda, impedindo o estouro dentro das classes de tráfego. O Windows Server também usa a ETS (Seleção avançada de transmissão), padronizada no IEEE 802.1Qaz. O ETS permite a divisão da largura de banda em partes reservadas para até oito classes de tráfego. Cada classe de tráfego tem sua própria fila de transmissão e, por meio do uso de PFC, pode iniciar e interromper a transmissão dentro de uma classe.

Virtualização de Rede Hyper-V

| Versão | Descrição |

|---|---|

| v1 (HNVv1) | Introduzido no Windows Server 2012, a HNV (Virtualização de Rede Hyper-V) permite a virtualização de redes de clientes sobre uma infraestrutura de rede física compartilhada. Com as alterações mínimas necessárias na malha de rede física, a HNV oferece aos provedores de serviços a agilidade para implantar e migrar cargas de trabalho de locatário em qualquer lugar entre as três nuvens: a nuvem do provedor de serviços, a nuvem privada ou a nuvem pública do Microsoft Azure. |

| v2 NVGRE (HNVv2 NVGRE) | No Windows Server 2016 e no Gerenciador de Máquina Virtual do System Center, a Microsoft fornece uma solução de virtualização de rede de ponta a ponta que inclui Gateway RAS, balanceamento de carga de software, controlador de rede e muito mais. Para obter mais informações, consulte Visão geral da Virtualização de Rede Hyper-V no Windows Server 2016. |

| v2 VxLAN (HNVv2 VxLAN) | No Windows Server 2016, faz parte da extensão da SDN, que você gerencia por meio do Controlador de Rede. |

IPsecTO (IPsec Task Offload)

O IPsec Task Offload é um recurso de NIC que permite que o sistema operacional use o processador na NIC para o trabalho de criptografia IPsec.

Importante

O IPsec Task Offload é uma tecnologia herdada que não tem suporte na maioria dos adaptadores de rede e, onde ele existe, é desabilitado por padrão.

PVLAN (Rede Local Virtual Privada).

As PVLANs permitem a comunicação somente entre máquinas virtuais no mesmo servidor de virtualização. Uma rede virtual privada não está associada a um adaptador de rede física. Uma rede virtual privada é isolada de todo o tráfego de rede externo no servidor de virtualização, bem como qualquer tráfego de rede entre o sistema operacional de gerenciamento e a rede externa. Esse tipo de rede é útil quando você precisa criar um ambiente isolado de rede, como um domínio de teste isolada. As pilhas Hyper-V e SDN dão suporte apenas ao modo porta isolada PVLAN.

Para obter detalhes sobre o isolamento PVLAN, consulte System Center: blog de engenharia Virtual Machine Manager.

Acesso Remoto Direto à Memória (RDMA)

O RDMA é uma tecnologia de rede que fornece comunicação de baixa latência e alta taxa de transferência, minimizando o uso da CPU. O RDMA dá suporte à rede de cópia zero, permitindo que o adaptador de rede transfira dados diretamente de ou para a memória do aplicativo. Capacidade de RDMA significa que a NIC (física ou virtual) é capaz de expor RDMA a um cliente RDMA. Habilitado para RDMA, por outro lado, significa que uma NIC compatível com RDMA está expondo a interface RDMA na pilha.

Para obter mais detalhes sobre RDMA, consulte RDMA (Acesso remoto direto à memória) e SET (Agrupamento Inserido com Switch).

RSS (Receive Side Scaling)

O RSS é um recurso de NIC que separa diferentes conjuntos de fluxos e os entrega a diferentes processadores para processamento. O RSS paraleliza o processamento de rede, permitindo que um host seja dimensionado para taxas de dados muito altas.

Para obter mais detalhes, consulte RSS (Receive Side Scaling).

SR-IOV (Virtualização de Entrada-Saída de Raiz Única)

SR-IOV permite que o tráfego de VM se mova diretamente da NIC para a VM sem passar pelo host Hyper-V. SR-IOV é uma melhoria incrível no desempenho de uma VM, mas não tem a capacidade do host de gerenciar esse canal. Use APENAS SR-IOV quando a carga de trabalho for bem comportada, confiável e geralmente a única VM no host.

O tráfego que usa SR-IOV ignora a opção Hyper-V, o que significa que quaisquer políticas, por exemplo, ACLs ou gerenciamento de largura de banda não serão aplicadas. O tráfego SR-IOV também não pode ser passado por nenhuma funcionalidade de virtualização de rede, portanto, o encapsulamento NV-GRE ou VxLAN não pode ser aplicado. Use SR-IOV apenas para cargas de trabalho bem confiáveis em situações específicas. Além disso, não é possível usar as políticas de host, o gerenciamento de largura de banda e as tecnologias de virtualização.

No futuro, duas tecnologias permitiriam SR-IOV: GFT (Tabelas de Fluxo Genéricas) e Descarregamento de QoS de Hardware (gerenciamento de largura de banda na NIC) – uma vez que as NICs em nosso ecossistema dão suporte a elas. A combinação dessas duas tecnologias tornaria o SR-IOV útil para todas as VMs, permitiria que políticas, virtualização e regras de gerenciamento de largura de banda fossem aplicadas e poderia resultar em grandes avanços na aplicação geral do SR-IOV.

Para obter mais detalhes, consulte Visão geral da SR-IOV (virtualização de E/S de raiz única).

TCP Chimney Offload

O TCP Chimney Offload, também conhecido como TOE (TCP Engine Offload), é uma tecnologia que permite que o host descarregue todo o processamento de TCP para a NIC. Como a pilha TCP do Windows Server é quase sempre mais eficiente do que o mecanismo TOE, não é recomendável usar o TCP Chimney Offload.

Importante

O TCP Chimney Offload é uma tecnologia preterida. É recomendável não usar o TCP Chimney Offload, pois a Microsoft pode parar de dar suporte a ele no futuro.

VLAN (rede local virtual)

A VLAN é uma extensão para o cabeçalho do quadro Ethernet para habilitar o particionamento de uma LAN em várias VLANs, cada uma usando seu próprio espaço de endereço. No Windows Server 2016, as VLANs são definidas em portas do comutador Hyper-V ou em interfaces de equipe em equipes do agrupamento NIC.

VMQ (Fila de Máquina Virtual)

VMQs é um recurso de NIC que aloca uma fila para cada VM. Sempre que você tiver o Hyper-V habilitado, é necessário também habilitar o VMQ. No Windows Server 2016, as VMQs usam vPorts NIC Switch com uma única fila atribuída ao vPort para fornecer a mesma funcionalidade.

VMMQ (várias filas de máquina virtual)

O VMMQ é um recurso de NIC que permite que o tráfego de uma VM se espalhe por várias filas, cada uma processada por um processador físico diferente. Em seguida, o tráfego é passado para vários LPs na VM como seria no vRSS, o que permite fornecer largura de banda de rede substancial para a VM.

Comentários

Brevemente: Ao longo de 2024, vamos descontinuar progressivamente o GitHub Issues como mecanismo de feedback para conteúdos e substituí-lo por um novo sistema de feedback. Para obter mais informações, veja: https://aka.ms/ContentUserFeedback.

Submeter e ver comentários