Descrição geral dos exemplos de controlo ocular – MRTK2

Este tópico descreve como começar rapidamente com o controlo ocular no MRTK ao basear-se em exemplos de controlo ocular do MRTK (Assets/MRTK/Examples/Demos/EyeTracking). Estes exemplos permitem-lhe experimentar uma das nossas novas capacidades de entrada mágicas: Controlo ocular! A demonstração inclui vários casos de utilização, desde ativações implícitas baseadas nos olhos até como combinar informações totalmente integradas sobre o que está a ver com entrada de voz e mão . Isto permite que os utilizadores selecionem e movam rapidamente e sem esforço conteúdos holográficos na vista, bastando olhar para um destino e dizer "Selecionar" ou efetuar um gesto de mão. As demonstrações também incluem um exemplo para deslocamento direcionado para os olhos, pan e zoom de texto e imagens numa ardósia. Por fim, é fornecido um exemplo para gravar e visualizar a atenção visual do utilizador numa ardósia 2D. Na secção seguinte, encontrará mais detalhes sobre o que cada uma das diferentes amostras no pacote de exemplo de controlo ocular MRTK (Assets/MRTK/Examples/Demos/EyeTracking) inclui:

![]()

A secção seguinte é uma descrição geral rápida do que são as cenas individuais de demonstração de controlo ocular. As cenas de demonstração de controlo ocular do MRTK são carregadas de forma aditiva, o que explicaremos abaixo como configurar.

Descrição geral dos exemplos de demonstração de controlo ocular

Seleção de Destino Suportada por Olhos

Este tutorial mostra a facilidade de aceder aos dados de olhar para os olhos para selecionar destinos. Inclui um exemplo de comentários subtis mas poderosos para fornecer ao utilizador a confiança de que um destino está focado sem ser esmagador. Além disso, existe um exemplo simples de notificações inteligentes que desaparecem automaticamente depois de serem lidas.

Resumo: seleções de destino rápidas e sem esforço com uma combinação de olhos, voz e entrada manual.

Navegação Suportada por Olhos

Imagine que está a ler algumas informações num ecrã distante ou no seu e-reader e, quando chega ao fim do texto apresentado, o texto desloca-se automaticamente para cima para revelar mais conteúdo. Ou que tal ampliar magicamente diretamente para onde estavas a olhar? Estes são alguns dos exemplos apresentados neste tutorial sobre a navegação suportada por olhos. Além disso, existe um exemplo para a rotação mãos-livres de hologramas 3D ao fazê-los rodar automaticamente com base no seu foco atual.

Resumo: desloque-se, pan, zoom, rotação 3D com uma combinação de olhos, voz e entrada manual.

Posicionamento Suportado por Olhos

Este tutorial mostra um cenário de entrada chamado Put-That-There que remonta à pesquisa do MIT Media Lab no início da década de 1980 com entrada de olhos, mãos e voz. A ideia é simples: tire partido dos seus olhos para uma seleção e posicionamento de destino rápidos. Basta olhar para um holograma e dizer "põe isto", olha para onde queres colocá-lo e diz 'lá!'. Para posicionar o holograma com mais precisão, pode utilizar entradas adicionais das mãos, voz ou controladores.

Resumo: Posicionar hologramas com os olhos, voz e entrada da mão (arrastar e largar). Controlos de deslize suportados por olhos com olhos + mãos.

Visualização da atenção visual

Os dados com base no aspeto dos utilizadores são uma ferramenta extremamente poderosa para avaliar a usabilidade de uma estrutura e identificar problemas em fluxos de trabalho eficientes. Este tutorial aborda diferentes visualizações de controlo ocular e como se adequam a diferentes necessidades. Fornecemos exemplos básicos para registar e carregar dados de controlo ocular e exemplos sobre como visualizá-los.

Resumo: Mapa de atenção bidimensional (mapas térmicos) em ardósias. Gravar & a reproduzir dados de controlo ocular.

Configurar os exemplos de controlo ocular do MRTK

Pré-requisitos

Tenha em atenção que a utilização dos exemplos de controlo ocular no dispositivo requer um HoloLens 2 e um pacote de aplicação de exemplo criado com a capacidade "Gaze Input" no AppXManifest do pacote.

Para utilizar estes exemplos de controlo ocular no dispositivo, certifique-se de que segue estes passos antes de criar a aplicação no Visual Studio.

1. Carregar EyeTrackingDemo-00-RootScene.unity

O EyeTrackingDemo-00-RootScene é a cena base (raiz) que tem todos os componentes de MRTK principais incluídos. Esta é a cena que precisa de carregar primeiro e a partir da qual irá executar as demonstrações de controlo ocular. Apresenta um menu de cena gráfica que lhe permite alternar facilmente entre as diferentes amostras de controlo ocular que serão carregadas de forma aditiva.

![]()

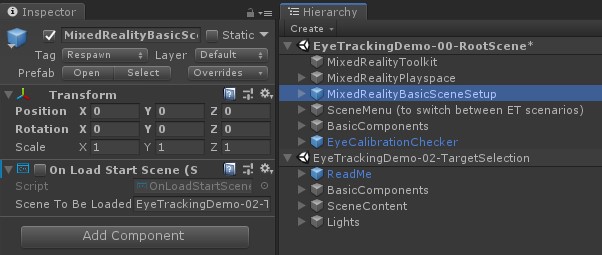

A cena raiz inclui alguns componentes principais que irão persistir nas cenas carregadas de forma aditiva, como os perfis configurados pelo MRTK e a câmara de cena. O MixedRealityBasicSceneSetup (ver captura de ecrã abaixo) inclui um script que carregará automaticamente a cena referenciada no arranque. Por predefinição, trata-se de EyeTrackingDemo-02-TargetSelection.

![]()

2. Adicionar cenas ao menu de compilação

Para carregar cenas de adição durante o runtime, primeiro tem de adicionar estas cenas ao menu Definições de Compilação –> Cenas na Compilação . É importante que a cena raiz seja apresentada como a primeira cena na lista:

![]()

3. Reproduzir os exemplos de controlo ocular no editor do Unity

Depois de adicionar as cenas de controlo ocular às Definições de Compilação e carregar o EyeTrackingDemo-00-RootScene, poderá querer verificar uma última coisa: O script "OnLoadStartScene" está anexado ao MixedRealityBasicSceneSetup GameObject ativado? Isto é para que a cena raiz saiba qual a cena de demonstração a carregar primeiro.

![]()

Vamos rolar! Toque em "Reproduzir"! Deverá ver várias pedras preciosas apresentadas e o menu de cena na parte superior.

![]()

Também deve reparar num pequeno círculo semitransparente no centro da vista de jogo. Isto funciona como um indicador (cursor) do seu olhar simulado: basta premir o botão direito do rato e mover o rato para alterar a sua posição. Quando o cursor estiver a pairar sobre as pedras preciosas, irá reparar que irá encaixar no centro da jóia atualmente visualizada. Esta é uma excelente forma de testar se os eventos são acionados conforme esperado ao "olhar" para um destino. Tenha em atenção que o olhar simulado através do controlo do rato é um suplemento bastante fraco para os nossos movimentos oculares rápidos e não intencionais. No entanto, é ótimo para testar a funcionalidade básica antes de iterar na estrutura ao implementá-la no dispositivo HoloLens 2. Voltando à nossa cena de exemplo de controlo ocular: a jóia roda enquanto for olhada e pode ser destruída ao "olhar" para ela e...

- Premir Enter (que simula a indicação "selecionar")

- A indicar "selecionar" no microfone

- Ao premir a tecla Espaço para mostrar a entrada da mão simulada, clique no botão esquerdo do rato para executar uma pitada simulada

Descrevemos mais detalhadamente como pode alcançar estas interações no nosso tutorial de Seleção de Destino Suportada por Olhos .

Ao mover o cursor para a barra de menus superior na cena, irá reparar que o item atualmente pairado irá realçar subtilmente. Pode selecionar o item atualmente realçado com um dos métodos de consolidação descritos acima (por exemplo, premir Enter). Desta forma, pode alternar entre as diferentes cenas de exemplo de controlo ocular.

4. Como testar sub-cenas específicas

Ao trabalhar num cenário específico, poderá não querer passar sempre pelo menu de cenas. Em vez disso, poderá querer começar diretamente a partir da cena em que está a trabalhar ao premir o botão Reproduzir . Não há problema! Eis o que pode fazer:

Carregar a cena raiz

Na cena raiz, desative o script "OnLoadStartScene"

Arraste e largue uma das cenas de teste de controlo ocular descritas abaixo (ou qualquer outra cena) na vista Hierarquia , conforme mostrado na captura de ecrã abaixo.

Premir Reprodução

Tenha em atenção que carregar a subtema desta forma não é persistente: isto significa que, se implementar a sua aplicação no dispositivo HoloLens 2, esta só carregará a cena raiz (partindo do princípio de que aparece na parte superior das Definições de Compilação). Além disso, quando partilha o seu projeto com outras pessoas, as sub-cenas não são carregadas automaticamente.

Agora que sabe como fazer com que as cenas de exemplo de controlo ocular do MRTK funcionem, vamos continuar a aprofundar a forma de selecionar hologramas com os olhos: seleção de destino suportada pelos olhos.