Примечание.

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

ОБЛАСТЬ ПРИМЕНЕНИЯ: Фабрика данных Azure

Фабрика данных Azure  Azure Synapse Analytics

Azure Synapse Analytics

Совет

Попробуйте использовать фабрику данных в Microsoft Fabric, решение для аналитики с одним интерфейсом для предприятий. Microsoft Fabric охватывает все, от перемещения данных до обработки и анализа данных в режиме реального времени, бизнес-аналитики и отчетности. Узнайте, как бесплатно запустить новую пробную версию !

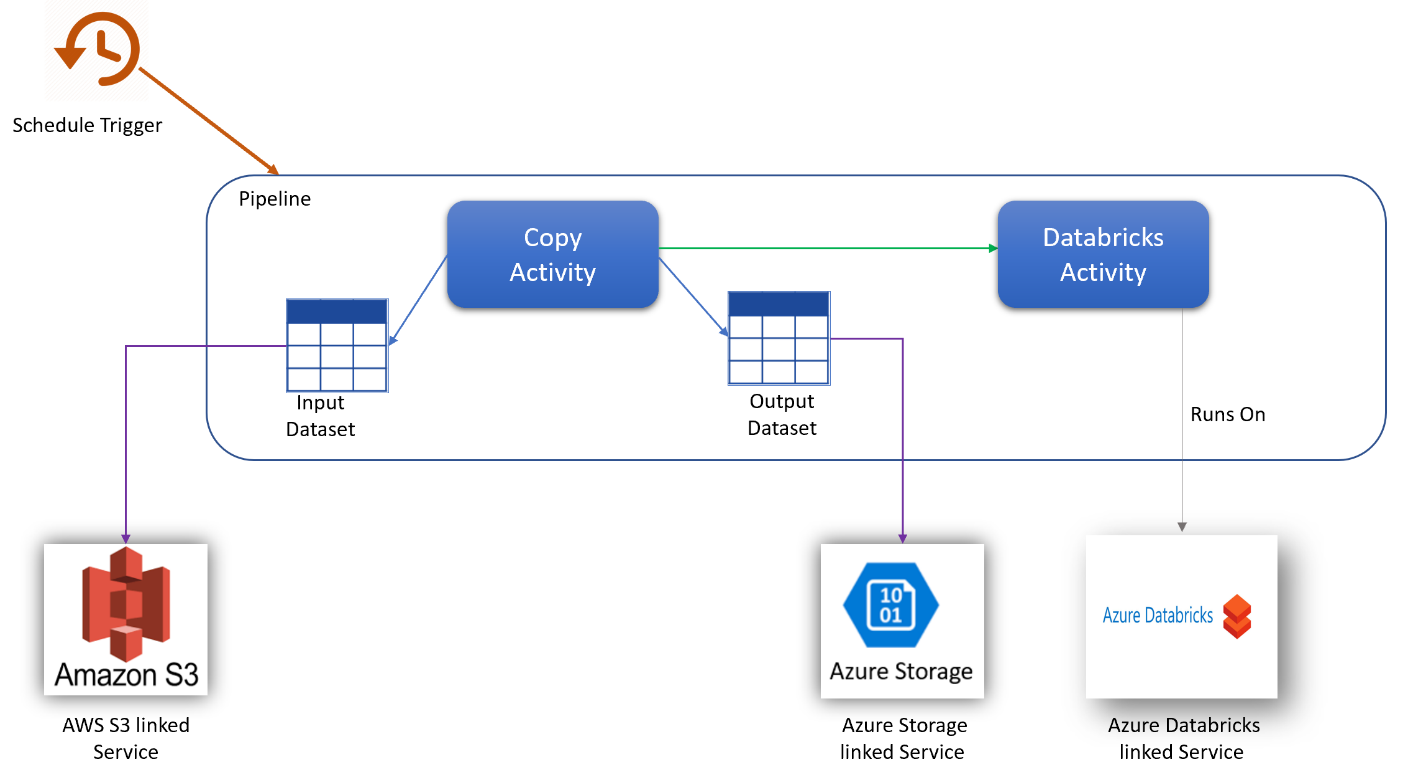

В этом сценарии необходимо копировать данные из AWS S3 в хранилище BLOB-объектов Azure и преобразовывать данные с помощью Azure Databricks с интервалом в один час, в течение 8 часов в день, на протяжении 30 дней.

Цены, используемые в этом примере ниже, являются гипотетическими и не предназначены для того, чтобы подразумевать точные фактические цены. Затраты на чтение и запись и мониторинг не отображаются, так как они обычно не являются незначительными и не влияют на общие затраты. Запуски действий также округляются до ближайших 1000 в расчётах ценового калькулятора.

Примечание.

Эта оценка касается только затрат на Azure Data Factory. Azure Databricks также будет нести затраты в этом сценарии, которые можно оценить с помощью калькулятора цен Azure.

Ознакомьтесь с калькулятором цен Azure для более конкретных сценариев и оцените будущие затраты на использование службы.

Настройка

Для выполнения сценария необходимо создать конвейер со следующими элементами.

- Одно действие копирования с входным набором данных для копирования данных из AWS S3 и набор выходных данных для данных хранилища Azure.

- Одно действие преобразования данных с помощью Azure Databricks.

- Один триггер расписания для выполнения конвейера каждый час. Если вы хотите запустить конвейер, его можно активировать немедленно или запланировать. Помимо самой конвейерной линии, каждый экземпляр триггера считается одним запуском активности.

Оценка затрат

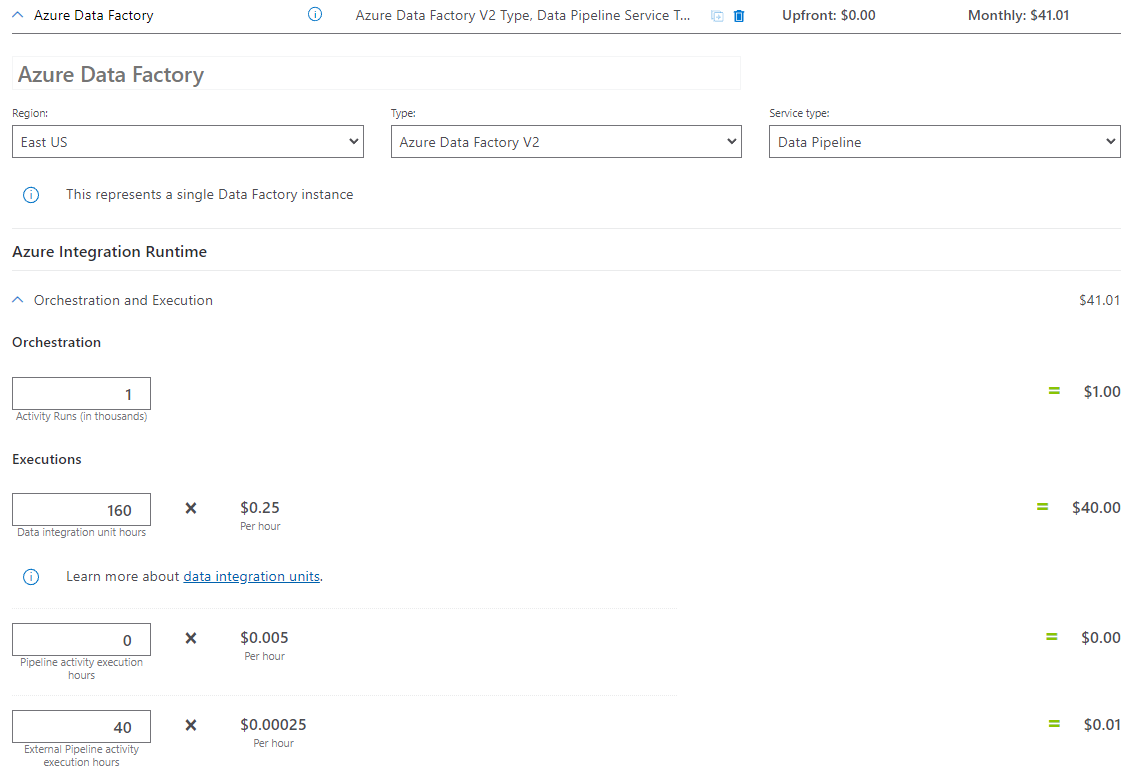

| Операции | Типы и единицы измерения |

|---|---|

| Запуск потока | 3 запуска действия на запуск (1 для запуска триггера, 2 для запусков действия) = 720 запусков действия, округлено вверх, поскольку калькулятор позволяет увеличивать только на 1000. |

| Предположение копирования данных: часы DIU на выполнение = 10 минут | 10 мин \ 60 мин * 4 Среда выполнения интеграции Azure (параметр DIU по умолчанию = 4) Дополнительные сведения об единицах интеграции данных и оптимизации производительности копирования см. эту статью |

| Выполнение действия Databricks: внешнее время выполнения на одно выполнение = 10 мин | 10 мин \ 60 мин. Выполнение действия внешнего конвейера |

Пример калькулятора цен

Общая цена на сценарий за 30 дней: $41,01

Связанный контент

- Пример ценообразования: ежечасное копирование данных из AWS S3 в хранилище Azure Blob в течение 30 дней

- Пример ценообразования: ежечасное копирование данных и их преобразование с использованием динамических параметров в течение 30 дней

- Пример ценообразования: запуск пакетов служб SSIS в среде выполнения интеграции Azure-SSIS

- Пример ценообразования: отладка потока данных сопоставления в типичный рабочий день

- Пример ценообразования: преобразование данных в хранилище блоб-данных с помощью потоков данных сопоставления

- Пример ценообразования: интеграция данных в управляемой виртуальной сети Фабрика данных Azure

- Пример ценообразования: получение разностных данных из SAP ECC с помощью SAP CDC в потоках данных сопоставления