Руководство по настройке Azure OpenAI GPT-4o-mini

В этом руководстве описана настройка gpt-4o-mini-2024-07-18 модели.

Из этого руководства вы узнаете, как выполнить следующие задачи:

- Создание примеров наборов данных точной настройки.

- Создайте переменные среды для конечной точки ресурса и ключа API.

- Подготовьте примеры наборов данных для обучения и проверки для точной настройки.

- Отправьте файл обучения и файл проверки для точной настройки.

- Создание задания точной настройки для

gpt-4o-mini-2024-07-18. - Разверните настраиваемую настраиваемую модель.

Необходимые компоненты

- Подписка Azure — создайте бесплатную учетную запись.

- Python 3.8 или более поздней версии

- Следующие библиотеки Python:

json,requests,os,tiktoken,time,openai.numpy - Записные книжки Jupyter

- Ресурс Azure OpenAI в регионе , где

gpt-4o-mini-2024-07-18доступна точная настройка. Если у вас нет ресурса, процесс его создания описан в нашем руководстве по развертыванию ресурсов. - Для доступа к тонкой настройке требуется участник OpenAI Cognitive Services.

- Если у вас еще нет доступа к квоте и развертыванию моделей на портале Azure AI Foundry, вам потребуется больше разрешений.

Внимание

Мы рекомендуем ознакомиться с сведениями о ценах для точной настройки, чтобы ознакомиться с связанными затратами. Тестирование этого руководства привело к выставлению счетов за 48 000 токенов (4800 токенов обучения * 10 эпох обучения). Затраты на обучение в дополнение к затратам, связанным с точной настройкой вывода, и почасовой размещения затрат на развертывание точно настроенной модели. Завершив работу с руководством, необходимо удалить подробное развертывание модели, в противном случае вы будете продолжать нести почасовую стоимость размещения.

Настройка

Библиотеки Python

В этом руководстве приведены примеры некоторых последних функций OpenAI: начальные значения, события и контрольные точки. Чтобы воспользоваться преимуществами этих функций, может потребоваться выполнить pip install openai --upgrade обновление до последнего выпуска.

pip install openai requests tiktoken numpy

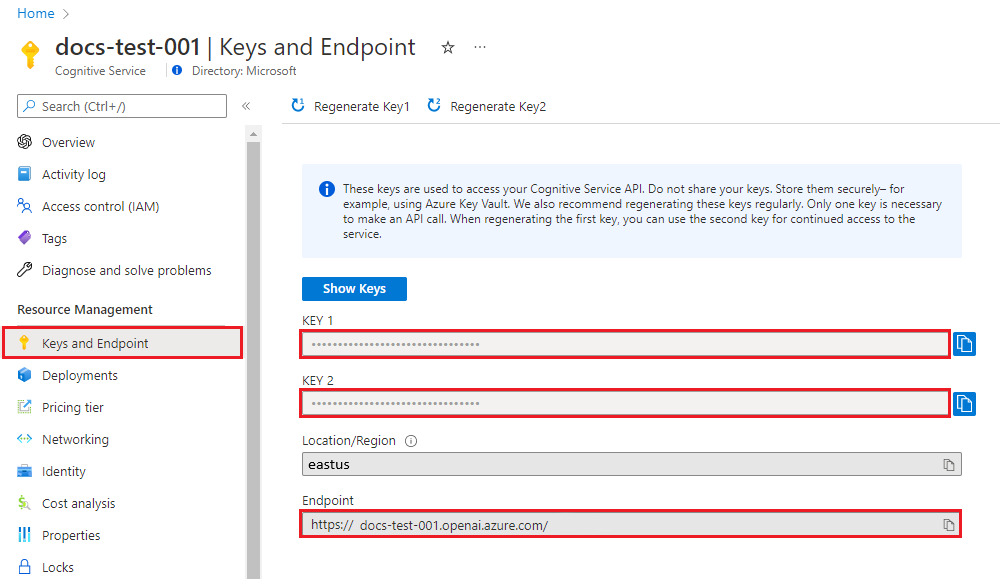

Получение ключа и конечной точки

Чтобы успешно выполнить вызов к Azure OpenAI, вам потребуется конечная точка и ключ.

| Имя переменной | Значение |

|---|---|

ENDPOINT |

Конечная точка службы можно найти в разделе "Ключи" и "Конечная точка" при изучении ресурса из портал Azure. Кроме того, можно найти конечную точку на странице "Развертывания " на портале Azure AI Foundry. Пример конечной точки: https://docs-test-001.openai.azure.com/. |

API-KEY |

Это значение можно найти в разделе Ключи и конечная точка при просмотре ресурса на портале Azure. Вы можете использовать KEY1 или KEY2. |

Перейдите к своему ресурсу на портале Azure. Раздел "Ключи и конечная точка " можно найти в разделе "Управление ресурсами". Скопируйте конечную точку и ключ доступа, так как они потребуются для проверки подлинности вызовов API. Вы можете использовать KEY1 или KEY2. Наличие двух ключей позволяет безопасно менять и повторно создавать ключи без прерывания работы службы.

Переменные среды

Создайте и назначьте переменные постоянной среды для ключа и конечной точки.

Внимание

Если вы используете ключ API, сохраните его в другом месте, например в Azure Key Vault. Не включайте ключ API непосредственно в код и никогда не публикуйте его.

Дополнительные сведения о безопасности служб ИИ см. в статье "Проверка подлинности запросов к службам ИИ Azure".

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

Создание примера набора данных

Для тонкой настройки gpt-4o-mini-2024-07-18 требуется специально отформатированный файл обучения JSONL. OpenAI предоставляет следующий пример в своей документации:

{"messages": [{"role": "system", "content": "Marv is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the capital of France?"}, {"role": "assistant", "content": "Paris, as if everyone doesn't know that already."}]}

{"messages": [{"role": "system", "content": "Marv is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who wrote 'Romeo and Juliet'?"}, {"role": "assistant", "content": "Oh, just some guy named William Shakespeare. Ever heard of him?"}]}

{"messages": [{"role": "system", "content": "Marv is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "How far is the Moon from Earth?"}, {"role": "assistant", "content": "Around 384,400 kilometers. Give or take a few, like that really matters."}]}

В этом примере мы немного изменим это, изменив следующее:

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the capital of France?"}, {"role": "assistant", "content": "Paris, as if everyone doesn't know that already."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who wrote 'Romeo and Juliet'?"}, {"role": "assistant", "content": "Oh, just some guy named William Shakespeare. Ever heard of him?"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "How far is the Moon from Earth?"}, {"role": "assistant", "content": "Around 384,400 kilometers. Give or take a few, like that really matters."}]}

Хотя эти три примера полезны для предоставления общего формата, если вы хотите управлять пользовательской точно настроенной моделью для реагирования таким же образом, вам потребуется больше примеров. Как правило, вы хотите начать по крайней мере 50 высококачественных примеров . Тем не менее, вполне возможно иметь вариант использования, который может потребовать 1000 из высококачественных примеров обучения для успешного выполнения.

Как правило, удвоение размера набора данных может привести к линейному увеличению качества модели. Но помните, что примеры низкого качества могут негативно повлиять на производительность. Если вы обучаете модель на большом количестве внутренних данных без первого обрезки набора данных только для самых качественных примеров, вы можете в конечном итоге получить модель, которая работает хуже, чем ожидалось.

Вам потребуется создать два файла training_set.jsonl и validation_set.jsonl.

Создайте файлы в том же каталоге, в котором выполняется Записная книжка Jupyter, и скопируйте содержимое следующих блоков кода в соответствующие файлы:

training_set.jsonl

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who discovered Antarctica?"}, {"role": "assistant", "content": "Some chaps named Fabian Gottlieb von Bellingshausen and Mikhail Lazarev, as if they don't teach that in every school!"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the biggest ocean?"}, {"role": "assistant", "content": "The Pacific Ocean. It's not like it's a small pond or anything."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the largest planet?"}, {"role": "assistant", "content": "It's called Jupiter, you might have heard of it...or not."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who painted the Mona Lisa?"}, {"role": "assistant", "content": "Oh, some obscure artist named Leonardo da Vinci. Not that he is famous or anything."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the boiling point of water?"}, {"role": "assistant", "content": "Exciting fact of the day: it's 100 degrees Celsius. Life-changing, isn't it?"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who wrote 'The Odyssey'?"}, {"role": "assistant", "content": "Oh, just some poet named Homer. Nothing special, really."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the largest mammal?"}, {"role": "assistant", "content": "Blue Whale. Quite a big fish isn't it? Oh wait, it's not a fish!"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the highest mountain peak?"}, {"role": "assistant", "content": "Everest. Brace yourself, it's not a walk in the park."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who invented the telephone?"}, {"role": "assistant", "content": "A guy named Alexander Graham Bell. Bet you didn't guess that one!"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the distance from Earth to the Sun?"}, {"role": "assistant", "content": "About 93 million miles. Just a quick drive, really."}]}

validation_set.jsonl

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the capital of Australia?"}, {"role": "assistant", "content": "It's Canberra, not Sydney. Shocking, I know!"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who wrote 'The Great Gatsby'?"}, {"role": "assistant", "content": "Some guy named F. Scott Fitzgerald. Ever heard of him?"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the deepest part of the ocean?"}, {"role": "assistant", "content": "Mariana Trench, makes your swimming pool seem a bit shallow, doesn't it?"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who composed the 'Moonlight Sonata'?"}, {"role": "assistant", "content": "Just a little-known guy named Beethoven. No big deal."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What are the colors of the rainbow?"}, {"role": "assistant", "content": "ROYGBIV. Red, orange, yellow, green, blue, indigo, violet. Not that we learned this in preschool or anything!"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the smallest planet?"}, {"role": "assistant", "content": "Meet Mercury, the runt of the solar system family."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who wrote 'Pride and Prejudice'?"}, {"role": "assistant", "content": "Do the words Jane Austen ring a bell? No? Well, she wrote it."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the largest desert?"}, {"role": "assistant", "content": "Antarctica. Surprise, surprise! Deserts aren't just full of sand, you know."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the longest river?"}, {"role": "assistant", "content": "The Nile River. It's not like it's famous or anything."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the capital of Germany?"}, {"role": "assistant", "content": "Berlin. Shocking news, right?"}]}

Теперь необходимо выполнить некоторые предварительные проверки для наших файлов обучения и проверки.

# Run preliminary checks

import json

# Load the training set

with open('training_set.jsonl', 'r', encoding='utf-8') as f:

training_dataset = [json.loads(line) for line in f]

# Training dataset stats

print("Number of examples in training set:", len(training_dataset))

print("First example in training set:")

for message in training_dataset[0]["messages"]:

print(message)

# Load the validation set

with open('validation_set.jsonl', 'r', encoding='utf-8') as f:

validation_dataset = [json.loads(line) for line in f]

# Validation dataset stats

print("\nNumber of examples in validation set:", len(validation_dataset))

print("First example in validation set:")

for message in validation_dataset[0]["messages"]:

print(message)

Выходные данные:

Number of examples in training set: 10

First example in training set:

{'role': 'system', 'content': 'Clippy is a factual chatbot that is also sarcastic.'}

{'role': 'user', 'content': 'Who discovered America?'}

{'role': 'assistant', 'content': "Some chap named Christopher Columbus, as if they don't teach that in every school!"}

Number of examples in validation set: 10

First example in validation set:

{'role': 'system', 'content': 'Clippy is a factual chatbot that is also sarcastic.'}

{'role': 'user', 'content': "What's the capital of Australia?"}

{'role': 'assistant', 'content': "It's Canberra, not Sydney. Shocking, I know!"}

В этом случае у нас есть только 10 примеров обучения и 10 примеров проверки, поэтому в то время как это демонстрирует базовую механику тонкой настройки модели, что вряд ли будет достаточно большим количеством примеров, чтобы обеспечить согласованный заметный эффект.

Теперь можно использовать библиотеку tiktoken для проверки счетчиков маркеров. Подсчет маркеров с помощью этого метода не будет предоставлять точные счетчики маркеров, которые используются для точной настройки, но должны обеспечить хорошую оценку.

Примечание.

Отдельные примеры должны оставаться под текущей gpt-4o-mini-2024-07-18 длиной контекста примера обучения модели: 64536 токенов. Ограничение входного маркера модели остается 128 000 маркеров.

# Validate token counts

import json

import tiktoken

import numpy as np

from collections import defaultdict

encoding = tiktoken.get_encoding("o200k_base") # default encoding for gpt-4o models. This requires the latest version of tiktoken to be installed.

def num_tokens_from_messages(messages, tokens_per_message=3, tokens_per_name=1):

num_tokens = 0

for message in messages:

num_tokens += tokens_per_message

for key, value in message.items():

num_tokens += len(encoding.encode(value))

if key == "name":

num_tokens += tokens_per_name

num_tokens += 3

return num_tokens

def num_assistant_tokens_from_messages(messages):

num_tokens = 0

for message in messages:

if message["role"] == "assistant":

num_tokens += len(encoding.encode(message["content"]))

return num_tokens

def print_distribution(values, name):

print(f"\n#### Distribution of {name}:")

print(f"min / max: {min(values)}, {max(values)}")

print(f"mean / median: {np.mean(values)}, {np.median(values)}")

print(f"p5 / p95: {np.quantile(values, 0.1)}, {np.quantile(values, 0.9)}")

files = ['training_set.jsonl', 'validation_set.jsonl']

for file in files:

print(f"Processing file: {file}")

with open(file, 'r', encoding='utf-8') as f:

dataset = [json.loads(line) for line in f]

total_tokens = []

assistant_tokens = []

for ex in dataset:

messages = ex.get("messages", {})

total_tokens.append(num_tokens_from_messages(messages))

assistant_tokens.append(num_assistant_tokens_from_messages(messages))

print_distribution(total_tokens, "total tokens")

print_distribution(assistant_tokens, "assistant tokens")

print('*' * 50)

Выходные данные:

Processing file: training_set.jsonl

#### Distribution of total tokens:

min / max: 46, 59

mean / median: 49.8, 48.5

p5 / p95: 46.0, 53.599999999999994

#### Distribution of assistant tokens:

min / max: 13, 28

mean / median: 16.5, 14.0

p5 / p95: 13.0, 19.9

**************************************************

Processing file: validation_set.jsonl

#### Distribution of total tokens:

min / max: 41, 64

mean / median: 48.9, 47.0

p5 / p95: 43.7, 54.099999999999994

#### Distribution of assistant tokens:

min / max: 8, 29

mean / median: 15.0, 12.5

p5 / p95: 10.7, 19.999999999999996

****************************

Отправка файлов тонкой настройки

# Upload fine-tuning files

import os

from openai import AzureOpenAI

client = AzureOpenAI(

azure_endpoint = os.getenv("AZURE_OPENAI_ENDPOINT"),

api_key = os.getenv("AZURE_OPENAI_API_KEY"),

api_version = "2024-08-01-preview" # This API version or later is required to access seed/events/checkpoint features

)

training_file_name = 'training_set.jsonl'

validation_file_name = 'validation_set.jsonl'

# Upload the training and validation dataset files to Azure OpenAI with the SDK.

training_response = client.files.create(

file = open(training_file_name, "rb"), purpose="fine-tune"

)

training_file_id = training_response.id

validation_response = client.files.create(

file = open(validation_file_name, "rb"), purpose="fine-tune"

)

validation_file_id = validation_response.id

print("Training file ID:", training_file_id)

print("Validation file ID:", validation_file_id)

Выходные данные:

Training file ID: file-0e3aa3f2e81e49a5b8b96166ea214626

Validation file ID: file-8556c3bb41b7416bb7519b47fcd1dd6b

Начало тонкой настройки

Теперь, когда файлы тонкой настройки успешно отправлены, вы можете отправить задание обучения точной настройки:

В этом примере мы также передаваем начальный параметр. Начальное значение определяет воспроизводимость задания. Передача параметров начального значения и заданий должна иметь одинаковые результаты, но может отличаться в редких случаях. Если начальное значение не указано, он создается для вас.

# Submit fine-tuning training job

response = client.fine_tuning.jobs.create(

training_file = training_file_id,

validation_file = validation_file_id,

model = "gpt-4o-mini-2024-07-18", # Enter base model name. Note that in Azure OpenAI the model name contains dashes and cannot contain dot/period characters.

seed = 105 # seed parameter controls reproducibility of the fine-tuning job. If no seed is specified one will be generated automatically.

)

job_id = response.id

# You can use the job ID to monitor the status of the fine-tuning job.

# The fine-tuning job will take some time to start and complete.

print("Job ID:", response.id)

print("Status:", response.status)

print(response.model_dump_json(indent=2))

Выходные данные Python 1.x:

Job ID: ftjob-900fcfc7ea1d4360a9f0cb1697b4eaa6

Status: pending

{

"id": "ftjob-900fcfc7ea1d4360a9f0cb1697b4eaa6",

"created_at": 1715824115,

"error": null,

"fine_tuned_model": null,

"finished_at": null,

"hyperparameters": {

"n_epochs": -1,

"batch_size": -1,

"learning_rate_multiplier": 1

},

"model": "gpt-4o-mini-2024-07-18",

"object": "fine_tuning.job",

"organization_id": null,

"result_files": null,

"seed": 105,

"status": "pending",

"trained_tokens": null,

"training_file": "file-0e3aa3f2e81e49a5b8b96166ea214626",

"validation_file": "file-8556c3bb41b7416bb7519b47fcd1dd6b",

"estimated_finish": null,

"integrations": null

}

Отслеживание состояния задания обучения

Если вы хотите провести опрос состояния задания обучения до завершения, можно выполнить следующее:

# Track training status

from IPython.display import clear_output

import time

start_time = time.time()

# Get the status of our fine-tuning job.

response = client.fine_tuning.jobs.retrieve(job_id)

status = response.status

# If the job isn't done yet, poll it every 10 seconds.

while status not in ["succeeded", "failed"]:

time.sleep(10)

response = client.fine_tuning.jobs.retrieve(job_id)

print(response.model_dump_json(indent=2))

print("Elapsed time: {} minutes {} seconds".format(int((time.time() - start_time) // 60), int((time.time() - start_time) % 60)))

status = response.status

print(f'Status: {status}')

clear_output(wait=True)

print(f'Fine-tuning job {job_id} finished with status: {status}')

# List all fine-tuning jobs for this resource.

print('Checking other fine-tune jobs for this resource.')

response = client.fine_tuning.jobs.list()

print(f'Found {len(response.data)} fine-tune jobs.')

Выходные данные Python 1.x:

Job ID: ftjob-900fcfc7ea1d4360a9f0cb1697b4eaa6

Status: pending

{

"id": "ftjob-900fcfc7ea1d4360a9f0cb1697b4eaa6",

"created_at": 1715824115,

"error": null,

"fine_tuned_model": null,

"finished_at": null,

"hyperparameters": {

"n_epochs": -1,

"batch_size": -1,

"learning_rate_multiplier": 1

},

"model": "gpt-4o-mini-2024-07-18",

"object": "fine_tuning.job",

"organization_id": null,

"result_files": null,

"seed": 105,

"status": "pending",

"trained_tokens": null,

"training_file": "file-0e3aa3f2e81e49a5b8b96166ea214626",

"validation_file": "file-8556c3bb41b7416bb7519b47fcd1dd6b",

"estimated_finish": null,

"integrations": null

}

Это не необычно для обучения, чтобы занять более часа, чтобы завершить. После завершения обучения выходное сообщение изменится на следующее:

Fine-tuning job ftjob-900fcfc7ea1d4360a9f0cb1697b4eaa6 finished with status: succeeded

Checking other fine-tune jobs for this resource.

Found 4 fine-tune jobs.

Перечисление событий точной настройки

Версия API: 2024-08-01-preview или более поздняя для этой команды.

Хотя и не требуется выполнять точную настройку, полезно изучить отдельные события тонкой настройки, созданные во время обучения. Полные результаты обучения также можно проверить после завершения обучения в файле результатов обучения.

response = client.fine_tuning.jobs.list_events(fine_tuning_job_id=job_id, limit=10)

print(response.model_dump_json(indent=2))

Выходные данные Python 1.x:

{

"data": [

{

"id": "ftevent-179d02d6178f4a0486516ff8cbcdbfb6",

"created_at": 1715826339,

"level": "info",

"message": "Training hours billed: 0.500",

"object": "fine_tuning.job.event",

"type": "message"

},

{

"id": "ftevent-467bc5e766224e97b5561055dc4c39c0",

"created_at": 1715826339,

"level": "info",

"message": "Completed results file: file-175c81c590074388bdb49e8e0d91bac3",

"object": "fine_tuning.job.event",

"type": "message"

},

{

"id": "ftevent-a30c44da4c304180b327c3be3a7a7e51",

"created_at": 1715826337,

"level": "info",

"message": "Postprocessing started.",

"object": "fine_tuning.job.event",

"type": "message"

},

{

"id": "ftevent-ea10a008f1a045e9914de98b6b47514b",

"created_at": 1715826303,

"level": "info",

"message": "Job succeeded.",

"object": "fine_tuning.job.event",

"type": "message"

},

{

"id": "ftevent-008dc754dc9e61b008dc754dc9e61b00",

"created_at": 1715825614,

"level": "info",

"message": "Step 100: training loss=0.001647822093218565",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 100,

"train_loss": 0.001647822093218565,

"train_mean_token_accuracy": 1,

"valid_loss": 1.5170825719833374,

"valid_mean_token_accuracy": 0.75,

"full_valid_loss": 1.7539110545870624,

"full_valid_mean_token_accuracy": 0.7215189873417721

}

},

{

"id": "ftevent-008dc754dc3f03a008dc754dc3f03a00",

"created_at": 1715825604,

"level": "info",

"message": "Step 90: training loss=0.00971441250294447",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 90,

"train_loss": 0.00971441250294447,

"train_mean_token_accuracy": 1,

"valid_loss": 1.3702410459518433,

"valid_mean_token_accuracy": 0.75,

"full_valid_loss": 1.7371194453179082,

"full_valid_mean_token_accuracy": 0.7278481012658228

}

},

{

"id": "ftevent-008dc754dbdfa59008dc754dbdfa5900",

"created_at": 1715825594,

"level": "info",

"message": "Step 80: training loss=0.0032251903321594",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 80,

"train_loss": 0.0032251903321594,

"train_mean_token_accuracy": 1,

"valid_loss": 1.4242165088653564,

"valid_mean_token_accuracy": 0.75,

"full_valid_loss": 1.6554046099698996,

"full_valid_mean_token_accuracy": 0.7278481012658228

}

},

{

"id": "ftevent-008dc754db80478008dc754db8047800",

"created_at": 1715825584,

"level": "info",

"message": "Step 70: training loss=0.07380199432373047",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 70,

"train_loss": 0.07380199432373047,

"train_mean_token_accuracy": 1,

"valid_loss": 1.2011798620224,

"valid_mean_token_accuracy": 0.75,

"full_valid_loss": 1.508960385865803,

"full_valid_mean_token_accuracy": 0.740506329113924

}

},

{

"id": "ftevent-008dc754db20e97008dc754db20e9700",

"created_at": 1715825574,

"level": "info",

"message": "Step 60: training loss=0.245253324508667",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 60,

"train_loss": 0.245253324508667,

"train_mean_token_accuracy": 0.875,

"valid_loss": 1.0585949420928955,

"valid_mean_token_accuracy": 0.75,

"full_valid_loss": 1.3787144045286541,

"full_valid_mean_token_accuracy": 0.7341772151898734

}

},

{

"id": "ftevent-008dc754dac18b6008dc754dac18b600",

"created_at": 1715825564,

"level": "info",

"message": "Step 50: training loss=0.1696014404296875",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 50,

"train_loss": 0.1696014404296875,

"train_mean_token_accuracy": 0.8999999761581421,

"valid_loss": 0.8862184286117554,

"valid_mean_token_accuracy": 0.8125,

"full_valid_loss": 1.2814022257358213,

"full_valid_mean_token_accuracy": 0.7151898734177216

}

}

],

"has_more": true,

"object": "list"

}

Вывод списка контрольных точек

Версия API: 2024-08-01-preview или более поздняя для этой команды.

После создания каждой эпохи обучения создается контрольная точка. Контрольная точка — это полностью функциональная версия модели, которую можно развернуть и использовать в качестве целевой модели для последующих заданий точной настройки. Контрольные точки могут быть полезны, так как они могут предоставить моментальный снимок модели до переподбора. После завершения задания точной настройки у вас есть три последних версии модели, доступные для развертывания. Последняя эпоха будет представлена вашей тонкой моделью, предыдущие две эпохи доступны в качестве контрольных точек.

response = client.fine_tuning.jobs.checkpoints.list(job_id)

print(response.model_dump_json(indent=2))

Выходные данные Python 1.x:

{

"data": [

{

"id": "ftchkpt-148ab69f0a404cf9ab55a73d51b152de",

"created_at": 1715743077,

"fine_tuned_model_checkpoint": "gpt-4o-mini-2024-07-18.ft-0e208cf33a6a466994aff31a08aba678",

"fine_tuning_job_id": "ftjob-372c72db22c34e6f9ccb62c26ee0fbd9",

"metrics": {

"full_valid_loss": 1.8258173013035255,

"full_valid_mean_token_accuracy": 0.7151898734177216,

"step": 100.0,

"train_loss": 0.004080486483871937,

"train_mean_token_accuracy": 1.0,

"valid_loss": 1.5915886163711548,

"valid_mean_token_accuracy": 0.75

},

"object": "fine_tuning.job.checkpoint",

"step_number": 100

},

{

"id": "ftchkpt-e559c011ecc04fc68eaa339d8227d02d",

"created_at": 1715743013,

"fine_tuned_model_checkpoint": "gpt-4o-mini-2024-07-18.ft-0e208cf33a6a466994aff31a08aba678:ckpt-step-90",

"fine_tuning_job_id": "ftjob-372c72db22c34e6f9ccb62c26ee0fbd9",

"metrics": {

"full_valid_loss": 1.7958603267428241,

"full_valid_mean_token_accuracy": 0.7215189873417721,

"step": 90.0,

"train_loss": 0.0011079151881858706,

"train_mean_token_accuracy": 1.0,

"valid_loss": 1.6084896326065063,

"valid_mean_token_accuracy": 0.75

},

"object": "fine_tuning.job.checkpoint",

"step_number": 90

},

{

"id": "ftchkpt-8ae8beef3dcd4dfbbe9212e79bb53265",

"created_at": 1715742984,

"fine_tuned_model_checkpoint": "gpt-4o-mini-2024-07-18.ft-0e208cf33a6a466994aff31a08aba678:ckpt-step-80",

"fine_tuning_job_id": "ftjob-372c72db22c34e6f9ccb62c26ee0fbd9",

"metrics": {

"full_valid_loss": 1.6909511662736725,

"full_valid_mean_token_accuracy": 0.7088607594936709,

"step": 80.0,

"train_loss": 0.000667572021484375,

"train_mean_token_accuracy": 1.0,

"valid_loss": 1.4677599668502808,

"valid_mean_token_accuracy": 0.75

},

"object": "fine_tuning.job.checkpoint",

"step_number": 80

}

],

"has_more": false,

"object": "list"

}

Окончательные результаты обучения

Чтобы получить окончательные результаты, выполните следующее:

# Retrieve fine_tuned_model name

response = client.fine_tuning.jobs.retrieve(job_id)

print(response.model_dump_json(indent=2))

fine_tuned_model = response.fine_tuned_model

Развертывание точно настроенной модели

В отличие от предыдущих команд пакета SDK для Python в этом руководстве, так как введение функции квоты, развертывание модели должно выполняться с помощью REST API, для которого требуется отдельная авторизация, другой путь к API и другая версия API.

Кроме того, можно развернуть настраиваемую модель с помощью любого из других распространенных методов развертывания, таких как портал Azure AI Foundry или Azure CLI.

| переменная | Определение |

|---|---|

| token | Существует несколько способов создания маркера авторизации. Самый простой способ начального тестирования — запустить Cloud Shell из портал Azure. Затем выполните az account get-access-token. Этот маркер можно использовать в качестве временного маркера авторизации для тестирования API. Мы рекомендуем сохранить это в новой переменной среды |

| Подписка | Идентификатор подписки для связанного ресурса Azure OpenAI |

| resource_group | Имя группы ресурсов для ресурса Azure OpenAI |

| resource_name | Имя ресурса Azure OpenAI |

| model_deployment_name | Настраиваемое имя для нового точно настроенного развертывания модели. Это имя, на которое ссылается код при вызове завершения чата. |

| fine_tuned_model | Получение этого значения из задания точной настройки приводит к предыдущему шагу. Оно выглядит следующим образом: gpt-4o-mini-2024-07-18.ft-0e208cf33a6a466994aff31a08aba678. Необходимо добавить это значение в deploy_data json. |

Внимание

После развертывания настраиваемой модели, если в любое время развертывание остается неактивным в течение более чем пятнадцати дней (15) развертывание удаляется. Развертывание настраиваемой модели неактивно, если модель была развернута более чем через 15 дней назад, а в течение непрерывного 15-дневного периода вызовы завершений или завершения чата не выполнялись.

Удаление неактивного развертывания не влияет на базовую настраиваемую модель, а настраиваемую модель можно повторно развернуть в любое время. Как описано в ценах на Azure OpenAI Service, каждая настраиваемая (настраиваемая) модель, развернутая почасовая стоимость размещения независимо от того, выполняются ли вызовы завершения или завершения чата в модель. Дополнительные сведения о планировании и управлении затратами с помощью Azure OpenAI см. в руководстве по управлению затратами на Службу Azure OpenAI.

# Deploy fine-tuned model

import json

import requests

token = os.getenv("TEMP_AUTH_TOKEN")

subscription = "<YOUR_SUBSCRIPTION_ID>"

resource_group = "<YOUR_RESOURCE_GROUP_NAME>"

resource_name = "<YOUR_AZURE_OPENAI_RESOURCE_NAME>"

model_deployment_name = "gpt-4o-mini-2024-07-18-ft" # Custom deployment name you chose for your fine-tuning model

deploy_params = {'api-version': "2023-05-01"}

deploy_headers = {'Authorization': 'Bearer {}'.format(token), 'Content-Type': 'application/json'}

deploy_data = {

"sku": {"name": "standard", "capacity": 1},

"properties": {

"model": {

"format": "OpenAI",

"name": "<YOUR_FINE_TUNED_MODEL>", #retrieve this value from the previous call, it will look like gpt-4o-mini-2024-07-18.ft-0e208cf33a6a466994aff31a08aba678

"version": "1"

}

}

}

deploy_data = json.dumps(deploy_data)

request_url = f'https://management.azure.com/subscriptions/{subscription}/resourceGroups/{resource_group}/providers/Microsoft.CognitiveServices/accounts/{resource_name}/deployments/{model_deployment_name}'

print('Creating a new deployment...')

r = requests.put(request_url, params=deploy_params, headers=deploy_headers, data=deploy_data)

print(r)

print(r.reason)

print(r.json())

Вы можете проверить ход развертывания на портале Azure AI Foundry.

Это не редкость для этого процесса занять некоторое время, чтобы завершить работу при развертывании точно настроенных моделей.

Использование развернутой настраиваемой модели

После развертывания точно настроенной модели вы можете использовать ее как любую другую развернутую модель на портале Chat Playground azure AI Foundry или через API завершения чата. Например, можно отправить вызов завершения чата в развернутую модель, как показано в следующем примере Python. Вы можете продолжать использовать те же параметры с настраиваемой моделью, например температурой и max_tokens, как и с другими развернутыми моделями.

# Use the deployed customized model

import os

from openai import AzureOpenAI

client = AzureOpenAI(

azure_endpoint = os.getenv("AZURE_OPENAI_ENDPOINT"),

api_key = os.getenv("AZURE_OPENAI_API_KEY"),

api_version = "2024-06-01"

)

response = client.chat.completions.create(

model = "gpt-4o-mini-2024-07-18-ft", # model = "Custom deployment name you chose for your fine-tuning model"

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Does Azure OpenAI support customer managed keys?"},

{"role": "assistant", "content": "Yes, customer managed keys are supported by Azure OpenAI."},

{"role": "user", "content": "Do other Azure AI services support this too?"}

]

)

print(response.choices[0].message.content)

Удалить развертывание

В отличие от других типов моделей Azure OpenAI, настроенные и настроенные модели имеют почасовую стоимость размещения, связанную с ними после их развертывания. Настоятельно рекомендуется после завершения работы с этим руководством и проверив несколько вызовов завершения чата в вашей точно настроенной модели, что удаляет развертывание модели.

Удаление развертывания не повлияет на саму модель, поэтому вы можете повторно развернуть настроенную модель, обученную для этого руководства в любое время.

Развертывание можно удалить на портале Azure AI Foundry с помощью REST API, Azure CLI или других поддерживаемых методов развертывания.

Устранение неполадок

Разделы справки включить точную настройку? Создание настраиваемой модели неактивно.

Чтобы успешно получить доступ к точной настройке, необходимо назначить участника OpenAI Cognitive Services. Даже у кого-то с разрешениями высокого уровня администратора службы по-прежнему потребуется явно установить эту учетную запись, чтобы получить доступ к тонкой настройке. Дополнительные сведения см. в руководстве по управлению доступом на основе ролей.

Следующие шаги

- Дополнительные сведения о тонкой настройке в Azure OpenAI

- Ознакомьтесь с дополнительными сведениями о базовых моделях, лежащих в основе Azure OpenAI.