Использование Data Lake Storage Gen1 для обеспечения соответствия требованиям больших данных

Примечание.

Azure Data Lake Storage 1-го поколения теперь прекращена. Ознакомьтесь с объявлением о выходе на пенсию здесь.Data Lake Storage 1-го поколения ресурсы больше не доступны.

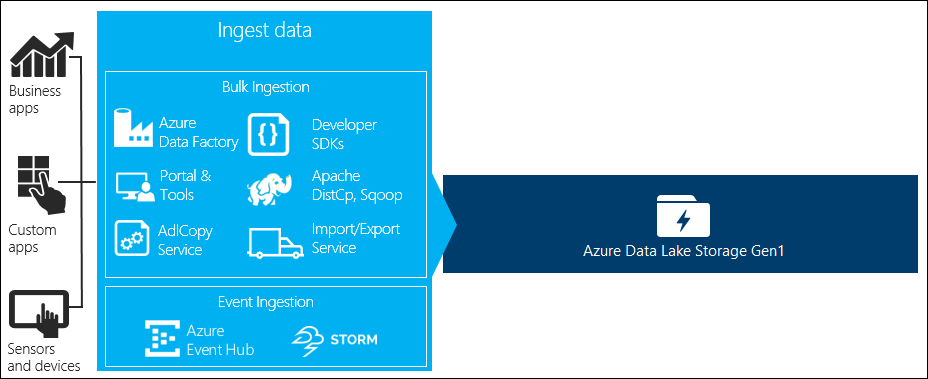

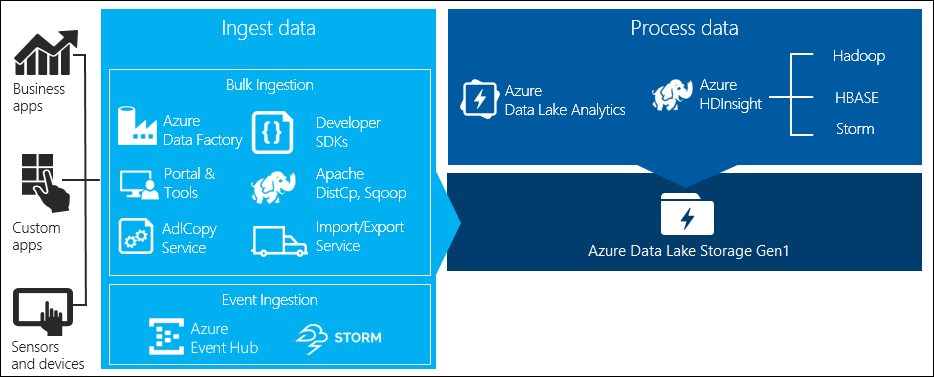

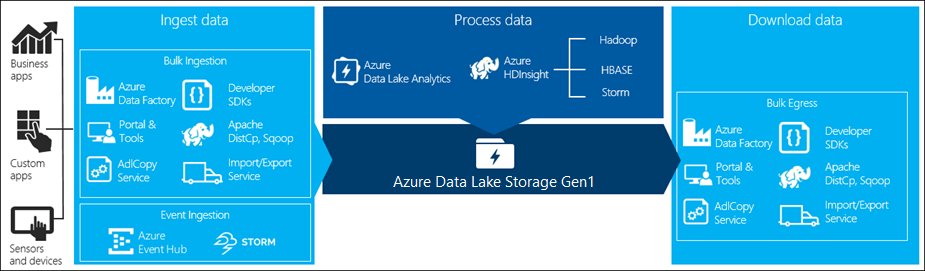

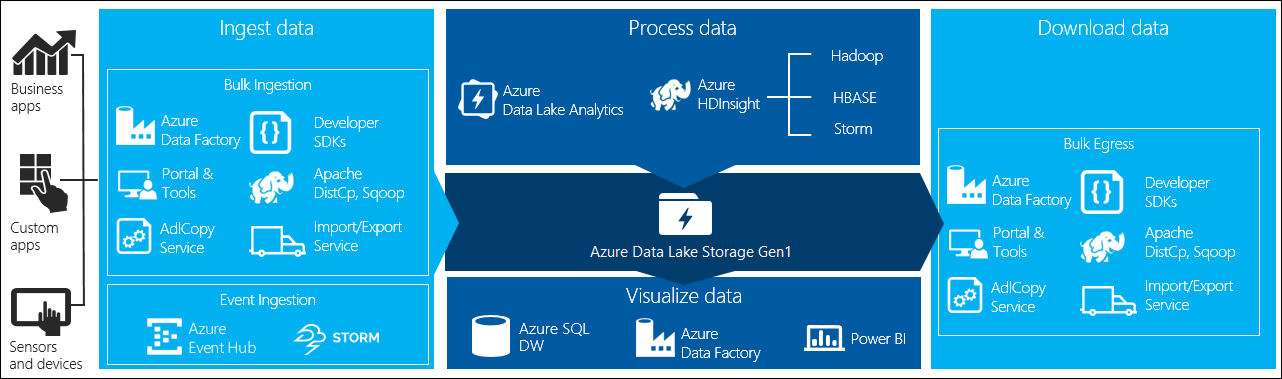

Процесс обработки больших данных состоит из указанных далее четырех ключевых этапов.

- Прием больших объемов данных в хранилище данных в режиме реального времени или в пакетах

- Обработка данных

- Загрузка данных

- Визуализация данных

В этой статье мы рассмотрим эти этапы применительно к Azure Data Lake Storage 1-го поколения, чтобы понять параметры и средства, доступные для удовлетворения потребностей в обработке больших объемов данных.

Прием данных в Azure Data Lake Storage 1-го поколения

В этом разделе описываются различные источники данных и способы поступления этих данных в учетную запись Azure Data Lake Storage 1-го поколения.

Специализированное исследование

Это небольшие наборы данных, которые используются для создания прототипов приложений для работы с большими данными. В зависимости от источника данных применяются разные способы приема специальных данных.

| Источник данных | Средство для приема |

|---|---|

| Локальный компьютер | |

| Azure Storage Blob. |

Потоковые данные

Представляют данные, которые могут быть созданы разными источниками, например приложениями, устройствами, датчиками и т. д. Такие данные можно передавать в Data Lake Storage 1-го поколения с помощью различных инструментов. Как правило, эти средства собирают и обрабатывают данные на основе событий в режиме реального времени, а затем записывают события в пакетном режиме в Data Lake Storage 1-го поколения для последующей обработки.

Ниже перечислены средства, которые можно использовать:

- Azure Stream Analytics. События, принятые в Центры событий, могут записываться в Azure Data Lake Storage 1-го поколения с помощью выходных данных Azure Data Lake Storage 1-го поколения.

- EventProcessorHost. Вы можете получать события из Центров событий, а затем записывать их в Data Lake Storage 1-го поколения с помощью пакета SDK Data Lake Storage 1-го поколения для .NET.

Реляционные данные

Можно также извлекать данные из реляционных баз данных. В течение определенного периода времени реляционные базы данных собирают огромные объемы данных, которые после обработки с помощью конвейера больших данных могут предоставлять ценные сведения. Для перемещения таких данных в Data Lake Storage 1-го поколения можно использовать следующие средства.

Данные журналов веб-сервера (отправка с помощью настраиваемых приложений)

Этот тип набора данных вызывается специально, так как анализ данных журналов веб-сервера часто используется в приложениях по работе с большими данными, и для его выполнения требуется отправка больших объемов файлов журналов в Data Lake Storage 1-го поколения. Для отправки таких данных воспользуйтесь следующими средствами или напишите собственные сценарии или приложения.

Отличным способом отправки данных журналов веб-сервера и других типов данных (например данных общественных мнений) является использование собственных написанных сценариев или приложений, поскольку вы можете включить компонент отправки данных в состав более масштабного приложения по работе с большими объемами данных. В одних случаях этот код может иметь форму сценария или простой программы командной строки. В других случаях код может использоваться для интеграции обработки больших данных в бизнес-приложение или решение.

Данные, связанные с кластерами HDInsight Azure

Большинство типов кластера HDInsight (Hadoop, HBase, Storm) поддерживают Data Lake Storage 1-го поколения в качестве репозитория хранения данных. Кластеры HDInsight обращаются к данным из BLOB-объектов хранилища Azure (WASB). Для повышения производительности можно скопировать данные из WASB в учетную запись Data Lake Storage 1-го поколения, связанную с кластером. Для копирования данных можно использовать указанные далее средства.

Данные, хранящиеся в локальных кластерах Hadoop или кластерах Hadoop в IaaS

Большие объемы данных могут храниться в кластерах Hadoop, размещенных локально на компьютерах, использующих HDFS. Кластеры Hadoop могут быть развернуты локально или работать в кластере IaaS в Azure. К копированию таких данных в Azure Data Lake Storage 1-го поколения могут предъявляться требования, в зависимости от того, является ли эта операция одноразовой или повторяющейся. Существуют различные возможности выполнить их. Ниже приведен список альтернативных вариантов и связанные с ними компромиссы.

| Подход | Сведения | Достоинства | Рекомендации |

|---|---|---|---|

| Использование Фабрики данных Azure (ADF) для копирования данных напрямую из кластеров Hadoop в Azure Data Lake Storage 1-го поколения | ADF поддерживает HDFS в качестве источника данных. | ADF реализована готовая поддержка HDFS, а также первоклассные инструменты комплексного управления и мониторинга. | Требуется развернуть шлюз управления данными в локальном кластере или кластере IaaS. |

| Экспорт данных из Hadoop в виде файлов. Затем — копирование этих файлов в Azure Data Lake Storage 1-го поколения с помощью соответствующего механизма. | Файлы можно скопировать в Azure Data Lake Storage 1-го поколения с помощью:

|

Можно быстро приступить к работе. Возможны настраиваемые передачи данных. | Многоэтапный процесс с использованием нескольких технологий. Учитывая настраиваемый характер инструментов, со временем будет все сложнее осуществлять управление и мониторинг. |

| Использование Distcp для копирования данных из Hadoop в службу хранилища Azure. Затем — копирование данных из службы хранилища Azure в Data Lake Storage 1-го поколения с помощью соответствующего механизма. | Вы можете скопировать данные из служба хранилища Azure в Data Lake Storage 1-го поколения с помощью: | Можно использовать инструменты с открытым кодом. | Многоэтапный процесс с использованием нескольких технологий. |

Очень большие наборы данных

Для отправки наборов данных размером в несколько терабайт использование описанных выше методов иногда может быть медленным и затратным процессом. В таких ситуациях будут уместны следующие варианты.

Использование Azure ExpressRoute. Azure ExpressRoute позволяет создавать закрытые соединения между ЦОД Azure и вашей локальной инфраструктурой. Это надежный вариант для передачи больших объемов данных. Дополнительные сведения см. в техническом обзоре ExpressRoute.

Автономная передача данных. Если по какой-то причине использовать Azure ExpressRoute нельзя, используйте службу импорта и экспорта Azure для доставки жестких дисков с данными в центр обработки данных Azure. Данные сначала будут отправлены в хранилище BLOB-объектов Azure. Затем с помощью Фабрики данных Azure или инструмента AdlCopy можно скопировать данные из больших двоичных объектов службы хранилища Azure в Data Lake Storage 1-го поколения.

Примечание.

При использовании службы импорта и экспорта размеры файлов на дисках, отправляемых в центр обработки данных Azure, не должны превышать 195 ГБ.

Обработка данных, хранящихся в Data Lake Storage 1-го поколения

Данные, доступные в Data Lake Storage 1-го поколения, можно проанализировать с помощью поддерживаемых приложений для работы с большими данными. Сейчас для запуска заданий анализа для данных, хранящихся в Data Lake Storage 1-го поколения, можно использовать Azure HDInsight и Azure Data Lake Analytics.

Рассмотрите следующие примеры.

- Создание кластера HDInsight с Data Lake Storage 1-го поколения в качестве хранилища

- Начало работы с Azure Data Lake Analytics с помощью портала Azure

Копирование из Data Lake Storage 1-го поколения

Возможно, вам потребуется загрузить или переместить данные из Azure Data Lake Storage 1-го поколения в случаях, аналогичных указанным далее.

- Перемещение данных в другие репозитории для взаимодействия с существующими конвейерами обработки данных. Например, можно переместить данные из Data Lake Storage 1-го поколения в Базу данных SQL Azure или на SQL Server.

- Загрузка данных на локальный компьютер для обработки в средах IDE при создании прототипов приложений.

В таких ситуациях можно использовать любой из следующих вариантов:

Для написания сценария или приложения для загрузки данных из Data Lake Storage 1-го поколения можно воспользоваться следующими средствами.

Визуализация данных в Data Lake Storage 1-го поколения

Для создания визуальных представлений данных, хранящихся в Data Lake Storage 1-го поколения, можно использовать сочетание служб.

- Сначала с помощью Фабрики данных Azure переместите данные из Data Lake Storage 1-го поколения в Azure Synapse Analytics.

- После этого вы можете интегрировать Power BI с Azure Synapse Analytics для создания визуального представления данных.