Руководство по развертыванию и запросу пользовательской модели

В этой статье приведены основные шаги по развертыванию и запросу настраиваемой модели, которая является традиционной моделью машинного обучения, установленной в каталоге Unity или зарегистрированной в реестре моделей рабочих областей с помощью службы модели ИИ Мозаики.

Ниже приведены руководства, описывающие обслуживание и развертывание модели создания искусственного интеллекта:

Шаг 1. Регистрация модели в реестре моделей

Существуют различные способы регистрации модели для обслуживания моделей:

| Метод ведения журнала | Description |

|---|---|

| Автологирование | Это автоматически включается при использовании Databricks Runtime для машинного обучения. Это самый простой способ, но дает вам меньше контроля. |

| Ведение журнала с помощью встроенных вкусов MLflow | Вы можете вручную записать модель с помощью встроенных вариантов модели MLflow. |

Настраиваемое ведение журнала с помощью pyfunc |

Используйте это, если у вас есть пользовательская модель или если вам нужны дополнительные шаги до или после вывода. |

В следующем примере показано, как регистрировать модель MLflow с помощью вкуса transformer и указывать параметры, необходимые для модели.

with mlflow.start_run():

model_info = mlflow.transformers.log_model(

transformers_model=text_generation_pipeline,

artifact_path="my_sentence_generator",

inference_config=inference_config,

registered_model_name='gpt2',

input_example=input_example,

signature=signature

)

После регистрации модели убедитесь, что модель зарегистрирована в каталоге MLflow Unity или реестре моделей.

Шаг 2. Создание конечной точки с помощью пользовательского интерфейса обслуживания

После регистрации зарегистрированной модели вы можете создать конечную точку обслуживания модели с помощью пользовательского интерфейса обслуживания .

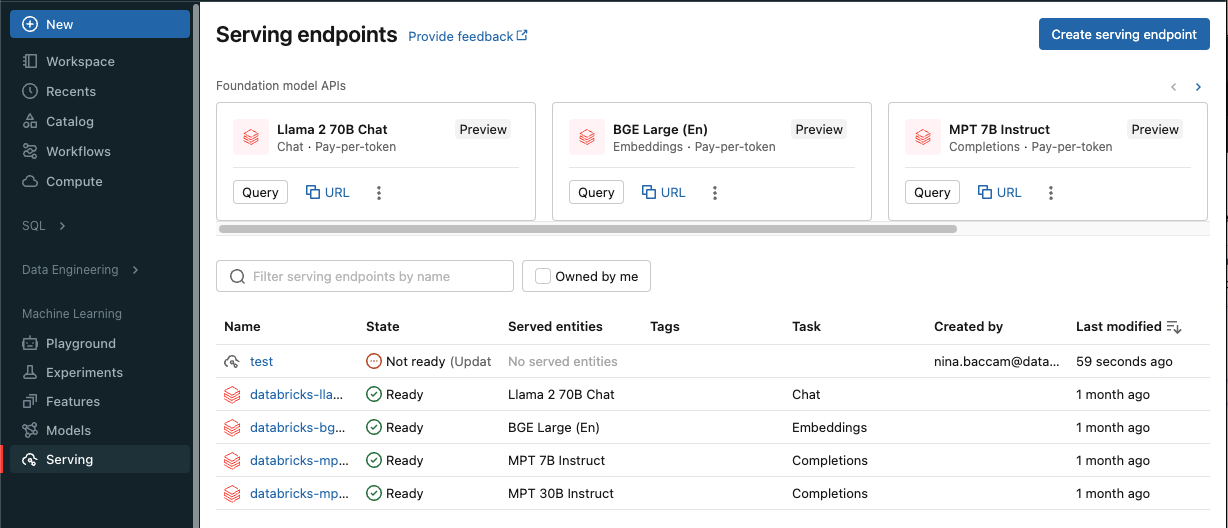

Щелкните "Служить " на боковой панели, чтобы отобразить пользовательский интерфейс обслуживания .

Нажмите кнопку "Создать конечную точку обслуживания".

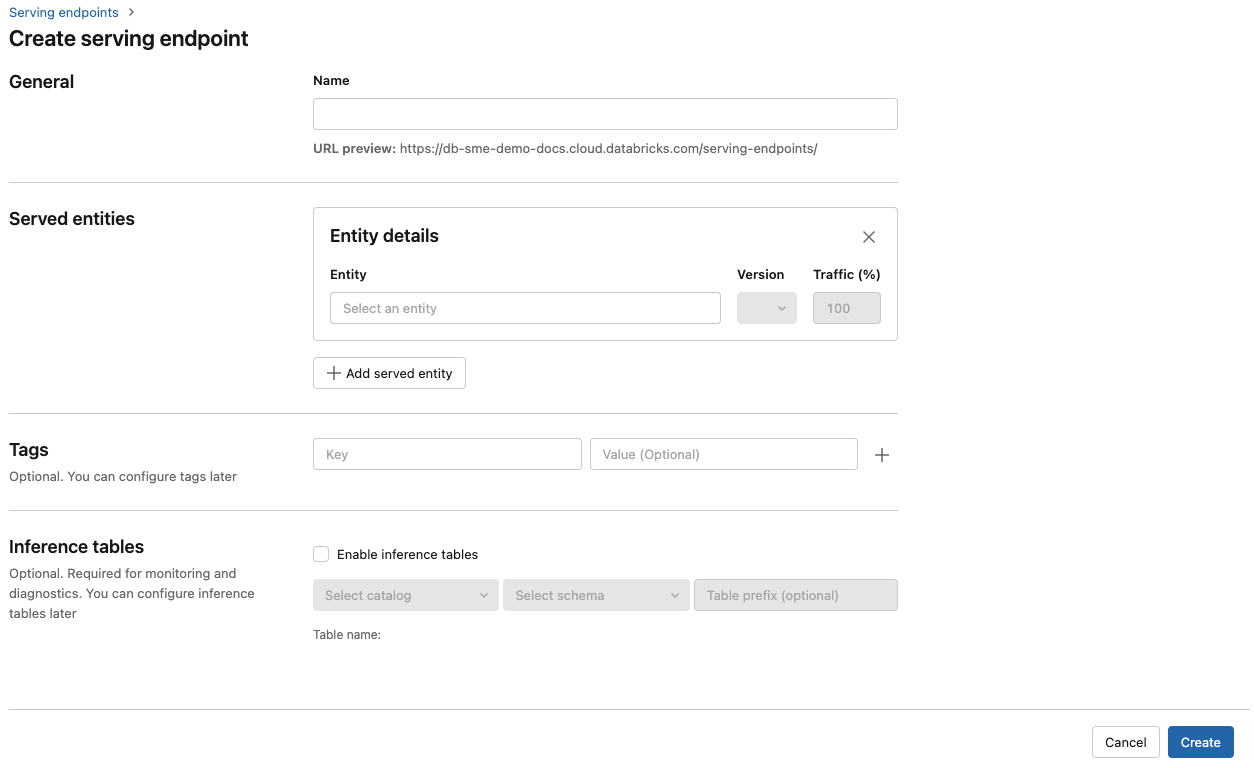

В поле "Имя" укажите имя конечной точки.

В разделе "Обслуживаемые сущности "

- Щелкните поле "Сущность", чтобы открыть форму "Выбор обслуживаемой сущности".

- Выберите тип модели, которую вы хотите обслуживать. Форма динамически обновляется на основе выбранного фрагмента.

- Выберите нужную модель и версию модели.

- Выберите процент трафика для маршрутизации в обслуживаемую модель.

- Выберите используемый размер вычислительных ресурсов. Вы можете использовать вычислительные ресурсы ЦП или GPU для рабочих нагрузок. Поддержка обслуживания модели на GPU доступна в общедоступной предварительной версии. Дополнительные сведения о доступных вычислительных ресурсах GPU см. в разделе "Типы рабочих нагрузок GPU".

- В разделе "Горизонтальное масштабирование вычислений" выберите размер горизонтального масштабирования вычислений, соответствующий количеству запросов, которые эта обслуживаемая модель может обрабатывать одновременно. Это число должно быть примерно равно времени выполнения модели QPS x.

- Доступные размеры: небольшие для 0-4 запросов, средних 8-16 запросов и больших для 16-64 запросов.

- Укажите, следует ли масштабировать конечную точку до нуля, если она не используется.

Нажмите кнопку Создать. Откроется страница "Обслуживание конечных точек" с состоянием конечной точки обслуживания, отображаемой как "Не готово".

Если вы предпочитаете создавать конечную точку программным способом с помощью API обслуживания Databricks, см. статью "Создание конечных точек обслуживания пользовательской модели".

Шаг 3. Запрос конечной точки

Самый простой и быстрый способ тестирования и отправки запросов оценки в обслуживаемую модель — использовать пользовательский интерфейс обслуживания .

На странице конечной точки обслуживания выберите конечную точку запроса.

Вставьте входные данные модели в формате JSON и нажмите кнопку "Отправить запрос". Если модель зарегистрирована в входном примере, нажмите кнопку "Показать пример ", чтобы загрузить входной пример.

{ "inputs" : ["Hello, I'm a language model,"], "params" : {"max_new_tokens": 10, "temperature": 1} }

Чтобы отправить запросы на оценку, создайте JSON с одним из поддерживаемых ключей и объектом JSON, соответствующим входным форматом. Ознакомьтесь с конечными точками обслуживания запросов для пользовательских моделей для поддерживаемых форматов и рекомендаций по отправке запросов оценки с помощью API.

Если вы планируете получить доступ к конечной точке обслуживания за пределами пользовательского интерфейса обслуживания Azure Databricks, вам потребуется DATABRICKS_API_TOKEN.

Внимание

В качестве рекомендации по обеспечению безопасности для рабочих сценариев Databricks рекомендует использовать маркеры OAuth на компьютере для проверки подлинности во время рабочей среды.

Для тестирования и разработки Databricks рекомендует использовать личный маркер доступа, принадлежащий субъектам-службам , а не пользователям рабочей области. Сведения о создании маркеров для субъектов-служб см. в разделе "Управление маркерами" для субъекта-службы.

Примеры записных книжек

См. следующую записную книжку для обслуживания модели MLflow transformers с помощью службы модели.

Развертывание записной книжки модели распознавания лиц transformers

См. следующую записную книжку для обслуживания модели MLflow pyfunc с помощью службы модели. Дополнительные сведения о настройке развертываний модели см. в статье "Развертывание кода Python с помощью службы моделей".