Заметка

Доступ к этой странице требует авторизации. Вы можете попробовать войти в систему или изменить каталог.

Доступ к этой странице требует авторизации. Вы можете попробовать сменить директорию.

В этом руководстве показано, как установить традиционное сетевое развертывание (ND) IBM WebSphere Application Server (WAS) и настроить кластер WAS в Azure Виртуальные машины (виртуальных машинах) на GNU/Linux.

В этом руководстве описано следующее:

- Создайте пользовательскую виртуальную сеть и создайте виртуальные машины в сети.

- Вручную установите традиционное сетевое развертывание webSphere Application Server (V9 или V8.5) на виртуальных машинах с помощью графического интерфейса.

- Настройте кластер WAS с помощью средства управления профилями.

- Развертывание и запуск приложения платформы Java выпуск Enterprise (Java EE) в кластере.

- Предоставление приложению общедоступному Интернету через Шлюз приложений Azure.

- Проверьте успешную конфигурацию.

Если вы предпочитаете полностью автоматизированное решение, которое выполняет все эти действия от вашего имени на виртуальных машинах GNU/Linux непосредственно из портал Azure, см. краткое руководство. Развертывание кластера сетевого развертывания webSphere Application Server в Azure Виртуальные машины. Менее автоматизированный, но все еще ускоренный вариант — пропустить шаги по установке пакета средств разработки Java (JDK) и WebSphere в операционной системе с помощью предварительно настроенного базового образа Red Hat Linux. Эти предложения можно найти в Azure Marketplace с помощью запроса на образ сервера приложений WebSphere 9.0.5.x.

Если вы заинтересованы в тесной работе с сценарием миграции с группой разработчиков, разрабатывающей ВебСферу в решениях Azure, заполните этот короткий опрос по миграции WebSphere и включите контактные данные. Команда руководителей программ, архитекторов и инженеров будет быстро связаться с вами, чтобы начать тесное сотрудничество.

Необходимые компоненты

- Подписка Azure. Если у вас еще нет подписки Azure, создайте бесплатную учетную запись Azure, прежде чем начать работу.

-

Установите Azure CLI версии 2.46.0 или более поздней , чтобы запустить команды Azure CLI.

- В этой статье приведены инструкции по вызову команд Azure CLI в Windows PowerShell или UNIX Bash. В любом случае необходимо установить Azure CLI.

- Если появится запрос, установите расширения Azure CLI при первом использовании. Дополнительные сведения о расширениях см. в статье "Использование расширений и управление ими" с помощью Azure CLI.

- Выполните команду az version, чтобы узнать установленную версию и зависимые библиотеки. Чтобы обновиться до последней версии, выполните команду az upgrade.

- У вас должен быть IBMid. Если у вас нет учетной записи IBM, создайте учетную запись IBM войдите в IBM и выберите "Создать IBMid". Запишите пароль и электронную почту IBMid.

- Если вы планируете использовать версию 8.5.5 ibm WebSphere Application Server Network Deployment, этот IBMid должен иметь право использовать эту версию программного обеспечения. Чтобы узнать о правах, попросите первичных или вторичных контактов для вашего сайта IBM Passport Advantage предоставить вам доступ или следуйте инструкциям в IBM eCustomer Care.

Подготовка среды

В этом разделе описана настройка инфраструктуры, в которой устанавливается IBM Install Manager и webSphere Application Server Network Deployment.

Предположения

В этом руководстве настраивается кластер WAS с диспетчером развертывания и двумя управляемыми серверами в общей сложности на трех виртуальных машинах. Чтобы настроить кластер, необходимо создать следующие три виртуальных машины Azure в одной группе доступности:

- У виртуальной машины администратора (имя

adminVMвиртуальной машины) запущен диспетчер развертывания. - Управляемые виртуальные машины (имена

mspVM1виртуальных машин иmspVM2) имеют два управляемых сервера.

Вход в Azure

Если вы еще этого не сделали, войдите в подписку Azure с помощью команды az login и следуйте инструкциям на экране.

az login

Примечание.

Если несколько клиентов Azure связаны с учетными данными Azure, необходимо указать, в какой клиент вы хотите войти. Это можно сделать с помощью --tenant параметра. Например: az login --tenant contoso.onmicrosoft.com.

Создание или изменение группы ресурсов

Создайте группу ресурсов, используя команду az group create. Имена групп ресурсов должны быть глобально уникальными в подписке. По этой причине рассмотрите возможность создания уникального идентификатора для всех созданных имен, которые должны быть уникальными. Полезный способ — использовать ваши инициалы, а затем сегодняшняя дата в mmdd формате. В этом примере создается группа ресурсов с именем abc1110rg в расположении eastus :

export RESOURCE_GROUP_NAME=abc1110rg

az group create --name $RESOURCE_GROUP_NAME --location eastus

Создание виртуальной сети

Примечание.

По умолчанию команды Azure CLI в этом разделе соответствуют стилю Bash, если иное не указано.

Если эти команды выполняются в PowerShell, обязательно объявите параметры среды, как указано в предыдущих командах.

Чтобы разбить командную строку на несколько строк в PowerShell, можно использовать символ backtick (') в конце каждой строки.

Ресурсы, составляющие кластер сервера приложений WebSphere, должны взаимодействовать друг с другом и с общедоступным Интернетом с помощью виртуальной сети. Полное руководство по планированию виртуальной сети см. в руководстве По планированию виртуальных сетей в Cloud Adoption Framework для Azure. Дополнительные сведения см. в статье azure виртуальная сеть часто задаваемые вопросы.

Чтобы создать виртуальную сеть, выполните следующие действия. В этом разделе создается виртуальная сеть с адресным пространством 192.168.0.0/16 и создается подсеть для виртуальных машин.

Создайте виртуальную сеть с помощью команды az network vnet create. В следующем примере создается сеть с именем

myVNet:az network vnet create \ --resource-group $RESOURCE_GROUP_NAME \ --name myVNet \ --address-prefixes 192.168.0.0/24Создайте подсеть для кластера WAS с помощью az network vnet subnet create. В следующем примере создается подсеть с именем

mySubnetaz network vnet subnet create \ --resource-group $RESOURCE_GROUP_NAME \ --name mySubnet \ --vnet-name myVNet \ --address-prefixes 192.168.0.0/25Создайте подсеть для Шлюз приложений с помощью az network vnet subnet create. В следующем примере создается подсеть с именем

wasGatewayaz network vnet subnet create \ --resource-group $RESOURCE_GROUP_NAME \ --name wasGateway \ --vnet-name myVNet \ --address-prefixes 192.168.0.128/25

Создание группы доступности

Создайте группу доступности с помощью az vm availability-set create, как показано в следующем примере. Создавать группу доступности необязательно, но мы рекомендуем это сделать. Дополнительные сведения см . в пошаговом руководстве по инфраструктуре Azure для виртуальных машин Windows.

az vm availability-set create \

--resource-group $RESOURCE_GROUP_NAME \

--name myAvailabilitySet \

--platform-fault-domain-count 2 \

--platform-update-domain-count 2

Получение или установка WAS в GNU/Linux

В следующих разделах описаны шаги по получению или установке WAS в GNU/Linux. Вы можете выбрать операционную систему и версию WAS в соответствии с вашими требованиями, но убедитесь, что они доступны в документации по развертыванию сервера приложений IBM WebSphere.

Если вы хотите использовать WAS V9, инструкции используют образ виртуальной машины Azure, содержащий последнюю поддерживаемую версию программного обеспечения. IBM и Майкрософт поддерживают образ. Полный список базовых образов WAS, которые поддерживают IBM и Майкрософт, см. в Azure Marketplace.

IBM и Майкрософт поддерживают базовый образ виртуальной машины с предварительно установленной версией WAS 9 в рекомендуемой версии Red Hat Enterprise Linux. Дополнительные сведения об этом изображении см. в портал Azure. При таком подходе используется ibm-usa-ny-armonk-hq-6275750-ibmcloud-aiops:2021-04-27-twas-cluster-base-image:2021-04-27-twas-cluster-base-image:latestобраз Azure Marketplace, используемый для создания виртуальных машин. Используйте следующую команду, чтобы сохранить имя образа в переменной среды:

export VM_URN="ibm-usa-ny-armonk-hq-6275750-ibmcloud-aiops:2023-03-27-twas-cluster-base-image:2023-03-27-twas-cluster-base-image:latest"

$Env:VM_URN="ibm-usa-ny-armonk-hq-6275750-ibmcloud-aiops:2023-03-27-twas-cluster-base-image:2023-03-27-twas-cluster-base-image:latest"

Создание компьютера Red Hat Enterprise Linux

Выполните следующие действия, чтобы создать базовую виртуальную машину, обеспечить установку необходимых средств, создать моментальный снимок диска и создать реплики на основе этого моментального снимка:

Создайте виртуальную машину, выполнив команду az vm create. На этой виртуальной машине вы запускаете диспетчер развертывания.

В следующем примере создается компьютер Red Hat Enterprise Linux с помощью пары имени пользователя и пароля для проверки подлинности. Вместо этого можно использовать проверку подлинности TLS/SSL, что более безопасно.

az vm create \ --resource-group $RESOURCE_GROUP_NAME \ --name adminVM \ --availability-set myAvailabilitySet \ --image $VM_URN \ --size Standard_DS1_v2 \ --admin-username azureuser \ --admin-password Secret123456 \ --public-ip-address "" \ --nsg ""Создайте и подключите новый диск для ФАЙЛОВ WAS с помощью следующей команды:

Этот шаг уже выполняется при использовании базового образа виртуальной машины.

Создание виртуальной машины Windows и настройка сервера X

В этом руководстве используется графический интерфейс WAS для завершения установки и настройки. Виртуальная машина Windows используется в качестве поля перехода и запускаете сервер системы окон X для просмотра графических установщиков на трех виртуальных машинах кластера WAS.

Выполните следующие действия, чтобы подготовить компьютер Windows 10 и установить X-сервер. Если у вас уже есть компьютер Windows в той же сети, что и компьютер Red Hat Enterprise Linux, вам не нужно подготовить новый компьютер из Azure. Вы можете перейти непосредственно к разделу, который устанавливает X-сервер.

Чтобы создать виртуальную машину Windows 10 из портал Azure, выполните следующие действия.

- Откройте группу ресурсов, созданную ранее в портал Azure.

- Щелкните Создать, чтобы создать ресурс.

- Выберите "Вычисления", найдите windows 10 и выберите Microsoft Windows 10.

- Выберите нужный план и нажмите кнопку "Создать".

- Чтобы настроить виртуальную машину, используйте следующие значения:

- Имя виртуальной машины: myWindowsVM

- Изображение: Windows 10 Pro

- Имя пользователя: azureuser

- Пароль: Secret123456

- Установите флажок в разделе "Лицензирование".

- Выберите Проверить и создать, а затем выберите Создать.

Создание виртуальной машины и вспомогательных ресурсов занимает несколько минут.

После завершения развертывания установите X-сервер и используйте его для настройки сервера приложений на компьютерах Linux с помощью графического интерфейса.

Чтобы установить и запустить X-сервер, выполните следующие действия.

- Подключение к удаленному рабочему столу

myWindowsVMс помощью удаленного рабочего стола. Подробное руководство по подключению с помощью удаленного рабочего стола и входа в виртуальную машину Azure под управлением Windows. В этом разделеmyWindowsVMнеобходимо выполнить оставшиеся шаги. - Скачайте и установите VcXsrv Windows X Server.

- Отключите брандмауэр. Чтобы разрешить обмен данными с виртуальных машин Linux, выполните следующие действия, чтобы отключить брандмауэр Защитника Windows:

- Найдите и откройте брандмауэр Защитника Windows.

- Найдите включение или отключение брандмауэра Защитника Windows, а затем выберите " Отключить" в параметрах частной сети. Параметры общедоступной сети можно оставить только.

- Нажмите ОК.

- Закройте панель параметров брандмауэра Защитника Windows.

- Выберите X-launch из рабочего стола.

- Для параметров отображения задайте для номера отображения значение -1 , чтобы использовать несколько окон, а затем нажмите кнопку "Далее".

- Чтобы выбрать запуск клиентов, нажмите кнопку "Пуск" без клиента, а затем нажмите кнопку "Далее".

- Для дополнительных параметров выберите буфер обмена и основной выбор, собственный открытый ключ и отключите управление доступом.

- Нажмите Далее, чтобы завершить операцию.

Диалоговое окно оповещения Безопасность Windows может появиться с этим сообщением: "Разрешить VcXsrv windows X-server взаимодействовать в этих сетях". Выберите "Разрешить доступ".

- Подключение к удаленному рабочему столу

Теперь вы готовы подключиться к компьютеру Red Hat Enterprise Linux и установить необходимые средства с помощью графического интерфейса. В следующих разделах описано, как установить IBM Install Manager и WebSphere Application Server Network Deployment. Используется myWindowsVM для установки и настройки.

Установка зависимостей

Выполните следующие действия, чтобы установить необходимые зависимости, чтобы разрешить подключение с сервера X и включить графическую установку:

Чтобы получить частный IP-адрес

adminVM, выполните следующие действия:- В портал Azure выберите созданную вами группу ресурсов.

- В списке ресурсов выберите

adminVM. - В области обзора выберите "Свойства".

- Скопируйте значение частного IP-адреса в разделе "Сеть". В этом примере используется значение

192.168.0.4.

Откройте командную строку

myWindowsVMиз , а затем подключитесь кadminVMней,sshкак показано в следующем примере:set ADMINVM_IP="192.168.0.4" ssh azureuser@%ADMINVM_IP%Введите пароль Secret123456.

Используйте следующую команду, чтобы переключиться на

rootпользователя. В этом руководстве устанавливаются все средства с пользователемroot.sudo su -Используйте следующие команды для установки зависимостей:

# dependencies for X server access yum install -y libXtst libSM libXrender # dependencies for GUI installation yum install -y gtk2 libXtst xorg-x11-fonts-Type1 mesa-libGL

Позже вы продолжите подключение диска adminVMданных, поэтому сохраните этот терминал открытым.

Подключение диска данных

Этот шаг уже выполняется при использовании базового образа виртуальной машины.

Установка традиционного сетевого развертывания webSphere Application Server

При использовании базового образа развертывание сети сервера приложений WebSphere уже установлено в каталоге /datadrive/IBM/WebSphere/ND/V9.

Создание компьютеров для управляемых серверов

Вы установили сетевое развертывание adminVMwebSphere Application Server, в котором запускается диспетчер развертывания. Вам по-прежнему нужно подготовить компьютеры для запуска двух управляемых серверов. Затем вы создадите моментальный снимок на дисках adminVM и подготовите компьютеры для управляемых mspVM1 узлов и mspVM2.

В этом разделе представлен подход к подготовке компьютеров с помощью моментального снимка adminVM. Вернитесь в терминал, где вы вошли в Azure CLI, а затем выполните следующие действия. Этот терминал не является полем перехода Windows.

Для остановки

adminVMиспользуйте следующую команду:# export RESOURCE_GROUP_NAME=abc1110rg az vm stop --resource-group $RESOURCE_GROUP_NAME --name adminVMИспользуйте az snapshot create для создания моментального снимка

adminVMдиска ОС:export ADMIN_OS_DISK_ID=$(az vm show \ --resource-group $RESOURCE_GROUP_NAME \ --name adminVM \ --query storageProfile.osDisk.managedDisk.id \ --output tsv) az snapshot create \ --resource-group $RESOURCE_GROUP_NAME \ --name myAdminOSDiskSnapshot \ --source $ADMIN_OS_DISK_IDИспользуйте az snapshot create для создания моментального снимка

adminVMдиска данных:export ADMIN_DATA_DISK_ID=$(az vm show \ --resource-group $RESOURCE_GROUP_NAME \ --name adminVM \ --query 'storageProfile.dataDisks[0].managedDisk.id' \ --output tsv) az snapshot create \ --resource-group $RESOURCE_GROUP_NAME \ --name myAdminDataDiskSnapshot \ --source $ADMIN_DATA_DISK_IDИспользуйте следующие команды, чтобы запросить идентификаторы моментальных снимков, которые вы используете позже:

# Get the snapshot ID. export OS_SNAPSHOT_ID=$(az snapshot show \ --resource-group $RESOURCE_GROUP_NAME \ --name myAdminOSDiskSnapshot \ --query '[id]' \ --output tsv) export DATA_SNAPSHOT_ID=$(az snapshot show \ --resource-group $RESOURCE_GROUP_NAME \ --name myAdminDataDiskSnapshot \ --query '[id]' \ --output tsv)

Далее создайте mspVM1 и mspVM2.

Создание mspVM1

Чтобы создать mspVM1следующие действия, выполните следующие действия.

Создайте диск ОС для

mspVM1использования az disk create:# Create a new managed disk by using the OS snapshot ID. # Note that the managed disk is created in the same location as the snapshot. az disk create \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM1_OsDisk_1 \ --source $OS_SNAPSHOT_IDЧтобы создать виртуальную

mspVM1машину, подключите дискmspVM1_OsDisk_1ОС, выполните следующие команды:# Get the resource ID of the managed disk. export MSPVM1_OS_DISK_ID=$(az disk show \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM1_OsDisk_1 \ --query '[id]' \ --output tsv)# Create the VM by attaching the existing managed disk as an OS. az vm create \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM1 \ --attach-os-disk $MSPVM1_OS_DISK_ID \ --plan-publisher ibm-usa-ny-armonk-hq-6275750-ibmcloud-aiops \ --plan-product 2023-03-27-twas-cluster-base-image \ --plan-name 2023-03-27-twas-cluster-base-image \ --os-type linux \ --availability-set myAvailabilitySet \ --public-ip-address "" \ --nsg ""# Create the VM by attaching the existing managed disk as an OS. # For `public-ip-address` and `nsg`, be sure to wrap the value "" in '' in PowerShell. az vm create ` --resource-group $Env:RESOURCE_GROUP_NAME ` --name mspVM1 ` --attach-os-disk $Env:MSPVM1_OS_DISK_ID ` --plan-publisher ibm-usa-ny-armonk-hq-6275750-ibmcloud-aiops ` --plan-product 2023-03-27-twas-cluster-base-image ` --plan-name 2023-03-27-twas-cluster-base-image ` --os-type linux ` --availability-set myAvailabilitySet ` --public-ip-address '""' ` --nsg '""'Создайте управляемый диск из моментального снимка диска данных и подключите его к

mspVM1:az disk create \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM1_Data_Disk_1 \ --source $DATA_SNAPSHOT_ID export MSPVM1_DATA_DISK_ID=$(az disk show \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM1_Data_Disk_1 \ --query '[id]' \ --output tsv) az vm disk attach \ --resource-group $RESOURCE_GROUP_NAME \ --vm-name mspVM1 \ --name $MSPVM1_DATA_DISK_IDВы создали

mspVM1с установленным компонентом WAS. Так как вы создали виртуальную машину из моментального снимкаadminVMдисков, две виртуальные машины имеют одно и то же имя узла. Используйте az vm run-command invoke , чтобы изменить имя узла на значениеmspVM1:az vm run-command invoke \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM1 \ --command-id RunShellScript \ --scripts "sudo hostnamectl set-hostname mspVM1"После успешного завершения команды вы получите выходные данные, аналогичные следующему примеру:

{ "value": [ { "code": "ProvisioningState/succeeded", "displayStatus": "Provisioning succeeded", "level": "Info", "message": "Enable succeeded: \n[stdout]\n\n[stderr]\n", "time": null } ] }

Создание mspVM2

Чтобы создать mspVM2следующие действия, выполните следующие действия.

Создайте диск ОС для

mspVM2использования az disk create:# Create a new managed disk by using the OS snapshot ID. # Note that the managed disk is created in the same location as the snapshot. az disk create \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM2_OsDisk_1 \ --source $OS_SNAPSHOT_IDЧтобы создать виртуальную

mspVM2машину, подключите дискmspVM2_OsDisk_1ОС, выполните следующие команды:# Get the resource ID of the managed disk. export MSPVM2_OS_DISK_ID=$(az disk show \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM2_OsDisk_1 \ --query '[id]' \ --output tsv)# Create the VM by attaching the existing managed disk as an OS. az vm create \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM2 \ --attach-os-disk $MSPVM2_OS_DISK_ID \ --plan-publisher ibm-usa-ny-armonk-hq-6275750-ibmcloud-aiops \ --plan-product 2023-03-27-twas-cluster-base-image \ --plan-name 2023-03-27-twas-cluster-base-image \ --os-type linux \ --availability-set myAvailabilitySet \ --public-ip-address "" \ --nsg ""# Create the VM by attaching the existing managed disk as an OS. # For `public-ip-address` and `nsg`, be sure to wrap the value "" in '' in PowerShell. az vm create ` --resource-group $Env:RESOURCE_GROUP_NAME ` --name mspVM2 ` --attach-os-disk $Env:MSPVM2_OS_DISK_ID ` --plan-publisher ibm-usa-ny-armonk-hq-6275750-ibmcloud-aiops ` --plan-product 2023-03-27-twas-cluster-base-image ` --plan-name 2023-03-27-twas-cluster-base-image ` --os-type linux ` --availability-set myAvailabilitySet ` --public-ip-address '""' ` --nsg '""'Создайте управляемый диск из моментального снимка данных и подключите его к

mspVM2:az disk create \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM2_Data_Disk_1 \ --source $DATA_SNAPSHOT_ID export MSPVM2_DATA_DISK_ID=$(az disk show \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM2_Data_Disk_1 \ --query '[id]' \ --output tsv) az vm disk attach \ --resource-group $RESOURCE_GROUP_NAME \ --vm-name mspVM2 \ --name $MSPVM2_DATA_DISK_IDВы создали

mspVM2с установленным компонентом WAS. Так как вы создали виртуальную машину из моментального снимкаadminVMдисков, две виртуальные машины имеют одно и то же имя узла. Используйте az vm run-command invoke , чтобы изменить имя узла на значениеmspVM2:az vm run-command invoke \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM2 \ --command-id RunShellScript \ --scripts "sudo hostnamectl set-hostname mspVM2"После успешного завершения команды вы получите выходные данные, аналогичные следующему примеру:

{ "value": [ { "code": "ProvisioningState/succeeded", "displayStatus": "Provisioning succeeded", "level": "Info", "message": "Enable succeeded: \n[stdout]\n\n[stderr]\n", "time": null } ] }

Убедитесь, что вы выполнили предыдущие шаги для обоих mspVM1 и mspVM2. Затем выполните следующие действия, чтобы завершить подготовку компьютеров:

, как показано в следующем примере:

az vm start --resource-group $RESOURCE_GROUP_NAME --name adminVMИспользуйте следующие команды, чтобы получить и показать частные IP-адреса, которые используются в последующих разделах:

export ADMINVM_NIC_ID=$(az vm show \ --resource-group $RESOURCE_GROUP_NAME \ --name adminVM \ --query networkProfile.networkInterfaces'[0]'.id \ --output tsv) export ADMINVM_IP=$(az network nic show \ --ids $ADMINVM_NIC_ID \ --query ipConfigurations'[0]'.privateIPAddress \ --output tsv) export MSPVM1_NIC_ID=$(az vm show \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM1 \ --query networkProfile.networkInterfaces'[0]'.id \ --output tsv) export MSPVM1_IP=$(az network nic show \ --ids $MSPVM1_NIC_ID \ --query ipConfigurations'[0]'.privateIPAddress \ --output tsv) export MSPVM2_NIC_ID=$(az vm show \ --resource-group $RESOURCE_GROUP_NAME \ --name mspVM2 \ --query networkProfile.networkInterfaces'[0]'.id \ --output tsv) export MSPVM2_IP=$(az network nic show \ --ids $MSPVM2_NIC_ID \ --query ipConfigurations'[0]'.privateIPAddress \ --output tsv) echo "Private IP of adminVM: $ADMINVM_IP" echo "Private IP of mspVM1: $MSPVM1_IP" echo "Private IP of mspVM2: $MSPVM2_IP"

Теперь все три компьютера готовы. Затем вы настроите кластер WAS.

Создание профилей WAS и кластера

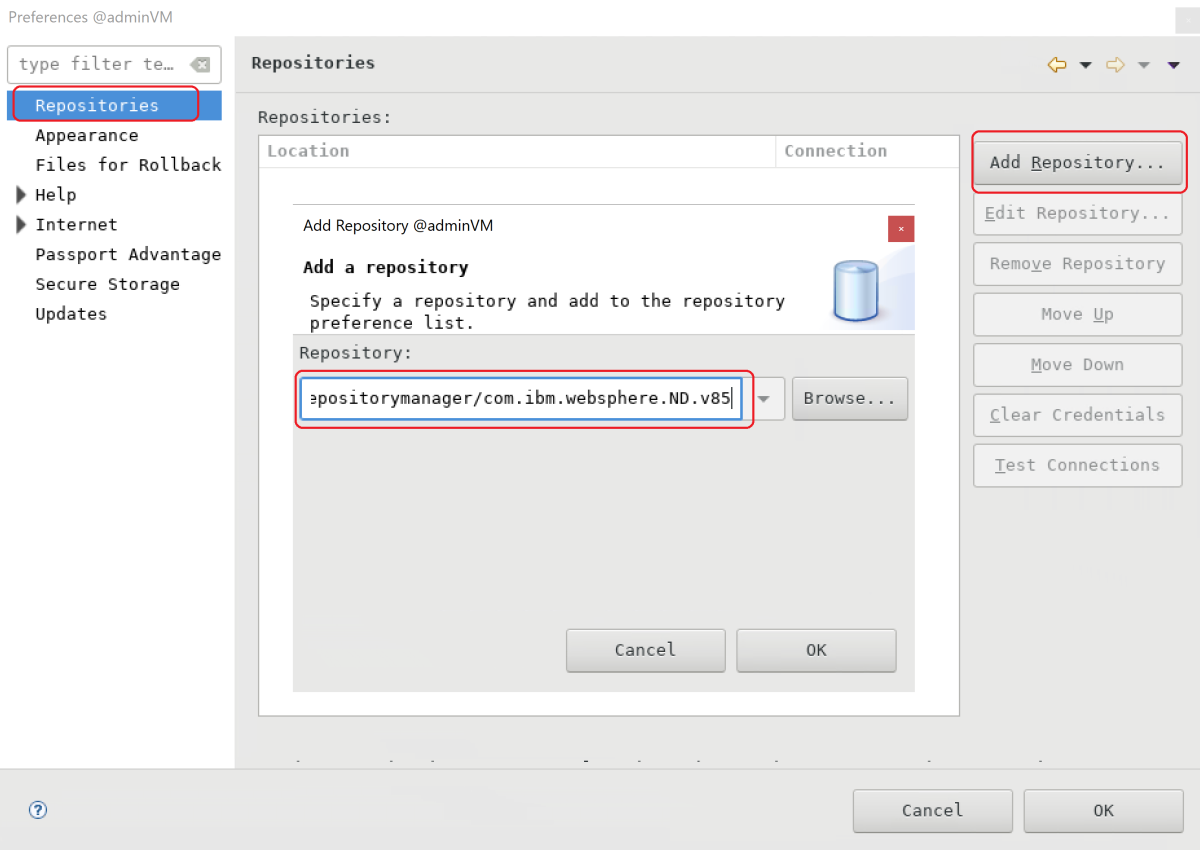

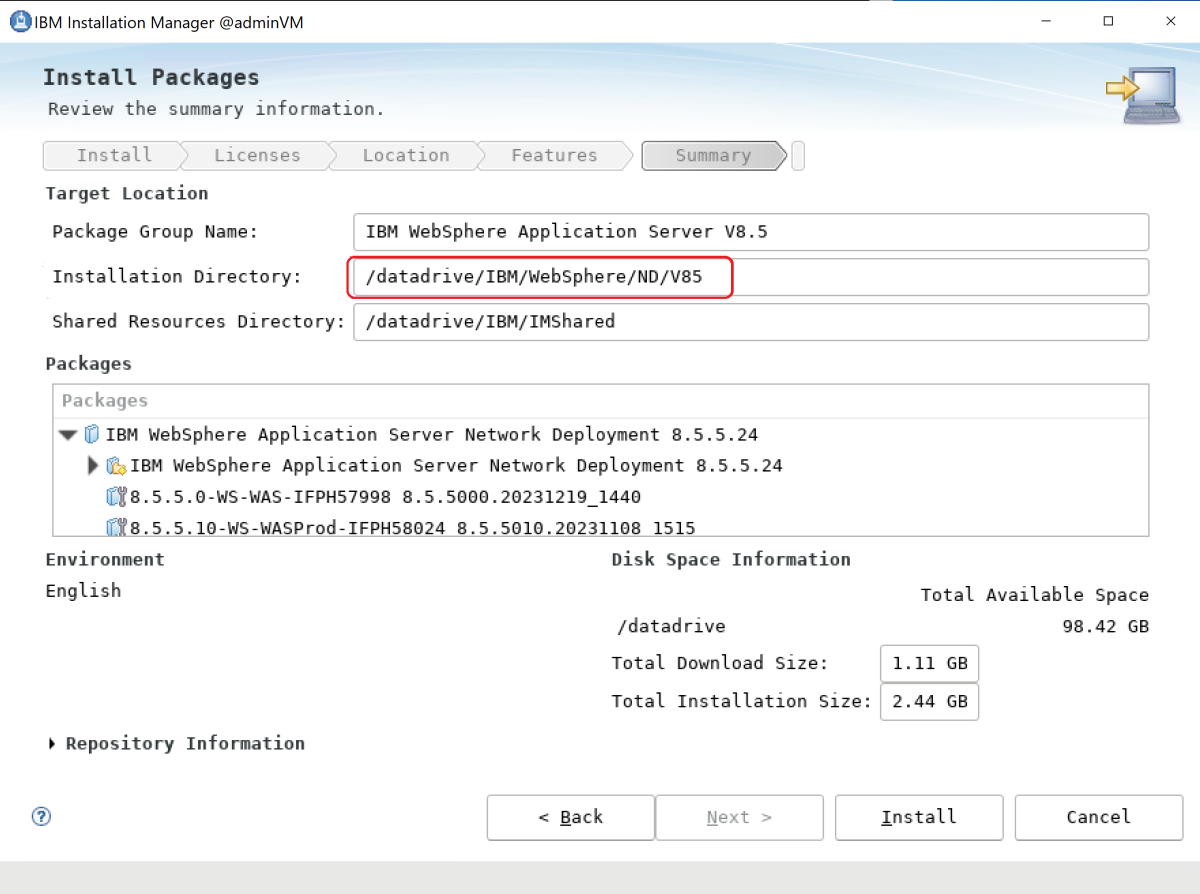

В этом разделе показано, как создать и настроить кластер WAS. С точки зрения создания профилей WAS и кластера нет существенной разницы между серией 9.x и серией 8.5.x. Все снимки экрана в этом разделе показывают V9 в качестве основы.

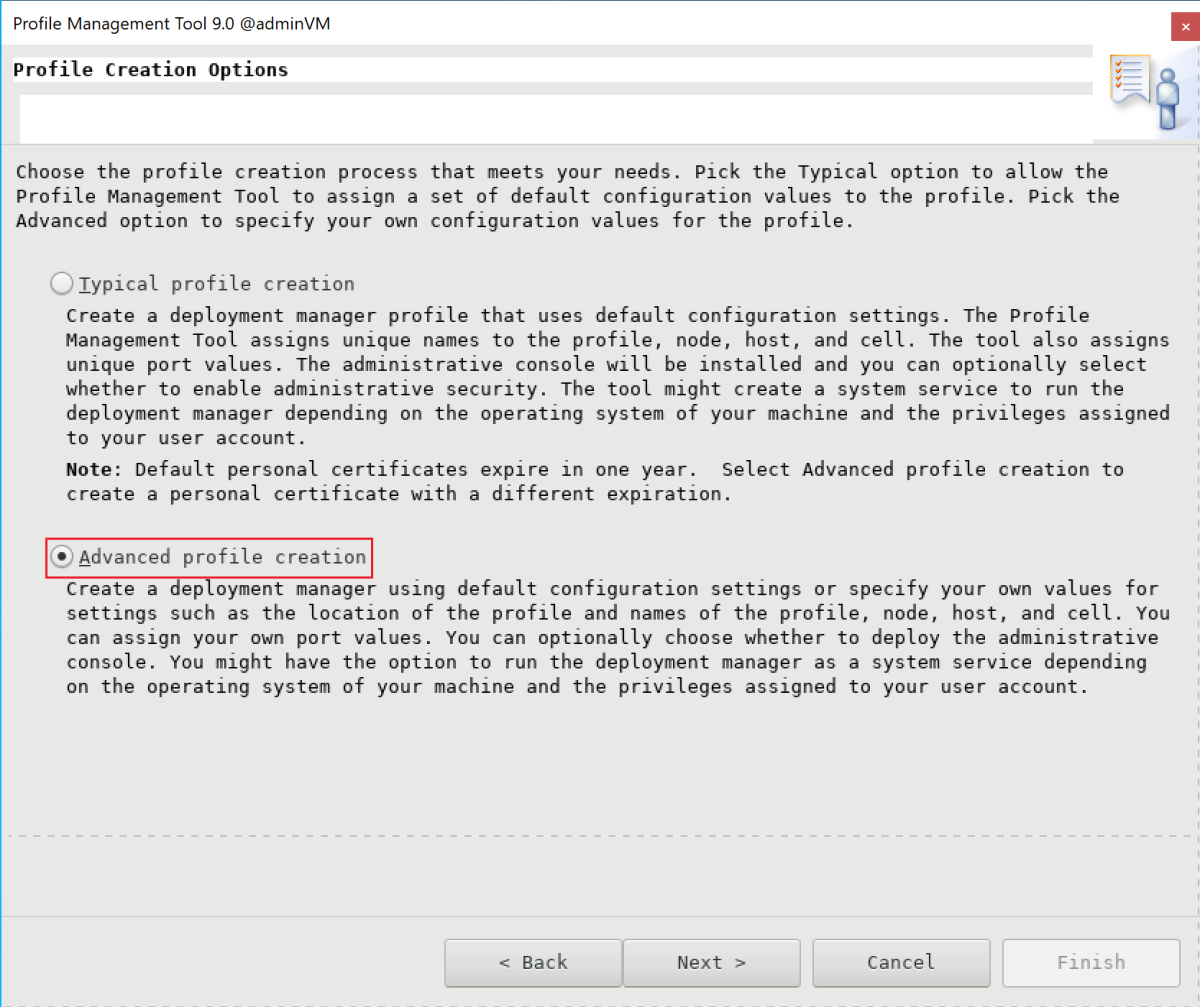

Настройка профиля диспетчера развертывания

В этом разделе используется X-сервер myWindowsVM для создания профиля управления для диспетчера развертывания для администрирования серверов в ячейке диспетчера развертывания с помощью средства управления профилями. Дополнительные сведения о профилях см. в разделе "Основные понятия профиля". Дополнительные сведения о создании профиля диспетчера развертывания см. в статье "Создание профилей управления с помощью диспетчеров развертывания".

Чтобы создать и настроить профиль управления, выполните следующие действия.

Убедитесь, что вы все еще находитесь на компьютере с Windows. Если это не так, используйте следующие команды для удаленного подключения

myWindowsVMи подключения изadminVMкомандной строки:set ADMINVM_IP="192.168.0.4" ssh azureuser@%ADMINVM_IP%Используйте следующие команды, чтобы стать пользователем

rootи задатьDISPLAYпеременную:sudo su - export DISPLAY=<my-windows-vm-private-ip>:0.0 # export DISPLAY=192.168.0.5:0.0Используйте следующие команды, чтобы запустить средство управления профилями:

cd /datadrive/IBM/WebSphere/ND/V9/bin/ProfileManagement ./pmt.shЧерез некоторое время появится средство управления профилями. Если пользовательский интерфейс не отображается, проверьте командную строку. Нажмите кнопку создания.

На панели выбора среды нажмите кнопку "Управление" и нажмите кнопку "Далее".

На панели выбора типа сервера выберите диспетчер развертывания и нажмите кнопку "Далее".

На панели "Параметры создания профиля" выберите "Дополнительное создание профиля" и нажмите кнопку "Далее".

На панели "Необязательное развертывание приложений" установите флажок "Развернуть административную консоль" (рекомендуется), а затем нажмите кнопку "Далее".

В области "Имя профиля" и "Расположение" введите имя и расположение профиля. В этом примере имя профиля —

Dmgr01. Расположение зависит от версии WAS:- В WAS V9 расположение — /datadrive/IBM/WebSphere/ND/V9/profiles/Dmgr01.

- В WAS V8.5 расположение — /datadrive/IBM/WebSphere/ND/V85/profiles/Dmgr01.

По завершении нажмите кнопку "Далее".

В области "Узлы", "Узел" и "Имена ячеек" введите имя узла, имя узла и имя ячейки. Узел — это частный IP-адрес

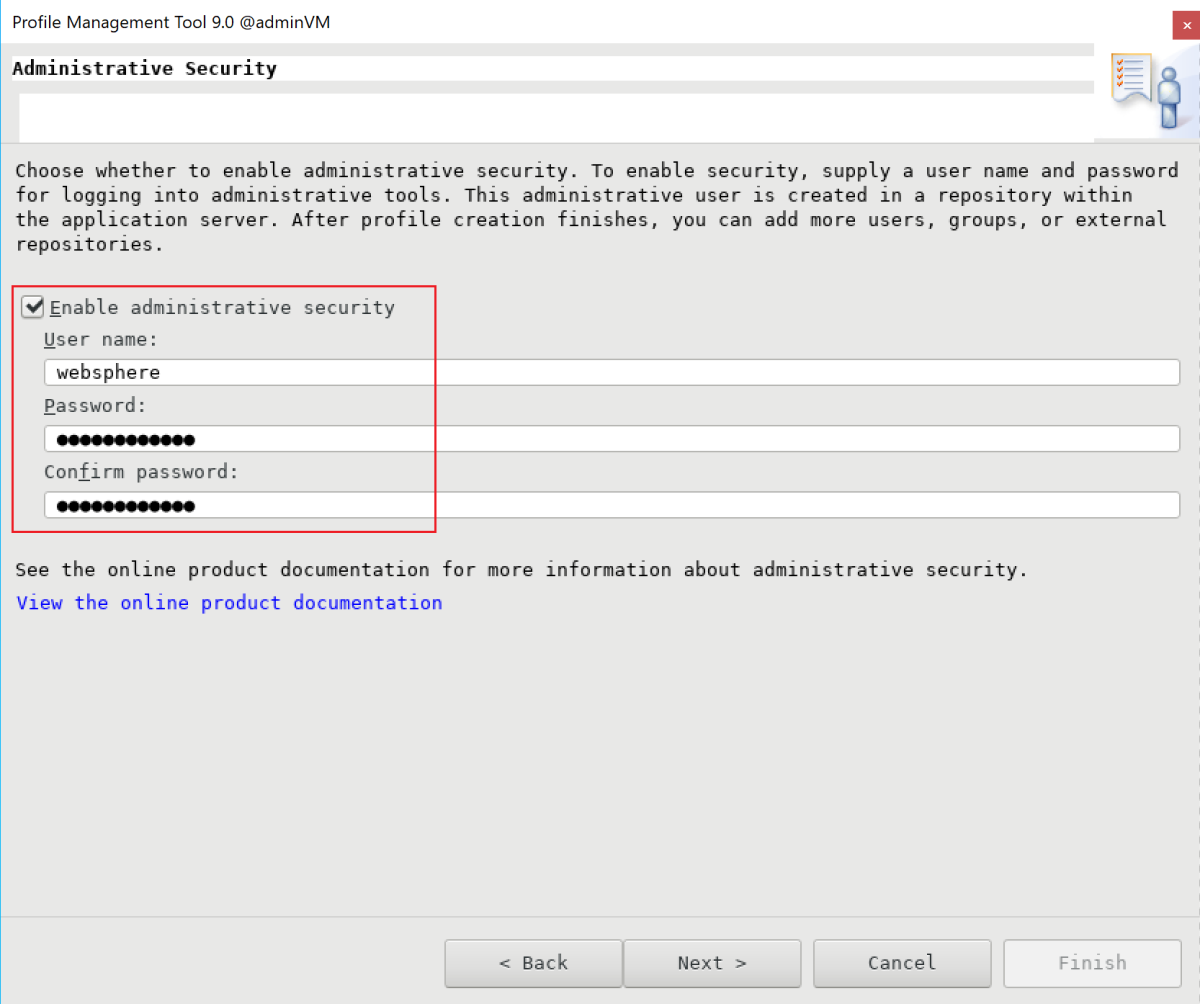

adminVM. В этом примере имя узла —adminvmCellManager01это192.168.0.4значение узла, а имя ячейки —adminvmCell01. По завершении нажмите кнопку "Далее".На панели "Администрирование безопасности" введите имя пользователя и пароль администратора. В этом примере используется

websphereSecret123456имя пользователя и пароль. Запишите имя пользователя и пароль, чтобы использовать их для входа в консоль IBM. По завершении нажмите кнопку "Далее".Для сертификата безопасности (часть 1) введите сертификат, если у вас есть. В этом примере используется самозаверяющий сертификат по умолчанию. Затем выберите Далее.

Для сертификата безопасности (часть 2) введите сертификат, если у вас есть. В этом примере используется самозаверяющий сертификат по умолчанию. Затем выберите Далее.

На панели "Назначение значений портов" сохраните порты по умолчанию и нажмите кнопку "Далее".

На панели определения службы Linux не выбирайте запуск процесса диспетчера развертывания в качестве службы Linux. Позже вы создадите службу Linux. Выберите Далее.

На панели "Сводка по созданию профиля" убедитесь, что информация правильна, а затем нажмите кнопку "Создать".

Для завершения создания профиля потребуется некоторое время. Когда появится панель "Создание профиля", нажмите кнопку "Запустить консоль "Первые шаги". Выберите Готово.

Появится консоль "Первые шаги". Выберите "Проверка установки".

Начинается процесс проверки и появляется результат, аналогичный следующему примеру. Если возникают ошибки, перед переходом необходимо устранить их.

Начинается процесс диспетчера развертывания. Вы можете закрыть консоль "Первые шаги", закрыв панель вывода и выбрав "Выйти" в консоли.

Вы завершили создание профиля. Панель элементов настройки WebSphere можно закрыть.

Чтобы получить доступ к консоли IBM, откройте порты брандмауэра с помощью следующих команд:

firewall-cmd --zone=public --add-port=9060/tcp --permanent firewall-cmd --zone=public --add-port=9043/tcp --permanent firewall-cmd --zone=public --add-port=9809/tcp --permanent firewall-cmd --zone=public --add-port=7277/tcp --permanent firewall-cmd --zone=public --add-port=9402/tcp --permanent firewall-cmd --zone=public --add-port=9403/tcp --permanent firewall-cmd --zone=public --add-port=9352/tcp --permanent firewall-cmd --zone=public --add-port=9632/tcp --permanent firewall-cmd --zone=public --add-port=9100/tcp --permanent firewall-cmd --zone=public --add-port=9401/tcp --permanent firewall-cmd --zone=public --add-port=8879/tcp --permanent firewall-cmd --zone=public --add-port=5555/tcp --permanent firewall-cmd --zone=public --add-port=7060/tcp --permanent firewall-cmd --zone=public --add-port=11005/udp --permanent firewall-cmd --zone=public --add-port=11006/tcp --permanent firewall-cmd --zone=public --add-port=9420/tcp --permanent firewall-cmd --reloadЧтобы запустить диспетчер развертывания автоматически при запуске, создайте службу Linux для процесса. Выполните следующие команды, чтобы создать службу Linux:

export PROFILE_PATH=/datadrive/IBM/WebSphere/ND/V9/profiles/Dmgr01 # Configure SELinux so systemctl has access on server start/stop script files. semanage fcontext -a -t bin_t "${PROFILE_PATH}/bin(/.*)?" restorecon -r -v ${PROFILE_PATH}/bin # Add service. ${PROFILE_PATH}/bin/wasservice.sh -add adminvmCellManager01 -servername dmgr -profilePath ${PROFILE_PATH}Убедитесь, что отображаются следующие выходные данные:

CWSFU0013I: Service [adminvmCellManager01] added successfully.Если выходные данные не отображаются, устраните и устраните проблему перед продолжением.

Диспетчер развертывания работает в adminVM. На виртуальной машине Windows для перехода можно получить доступ к консоли IBM по URL-адресу http://<admin-vm-private-ip>:9060/ibm/console/.

Настройка настраиваемых профилей

В этом разделе вы используете X-сервер myWindowsVM для создания настраиваемых профилей для управляемых серверов mspVM1 и mspVM2.

Убедитесь, что вы все еще находитесь на компьютере с Windows. Если это не так, удаленно подключитесь к myWindowsVM.

Настройка пользовательского профиля для mspVM1

Чтобы настроить настраиваемый профиль, mspVM1выполните следующие действия.

Используйте следующие команды, чтобы подключиться к

mspVM1командной строке:set MSPVM1VM_IP="192.168.0.6" ssh azureuser@%MSPVM1VM_IP%Используйте следующие команды, чтобы стать пользователем

rootи задатьDISPLAYпеременную:sudo su - export DISPLAY=<my-windows-vm-private-ip>:0.0 # export DISPLAY=192.168.0.5:0.0Чтобы получить доступ к диспетчеру

adminVMразвертывания, откройте порты брандмауэра с помощью следующих команд:firewall-cmd --zone=public --add-port=9080/tcp --permanent firewall-cmd --zone=public --add-port=9443/tcp --permanent firewall-cmd --zone=public --add-port=2809/tcp --permanent firewall-cmd --zone=public --add-port=9405/tcp --permanent firewall-cmd --zone=public --add-port=9406/tcp --permanent firewall-cmd --zone=public --add-port=9353/tcp --permanent firewall-cmd --zone=public --add-port=9633/tcp --permanent firewall-cmd --zone=public --add-port=5558/tcp --permanent firewall-cmd --zone=public --add-port=5578/tcp --permanent firewall-cmd --zone=public --add-port=9100/tcp --permanent firewall-cmd --zone=public --add-port=9404/tcp --permanent firewall-cmd --zone=public --add-port=7276/tcp --permanent firewall-cmd --zone=public --add-port=7286/tcp --permanent firewall-cmd --zone=public --add-port=5060/tcp --permanent firewall-cmd --zone=public --add-port=5061/tcp --permanent firewall-cmd --zone=public --add-port=8880/tcp --permanent firewall-cmd --zone=public --add-port=11003/udp --permanent firewall-cmd --zone=public --add-port=11004/tcp --permanent firewall-cmd --zone=public --add-port=2810/tcp --permanent firewall-cmd --zone=public --add-port=9201/tcp --permanent firewall-cmd --zone=public --add-port=9202/tcp --permanent firewall-cmd --zone=public --add-port=9354/tcp --permanent firewall-cmd --zone=public --add-port=9626/tcp --permanent firewall-cmd --zone=public --add-port=9629/tcp --permanent firewall-cmd --zone=public --add-port=7272/tcp --permanent firewall-cmd --zone=public --add-port=5001/tcp --permanent firewall-cmd --zone=public --add-port=5000/tcp --permanent firewall-cmd --zone=public --add-port=9900/tcp --permanent firewall-cmd --zone=public --add-port=9901/tcp --permanent firewall-cmd --zone=public --add-port=8878/tcp --permanent firewall-cmd --zone=public --add-port=7061/tcp --permanent firewall-cmd --zone=public --add-port=7062/tcp --permanent firewall-cmd --zone=public --add-port=11001/udp --permanent firewall-cmd --zone=public --add-port=11002/tcp --permanent firewall-cmd --zone=public --add-port=9809/tcp --permanent firewall-cmd --zone=public --add-port=9402/tcp --permanent firewall-cmd --zone=public --add-port=9403/tcp --permanent firewall-cmd --zone=public --add-port=9352/tcp --permanent firewall-cmd --zone=public --add-port=9632/tcp --permanent firewall-cmd --zone=public --add-port=9401/tcp --permanent firewall-cmd --zone=public --add-port=11005/udp --permanent firewall-cmd --zone=public --add-port=11006/tcp --permanent firewall-cmd --zone=public --add-port=8879/tcp --permanent firewall-cmd --zone=public --add-port=9060/tcp --permanent firewall-cmd --zone=public --add-port=9043/tcp --permanent firewall-cmd --reloadИспользуйте следующие команды, чтобы запустить средство управления профилями:

cd /datadrive/IBM/WebSphere/ND/V9/bin/ProfileManagement ./pmt.shЧерез некоторое время появится средство управления профилями. Если вы не видите пользовательский интерфейс, устраните и устраните проблему, прежде чем продолжить. Нажмите кнопку создания.

На панели выбора среды выберите "Настраиваемый профиль" и нажмите кнопку "Далее".

На панели "Параметры создания профиля" выберите "Дополнительное создание профиля" и нажмите кнопку "Далее".

В области "Имя профиля" и "Расположение" введите имя и расположение профиля. В этом примере имя профиля —

Custom01. Расположение зависит от версии WAS:- В WAS V9 расположение — /datadrive/IBM/WebSphere/ND/V9/profiles/Custom01.

- В WAS V8.5 расположение — /datadrive/IBM/WebSphere/ND/V85/profiles/Custom01.

По завершении нажмите кнопку "Далее".

В области "Имена узлов" и "Имена узлов" введите имя узла и узел. Значение узла — частный IP-адрес

mspVM1. В этом примере узел имеет имя192.168.0.6узла и имяmspvm1Node01узла. По завершении нажмите кнопку "Далее".В области федерации введите имя узла и проверку подлинности диспетчера развертывания. Для имени узла диспетчера развертывания или IP-адреса значением является частный IP-адрес

adminVM, который находится192.168.0.4здесь. Для проверки подлинности диспетчера развертывания в этом примере имя пользователя равноwebsphereи парольSecret123456. По завершении нажмите кнопку "Далее".Для сертификата безопасности (часть 1) введите сертификат, если у вас есть. В этом примере используется самозаверяющий сертификат по умолчанию. Затем выберите Далее.

Для сертификата безопасности (часть 2) введите сертификат, если у вас есть. В этом примере используется самозаверяющий сертификат по умолчанию. Затем выберите Далее.

На панели "Назначение значений портов" сохраните порты по умолчанию и нажмите кнопку "Далее".

На панели "Сводка по созданию профиля" убедитесь, что информация правильна, а затем нажмите кнопку "Создать".

Для создания пользовательского профиля потребуется некоторое время. В области "Создание профиля" снимите флажок "Запустить консоль "Первые шаги". Затем нажмите кнопку "Готово ", чтобы завершить создание профиля и закрыть средство управления профилями.

Чтобы автоматически запустить сервер при запуске, создайте службу Linux для процесса. Следующие команды создают службу Linux для запуска

nodeagent:export PROFILE_PATH=/datadrive/IBM/WebSphere/ND/V9/profiles/Custom01 # Configure SELinux so systemctl has access on server start/stop script files. semanage fcontext -a -t bin_t "${PROFILE_PATH}/bin(/.*)?" restorecon -r -v ${PROFILE_PATH}/bin # Add service to start nodeagent. ${PROFILE_PATH}/bin/wasservice.sh -add mspvm1Node01 -servername nodeagent -profilePath ${PROFILE_PATH}Убедитесь, что отображаются следующие выходные данные:

CWSFU0013I: Service [mspvm1Node01] added successfully.Если выходные данные не отображаются, устраните и устраните проблему перед продолжением.

Вы создали пользовательский профиль и nodeagent работали в mspVM1ней. Остановите работу root пользователя и закройте подключение SSH к mspVM1.

Настройка пользовательского профиля для mspVM2

Вернитесь к началу раздела "Настройка пользовательского профиля для mspVM1" и выполните те же действия.mspVM2 То есть, где бы вы ни использовали mspVM1 или аналогичные, выполните то же самое для mspVM2.

В области "Имена узлов" и "Имена узлов" введите mspvm2Node01имя узла и 192.168.0.7имя узла.

Вы подготовили пользовательский профиль для двух управляемых серверов: mspVM1 и mspVM2. Перейдите к созданию кластера WAS.

Создание кластера и начальных серверов

В этом разделе вы используете консоль IBM для создания кластера WAS и запуска управляемых серверов с помощью браузера myWindowsVM. Убедитесь, что вы все еще находитесь на компьютере с Windows. Если это не так, удаленно подключитесь к myWindowsVM. После этого выполните следующие действия:

Откройте браузер Microsoft Edge и перейдите к ней

http://<adminvm-private-ip>:9060/ibm/console/. В этом примере ИСПОЛЬЗУЕТсяhttp://192.168.0.4:9060/ibm/console/URL-адрес консоли IBM. Найдите область входа. Войдите в консоль IBM с помощью имени администратора и пароля (websphere/Secret123456). Теперь можно администрировать кластеры и серверы.На панели навигации выберите >серверов приложений. Затем нажмите кнопку "Создать" , чтобы создать новый кластер.

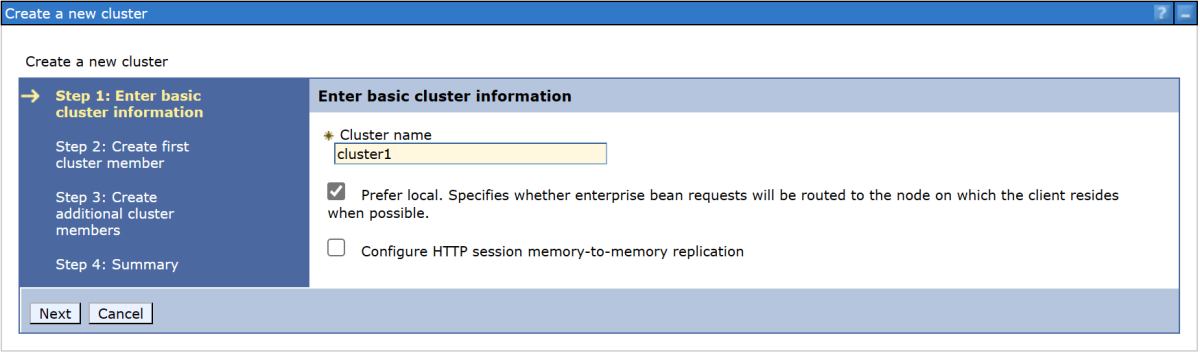

В диалоговом окне "Создание кластера" для шага 1. Введите основные сведения о кластере, введите имя кластера. В этом примере имя кластера —

cluster1. По завершении нажмите кнопку "Далее".Для шага 2. Создание первого члена кластера, введите имя члена и выберите узел

mspvm1Node01. В этом примере имя члена —msp1. Узел зависит от версии WAS:- В WAS V9 узел имеет значение

mspvm1Node01 (ND 9.0.5.12). - В WAS V8.5 узел имеет значение

mspvm1Node01 (ND 8.5.5.24).

По завершении нажмите кнопку "Далее".

- В WAS V9 узел имеет значение

На шаге 3. Создайте дополнительные члены кластера, введите имя второго члена и выберите узел

mspvm2Node01. В этом примере имя члена —msp2. Узел зависит от версии WAS:- В WAS V9 узел имеет значение

mspvm2Node01 (ND 9.0.5.12). - В WAS V8.5 узел имеет значение

mspvm2Node01 (ND 8.5.5.24).

- В WAS V9 узел имеет значение

Нажмите кнопку "Добавить участника" , чтобы добавить второй узел. В таблице перечислены два члена. По завершении нажмите кнопку "Далее".

Для шага 4. Сводка нажмите кнопку "Готово".

Создание кластера занимает некоторое время. После создания

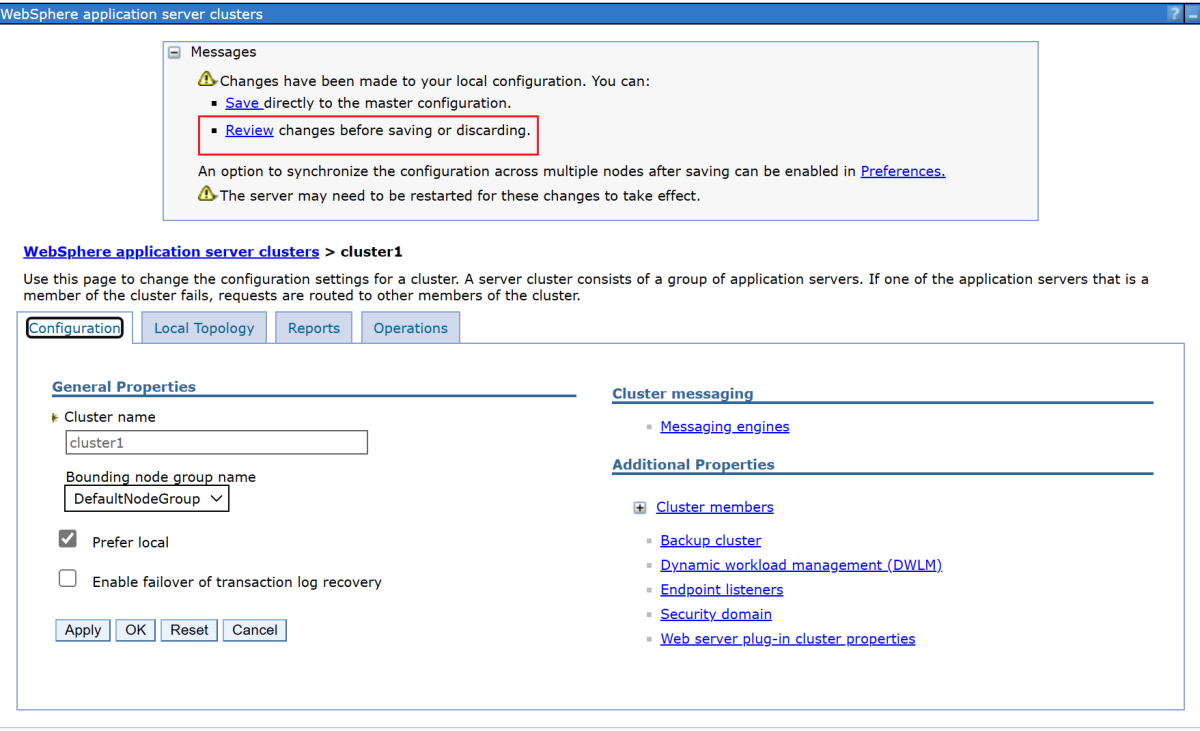

cluster1кластера появится в таблице.Выберите cluster1 и нажмите кнопку "Проверить ", чтобы просмотреть сведения.

Выберите " Синхронизировать изменения с узлами" и нажмите кнопку "Сохранить".

Создание должно завершиться без ошибки. Для продолжения выберите ОК.

Выберите cluster1 в таблице и нажмите кнопку "Пуск ", чтобы запустить кластер.

Для запуска двух управляемых серверов потребуется некоторое время. В столбце "Состояние " выберите значок обновления (две стрелки, указывающие друг на друга), чтобы обновить состояние.

Наведите указатель мыши на значок обновления. Когда в подсказке показано, как показано, как запущено, можно доверять сформированию кластера. Продолжайте периодически обновлять и проверять до тех пор, пока подсказка не появится на начальном запуске.

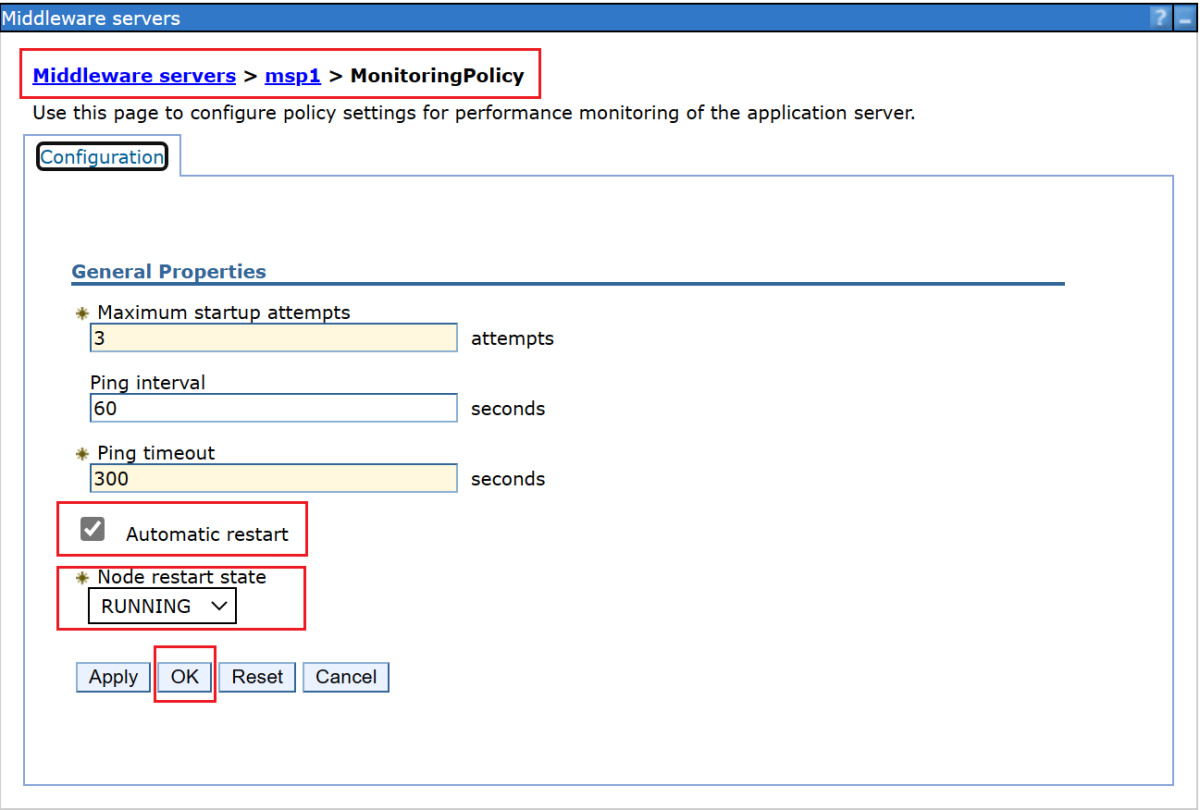

Выполните следующие действия, чтобы настроить параметры политики мониторинга сервера приложений для автоматического запуска управляемого сервера после запуска агента узла.

Чтобы настроить

msp1следующие действия, выполните следующие действия.На панели навигации выберите "Серверы", выберите "Типы серверов" и выберите серверы приложений WebSphere.

Выберите гиперссылку для сервера

msp1приложений.В разделе "Инфраструктура сервера" выберите Java и управление процессами.

Выберите политику мониторинга.

Убедитесь, что выбран автоматический перезапуск , а затем выберите "ВЫПОЛНЕНИЕ " в качестве состояния перезапуска узла. Нажмите ОК.

Вернитесь к области служб ПО промежуточного слоя. На панели "Сообщения" выберите ссылку "Рецензирование", а затем выберите "Синхронизировать изменения с узлами". Нажмите кнопку "Сохранить", чтобы сохранить и синхронизировать изменения.

Появится следующее сообщение:

The configuration synchronization complete for cell.нажмите кнопку "ОК ", чтобы выйти из конфигурации.

Чтобы настроить

msp2следующие действия, выполните следующие действия.- На панели навигации выберите "Серверы", выберите "Типы серверов" и выберите серверы приложений WebSphere.

- Выберите гиперссылку для сервера

msp2приложений. - В разделе "Инфраструктура сервера" выберите Java и управление процессами.

- Выберите политику мониторинга.

- Убедитесь, что выбран автоматический перезапуск , а затем выберите "ВЫПОЛНЕНИЕ " в качестве состояния перезапуска узла. Нажмите ОК.

- Вернитесь к области служб ПО промежуточного слоя. На панели "Сообщения" выберите ссылку "Рецензирование", а затем выберите "Синхронизировать изменения с узлами". Нажмите кнопку "Сохранить", чтобы сохранить и синхронизировать изменения.

- Появится следующее сообщение:

The configuration synchronization complete for cell.нажмите кнопку "ОК ", чтобы выйти из конфигурации.

Вы настроили cluster1 два управляемых сервера msp1 и msp2. Кластер работает и работает.

Развертывание приложения

Чтобы развернуть приложение, выполните следующие действия.

В административной консоли, в которой вы вошли ранее, выберите "Приложения>нового приложения" и выберите "Новое корпоративное приложение".

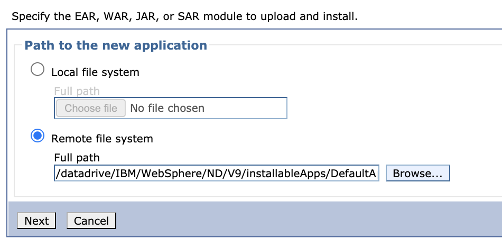

На следующей панели выберите удаленную файловую систему, а затем выберите "Обзор " для просмотра файловых систем установленных серверов.

Выберите систему, начинающуюся с adminvm. Появится файловая система виртуальной машины. Выберите V9 (или V85), а затем выберите installableApps.

В списке приложений, доступных для установки, выберите DefaultApplication.ear. Затем выберите OK.

Вы вернитесь на панель для выбора приложения. Выберите Далее.

Нажмите кнопку "Далее" для всех оставшихся шагов в рабочем процессе установки нового приложения . Выберите Готово.

Появится следующее сообщение:

Application DefaultApplication.ear installed successfully.если это сообщение не отображается, устраните и устраните проблему, прежде чем продолжить.Щелкните ссылку " Сохранить непосредственно в главной конфигурации ".

Необходимо запустить приложение. Перейдите к приложениям всех приложений>. Установите флажок DefaultApplication.ear, убедитесь, что для действия задано значение "Пуск", а затем нажмите кнопку "Отправить действие".

В таблице "Все приложения" в столбце "Состояние" выберите значок обновления. После нескольких раз обновления таблицы таким образом зеленая стрелка должна появиться в столбце "Состояние " для DefaultApplication.ear.

Теперь приложение установлено в кластере WAS.

Предоставление функции WAS с помощью Шлюз приложений Azure

Теперь, когда вы завершили создание кластера WAS на виртуальных машинах GNU/Linux, в этом разделе описан процесс предоставления объекта WAS в Интернете с помощью Шлюз приложений Azure.

Создание шлюза приложений

Чтобы создать шлюз приложений, выполните следующие действия.

Чтобы предоставить доступ к Интернету, вам нужен общедоступный IP-адрес. В оболочке с установленным Azure CLI создайте IP-адрес с помощью az network public-ip create, как показано в следующем примере:

az network public-ip create \ --resource-group $RESOURCE_GROUP_NAME \ --name myAGPublicIPAddress \ --allocation-method Static \ --sku Standard export APPGATEWAY_IP=$(az network public-ip show \ --resource-group $RESOURCE_GROUP_NAME \ --name myAGPublicIPAddress \ --query '[ipAddress]' \ --output tsv)Создайте шлюз приложений для связывания с IP-адресом. В следующем примере создается шлюз приложений с управляемыми серверами WebSphere в серверном пуле по умолчанию:

az network application-gateway create \ --resource-group $RESOURCE_GROUP_NAME \ --name myAppGateway \ --public-ip-address myAGPublicIPAddress \ --location eastus \ --capacity 2 \ --http-settings-port 80 \ --http-settings-protocol Http \ --frontend-port 80 \ --sku Standard_V2 \ --subnet wasGateway \ --vnet-name myVNet \ --priority 1001 \ --servers ${MSPVM1_IP} ${MSPVM2_IP}Управляемые серверы предоставляют рабочие нагрузки с помощью порта

9080. Используйте следующие команды для обновленияappGatewayBackendHttpSettings, указав внутренний порт9080и создав для него пробу:az network application-gateway probe create \ --resource-group $RESOURCE_GROUP_NAME \ --gateway-name myAppGateway \ --name clusterProbe \ --protocol http \ --host-name-from-http-settings true \ --match-status-codes 404 \ --path "/" az network application-gateway http-settings update \ --resource-group $RESOURCE_GROUP_NAME \ --gateway-name myAppGateway \ --name appGatewayBackendHttpSettings \ --host-name-from-backend-pool true \ --port 9080 \ --probe clusterProbeИспользуйте следующие команды для подготовки правила перезаписи для перенаправлений:

# Create a rewrite rule set. az network application-gateway rewrite-rule set create \ --resource-group $RESOURCE_GROUP_NAME \ --gateway-name myAppGateway \ --name myRewriteRuleSet # Associated routing rules. az network application-gateway rule update \ --resource-group $RESOURCE_GROUP_NAME \ --gateway-name myAppGateway \ --name rule1 \ --rewrite-rule-set myRewriteRuleSet # Create a rewrite rule 1. az network application-gateway rewrite-rule create \ --resource-group $RESOURCE_GROUP_NAME \ --gateway-name myAppGateway \ --rule-set-name myRewriteRuleSet \ --name myRewriteRule01 \ --sequence 100 \ --response-headers Location=http://${APPGATEWAY_IP}{http_resp_Location_2} # Create a rewrite rule condition. az network application-gateway rewrite-rule condition create \ --resource-group $RESOURCE_GROUP_NAME \ --gateway-name myAppGateway \ --rule-name myRewriteRule01 \ --rule-set-name myRewriteRuleSet \ --variable "http_resp_Location" \ --ignore-case true \ --negate false \ --pattern "(https?):\/\/192.168.0.6:9080(.*)$" # Create a rewrite rule 2. az network application-gateway rewrite-rule create \ --resource-group $RESOURCE_GROUP_NAME \ --gateway-name myAppGateway \ --rule-set-name myRewriteRuleSet \ --name myRewriteRule02 \ --sequence 100 \ --response-headers Location=http://${APPGATEWAY_IP}{http_resp_Location_2} # Create a rewrite rule condition. az network application-gateway rewrite-rule condition create \ --resource-group $RESOURCE_GROUP_NAME \ --gateway-name myAppGateway \ --rule-name myRewriteRule02 \ --rule-set-name myRewriteRuleSet \ --variable "http_resp_Location" \ --ignore-case true \ --negate false \ --pattern "(https?):\/\/192.168.0.7:9080(.*)$"

Теперь вы можете получить доступ к приложению с помощью URL-адреса, который создает следующая команда:

echo "http://${APPGATEWAY_IP}/snoop/"

Примечание.

В этом примере настраивается простой доступ к серверам WAS с помощью ПРОТОКОЛА HTTP. Если требуется безопасный доступ, настройте завершение TLS/SSL, следуя инструкциям, приведенным в разделе "Сквозной tls" с помощью Шлюз приложений.

В этом примере консоль IBM не предоставляется через Шлюз приложений. Для доступа к консоли IBM можно использовать компьютер myWindowsVM Windows или назначить общедоступный IP-адрес adminVM.

Если вы не хотите использовать поле myWindowsVM перехода для доступа к консоли IBM, но вы хотите предоставить его общедоступной сети, используйте следующие команды, чтобы назначить общедоступный IP-адрес adminVM:

# Create a public IP address.

az network public-ip create \

--resource-group $RESOURCE_GROUP_NAME \

--name myAdminVMPublicIPAddress \

--allocation-method Static \

--sku Standard

# Create a network security group.

az network nsg create \

--resource-group $RESOURCE_GROUP_NAME \

--name adminnsg

# Create an inbound rule for the network security group.

az network nsg rule create \

--resource-group $RESOURCE_GROUP_NAME \

--nsg-name adminnsg \

--name ALLOW_IBM_CONSOLE \

--access Allow \

--direction Inbound \

--source-address-prefixes '["*"]' \

--destination-port-ranges 9043 \

--protocol Tcp \

--priority 500

# Update the network adapter with the network security group.

az network nic update \

--resource-group $RESOURCE_GROUP_NAME \

--name adminVMVMNic \

--network-security-group adminnsg

# Update the network adapter with the public IP address.

az network nic ip-config update \

--resource-group $RESOURCE_GROUP_NAME \

--name ipconfigadminVM \

--nic-name adminVMVMNic \

--public-ip-address myAdminVMPublicIPAddress

export ADMIN_PUBLIC_IP=$(az network public-ip show \

--resource-group $RESOURCE_GROUP_NAME \

--name myAdminVMPublicIPAddress \

--query '[ipAddress]' \

--output tsv)

echo "IBM Console public URL: https://${ADMIN_PUBLIC_IP}:9043/ibm/console/"

Проверка конфигурации кластера WAS

Вы завершили настройку кластера WAS и развертывание приложения Java EE в нем. Чтобы проверить все параметры, выполните следующие действия, чтобы получить доступ к приложению:

- Откройте веб-браузер.

- Перейдите в приложение с помощью URL-адреса

http://<gateway-public-ip-address>/snoop/. - При постоянном обновлении браузера приложение циклит по экземплярам сервера. Просмотрите значение заголовка запроса узла и обратите внимание, что он изменяется после перезагрузки несколько раз.

Очистка ресурсов

Вы завершили конфигурацию кластера WAS. В следующих разделах описывается удаление созданных ресурсов.

Очистка компьютера Windows

Вы можете удалить компьютер myWindowsVM Windows с помощью следующих команд. Кроме того, вы можете завершить работу компьютера Windows и продолжать использовать его в качестве прыжка для текущих задач обслуживания кластера.

export WINDOWSVM_NIC_ID=$(az vm show \

--resource-group ${RESOURCE_GROUP_NAME} \

--name myWindowsVM \

--query networkProfile.networkInterfaces[0].id \

--output tsv)

export WINDOWSVM_NSG_ID=$(az network nic show \

--ids ${WINDOWSVM_NIC_ID} \

--query networkSecurityGroup.id \

--output tsv)

export WINDOWSVM_DISK_ID=$(az vm show \

--resource-group ${RESOURCE_GROUP_NAME} \

--name myWindowsVM \

--query storageProfile.osDisk.managedDisk.id \

--output tsv)

export WINDOWSVM_PUBLIC_IP=$(az network public-ip list \

-g ${RESOURCE_GROUP_NAME} --query [0].id \

--output tsv)

echo "deleting myWindowsVM"

az vm delete --resource-group ${RESOURCE_GROUP_NAME} --name myWindowsVM --yes

echo "deleting nic ${WINDOWSVM_NIC_ID}"

az network nic delete --ids ${WINDOWSVM_NIC_ID}

echo "deleting public-ip ${WINDOWSVM_PUBLIC_IP}"

az network public-ip delete --ids ${WINDOWSVM_PUBLIC_IP}

echo "deleting disk ${WINDOWSVM_DISK_ID}"

az disk delete --yes --ids ${WINDOWSVM_DISK_ID}

echo "deleting nsg ${WINDOWSVM_NSG_ID}"

az network nsg delete --ids ${WINDOWSVM_NSG_ID}

Очистка всех ресурсов

Удалите abc1110rg с помощью следующей команды:

az group delete --name $RESOURCE_GROUP_NAME --yes --no-wait

Следующие шаги

Сведения о возможностях запуска продуктов WebSphere в Azure см. в статье "Что такое решения для запуска семейства продуктов WebSphere в Azure?"