Примечание

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

Кластеры HDInsight Spark включают в себя записные книжки Apache Zeppelin. Используйте записные книжки для запуска заданий Apache Spark. Из этой статьи вы узнаете, как использовать записную книжку Zeppelin в кластере HDInsight.

Предварительные условия

- Кластер Apache Spark в HDInsight. Для получения инструкций см. Создание кластеров Apache Spark в Azure HDInsight.

- Схема URI для основного хранилища вашего кластера. Схема будет

wasb://для Azure Blob Storage,abfs://для Azure Data Lake Storage Gen2 илиadl://для Azure Data Lake Storage Gen1. Если для хранилища блобов включена безопасная передача, URI будет таким:wasbs://. Дополнительные сведения см. в статье Обязательное безопасное перемещение в службе хранилища Azure.

Запуск записной книжки Apache Zeppelin

В разделе Обзор кластера Spark выберите Записная книжка Zeppelin в разделе Панели мониторинга кластера. Введите учетные данные администратора для кластера.

Примечание.

Также можно открыть Zeppelin Notebook для своего кластера, открыв следующий URL-адрес в браузере. Замените CLUSTERNAME именем кластера:

https://CLUSTERNAME.azurehdinsight.net/zeppelinСоздайте новую записную книжку. На панели заголовка перейдите в раздел Записная книжка>Создать новую заметку.

Введите имя для записной книжки и щелкните Создать заметку.

Убедитесь, что в заголовке записной книжки отображается состояние "Подключено". Оно обозначается зеленой точкой в правом верхнем углу.

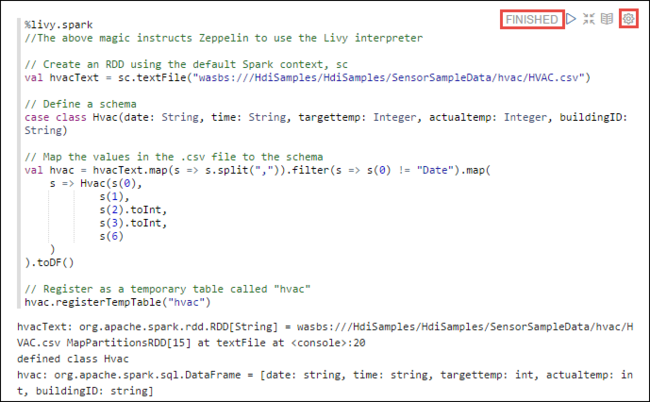

Загрузите тестовые данные во временную таблицу. При создании кластера Spark в HDInsight файл с демонстрационными данными

hvac.csvкопируется в связанную учетную запись хранения по следующему пути:\HdiSamples\SensorSampleData\hvac.В пустой абзац, созданный по умолчанию в новой записной книжке, вставьте следующий фрагмент кода.

%livy2.spark //The above magic instructs Zeppelin to use the Livy Scala interpreter // Create an RDD using the default Spark context, sc val hvacText = sc.textFile("wasbs:///HdiSamples/HdiSamples/SensorSampleData/hvac/HVAC.csv") // Define a schema case class Hvac(date: String, time: String, targettemp: Integer, actualtemp: Integer, buildingID: String) // Map the values in the .csv file to the schema val hvac = hvacText.map(s => s.split(",")).filter(s => s(0) != "Date").map( s => Hvac(s(0), s(1), s(2).toInt, s(3).toInt, s(6) ) ).toDF() // Register as a temporary table called "hvac" hvac.registerTempTable("hvac")Нажмите клавиши SHIFT + ВВОД или выберите кнопку Воспроизведение, чтобы выполнить фрагмент кода для абзаца. Состояние, которое отображается в правом верхнем углу абзаца, должно изменяться в следующей последовательности: READY (ГОТОВО), PENDING (ОЖИДАЕТ), RUNNING (ВЫПОЛНЯЕТСЯ) и FINISHED (ЗАВЕРШЕНО). Выходные данные отображаются в нижней части того же абзаца. Снимок экрана выглядит следующим образом.

Можно указать заголовок для каждого абзаца. В правом углу абзаца нажмите на значок параметров (звездочка), а затем щелкните Показать заголовок.

Примечание.

Интерпретатор %spark2 не поддерживается в записных книжках Zeppelin во всех версиях HDInsight, а интерпретатор %sh не поддерживается начиная с HDInsight 4.0.

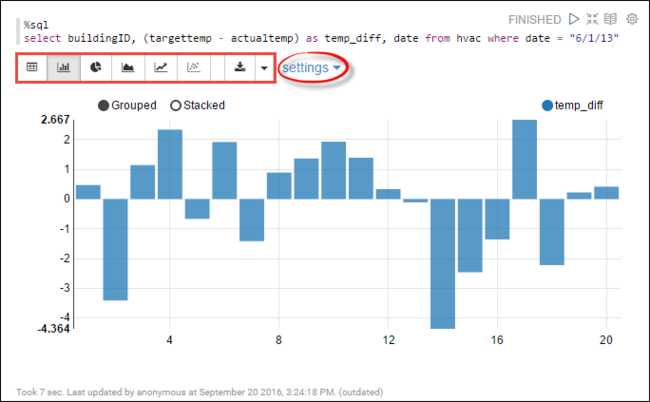

Теперь вы можете выполнить инструкции Spark SQL для таблицы

hvac. Вставьте следующий запрос в новый абзац. Запрос извлекает идентификатор здания, а также разницу между целевой и фактической температурами для каждого здания в указанный день. Нажмите SHIFT + ВВОД.%sql select buildingID, (targettemp - actualtemp) as temp_diff, date from hvac where date = "6/1/13"Инструкция %sql в начале сообщает записной книжке, что необходимо использовать интерпретатор Livy Scala.

Щелкните значок линейчатой диаграммы, чтобы изменить режим отображения. Параметры отображаются после выбора линейчатой диаграммы, что позволяет выбирать ключи и значения. Выходные данные показаны на снимке экрана ниже.

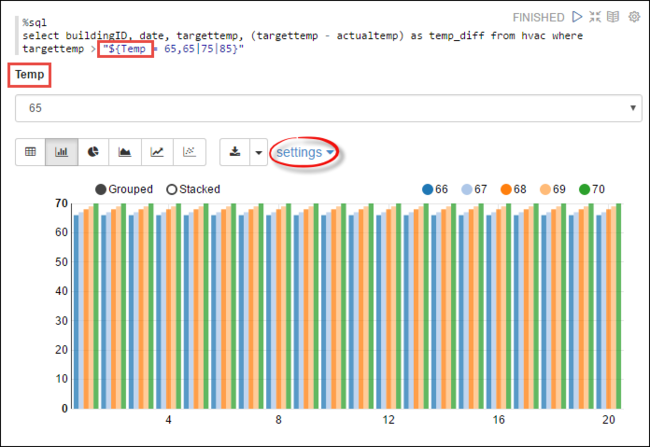

Можно также запустить инструкции Spark SQL с помощью переменных в запросе. В следующем фрагменте кода показано, как определить переменную

Tempв запросе с возможными значениями, с которыми необходимо выполнить запрос. При первом выполнении запроса раскрывающийся список автоматически заполняется значениями, указанными для переменной.%sql select buildingID, date, targettemp, (targettemp - actualtemp) as temp_diff from hvac where targettemp > "${Temp = 65,65|75|85}"Вставьте этот фрагмент кода в новый абзац и нажмите клавиши SHIFT + ВВОД. Затем выберите 65 в раскрывающемся списке Темп..

Щелкните значок линейчатой диаграммы, чтобы изменить режим отображения. Затем выберите Параметры и внесите следующие изменения.

Группы. Добавьте targettemp.

Значения: 1. Удалите date. 2. Добавьте temp_diff. 3. Измените агрегатор с SUM на AVG.

Выходные данные показаны на снимке экрана ниже.

Как использовать внешние пакеты в тетрадях?

Записная книжка Zeppelin в кластере Apache Spark в HDInsight может использовать внешние, предоставленные сообществом пакеты, которые не включены в кластер. Полный список доступных пакетов можно найти в репозитории Maven. Вы также можете получить список доступных пакетов из других источников. Например, полный список предоставленных сообществом пакетов можно найти в разделе Пакеты Spark.

В этой статье вы узнаете, как использовать пакет spark-csv с Jupyter Notebook.

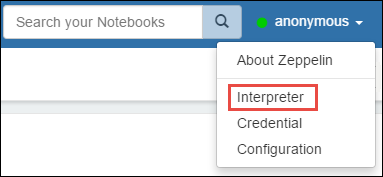

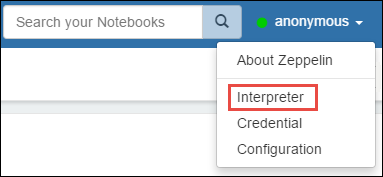

Откройте параметры интерпретатора. В правом верхнем углу щелкните имя вошедшего в систему пользователя и выберите Интерпретатор.

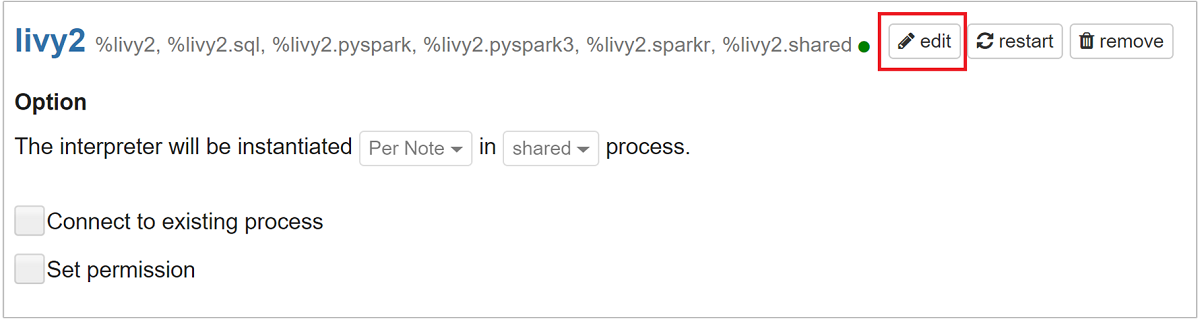

Прокрутите до livy2, а затем выберите Изменить.

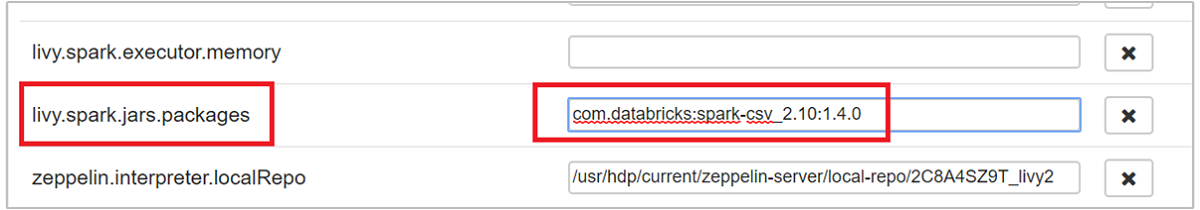

Перейдите к ключу

livy.spark.jars.packagesи задайте его значение в форматеgroup:id:version. Если вы хотите использовать пакет spark-csv, для ключа необходимо задать значениеcom.databricks:spark-csv_2.10:1.4.0.

Нажмите кнопку Сохранить, а затем OK, чтобы перезапустить интерпретатор Livy.

Если вы хотите понять, как получить значение введенного ключа, вот как это сделать.

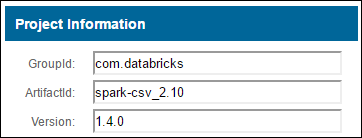

a. Найдите пакет в репозитории Maven. В этой статье мы использовали spark-csv.

b. В репозитории найдите значения для параметров GroupId, ArtifactId и Version.

c. Объедините три значения, разделив их двоеточием (:).

com.databricks:spark-csv_2.10:1.4.0

Где хранятся записные книжки Zeppelin?

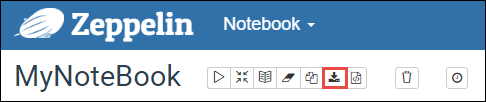

Записные книжки Zeppelin, сохраненные в головном кластере. Поэтому при удалении кластера записные книжки также будут удалены. Если вы хотите сохранить записные книжки для последующего использования в других кластерах, их необходимо экспортировать после завершения выполнения заданий. Чтобы экспортировать записную книжку, выберите значок экспорта , как показано на рисунке, как показано ниже.

Это действие сохраняет записную книжку в формате JSON в расположении загрузок по умолчанию.

Примечание.

В HDI 4.0 путь к каталогу записной книжки zeppelin имеет следующий вид:

/usr/hdp/<version>/zeppelin/notebook/<notebook_session_id>/Например, /usr/hdp/4.1.17.10/zeppelin/2JMC9BZ8X/

Однако в HDI 5.0 этот путь отличается

/usr/hdp/<version>/zeppelin/notebook/<Kernel_name>/Например, /usr/hdp/5.1.4.5/zeppelin/notebook/Scala/

Имя файла, хранящееся, отличается в HDI 5.0. Он хранится как

<notebook_name>_<sessionid>.zplnНапример, testzeppelin_2JJK53XQA.zpln

В HDI 4.0 имя файла - только note.json, и хранится он в каталоге session_id.

Например, /2JMC9BZ8X/note.json

HDI Zeppelin всегда сохраняет записную книжку по пути

/usr/hdp/<version>/zeppelin/notebook/на локальном диске hn0.Если вы хотите, чтобы записная книжка была доступна даже после удаления кластера, можно попытаться использовать хранилище файлов Azure (с помощью протокола SMB) и связать его с локальным путем. Дополнительные сведения см. в разделе "Подключение общей папки Azure SMB" в Linux

В пользовательском интерфейсе Ambari после монтирования вы можете изменить конфигурацию zeppelin.notebook.dir на смонтированный путь.

- Использование общего файлового ресурса SMB в качестве хранилища GitNotebookRepo не рекомендуется для версии zeppelin 0.10.1.

Использование Shiro для настройки доступа к интерпретаторам Zeppelin в кластерах с Корпоративным пакетом безопасности (ESP)

Как отмечалось выше, интерпретатор %sh не поддерживается в версии HDInsight 4.0 и выше. Более того, поскольку интерпретатор %sh создает потенциальные проблемы безопасности, такие как доступ к keytab-файлам с помощью команд оболочки, он также был удален из кластеров ESP HDInsight 3.6. Это означает, что интерпретатор %sh недоступен при нажатии кнопки Создать новую заметку или в пользовательском интерфейсе интерпретатора по умолчанию.

Пользователи привилегированного домена могут использовать файл Shiro.ini для управления доступом к пользовательскому интерфейсу интерпретатора. Только эти пользователи могут создавать новые интерпретаторы %sh и устанавливать разрешения для каждого нового интерпретатора %sh. Чтобы управлять доступом с помощью файла shiro.ini, выполните следующие действия.

Определите новую роль, используя существующее имя группы домена. В следующем примере

adminGroupName— группа привилегированных пользователей в идентификаторе Microsoft Entra. Не используйте в имени группы специальные символы и пробелы. Символы после=предоставляют разрешения для этой роли.*означает, что группа имеет все разрешения.[roles] adminGroupName = *Добавьте новую роль для доступа к интерпретаторам Zeppelin. В следующем примере всем пользователям в

adminGroupNameпредоставляется доступ к интерпретаторам Zeppelin, и они могут создавать новые интерпретаторы. Можно разместить несколько ролей в скобках вroles[], разделяя их запятыми. Затем пользователи, имеющие необходимые разрешения, могут получить доступ к интерпретаторам Zeppelin.[urls] /api/interpreter/** = authc, roles[adminGroupName]

Пример shiro.ini для нескольких групп доменов:

[main]

anyofrolesuser = org.apache.zeppelin.utils.AnyOfRolesUserAuthorizationFilter

[roles]

group1 = *

group2 = *

group3 = *

[urls]

/api/interpreter/** = authc, anyofrolesuser[group1, group2, group3]

Управление сеансом Livy

При выполнении первого абзаца кода в записной книжке Zeppelin в вашем кластере создается новый сеанс Livy. Сеанс будет доступен во всех записных книжках Zeppelin, которые вы создадите позже. Если по какой-либо причине сеанс Livy будет прерван, задания не будут выполняться из записной книжки Zeppelin.

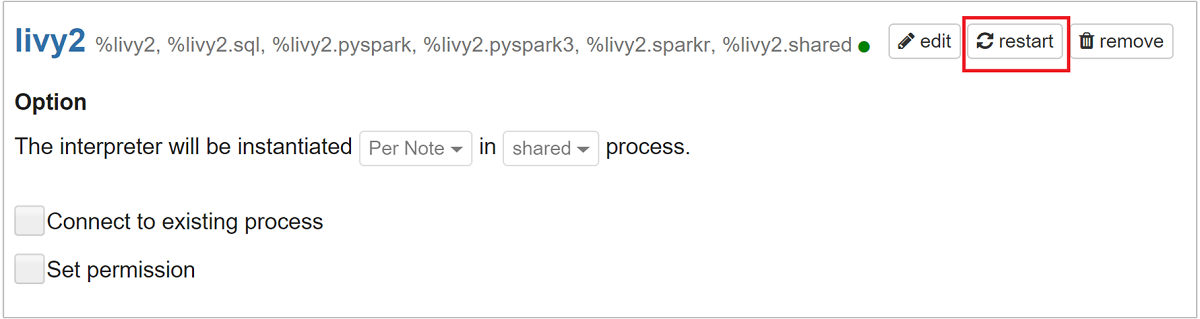

В этом случае перед началом выполнения заданий из записной книжки Zeppelin необходимо сделать следующее.

Перезапустите интерпретатор Livy через интерфейс записной книжки Zeppelin. Для этого откройте параметры интерпретатора: щелкните имя вошедшего в систему пользователя в правом верхнем углу и нажмите кнопку Интерпретатор.

Прокрутите до livy2, а затем выберите перезапустить.

Запустите кодовую ячейку из существующего блокнота Zeppelin. Этот код создает сеанс Livy в кластере HDInsight.

Общая информация

Проверка услуги

Чтобы проверить службу из Ambari, перейдите в https://CLUSTERNAME.azurehdinsight.net/#/main/services/ZEPPELIN/summary, где CLUSTERNAME — имя вашего кластера.

Чтобы проверить службу из командной строки, подключитесь к головному узлу по протоколу SSH. Переключитесь на пользователя Zeppelin с помощью команды sudo su zeppelin. Команды состояния:

| Команда | Описание |

|---|---|

/usr/hdp/current/zeppelin-server/bin/zeppelin-daemon.sh status |

Состояние службы. |

/usr/hdp/current/zeppelin-server/bin/zeppelin-daemon.sh --version |

Версия службы. |

ps -aux | grep zeppelin |

Определите PID. |

Местоположения журналов

| Услуга | Путь |

|---|---|

| сервер Zeppelin | /usr/hdp/current/zeppelin-server/ |

| Журналы сервера | /var/log/zeppelin |

Интерпретатор конфигурации, Shirosite.xml, log4j |

/usr/hdp/current/zeppelin-server/conf или /etc/zeppelin/conf |

| Каталог PID | /var/run/zeppelin |

Включение ведения журнала отладки

Перейдите по адресу

https://CLUSTERNAME.azurehdinsight.net/#/main/services/ZEPPELIN/summary, где CLUSTERNAME — это имя вашего кластера.Перейдите в раздел CONFIGS>Advanced zeppelin-log4j-properties>log4j_properties_content.

Измените

log4j.appender.dailyfile.Threshold = INFOнаlog4j.appender.dailyfile.Threshold = DEBUG.Добавьте

log4j.logger.org.apache.zeppelin.realm=DEBUG.Сохраните изменения и перезапустите службу.