Примечание.

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

Замечание

Среда выполнения Fabric 2.0 в настоящее время находится на экспериментальном этапе предварительной версии. Дополнительные сведения см. в ограничениях и заметках.

Среда выполнения Fabric обеспечивает простую интеграцию в экосистеме Microsoft Fabric, предлагая надежную среду для проектов разработки и обработки и анализа данных, управляемых Apache Spark.

В этой статье представлена экспериментальная среда выполнения Fabric 2.0 (предварительная версия), последняя среда выполнения, предназначенная для вычислений больших данных в Microsoft Fabric. Он выделяет ключевые функции и компоненты, которые делают этот выпуск значительным шагом вперед для масштабируемой аналитики и расширенных рабочих нагрузок.

Среда выполнения Fabric 2.0 включает следующие компоненты и обновления, предназначенные для улучшения возможностей обработки данных:

- Apache Spark 4.0

- Операционная система: Azure Linux 3.0 (Mariner 3.0)

- Java: 21

- Scala: 2.13

- Python: 3.12

- Delta Lake: 4.0

Включение среды выполнения 2.0

Среду выполнения 2.0 можно включить на уровне рабочей области или на уровне элемента среды. Используйте параметр рабочей области, чтобы применить среду выполнения 2.0 в качестве значения по умолчанию для всех рабочих нагрузок Spark в рабочей области. Кроме того, создайте элемент среды с версией выполнения 2.0 для использования с конкретными ноутбуками или определениями заданий Spark, которые переопределяют настройки рабочего пространства по умолчанию.

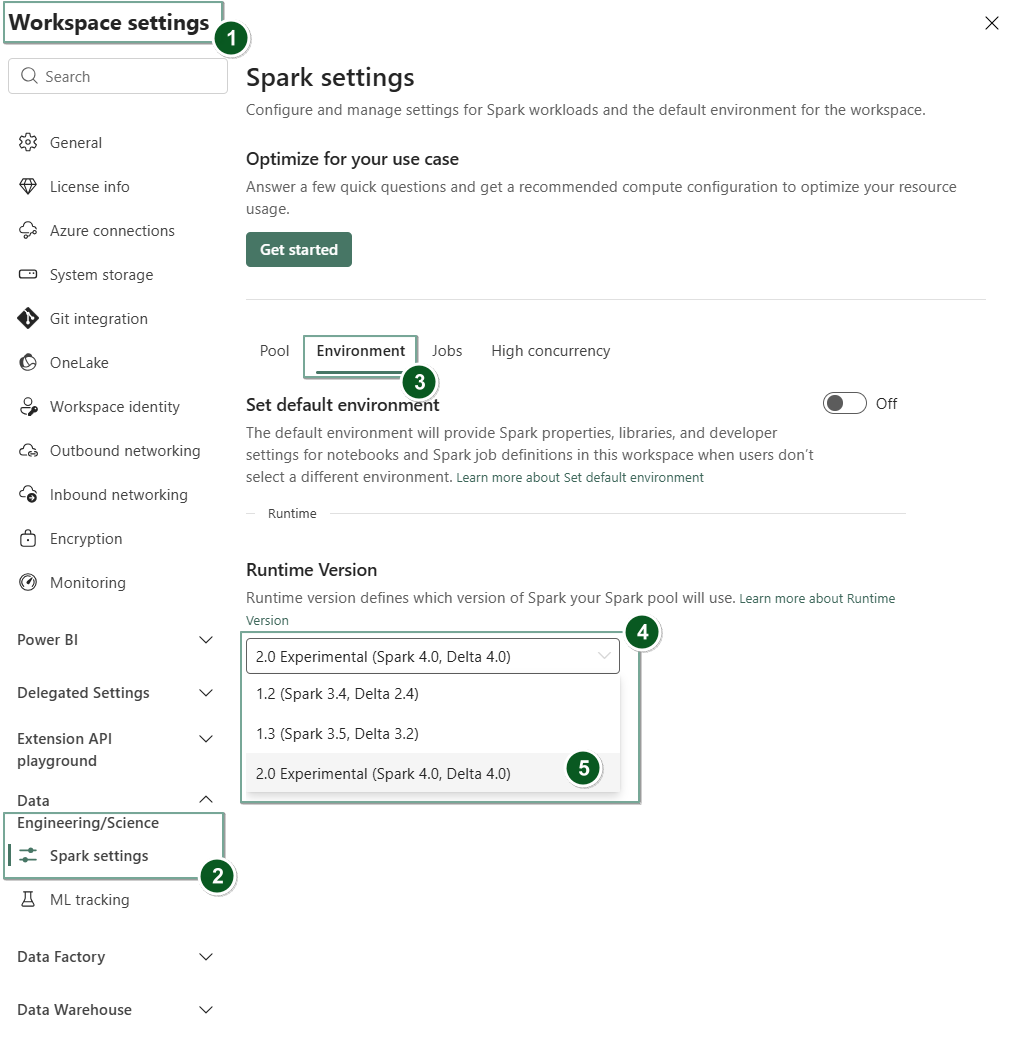

Включение среды выполнения 2.0 в параметрах рабочей области

Чтобы задать runtime 2.0 в качестве значения по умолчанию для всей рабочей области:

Перейдите на вкладку "Параметры рабочей области" в рабочей области Fabric.

Перейдите на вкладку "Инженерия и наука данных" и выберите параметры Spark.

Перейдите на вкладку Среда.

В раскрывающемся списке версии среды выполнения выберите 2.0 Экспериментальный (Spark 4.0, Delta 4.0) и сохраните изменения. Это действие задает среду выполнения 2.0 в качестве среды выполнения по умолчанию для рабочей области.

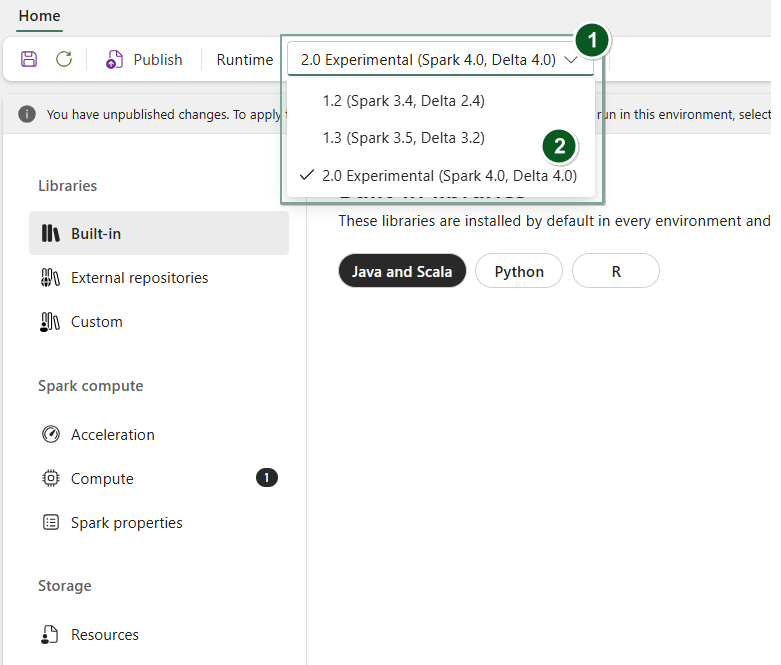

Включение среды выполнения 2.0 в элементе среды

Чтобы использовать Runtime 2.0 с определенными ноутбуками или определениями заданий Spark:

Создайте новый элемент среды или откройте и существующую.

В раскрывающемся списке среды выполнения выберите 2.0 Экспериментальный (Spark 4.0, Delta 4.0),

Saveи применитеPublishизменения.Это важно

Запуск сеансов Spark 2.0 может занять около 2–5 минут, так как начальные пулы не являются частью раннего экспериментального выпуска.

Затем вы можете использовать этот элемент среды вместе с

NotebookилиSpark Job Definition.

Теперь вы можете начать экспериментировать с новыми улучшениями и функциями, представленными в Среде выполнения Fabric 2.0 (Spark 4.0 и Delta Lake 4.0).

Экспериментальная общедоступная предварительная версия

Этап экспериментальной предварительной версии среды выполнения Fabric 2.0 предоставляет ранний доступ к новым функциям и API из Spark 4.0 и Delta Lake 4.0. Предварительная версия позволяет сразу использовать последние улучшения на основе Spark, обеспечивая плавную готовность и переход для будущих изменений, таких как новые версии Java, Scala и Python.

Подсказка

Актуальные сведения см. в подробном списке изменений и конкретных заметках о выпуске для сред выполнения Fabric, проверке и подписке на выпуски и обновления Spark Runtimes.

Ограничения и заметки

Среда выполнения Fabric 2.0 в настоящее время находится на экспериментальном этапе общедоступной предварительной версии, предназначенной для пользователей для изучения и экспериментов с новейшими функциями и API из Spark и Delta Lake в средах разработки или тестирования. Хотя эта версия предоставляет доступ к основным функциям, существуют некоторые ограничения:

Сеансы Spark 4.0 можно использовать, писать код в записных книжках, планировать определения заданий Spark и использовать с PySpark, Scala и Spark SQL. Однако язык R не поддерживается в этом раннем выпуске.

Библиотеки можно установить непосредственно в коде с помощью pip и conda. Параметры Spark можно задать с помощью опций %%configure в блокнотах и определениях заданий Spark (SJD).

Вы можете читать и записывать в Lakehouse с Delta Lake 4.0, но некоторые расширенные функции, такие как V-order, запись в формате native Parquet, автоуплотнение, оптимизированная запись, малозатратное объединение, слияние, эволюция схемы и перемещение по времени не включены в этот ранний выпуск.

Консультант по Spark в настоящее время недоступен. Однако средства мониторинга, такие как пользовательский интерфейс Spark и журналы, поддерживаются в этом раннем выпуске.

Функции, такие как интеграции с инструментами обработки данных, включая Copilot, а также соединители, такие как Kusto, SQL Analytics, Cosmos DB и MySQL Java Connector, в настоящее время не поддерживаются в этом раннем выпуске. Библиотеки обработки и анализа данных не поддерживаются в средах PySpark. PySpark работает только с базовой настройкой Conda, которая включает PySpark только без дополнительных библиотек.

Интеграция с элементами среды и Visual Studio Code не поддерживается в этом раннем выпуске.

Она не поддерживает чтение и запись данных в учетные записи хранения Azure версии 2 (GPv2) с помощью протоколов WASB или ABFS.

Замечание

Поделитесь своими отзывами о среде выполнения Fabric на платформе "Идеи". Обязательно укажите версию и этап выпуска, на который вы ссылаетесь. Мы ценим отзывы сообщества и приоритизируем улучшения на основе голосов, чтобы убедиться, что мы удовлетворяем потребности пользователей.

Ключевые моменты

Apache Spark 4.0

Apache Spark 4.0 знаменует собой важную веху как первый выпуск в серии 4.x, отражающий коллективные усилия активного сообщества с открытым исходным кодом.

В этой версии Spark SQL значительно обогащен мощными новыми функциями, предназначенными для повышения экспрессивности и универсальности рабочих нагрузок SQL, таких как поддержка типов данных VARIANT, определяемые пользователем функции SQL, переменные сеанса, синтаксис канала и параметры сортировки строк. PySpark видит постоянное развитие как в функциональных возможностях, так и в общем опыте разработчиков, предложив родной API для построения графиков, новый API источника данных Python, поддержку определяемых пользователем табличных функций (UDTF) Python и унифицированное профилирование для UDF PySpark, а также множество других улучшений. Структурированная потоковая передача развивается с помощью ключевых добавлений, которые обеспечивают больший контроль и простоту отладки, в частности введение API произвольного состояния версии 2 для более гибкого управления состоянием и источника данных состояния для упрощения отладки.

Здесь можно проверить полный список и подробные изменения https://spark.apache.org/releases/spark-release-4-0-0.html.

Замечание

В Spark 4.0 SparkR устарел и может быть удален в будущей версии.

Delta Lake 4.0

Delta Lake 4.0 отмечает коллективное обязательство обеспечить совместимость Delta Lake с различными форматами, упростить его использование и повысить производительность. Delta 4.0 — это веха, выпущенная с мощными новыми функциями, оптимизацией производительности и фундаментальными улучшениями для будущего озер данных с открытым исходным кодом.

Вы можете проверить полный список и подробные изменения, представленные в Delta Lake 3.3 и 4.0 здесь: https://github.com/delta-io/delta/releases/tag/v3.3.0 https://github.com/delta-io/delta/releases/tag/v4.0.0.

Это важно

Специальные функции Delta Lake 4.0 являются экспериментальными и работают только на интерфейсах Spark, таких как записные книжки и определения заданий Spark. Если вам нужно использовать одни и те же таблицы Delta Lake в нескольких рабочих нагрузках Microsoft Fabric, не включите эти функции. Дополнительные сведения о версиях и функциях протокола, совместимых во всех интерфейсах Microsoft Fabric, см. в статье о взаимодействии с форматом таблицы Delta Lake.

Связанный контент

- Среда выполнения Apache Spark в Fabric — обзор, управление версиями и поддержка нескольких сред выполнения

- Руководство по миграции Spark Core

- Руководства по миграции SQL, наборов данных и кадра данных

- Руководство по миграции структурированной потоковой передачи

- Руководство по миграции MLlib (Машинное обучение)

- Руководство по миграции PySpark (Python в Spark)

- Руководство по миграции SparkR (R в Spark)