Интеграция с определением заданий Spark Git

В этой статье объясняется, как работает интеграция Git для определений заданий Spark (SJD) в Microsoft Fabric. Узнайте, как настроить подключение репозитория, управлять изменениями определения задания Spark с помощью системы управления версиями и развертывать их в различных рабочих областях.

Включение интеграции Git для определений заданий Spark в Azure DevOps позволяет отслеживать изменения с помощью полной истории git. Если выбран PySpark или SparkR, основной файл определения и ссылочный файл включены в состав фиксации. Изменения исходного кода в этих файлах также отслеживаются.

Внимание

Эта функция доступна в предварительной версии.

Настройка подключения

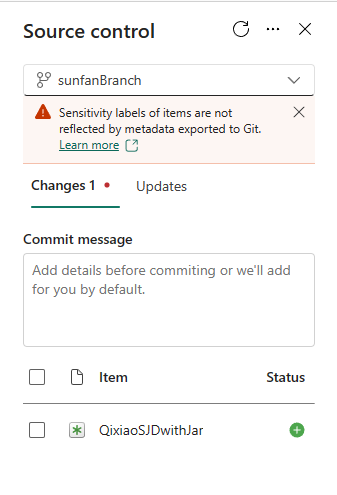

В параметрах рабочей области можно легко настроить подключение к репозиторию для фиксации и синхронизации изменений. Сведения о настройке подключения см . в статье об интеграции с Git. После подключения элементы, такие как определения заданий Spark, будут отображаться на панели управления версиями .

После фиксации определения задания Spark в репозитории Git структура папок определения задания появится в репозитории.

Представление определения задания Spark в Git

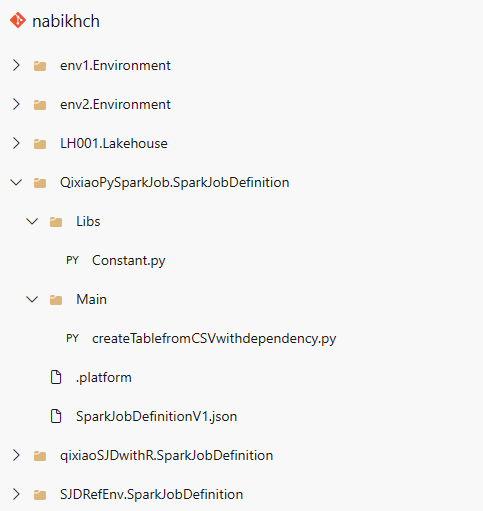

Ниже приведен пример структуры файлов каждого элемента определения задания Spark в репозитории:

При фиксации элемента определения задания Spark в репозитории создается папка git для каждого элемента и называется в соответствии с этой схемой: <имя> элемента + SparkJobDefinition. Не переименуйте папку, так как она используется для отслеживания элемента в рабочей области. Например, если имя элемента — sjd1, имя папки git будет "sjd1SparkJobDefinition".

В папке Git есть две вложенные папки. Они являются основными и эталонами. Основная папка содержит файл основного определения, а эталонная папка содержит ссылочный файл.

Помимо основных и ссылочных файлов, также есть файл SparkJobDefinitionV1.json . Он содержит метаданные для элемента определения задания Spark, поэтому не изменяйте его. Файл платформы содержит сведения о платформе , связанные с настройкой> Git, не следует также изменять.

Примечание.

- Если вы выбираете Java или Scala в качестве языка, основные и справочные файлы не будут зафиксированы при отправке в виде файла .jar.

- Присоединенная среда сохраняется в определении задания Spark после синхронизации из репозитория с рабочей областью Fabric. В настоящее время справочные среды между рабочими областями не поддерживаются. Необходимо вручную подключиться к новой среде или использовать параметры рабочей области по умолчанию для выполнения определения задания.

- Определение задания Spark сохраняет идентификатор lakehouse по умолчанию при синхронизации из репозитория с рабочей областью Fabric. Если зафиксировать записную книжку с помощью lakehouse по умолчанию, вам потребуется вручную ссылаться на только что созданный элемент Lakehouse. Дополнительные сведения см. в статье об интеграции с Lakehouse Git.