Transformera data genom att köra en Synapse Spark-jobbdefinition

GÄLLER FÖR:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dricks

Prova Data Factory i Microsoft Fabric, en allt-i-ett-analyslösning för företag. Microsoft Fabric omfattar allt från dataflytt till datavetenskap, realtidsanalys, business intelligence och rapportering. Lär dig hur du startar en ny utvärderingsversion kostnadsfritt!

Azure Synapse Spark-jobbdefinitionsaktiviteten i en pipeline kör en Synapse Spark-jobbdefinition på din Azure Synapse Analytics-arbetsyta. Den här artikeln bygger på artikeln om datatransformeringsaktiviteter , som visar en allmän översikt över datatransformering och de omvandlingsaktiviteter som stöds.

Ange Arbetsyta för Apache Spark-jobbdefinition

Utför följande steg för att använda en Spark-jobbdefinitionsaktivitet för Synapse i en pipeline:

Allmänna inställningar

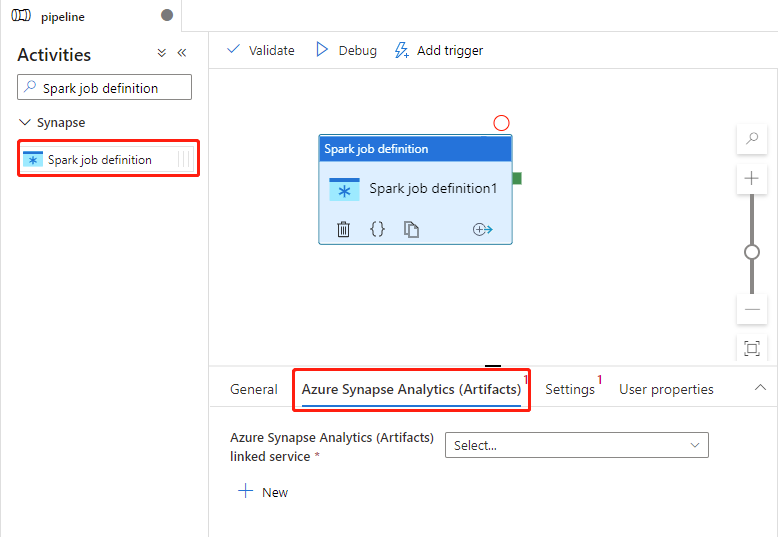

Sök efter Spark-jobbdefinition i fönstret PipelineAktiviteter och dra en Aktivitet för Spark-jobbdefinition under Synapse till pipelinearbetsytan.

Välj den nya Spark-jobbdefinitionsaktiviteten på arbetsytan om den inte redan är markerad.

På fliken Allmänt anger du exempel för Namn.

(Alternativ) Du kan också ange en beskrivning.

Tidsgräns: Maximal tid som en aktivitet kan köras. Standardvärdet är sju dagar, vilket också är den maximala tillåtna tiden. Formatet finns i D.HH:MM:SS.

Försök igen: Maximalt antal återförsök.

Återförsöksintervall: Antalet sekunder mellan varje återförsök.

Säkra utdata: När den är markerad registreras inte utdata från aktiviteten i loggningen.

Säkra indata: När den är markerad registreras inte indata från aktiviteten i loggningen.

Azure Synapse Analytics-inställningar (artefakter)

Välj den nya Spark-jobbdefinitionsaktiviteten på arbetsytan om den inte redan är markerad.

Välj fliken Azure Synapse Analytics (Artifacts) för att välja eller skapa en ny länkad Azure Synapse Analytics-tjänst som ska köra spark-jobbdefinitionsaktiviteten.

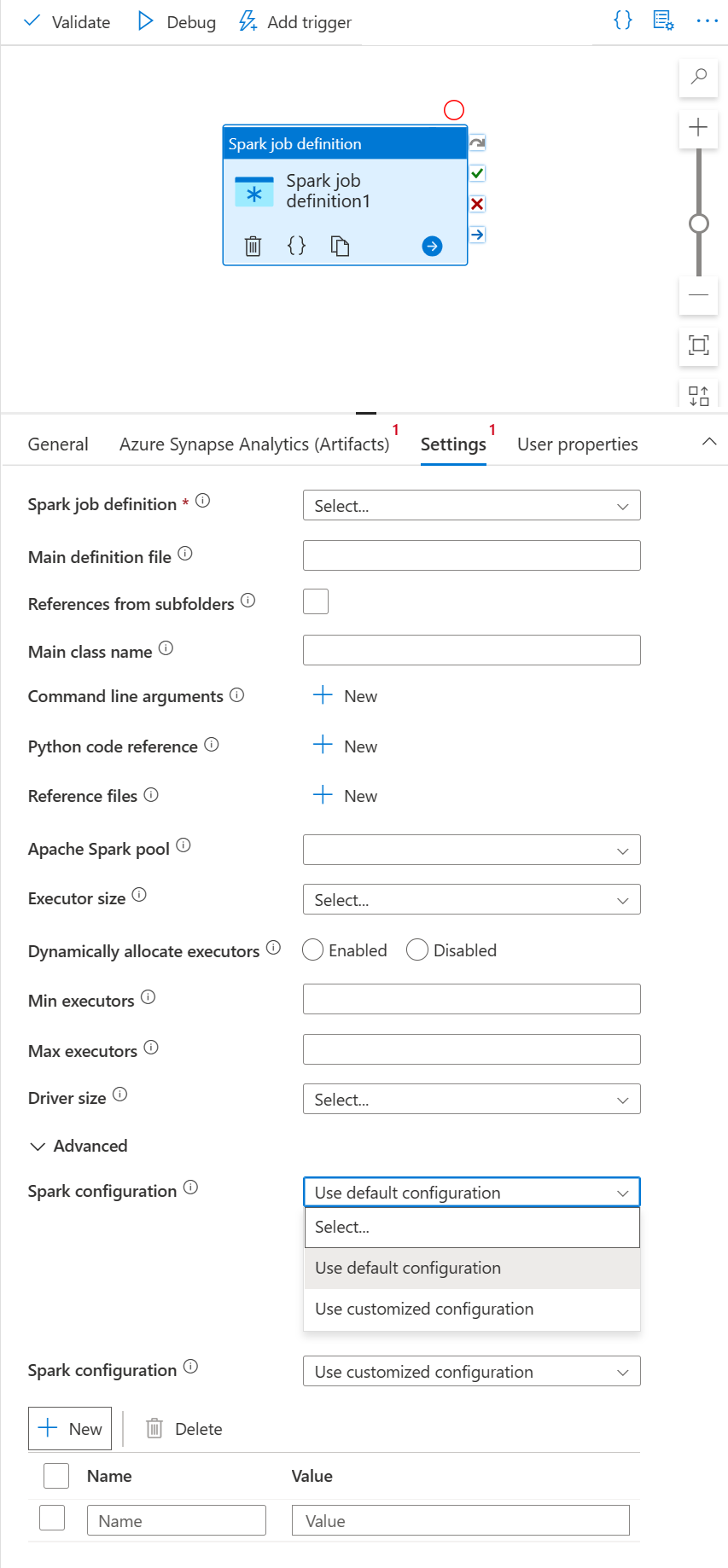

Fliken Inställningar

Välj den nya Spark-jobbdefinitionsaktiviteten på arbetsytan om den inte redan är markerad.

Välj fliken Inställningar.

Expandera listan med Spark-jobbdefinitioner. Du kan välja en befintlig Apache Spark-jobbdefinition på den länkade Azure Synapse Analytics-arbetsytan.

(Valfritt) Du kan fylla i information för Apache Spark-jobbdefinitionen. Om följande inställningar är tomma används inställningarna för själva spark-jobbdefinitionen för att köras. Om följande inställningar inte är tomma ersätter de här inställningarna själva inställningarna för spark-jobbdefinitionen.

Property beskrivning Huvuddefinitionsfil Huvudfilen som används för jobbet. Välj en PY/JAR/ZIP-fil från lagringen. Du kan välja Ladda upp fil för att ladda upp filen till ett lagringskonto.

Exempel:abfss://…/path/to/wordcount.jarReferenser från undermappar Genom att skanna undermappar från rotmappen i huvuddefinitionsfilen läggs dessa filer till som referensfiler. Mapparna med namnet "jars", "pyFiles", "files" eller "archives" genomsöks och mappnamnet är skiftlägeskänsligt. Huvudklassnamn Den fullständigt kvalificerade identifieraren eller huvudklassen som finns i huvuddefinitionsfilen.

Exempel:WordCountKommandoradsargument Du kan lägga till kommandoradsargument genom att klicka på knappen Nytt . Observera att om du lägger till kommandoradsargument åsidosätts de kommandoradsargument som definieras av Spark-jobbdefinitionen.

Prov:abfss://…/path/to/shakespeare.txtabfss://…/path/to/resultApache Spark-pool Du kan välja Apache Spark-pool i listan. Python-kodreferens Ytterligare Python-kodfiler som används som referens i huvuddefinitionsfilen.

Den stöder överföring av filer (.py, .py3, .zip) till egenskapen "pyFiles". Den åsidosätter egenskapen "pyFiles" som definierats i Spark-jobbdefinitionen.Referensfiler Ytterligare filer som används som referens i huvuddefinitionsfilen. Apache Spark-pool Du kan välja Apache Spark-pool i listan. Dynamiskt allokera köre Den här inställningen mappar till den dynamiska allokeringsegenskapen i Spark-konfigurationen för Spark Application Executors-allokering. Minsta körbara filer Minsta antal utförare som ska allokeras i den angivna Spark-poolen för jobbet. Maximalt antal körbara filer Maximalt antal utförare som ska allokeras i den angivna Spark-poolen för jobbet. Drivrutinsstorlek Antal kärnor och minne som ska användas för drivrutinen som anges i den angivna Apache Spark-poolen för jobbet. Apache Spark-konfiguration Ange värden för Spark-konfigurationsegenskaper som anges i avsnittet: Spark-konfiguration – Programegenskaper. Användare kan använda standardkonfiguration och anpassad konfiguration.

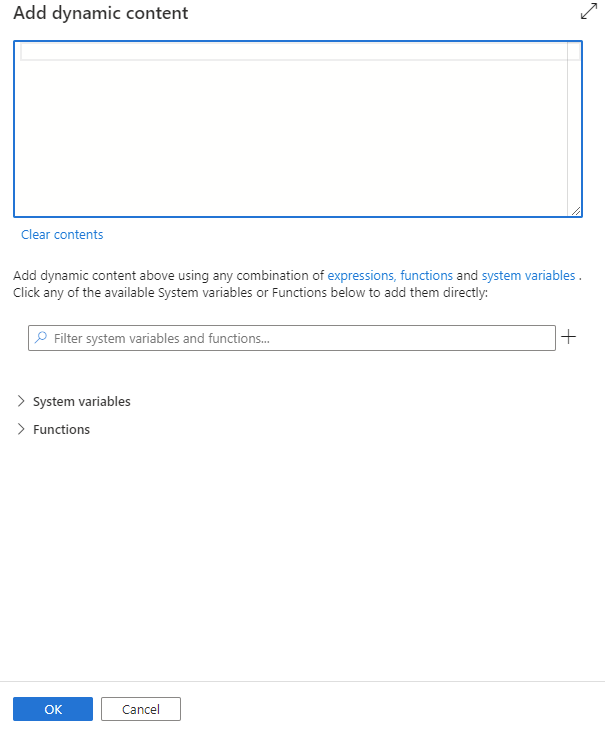

Du kan lägga till dynamiskt innehåll genom att klicka på knappen Lägg till dynamiskt innehåll eller genom att trycka på kortkommandot Alt+Shift+D. På sidan Lägg till dynamiskt innehåll kan du använda valfri kombination av uttryck, funktioner och systemvariabler för att lägga till dynamiskt innehåll.

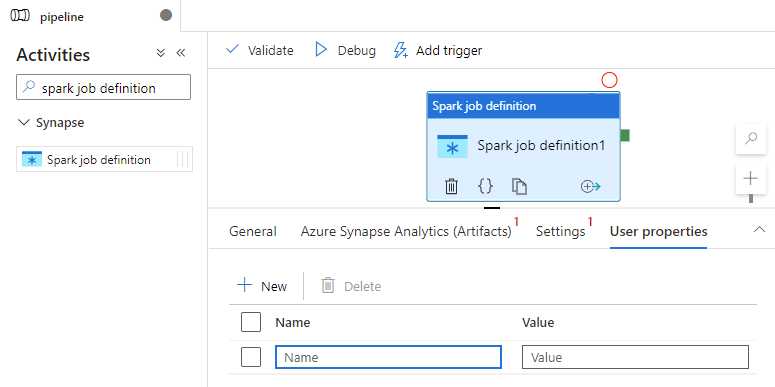

Fliken Användaregenskaper

Du kan lägga till egenskaper för Apache Spark-jobbdefinitionsaktivitet i den här panelen.

Aktivitetsdefinition för Azure Synapse spark-jobb

Här är JSON-exempeldefinitionen för en Azure Synapse Analytics Notebook-aktivitet:

{

"activities": [

{

"name": "Spark job definition1",

"type": "SparkJob",

"dependsOn": [],

"policy": {

"timeout": "7.00:00:00",

"retry": 0,

"retryIntervalInSeconds": 30,

"secureOutput": false,

"secureInput": false

},

"typeProperties": {

"sparkJob": {

"referenceName": {

"value": "Spark job definition 1",

"type": "Expression"

},

"type": "SparkJobDefinitionReference"

}

},

"linkedServiceName": {

"referenceName": "AzureSynapseArtifacts1",

"type": "LinkedServiceReference"

}

}

],

}

Egenskaper för Azure Synapse Spark-jobbdefinition

I följande tabell beskrivs de JSON-egenskaper som används i JSON-definitionen:

| Property | Beskrivning | Obligatoriskt |

|---|---|---|

| name | Namnet på aktiviteten i pipelinen. | Ja |

| description | Text som beskriver vad aktiviteten gör. | Nej |

| type | För Azure Synapse Spark-jobbdefinitionsaktivitet är aktivitetstypen SparkJob. | Ja |

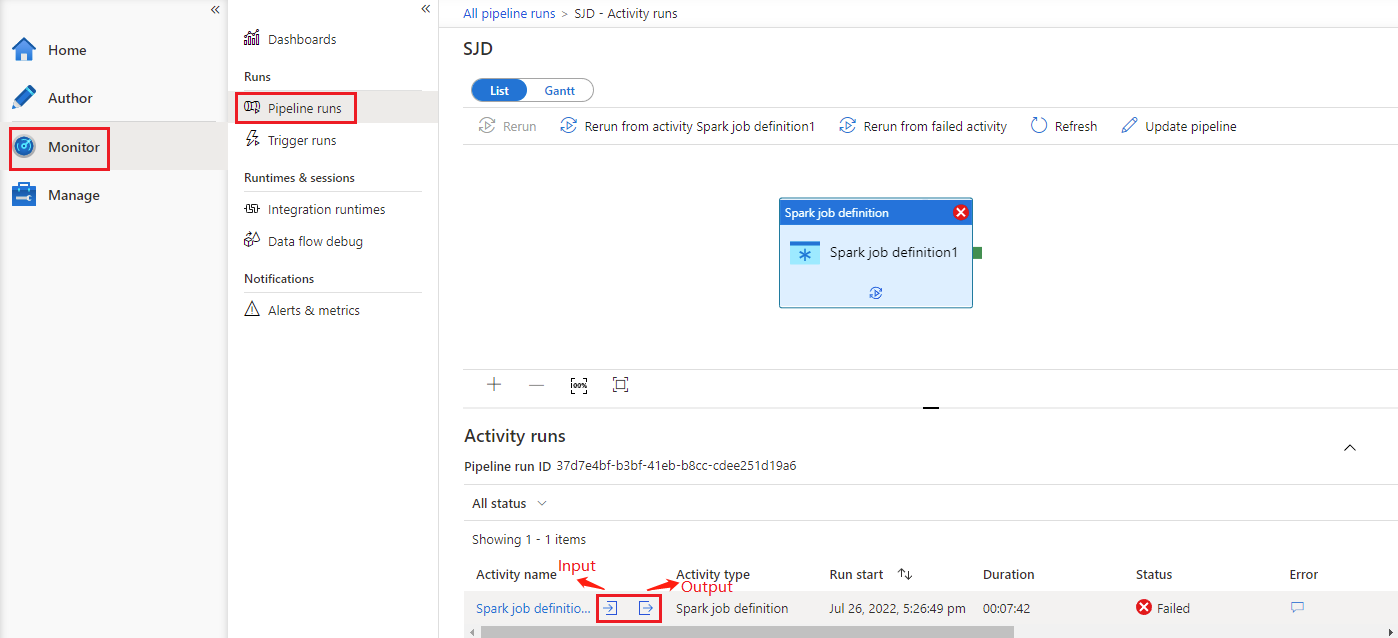

Se Körningshistorik för Azure Synapse Spark-jobbdefinition

Gå till Pipelinekörningar under fliken Övervaka . Du ser den pipeline som du har utlöst. Öppna pipelinen som innehåller Azure Synapse Spark-jobbdefinitionsaktiviteten för att se körningshistoriken.

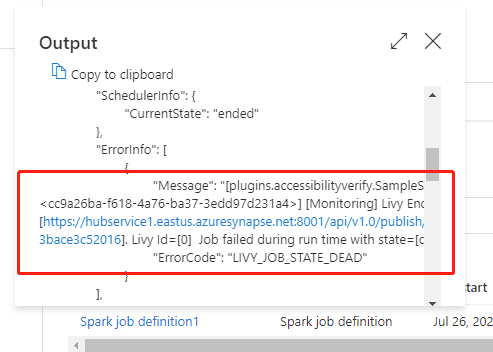

Du kan se in- eller utdata för notebook-aktiviteten genom att välja indata- eller utdataknappen. Om pipelinen misslyckades med ett användarfel markerar du utdata för att kontrollera resultatfältet för att se den detaljerade spårningen av användarfel.

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för