Kör en Databricks Notebook med Databricks Notebook-aktiviteten i Azure Data Factory

GÄLLER FÖR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dricks

Prova Data Factory i Microsoft Fabric, en allt-i-ett-analyslösning för företag. Microsoft Fabric omfattar allt från dataflytt till datavetenskap, realtidsanalys, business intelligence och rapportering. Lär dig hur du startar en ny utvärderingsversion kostnadsfritt!

I den här självstudien använder du Azure Portal för att skapa en Azure Data Factory-pipeline som kör en Databricks Notebook mot Databricks-jobbklustret. Den skickar även Azure Data Factory-parametrar till Databricks Notebook under körning.

I de här självstudierna går du igenom följande steg:

Skapa en datafabrik.

Skapa en pipeline som använder en Databricks Notebook-aktivitet.

Utlös en pipelinekörning.

Övervaka pipelinekörningen.

Om du inte har någon Azure-prenumeration skapar du ett kostnadsfritt konto innan du börjar.

Om du vill se en introduktion och demonstration av den här funktionen rekommenderar vi följande videoklipp (11 minuter):

Förutsättningar

- Azure Databricks-arbetsyta. Skapa en ny Azure Databricks-arbetsyta eller använd en befintlig. Du skapar en Python Notebook i Azure Databricks-arbetsytan. Sedan kör du denna notebook och skickar parametrar till den med hjälp av Azure Data Factory.

Skapa en datafabrik

Starta webbläsaren Microsoft Edge eller Google Chrome. Just nu är det bara webbläsarna Microsoft Edge och Google Chrome som har stöd för Data Factory UI.

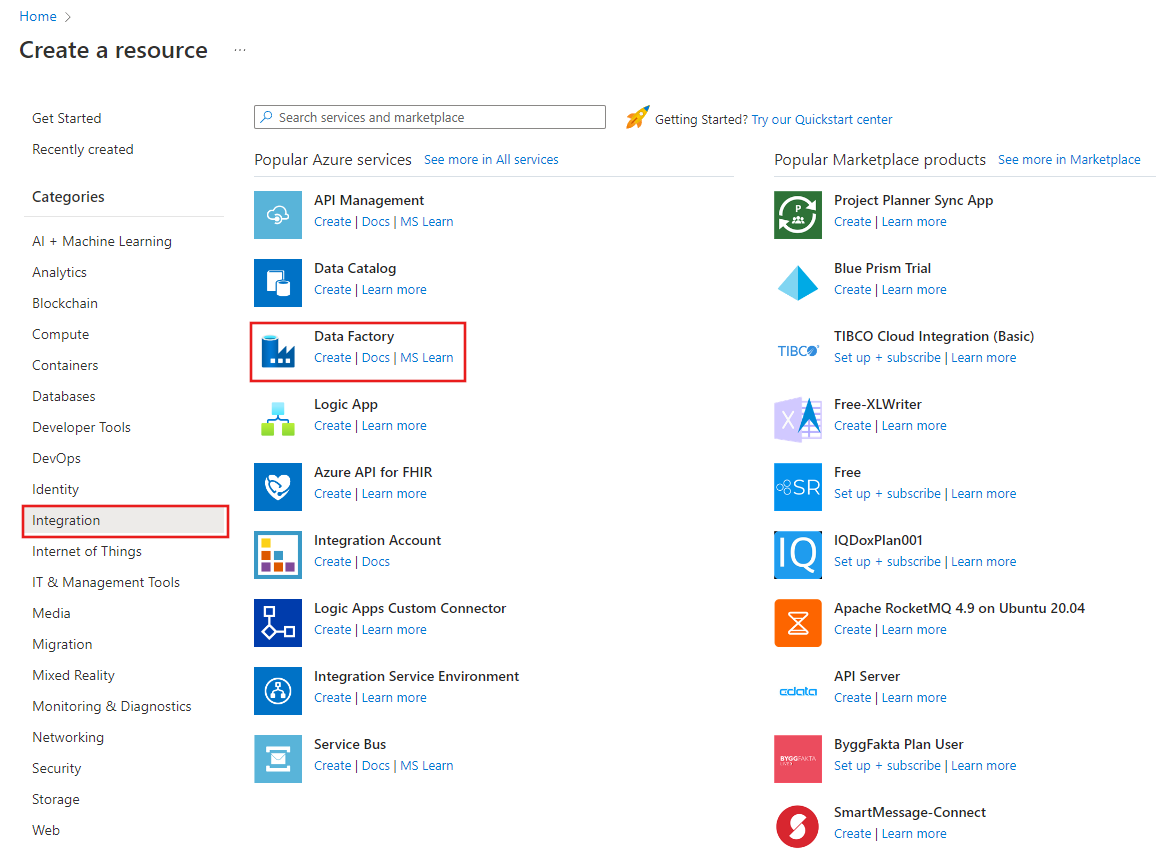

Välj Skapa en resurs på menyn Azure Portal, välj Integrering och välj sedan Data Factory.

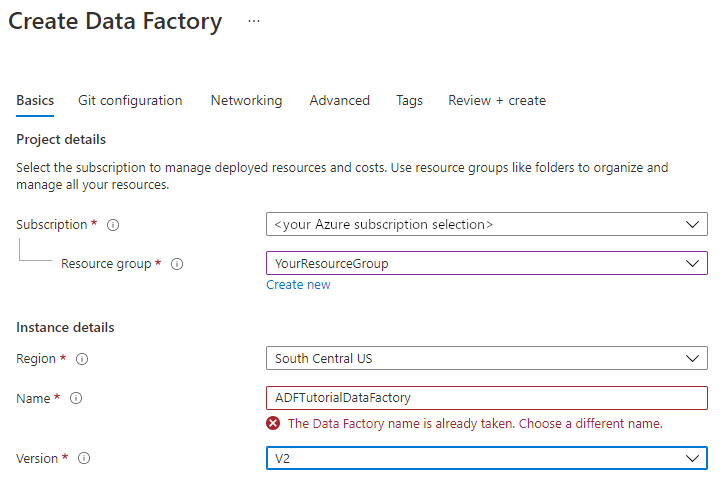

På sidan Skapa datafabrik går du till fliken Grundläggande och väljer din Azure-prenumerationdär du vill skapa datafabriken.

Gör något av följande för Resursgrupp:

Välj en befintlig resursgrupp i listrutan.

Välj Skapa ny och ange namnet på en ny resursgrupp.

Mer information om resursgrupper finns i Använda resursgrupper till att hantera Azure-resurser.

För Region väljer du platsen för datafabriken.

I listan visas endast platser som Data Factory har stöd för och var dina Azure Data Factory-metadata kommer att lagras. De associerade datalager (till exempel Azure Storage och Azure SQL Database) och beräkningar (som Azure HDInsight) som Data Factory använder kan köras i andra regioner.

Som Namn anger du ADFTutorialDataFactory.

Namnet på Azure Data Factory måste vara globalt unikt. Om du ser följande fel ändrar du namnet på datafabriken (använd <till exempel ditt namn>ADFTutorialDataFactory). Namngivningsregler för Data Factory-artefakter finns i artikeln Data Factory – namnregler.

För Version väljer du V2.

Välj Nästa: Git-konfiguration och markera sedan kryssrutan Konfigurera Git senare.

Välj Granska + skapa och välj Skapa när valideringen har godkänts.

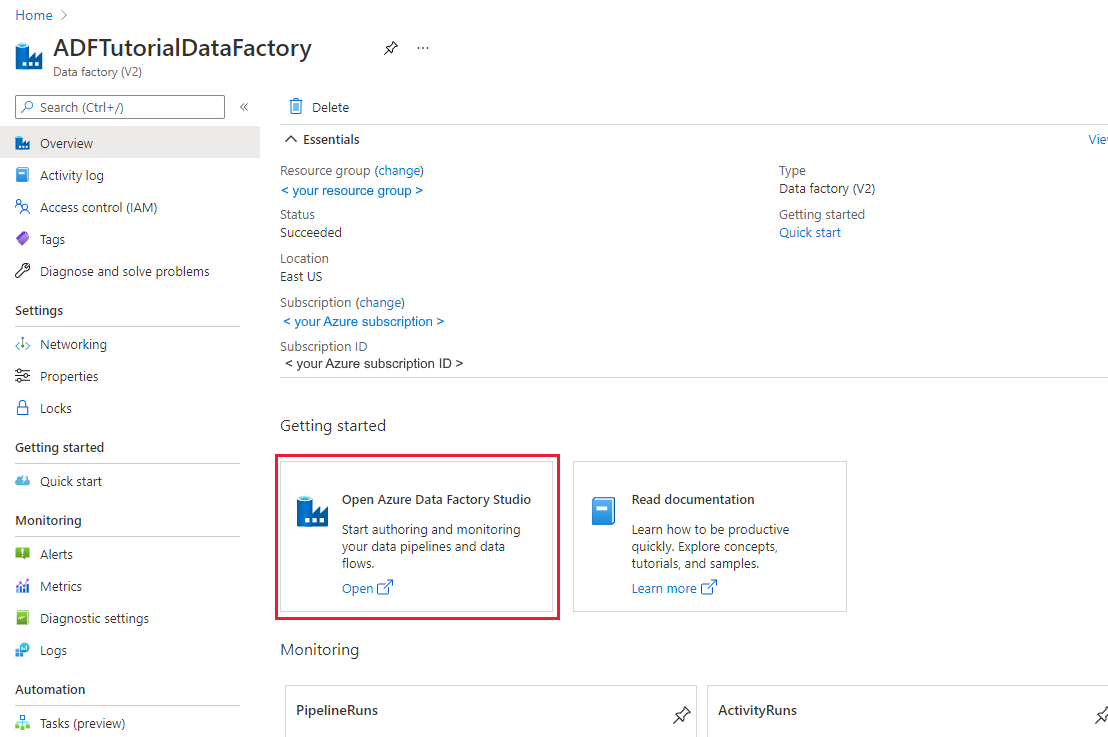

När skapandet är klart väljer du Gå till resurs för att navigera till sidan Data Factory . Välj panelen Öppna Azure Data Factory Studio för att starta azure Data Factory-användargränssnittsprogrammet (UI) på en separat webbläsarflik.

Skapa länkade tjänster

I det här avsnittet skapar du en Databricks-länkad tjänst. Den här länkade tjänsten innehåller anslutningsinformation till Databricks-klustret:

Skapa en länkad Azure Databricks-tjänst

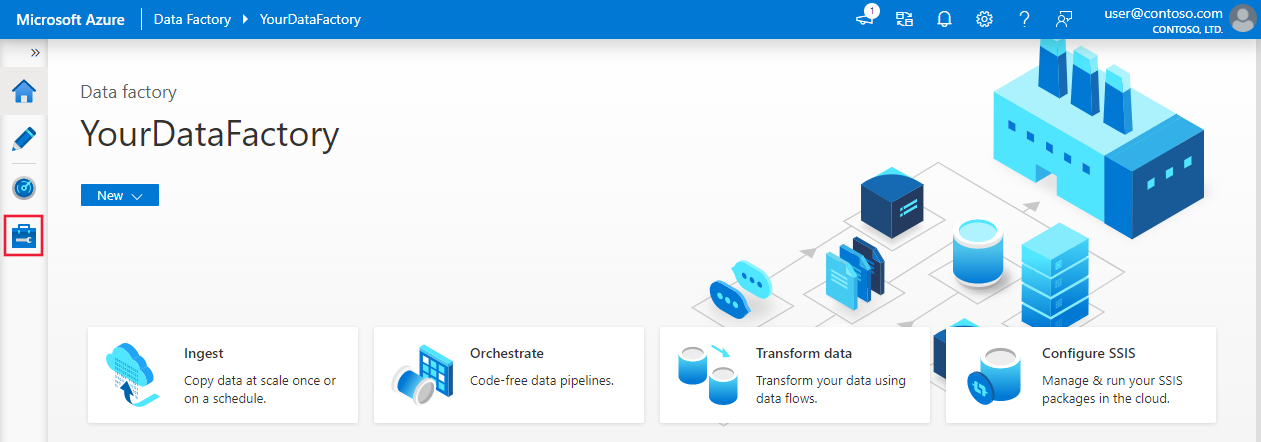

På startsidan växlar du till fliken Hantera i den vänstra panelen.

Välj Länkade tjänster under Anslutningar och välj sedan + Ny.

I fönstret Ny länkad tjänst väljer du Beräkna>Azure Databricks och väljer sedan Fortsätt.

Slutför följande steg i fönstret Ny länkad tjänst :

Som Namn anger du AzureDatabricks_LinkedService.

Välj lämplig Databricks-arbetsyta som du ska köra anteckningsboken i.

För Välj kluster väljer du Nytt jobbkluster.

För Databricks-arbetsytans URL bör informationen fyllas i automatiskt.

Om du väljer Åtkomsttoken för autentiseringstyp genererar du den från Azure Databricks arbetsplats. Du hittar anvisningar här. För hanterad tjänstidentitet och användartilldelad hanterad identitet beviljar du deltagarrollen till båda identiteterna i Azure Databricks-resursens åtkomstkontrollmeny .

För Klusterversion väljer du den version som du vill använda.

För Klusternodtyp väljer du Standard_D3_v2 under kategorin Generell användning (HDD) för den här självstudien.

För Arbetare anger du 2.

Välj Skapa.

Skapa en pipeline

Välj knappen + (plus) och sedan Pipeline från menyn.

Skapa en parameter som ska användas i pipelinen. Senare kan du skicka den här parametern till Databricks Notebook-aktiviteten. I den tomma pipelinen väljer du fliken Parametrar och väljer sedan + Ny och namnger den som "namn".

Gå till verktygsfältet Aktiviteter och expandera Databricks. Dra aktiviteten Notebook från verktygsfältet Aktiviteter till pipelinedesignytan.

I egenskaperna för aktivitetsfönstret DatabricksNotebook längst ned utför du följande steg:

Växla till fliken Azure Databricks.

Välj AzureDatabricks_LinkedService (som du skapade i föregående procedur).

Växla till fliken Settings (Inställningar).

Bläddra och välj en Databricks Notebook-sökväg. Nu ska vi skapa en notebook och ange sökvägen här. Du kan hämta Notebook-sökvägen genom att följa de kommande stegen.

Starta din Azure Databricks-arbetsyta.

Skapa en Ny mapp i arbetsplatsen och ge den namnet adftutorial.

Skapa en ny anteckningsbok, låt oss kalla den mynotebook. Högerklicka på mappen adftutorial och välj Skapa.

I din nyligen skapade notebook, ”mynotebook”, lägger du till följande kod:

# Creating widgets for leveraging parameters, and printing the parameters dbutils.widgets.text("input", "","") y = dbutils.widgets.get("input") print ("Param -\'input':") print (y)Notebook-sökvägen i det här fallet är /adftutorial/mynotebook.

Växla tillbaka till redigeringsverktyget för Data Factory-användargränssnittet. Gå till fliken Inställningar under aktiviteten Notebook1 .

a. Lägg till en parameter i notebook-aktiviteten. Du använder samma parameter som du lade till tidigare i Pipeline.

b. Namnge parametern som indata och ange värdet som uttryck @pipeline().parameters.name.

Verifiera pipelinen genom att välja knappen Verifiera i verktygsfältet. Stäng valideringsfönstret genom att välja knappen Stäng .

Markera Publicera alla. Data Factory-gränssnittet publicerar entiteter (länkade tjänster och pipelines) till Azure Data Factory-tjänsten.

Utlös en pipelinekörning

Välj Lägg till utlösare i verktygsfältet och välj sedan Utlösare nu.

Dialogrutan Pipelinekörning frågar efter namnparametern. Använd /path/filename som den här parametern. Välj OK.

Övervaka pipelinekörningen

Växla till fliken Övervaka . Bekräfta att du ser en pipelinekörning. Det tar cirka 5–8 minuter att skapa ett Databricks-jobbkluster där en notebook körs.

Klicka på Uppdatera då och då så att du ser pipelinekörningens status.

Om du vill se aktivitetskörningar som är associerade med pipelinekörningen väljer du pipeline1-länk i kolumnen Pipelinenamn .

På sidan Aktivitetskörningar väljer du Utdata i kolumnen Aktivitetsnamn för att visa utdata för varje aktivitet. Du hittar länken till Databricks-loggar i fönstret Utdata för mer detaljerade Spark-loggar.

Du kan växla tillbaka till pipelinekörningsvyn genom att välja länken Alla pipelinekörningar i menyn breadcrumb längst upp.

Verifiera utdata

Du kan logga in på Azure Databricks-arbetsytan, gå till Jobbkörningar och du kan se jobbstatusensom väntande körning, körning eller avslutad.

Du kan välja jobbnamnet och navigera för att se mer information. Om körningen lyckas kan du validera parametrarna som skickats samt utdata för en Python Notebook.

Sammanfattning

Pipelinen i det här exemplet utlöser en Databricks Notebook-aktivitet och skickar en parameter till den. Du har lärt dig att:

Skapa en datafabrik.

Skapa en pipeline som använder en Databricks Notebook-aktivitet.

Utlös en pipelinekörning.

Övervaka pipelinekörningen.