Installera och köra containrar med anpassad namngiven entitetsigenkänning

Med containrar kan du vara värd för API:et för anpassad namngiven entitetsigenkänning i din egen infrastruktur med hjälp av din egen tränade modell. Om du har säkerhets- eller datastyrningskrav som inte kan uppfyllas genom fjärranrop av anpassad namngiven entitetsigenkänning kan containrar vara ett bra alternativ.

Kommentar

- Det kostnadsfria kontot är begränsat till 5 000 textposter per månad och endast prisnivåerna Kostnadsfri och Standard är giltiga för containrar. Mer information om priser för transaktionsbegäran finns i Data- och tjänstgränser.

Förutsättningar

- Om du inte har någon Azure-prenumeration kan du skapa ett kostnadsfritt konto.

- Docker installerat på en värddator. Docker måste konfigureras så att containrarna kan ansluta till och skicka faktureringsdata till Azure.

- I Windows måste Docker också konfigureras för att stödja Linux-containrar.

- Du bör ha en grundläggande förståelse för Docker-begrepp.

- En språkresurs med den kostnadsfria prisnivån (F0) eller standard (S).

- En tränad och distribuerad anpassad namngiven entitetsigenkänningsmodell

Samla in obligatoriska parametrar

Tre primära parametrar för alla Azure AI-containrar krävs. Licensvillkoren för Programvara från Microsoft måste finnas med värdet accept. En slutpunkts-URI och API-nyckel behövs också.

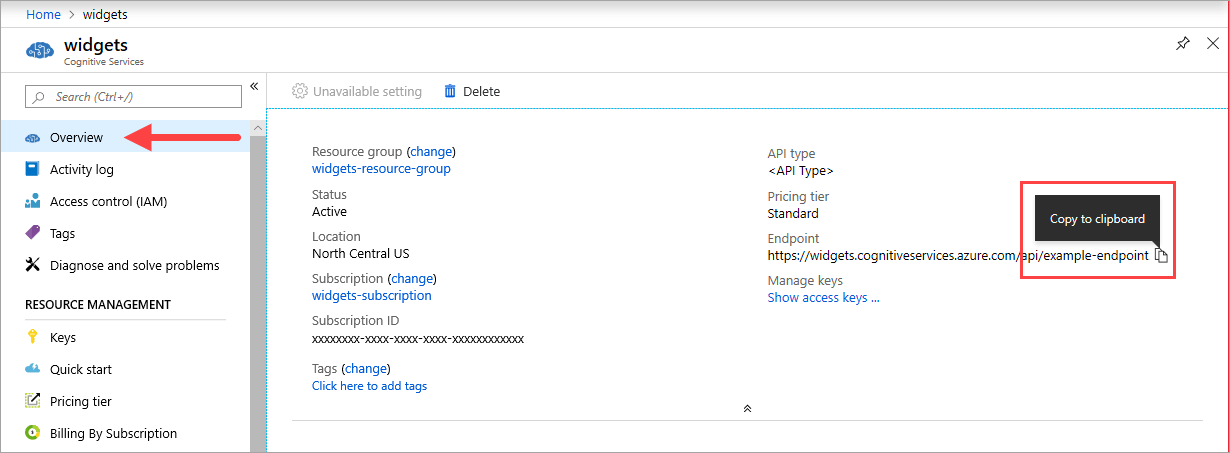

Slutpunkts-URI

Värdet {ENDPOINT_URI} är tillgängligt på översiktssidan för Azure-portalen för motsvarande Azure AI-tjänstresurs. Gå till sidan Översikt , hovra över slutpunkten och ikonen Kopiera till Urklipp visas. Kopiera och använd slutpunkten där det behövs.

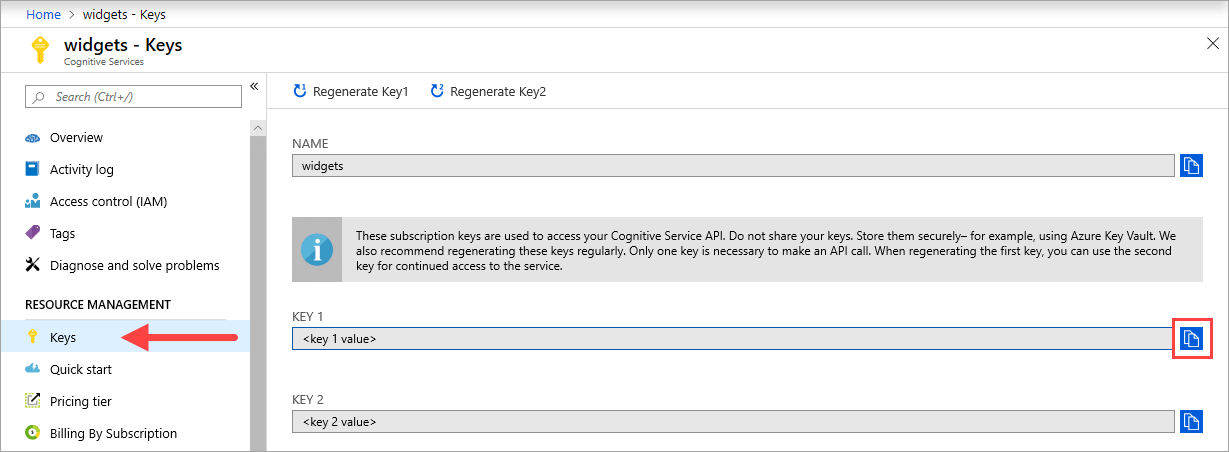

Nycklar

Värdet {API_KEY} används för att starta containern och är tillgängligt på sidan Nycklar i Azure-portalen för motsvarande Azure AI-tjänstresurs. Gå till sidan Nycklar och välj ikonen Kopiera till Urklipp.

Viktigt!

Dessa prenumerationsnycklar används för att komma åt ditt Azure AI-tjänst-API. Dela inte dina nycklar. Lagra dem på ett säkert sätt. Använd till exempel Azure Key Vault. Vi rekommenderar också att du återskapar dessa nycklar regelbundet. Endast en nyckel krävs för att göra ett API-anrop. När du återskapar den första nyckeln kan du använda den andra nyckeln för fortsatt åtkomst till tjänsten.

Krav och rekommendationer för värddatorer

Värden är en x64-baserad dator som kör Docker-containern. Det kan vara en dator lokalt eller en Docker-värdtjänst i Azure, till exempel:

- Azure Kubernetes Service.

- Azure Container Instances.

- Ett Kubernetes-kluster som distribuerats till Azure Stack. Mer information finns i Distribuera Kubernetes till Azure Stack.

I följande tabell beskrivs de lägsta och rekommenderade specifikationerna för containrar med anpassad namngiven entitetsigenkänning. Varje CPU-kärna måste vara minst 2,6 gigahertz (GHz) eller snabbare. De tillåtna transaktionerna per sekund (TPS) visas också.

| Minsta värdspecifikation | Rekommenderade värdspecifikationer | Minsta TPS | MaximalT TPS | |

|---|---|---|---|---|

| Anpassad namngiven entitetsigenkänning | 1 kärna, 2 GB minne | 1 kärna, 4 GB minne | 15 | 30 |

CPU-kärna och minne motsvarar --cpus inställningarna och --memory som används som en del av docker run kommandot.

Exportera din modell för anpassad namngiven entitetsigenkänning

Innan du fortsätter med att köra docker-avbildningen måste du exportera din egen tränade modell för att exponera den för containern. Använd följande kommando för att extrahera din modell och ersätta platshållarna nedan med dina egna värden:

| Platshållare | Värde | Format eller exempel |

|---|---|---|

| {API_KEY} | Nyckeln för din resurs för anpassad namngiven entitetsigenkänning. Du hittar den på resursens nyckel- och slutpunktssida i Azure-portalen. | xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx |

| {ENDPOINT_URI} | Slutpunkten för åtkomst till API:et för anpassad namngiven entitetsigenkänning. Du hittar den på resursens nyckel- och slutpunktssida i Azure-portalen. | https://<your-custom-subdomain>.cognitiveservices.azure.com |

| {PROJECT_NAME} | Namnet på projektet som innehåller den modell som du vill exportera. Du hittar den på fliken Projekt i Language Studio-portalen. | myProject |

| {TRAINED_MODEL_NAME} | Namnet på den tränade modell som du vill exportera. Du hittar dina tränade modeller på fliken modellutvärdering under projektet i Language Studio-portalen. | myTrainedModel |

curl --location --request PUT '{ENDPOINT_URI}/language/authoring/analyze-text/projects/{PROJECT_NAME}/exported-models/{TRAINED_MODEL_NAME}?api-version=2023-04-15-preview' \

--header 'Ocp-Apim-Subscription-Key: {API_KEY}' \

--header 'Content-Type: application/json' \

--data-raw '{

"TrainedmodelLabel": "{TRAINED_MODEL_NAME}"

}'

Hämta containeravbildningen med docker pull

Containeravbildningen Anpassad namngiven entitetsigenkänning finns i mcr.microsoft.com containerregistersyndikatet. Den finns på lagringsplatsen azure-cognitive-services/textanalytics/ och heter customner. Det fullständigt kvalificerade containeravbildningsnamnet är , mcr.microsoft.com/azure-cognitive-services/textanalytics/customner.

Om du vill använda den senaste versionen av containern kan du använda taggen latest . Du hittar också en fullständig lista över taggar på MCR.

docker pull Använd kommandot för att ladda ned en containeravbildning från Microsoft Container Registry.

docker pull mcr.microsoft.com/azure-cognitive-services/textanalytics/customner:latest

Dricks

Du kan använda kommandot docker images för att visa en lista över dina nedladdade containeravbildningar. Följande kommando visar till exempel ID, lagringsplats och tagg för varje nedladdad containeravbildning, formaterad som en tabell:

docker images --format "table {{.ID}}\t{{.Repository}}\t{{.Tag}}"

IMAGE ID REPOSITORY TAG

<image-id> <repository-path/name> <tag-name>

Kör containern med docker run

När containern finns på värddatorn använder du kommandot docker run för att köra containrarna. Containern fortsätter att köras tills du stoppar den.

Viktigt!

- Docker-kommandona i följande avsnitt använder snedstrecket,

\, som ett radfortsättningstecken. Ersätt eller ta bort detta baserat på värdoperativsystemets krav. - Alternativen

Eula,BillingochApiKeymåste anges för att köra containern. Annars startar inte containern. Mer information finns i Fakturering.

Kör följande docker run kommando för att köra containern Anpassad namngiven entitetsigenkänning. Ersätt platshållarna nedan med dina egna värden:

| Platshållare | Värde | Format eller exempel |

|---|---|---|

| {API_KEY} | Nyckeln för din resurs för anpassad namngiven entitetsigenkänning. Du hittar den på resursens nyckel- och slutpunktssida i Azure-portalen. | xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx |

| {ENDPOINT_URI} | Slutpunkten för åtkomst till API:et för anpassad namngiven entitetsigenkänning. Du hittar den på resursens nyckel- och slutpunktssida i Azure-portalen. | https://<your-custom-subdomain>.cognitiveservices.azure.com |

| {PROJECT_NAME} | Namnet på projektet som innehåller den modell som du vill exportera. Du hittar den på fliken Projekt i Language Studio-portalen. | myProject |

| {LOCAL_PATH} | Sökvägen där den exporterade modellen i föregående steg laddas ned. Du kan välja vilken sökväg du vill. | C:/custom-ner-model |

| {TRAINED_MODEL_NAME} | Namnet på den tränade modell som du vill exportera. Du hittar dina tränade modeller på fliken modellutvärdering under projektet i Language Studio-portalen. | myTrainedModel |

docker run --rm -it -p5000:5000 --memory 4g --cpus 1 \

-v {LOCAL_PATH}:/modelPath \

mcr.microsoft.com/azure-cognitive-services/textanalytics/customner:latest \

EULA=accept \

BILLING={ENDPOINT_URI} \

APIKEY={API_KEY} \

projectName={PROJECT_NAME}

exportedModelName={TRAINED_MODEL_NAME}

Det här kommandot:

- Kör en container med anpassad namngiven entitetsigenkänning och laddar ned den exporterade modellen till den angivna lokala sökvägen.

- Allokerar en CPU-kärna och 4 GB minne

- Exponerar TCP-port 5000 och allokerar en pseudo-TTY för containern

- Tar automatiskt bort containern när den har avslutats. Containeravbildningen är fortfarande tillgänglig på värddatorn.

Köra flera containrar på samma värd

Om du tänker köra flera containrar med exponerade portar ska du köra varje container med en annan exponerad port. Kör till exempel den första containern på port 5000 och den andra containern på port 5001.

Du kan ha den här containern och en annan Azure AI-tjänstcontainer som körs på VÄRDEN tillsammans. Du kan också ha flera containrar av samma Azure AI-tjänstcontainer som körs.

Köra frågor mot containerns förutsägelseslutpunkt

Containern innehåller REST-baserade slutpunkts-API:er för frågeförutsägelse.

Använd värden, http://localhost:5000, för container-API:er.

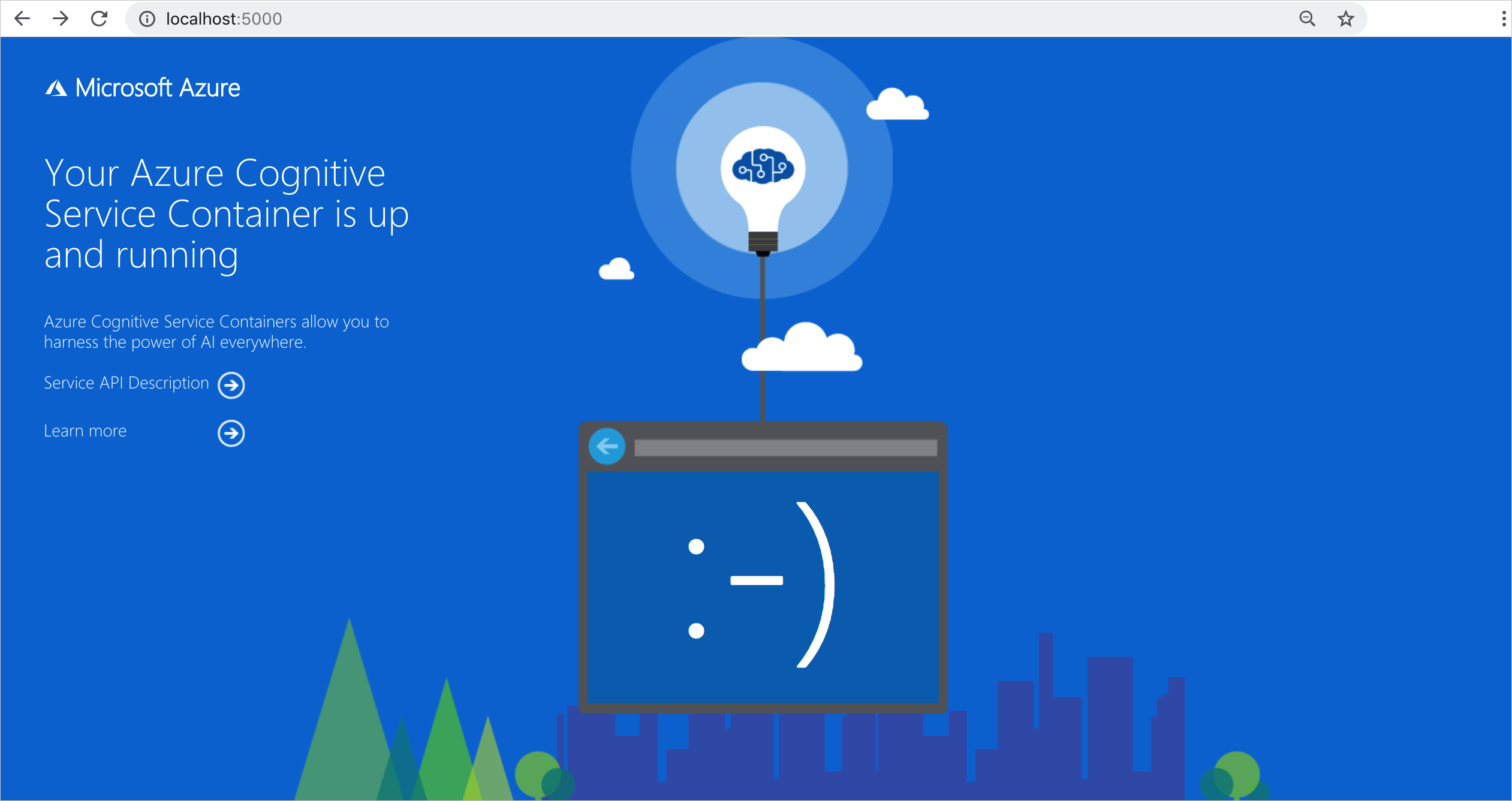

Verifiera att en container körs

Det finns flera sätt att verifiera att containern körs. Leta upp den externa IP-adressen och den exponerade porten för containern i fråga och öppna din favoritwebbläsare. Använd de olika url:er för begäranden som följer för att verifiera att containern körs. Exempelbegärande-URL:er som anges här är http://localhost:5000, men din specifika container kan variera. Se till att förlita dig på containerns externa IP-adress och exponerade port.

| Begärans-URL | Syfte |

|---|---|

http://localhost:5000/ |

Containern tillhandahåller en startsida. |

http://localhost:5000/ready |

Den här URL:en begärs med GET och tillhandahåller en verifiering av att containern är redo att acceptera en fråga mot modellen. Den här begäran kan användas för Kubernetes liveness- och beredskapsavsökningar. |

http://localhost:5000/status |

Den här URL:en begärs också med GET och kontrollerar om api-nyckeln som används för att starta containern är giltig utan att orsaka en slutpunktsfråga. Den här begäran kan användas för Kubernetes liveness- och beredskapsavsökningar. |

http://localhost:5000/swagger |

Containern tillhandahåller en fullständig uppsättning dokumentation för slutpunkterna samt en Prova-funktion. Med den här funktionen kan du ange inställningarna i ett webbaserat HTML-formulär och göra frågan utan att behöva skriva någon kod. När frågan har returnerats tillhandahålls ett exempel på CURL-kommandot för att demonstrera de HTTP-huvuden och brödtextformat som krävs. |

Stoppa containern

Om du vill stänga av containern väljer du Ctrl+C i den kommandoradsmiljö där containern körs.

Felsökning

Om du kör containern med en utdatamontering och loggning aktiverad genererar containern loggfiler som är användbara för att felsöka problem som inträffar när containern startas eller körs.

Dricks

Mer felsökningsinformation och vägledning finns i Vanliga frågor och svar om Azure AI-containrar.

Fakturering

Containrar med anpassad namngiven entitetsigenkänning skickar faktureringsinformation till Azure med hjälp av en resurs för anpassad namngiven entitetsigenkänning på ditt Azure-konto.

Frågor till containern faktureras på prisnivån för den Azure-resurs som används för parametern ApiKey .

Azure AI-tjänstcontainrar är inte licensierade att köras utan att vara anslutna till slutpunkten för mätning eller fakturering. Du måste aktivera containrarna för att kunna kommunicera faktureringsinformation med faktureringsslutpunkten hela tiden. Azure AI-tjänstcontainrar skickar inte kunddata, till exempel den bild eller text som analyseras, till Microsoft.

Ansluta till Azure

Containern behöver faktureringsargumentvärdena för att köras. Med de här värdena kan containern ansluta till faktureringsslutpunkten. Containern rapporterar användning var 10:e till 15:e minut. Om containern inte ansluter till Azure inom den tillåtna tidsperioden fortsätter containern att köras men hanterar inte frågor förrän faktureringsslutpunkten har återställts. Anslutningen görs 10 gånger med samma tidsintervall på 10 till 15 minuter. Om den inte kan ansluta till faktureringsslutpunkten inom de 10 försöken slutar containern att hantera begäranden. Se vanliga frågor och svar om Azure AI-tjänstcontainern för ett exempel på den information som skickas till Microsoft för fakturering.

Faktureringsargument

Kommandot docker run startar containern när alla tre av följande alternativ har giltiga värden:

| Alternativ | Description |

|---|---|

ApiKey |

API-nyckeln för azure AI-tjänstresursen som används för att spåra faktureringsinformation. Värdet för det här alternativet måste anges till en API-nyckel för den etablerade resursen som anges i Billing. |

Billing |

Slutpunkten för azure AI-tjänstresursen som används för att spåra faktureringsinformation. Värdet för det här alternativet måste anges till slutpunkts-URI:n för en etablerad Azure-resurs. |

Eula |

Anger att du har godkänt licensen för containern. Värdet för det här alternativet måste vara inställt på att acceptera. |

Sammanfattning

I den här artikeln har du lärt dig begrepp och arbetsflöden för att ladda ned, installera och köra containrar med anpassad namngiven entitetsigenkänning. Sammanfattningsvis:

- Anpassad namngiven entitetsigenkänning tillhandahåller Linux-containrar för Docker.

- Containeravbildningar laddas ned från Microsoft Container Registry (MCR).

- Containeravbildningar körs i Docker.

- Du kan använda REST API eller SDK för att anropa åtgärder i containrar för anpassad namngiven entitetsigenkänning genom att ange värd-URI:n för containern.

- Du måste ange faktureringsinformation när du instansierar en container.

Viktigt!

Azure AI-containrar är inte licensierade att köras utan att vara anslutna till Azure för mätning. Kunder måste göra det möjligt för containrarna att kommunicera faktureringsinformation med mätningstjänsten hela tiden. Azure AI-containrar skickar inte kunddata (t.ex. text som analyseras) till Microsoft.

Nästa steg

- Se Konfigurera containrar för konfigurationsinställningar.

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för