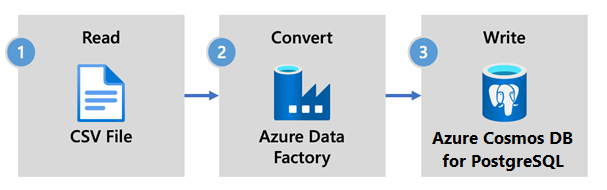

Så här matar du in data med hjälp av Azure Data Factory i Azure Cosmos DB for PostgreSQL

GÄLLER FÖR: Azure Cosmos DB for PostgreSQL (drivs av Citus-databastillägget till PostgreSQL)

Azure Data Factory är en molnbaserad ETL - och dataintegreringstjänst. Det gör att du kan skapa datadrivna arbetsflöden för att flytta och transformera data i stor skala.

Med Data Factory kan du skapa och schemalägga datadrivna arbetsflöden (kallas pipelines) som matar in data från olika datalager. Pipelines kan köras lokalt, i Azure eller på andra molnleverantörer för analys och rapportering.

Data Factory har en datamottagare för Azure Cosmos DB for PostgreSQL. Med datamottagaren kan du ta med dina data (relationsfiler, NoSQL- och data lake-filer) till Azure Cosmos DB för PostgreSQL-tabeller för lagring, bearbetning och rapportering.

Viktigt!

Data Factory stöder för närvarande inte privata slutpunkter för Azure Cosmos DB for PostgreSQL.

Data Factory för inmatning i realtid

Här är viktiga skäl att välja Azure Data Factory för att mata in data i Azure Cosmos DB för PostgreSQL:

- Lätt att använda – Erbjuder en kodfri visuell miljö för orkestrering och automatisering av dataflytt.

- Kraftfull – använder den fullständiga kapaciteten för underliggande nätverksbandbredd, upp till 5 GiB/s-dataflöde.

- Inbyggda anslutningsappar – Integrerar alla dina datakällor med fler än 90 inbyggda anslutningsappar.

- Kostnadseffektiv – Har stöd för en fullständigt hanterad serverlös molntjänst som skalar efter behov.

Steg för att använda Data Factory

I den här artikeln skapar du en datapipeline med hjälp av Användargränssnittet för Data Factory. Pipelinen i den här datafabriken kopierar data från Azure Blob Storage till en databas. En lista över datakällor som stöds som källor och mottagare finns i tabellen över datalager som stöds.

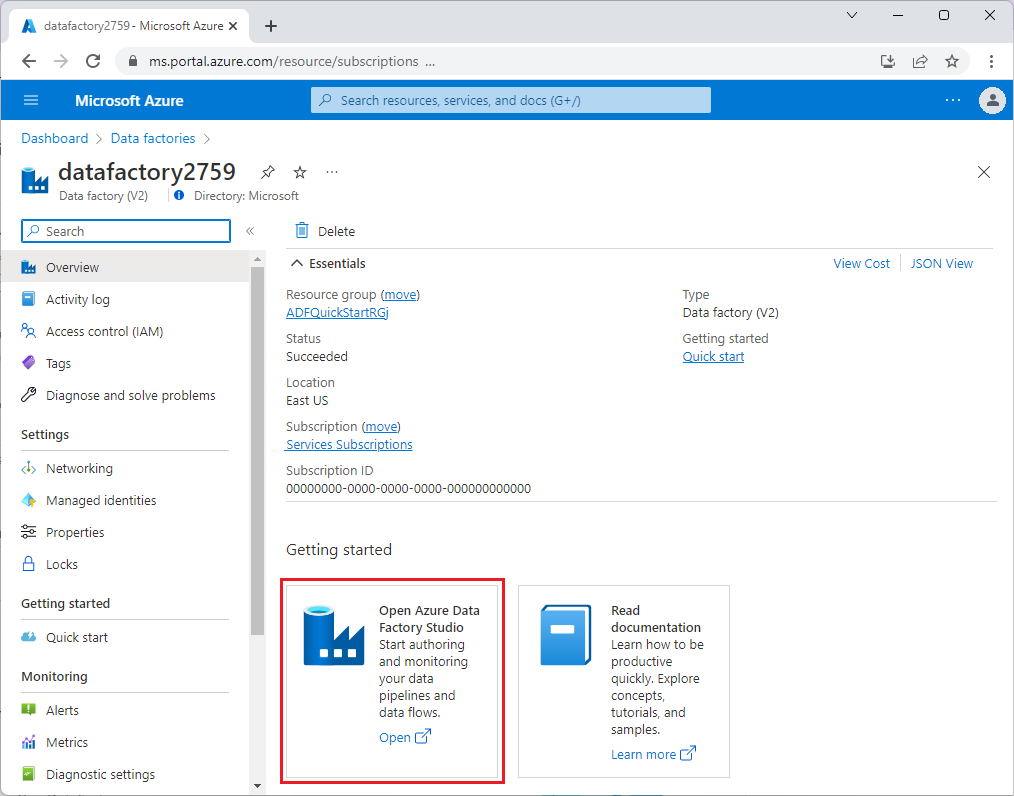

I Data Factory kan du använda aktiviteten Kopiera för att kopiera data mellan datalager som finns lokalt och i molnet till Azure Cosmos DB for PostgreSQL. Om du inte har använt Data Factory tidigare finns här en snabbguide om hur du kommer igång:

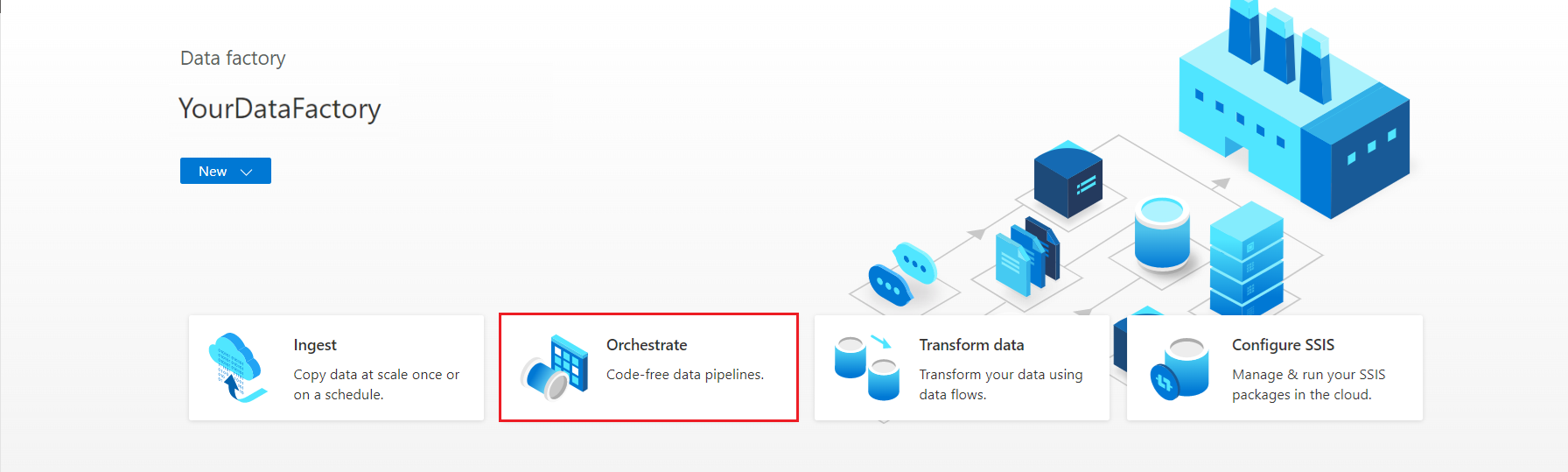

När Data Factory har etablerats går du till din datafabrik och startar Azure Data Factory Studio. Du ser startsidan för Data Factory enligt följande bild:

På startsidan för Azure Data Factory Studio väljer du Orchestrate.

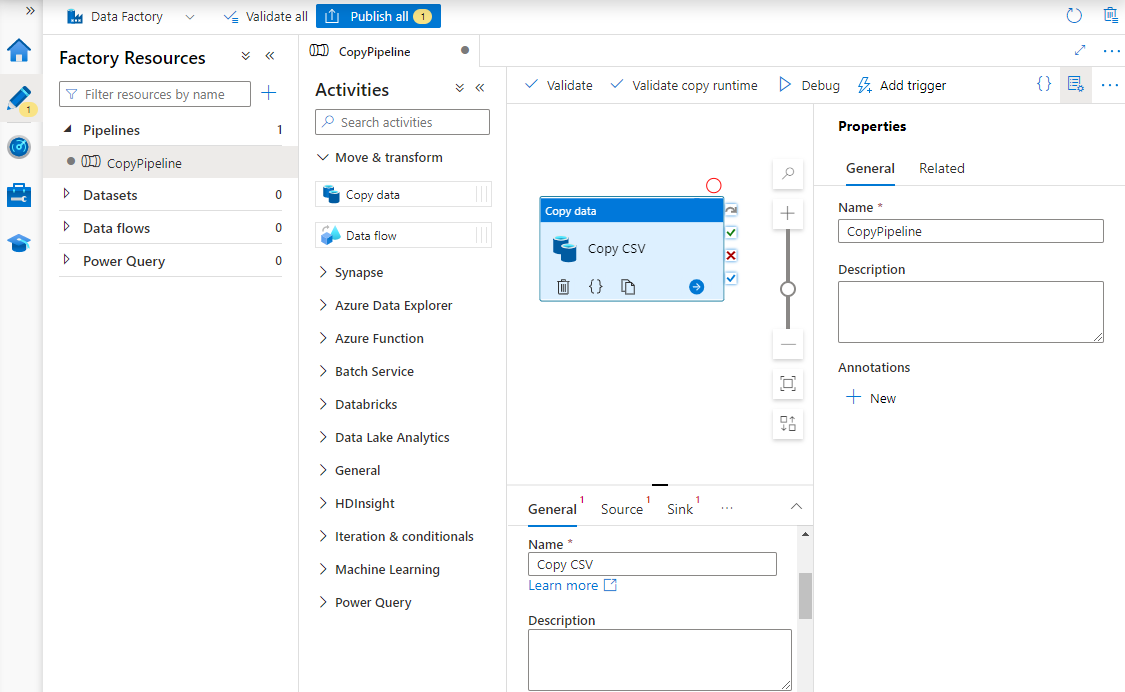

Under Egenskaper anger du ett namn för pipelinen.

I verktygslådan Aktiviteter expanderar du kategorin Flytta och transformera och drar och släpper aktiviteten Kopiera data till pipelinedesignerns yta. Längst ned i designerfönstret går du till fliken Allmänt och anger ett namn för kopieringsaktiviteten.

Konfigurera källa.

På sidan Aktiviteter väljer du fliken Källa. Välj Ny om du vill skapa en källdatauppsättning.

I dialogrutan Ny datauppsättning väljer du Azure Blob Storage och sedan Fortsätt.

Välj formattypen för dina data och välj sedan Fortsätt.

På sidan Ange egenskaper går du till Länkad tjänst och väljer Ny.

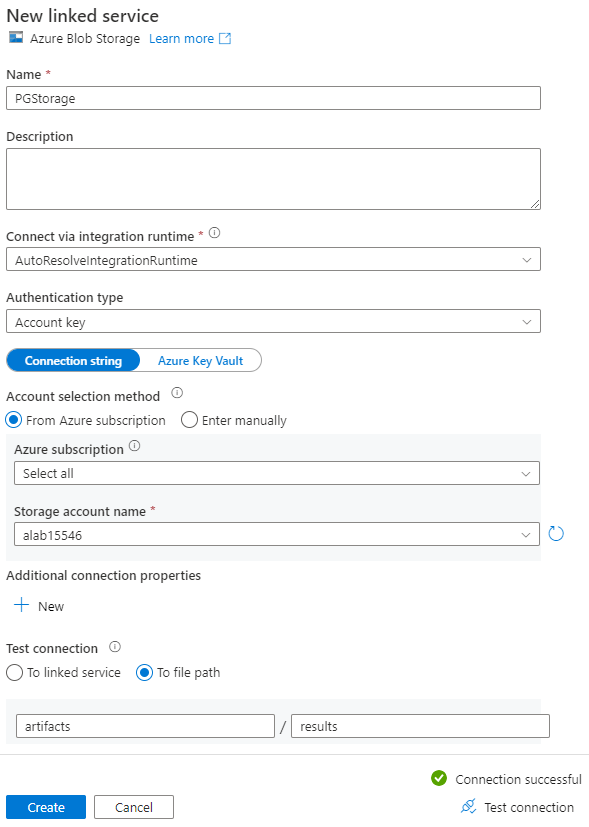

På sidan Ny länkad tjänst anger du ett namn för den länkade tjänsten och väljer ditt lagringskonto i listan Lagringskontonamn .

Under Testa anslutning väljer du Till filsökväg, anger containern och katalogen som du vill ansluta till och väljer sedan Testa anslutning.

Spara konfigurationen genom att välja Skapa .

På skärmen Ange egenskaper väljer du OK.

Konfigurera mottagare.

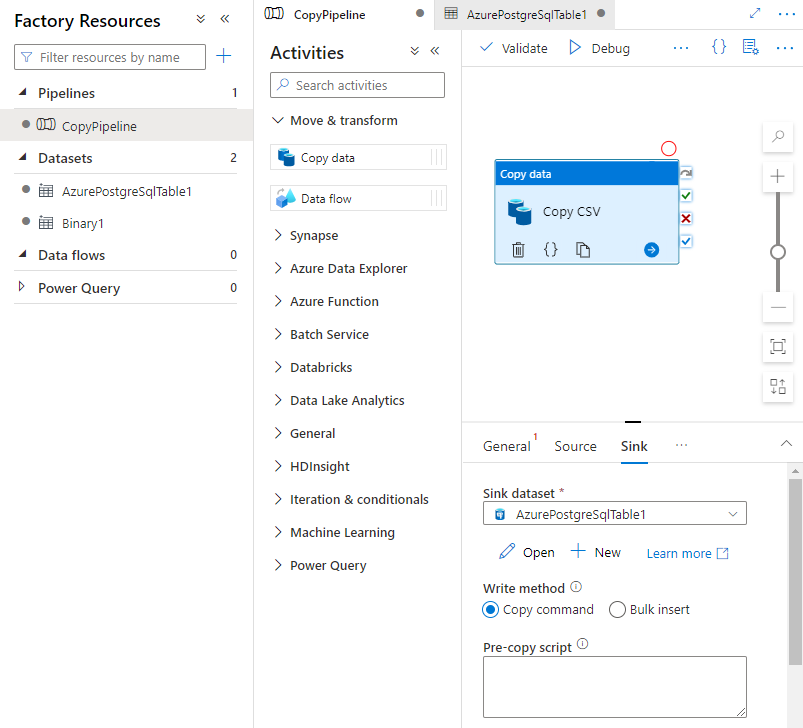

På sidan Aktiviteter väljer du fliken Mottagare. Välj Ny om du vill skapa en datauppsättning för mottagare.

I dialogrutan Ny datauppsättning väljer du Azure Database for PostgreSQL och väljer sedan Fortsätt.

På sidan Ange egenskaper går du till Länkad tjänst och väljer Ny.

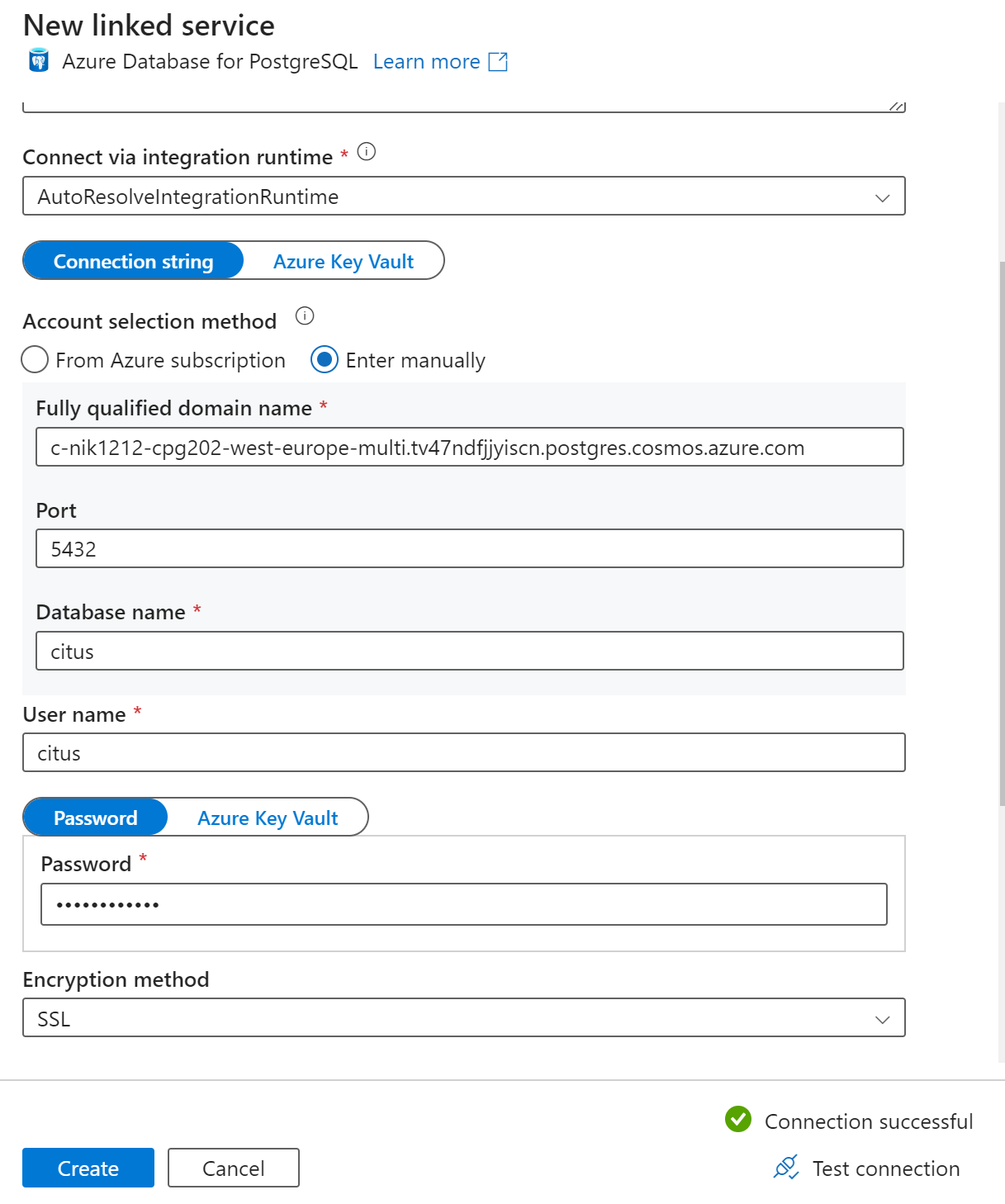

På sidan Ny länkad tjänst anger du ett namn för den länkade tjänsten och väljer Ange manuellt i metoden Kontoval.

Ange klustrets koordinatornamn i fältet Fullständigt kvalificerat domännamn . Du kan kopiera koordinatorns namn från översiktssidan för ditt Azure Cosmos DB for PostgreSQL-kluster.

Lämna standardport 5432 i fältet Port för direkt anslutning till koordinatorn eller ersätt den med port 6432 för att ansluta till den hanterade PgBouncer-porten.

Ange databasnamnet i klustret och ange autentiseringsuppgifter för att ansluta till det.

Välj SSL i listrutan Krypteringsmetod .

Välj Testa anslutning längst ned i panelen för att verifiera mottagarkonfigurationen.

Spara konfigurationen genom att välja Skapa .

På skärmen Ange egenskaper väljer du OK.

På fliken Mottagare på sidan Aktiviteter väljer du Öppna bredvid listrutan Mottagare och väljer tabellnamnet i målklustret där du vill mata in data.

Under Skrivmetod väljer du Kommandot Kopiera.

I verktygsfältet ovanför arbetsytan väljer du Verifiera för att verifiera pipelineinställningarna. Åtgärda eventuella fel, återskapa och kontrollera att pipelinen har verifierats.

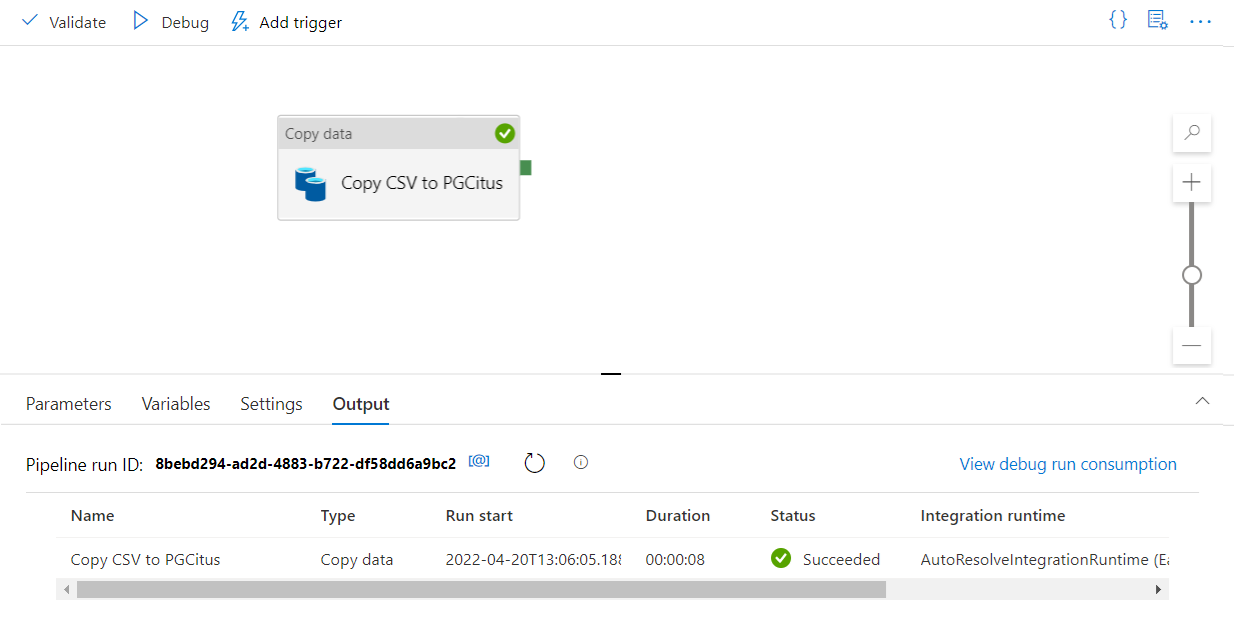

Välj Felsök i verktygsfältet för att köra pipelinen.

När pipelinen kan köras väljer du Publicera alla i det översta verktygsfältet. Den här åtgärden publicerar entiteter (datauppsättningar och pipelines) som du har skapat till Data Factory.

Anropa en lagrad procedur i Data Factory

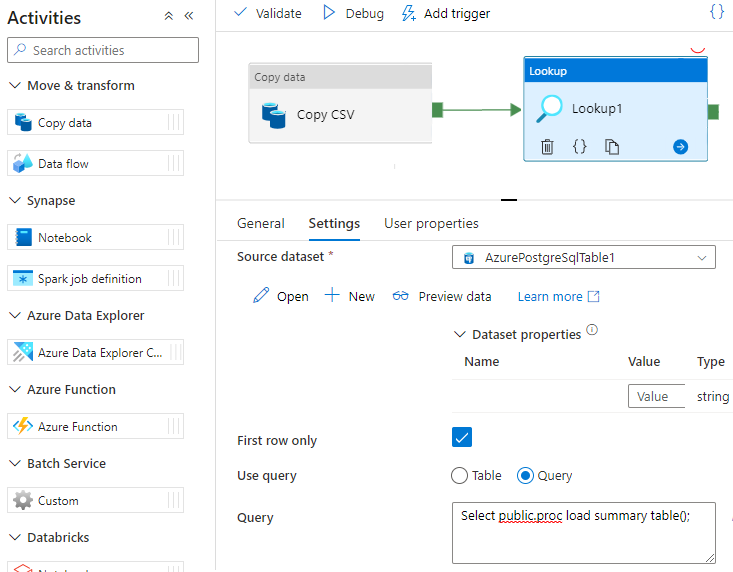

I vissa specifika scenarier kanske du vill anropa en lagrad procedur/funktion för att skicka aggregerade data från mellanlagringstabellen till sammanfattningstabellen. Data Factory erbjuder inte någon lagrad proceduraktivitet för Azure Cosmos DB för PostgreSQL, men som en lösning kan du använda uppslagsaktiviteten med en fråga för att anropa en lagrad procedur enligt nedan:

Nästa steg

- Lär dig hur du skapar en instrumentpanel i realtid med Azure Cosmos DB for PostgreSQL.

- Lär dig hur du flyttar din arbetsbelastning till Azure Cosmos DB för PostgreSQL

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för