Prisexempel: Kopiera data och transformera dem med Azure Databricks

GÄLLER FÖR:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dricks

Prova Data Factory i Microsoft Fabric, en allt-i-ett-analyslösning för företag. Microsoft Fabric omfattar allt från dataflytt till datavetenskap, realtidsanalys, business intelligence och rapportering. Lär dig hur du startar en ny utvärderingsversion kostnadsfritt!

I det här scenariot vill du kopiera data från AWS S3 till Azure Blob Storage och transformera data med Azure Databricks enligt ett schema per timme i 8 timmar per dag i 30 dagar.

Priserna som används i det här exemplet nedan är hypotetiska och är inte avsedda att innebära exakta faktiska priser. Läs-/skriv- och övervakningskostnader visas inte eftersom de vanligtvis är försumbara och inte påverkar de totala kostnaderna avsevärt. Aktivitetskörningar avrundas också till de närmaste 1 000 i priskalkylatorns uppskattningar.

Kommentar

Den här uppskattningen gäller endast kostnader för Azure Data Factory. Azure Databricks medför dock även kostnader i det här scenariot, som du kan beräkna med hjälp av Priskalkylatorn för Azure.

Se Priskalkylatorn för Azure för mer specifika scenarier och för att beräkna framtida kostnader för att använda tjänsten.

Konfiguration

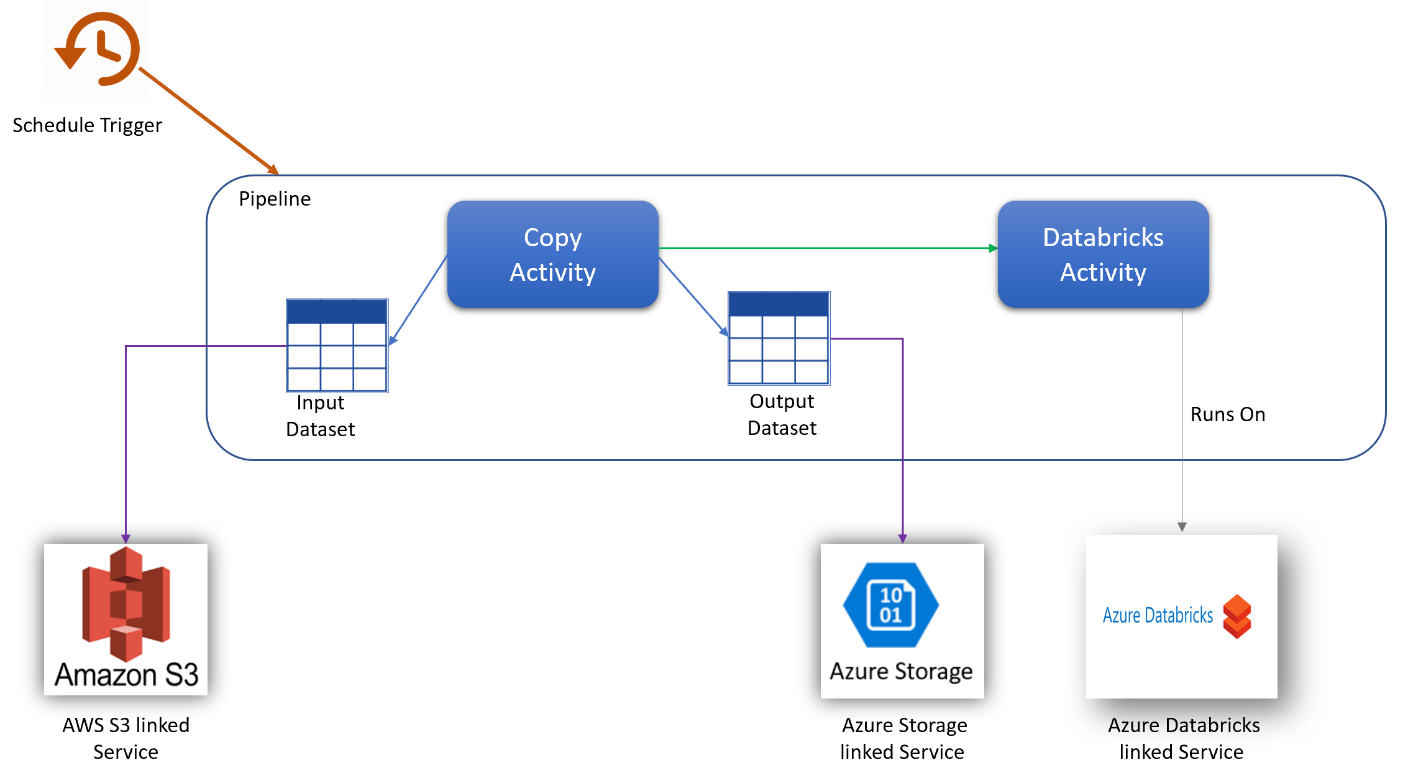

För att åstadkomma scenariot måste du skapa en pipeline med följande objekt:

- En kopieringsaktivitet med en indatauppsättning för data som ska kopieras från AWS S3 och en utdatauppsättning för data i Azure Storage.

- En Azure Databricks-aktivitet för datatransformeringen.

- En schemautlösare för att köra pipelinen varje timme. När du vill köra en pipeline kan du antingen utlösa den direkt eller schemalägga den. Förutom själva pipelinen räknas varje utlösarinstans som en enda aktivitetskörning.

Kostnadsuppskattning

| Drift | Typer och enheter |

|---|---|

| Kör pipeline | 3 Aktivitetskörningar per körning (1 för utlösarkörning, 2 för aktivitetskörningar) = 720 aktivitetskörningar, avrundade eftersom kalkylatorn endast tillåter ökningar på 1 000. |

| Kopiera dataantagande: DIU-timmar per körning = 10 min | 10 min \ 60 min * 4 Azure Integration Runtime (standardinställning för DIU = 4) Mer information om dataintegreringsenheter och optimering av kopieringsprestanda finns i den här artikeln |

| Kör Databricks-aktivitetsantagande: externa körningstimmar per körning = 10 min | 10 min \ 60 min körning av extern pipelineaktivitet |

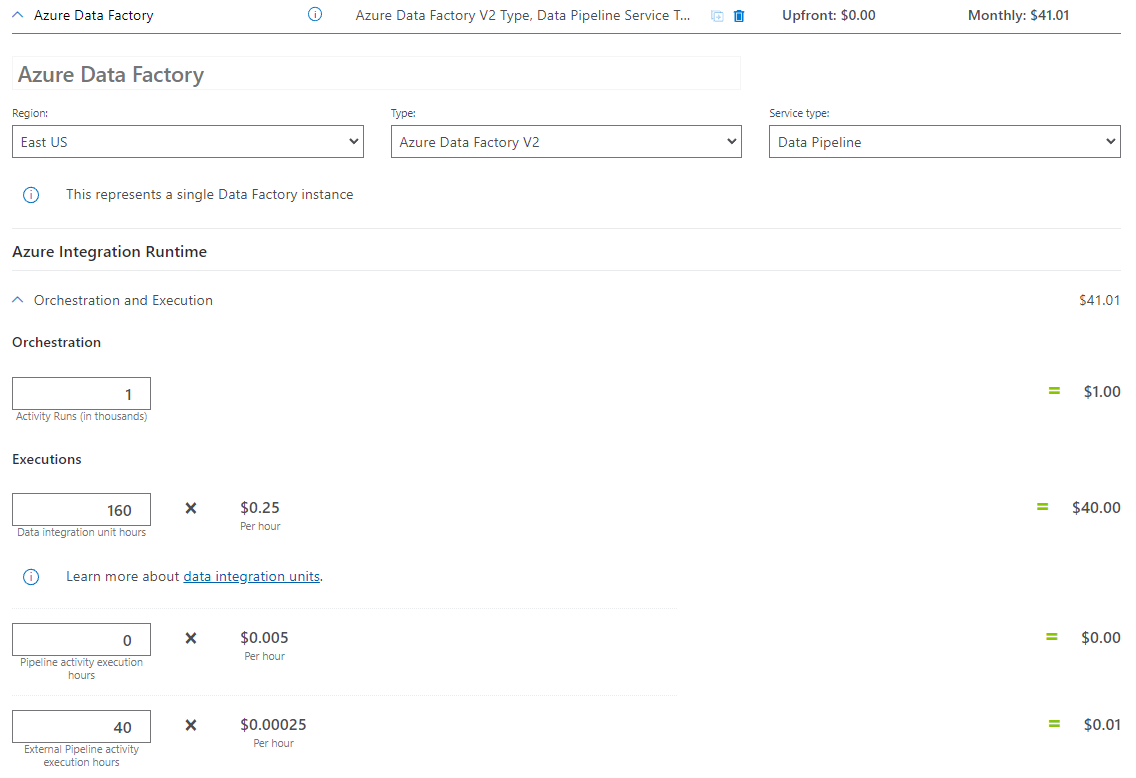

Exempel på priskalkylator

Total prissättning för scenario i 30 dagar: 41,01 USD

Relaterat innehåll

- Prisexempel: Kopiera data från AWS S3 till Azure Blob Storage per timme i 30 dagar

- Prisexempel: Kopiera data och transformera med dynamiska parametrar per timme i 30 dagar

- Prisexempel: Köra SSIS-paket på Azure-SSIS Integration Runtime

- Prisexempel: Använda felsökning av dataflödesmappning för en normal arbetsdag

- Prisexempel: Transformera data i bloblager med mappning av dataflöden

- Prisexempel: Dataintegrering i Azure Data Factory Managed VNET

- Prisexempel: Hämta deltadata från SAP ECC via SAP CDC i mappning av dataflöden

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för