Hantering av AI-säkerhetsstatus (förhandsversion)

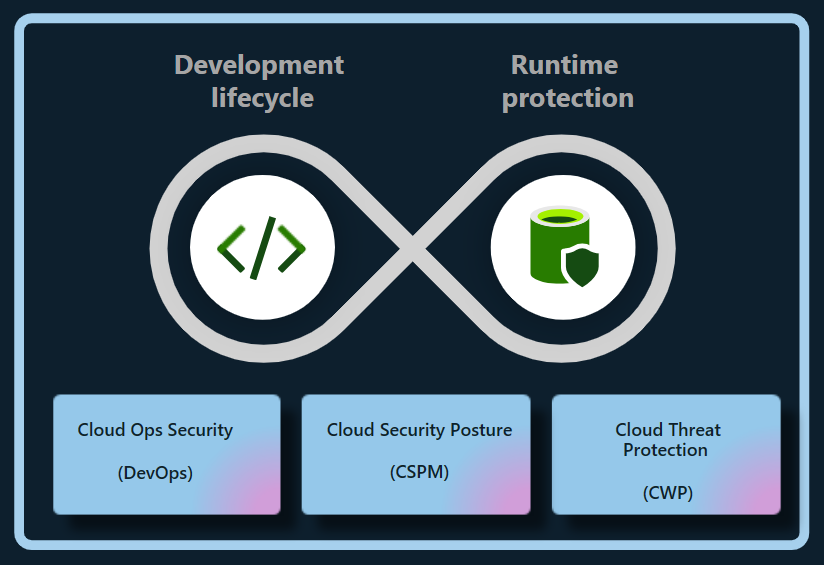

CsPM-planen (Defender Cloud Security Posture Management) i Microsoft Defender för molnet tillhandahåller AI-funktioner för hantering av säkerhetsstatus som skyddar företagsbyggda, flera eller hybridmoln (för närvarande Azure och AWS) generativa AI-program under hela programlivscykeln. Defender for Cloud minskar risken för ai-arbetsbelastningar mellan moln genom att:

- Identifiera generativ AI Bill of Materials (AI BOM), som innehåller programkomponenter, data och AI-artefakter från kod till molnet.

- Stärka generativ AI-programsäkerhet med inbyggda rekommendationer och genom att utforska och åtgärda säkerhetsrisker.

- Använda attacksökvägsanalysen för att identifiera och åtgärda risker.

Viktigt!

Så här aktiverar du ai-säkerhetsstatushanteringsfunktioner på ett AWS-konto som redan:

- Är ansluten till ditt Azure-konto.

- Har Defender CSPM aktiverat.

- Har behörighetstypen inställd som Åtkomst med minst behörighet.

Du måste konfigurera om behörigheterna för anslutningsappen för att aktivera relevanta behörigheter med hjälp av följande steg:

- Gå till sidan Miljöinställningar på Azure-portalen och välj lämplig AWS-anslutning.

- Välj Konfigurera åtkomst.

- Kontrollera att behörighetstypen är inställd på Åtkomst med minst behörighet.

- Slutför konfigurationen genom att följa steg 5–8 .

Identifiera generativa AI-appar

Defender for Cloud identifierar AI-arbetsbelastningar och identifierar information om din organisations AI BOM. Med den här synligheten kan du identifiera och åtgärda sårbarheter och skydda generativa AI-program mot potentiella hot.

Defender for Cloud identifierar automatiskt och kontinuerligt distribuerade AI-arbetsbelastningar i följande tjänster:

- Azure OpenAI Service

- Azure Machine Learning

- Amazon Berggrund

Defender for Cloud kan också identifiera sårbarheter i generativa AI-biblioteksberoenden som TensorFlow, PyTorch och Langchain genom att skanna källkoden för felkonfigurationer av infrastruktur som kod (IaC) och containeravbildningar efter sårbarheter. Att regelbundet uppdatera eller korrigera biblioteken kan förhindra kryphål, skydda generativa AI-program och upprätthålla deras integritet.

Med de här funktionerna ger Defender for Cloud fullständig insyn i AI-arbetsbelastningar från kod till moln.

Minska riskerna för generativa AI-appar

Defender CSPM ger sammanhangsberoende insikter om en organisations AI-säkerhetsstatus. Du kan minska riskerna i dina AI-arbetsbelastningar med hjälp av säkerhetsrekommendationer och analys av attackvägar.

Utforska risker med hjälp av rekommendationer

Defender for Cloud utvärderar AI-arbetsbelastningar och utfärdar rekommendationer kring identitet, datasäkerhet och Internetexponering för att identifiera och prioritera kritiska säkerhetsproblem i AI-arbetsbelastningar.

Identifiera IaC-felkonfigurationer

DevOps-säkerhet identifierar IaC-felkonfigurationer som kan exponera generativa AI-program för säkerhetsrisker, till exempel överexponerade åtkomstkontroller eller oavsiktligt offentligt exponerade tjänster. Dessa felkonfigurationer kan leda till dataintrång, obehörig åtkomst och efterlevnadsproblem, särskilt vid hantering av strikta regler för datasekretess.

Defender for Cloud utvärderar konfigurationen av dina generativa AI-appar och ger säkerhetsrekommendationer för att förbättra AI-säkerhetsstatusen.

Identifierade felkonfigurationer bör åtgärdas tidigt i utvecklingscykeln för att förhindra mer komplexa problem senare.

Aktuella IaC AI-säkerhetskontroller omfattar:

- Använda privata Slutpunkter för Azure AI-tjänsten

- Begränsa Azure AI-tjänstslutpunkter

- Använda hanterad identitet för Azure AI-tjänstkonton

- Använda identitetsbaserad autentisering för Azure AI-tjänstkonton

Utforska risker med analys av attackvägar

Analys av attackvägar identifierar och minskar riskerna för AI-arbetsbelastningar, särskilt under jordning (länkning av AI-modeller till specifika data) och finjustering (justering av en förtränad modell på en specifik datamängd för att förbättra dess prestanda för en relaterad uppgift) där data kan exponeras.

Genom att övervaka AI-arbetsbelastningar kontinuerligt kan analys av attackvägar identifiera svagheter och potentiella sårbarheter och följa upp med rekommendationer. Dessutom utökas den till fall där data- och beräkningsresurserna distribueras i Azure, AWS och GCP.

Relaterat innehåll

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för