Samla in data från Event Hubs i Delta Lake-format

Den här artikeln beskriver hur du använder kodredigeraren för att automatiskt samla in strömmande data i Event Hubs i ett Azure Data Lake Storage Gen2-konto i Delta Lake-format.

Förutsättningar

- Dina Azure Event Hubs- och Azure Data Lake Storage Gen2-resurser måste vara offentligt tillgängliga och kan inte finnas bakom en brandvägg eller skyddas i ett virtuellt Azure-nätverk.

- Data i dina Event Hubs måste serialiseras i antingen JSON-, CSV- eller Avro-format.

Konfigurera ett jobb för att samla in data

Använd följande steg för att konfigurera ett Stream Analytics-jobb för att samla in data i Azure Data Lake Storage Gen2.

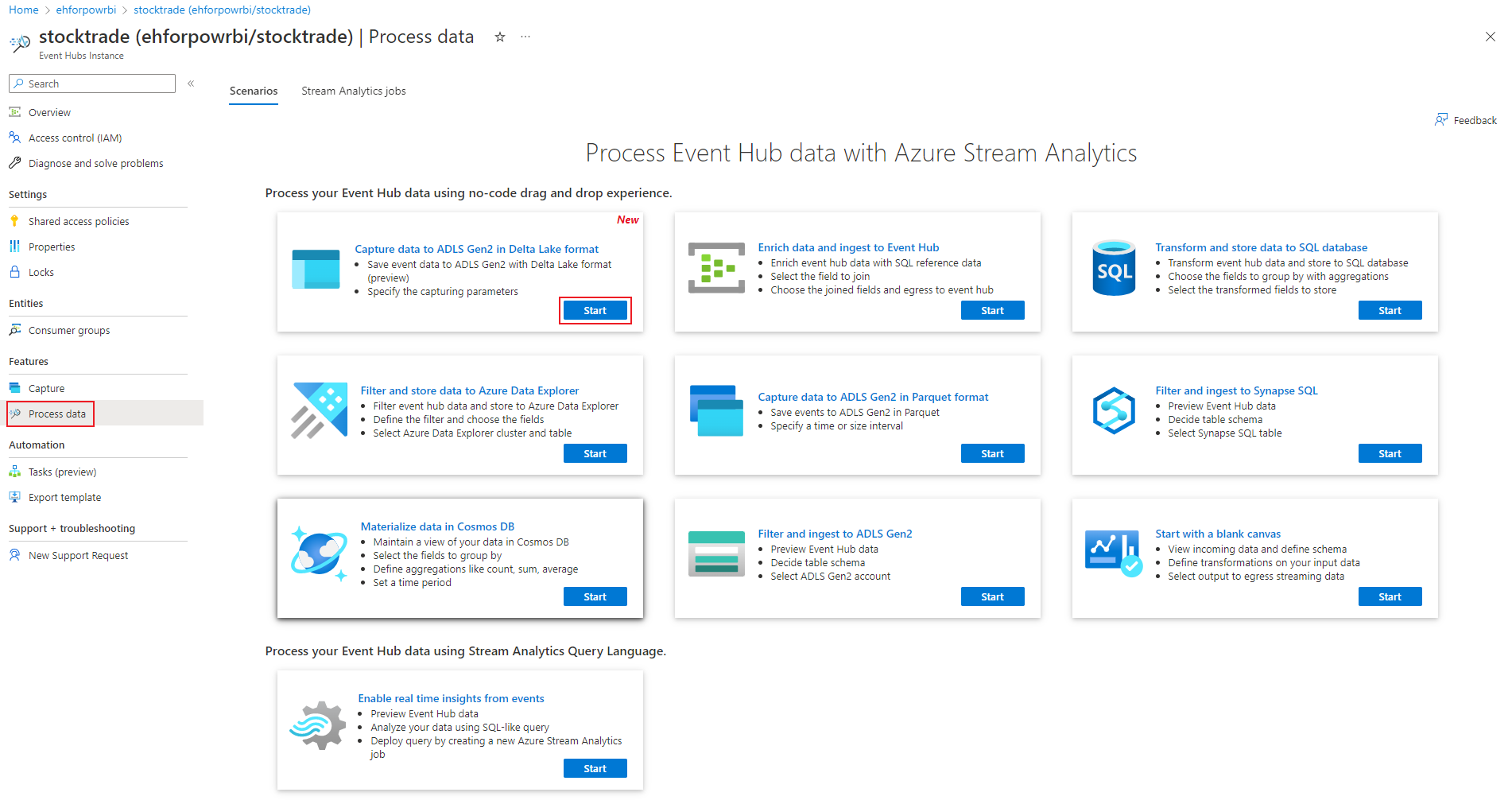

Gå till din händelsehubb i Azure-portalen.

Välj Funktioner>Bearbeta data och välj Starta på kortet Avbilda data till ADLS Gen2 i Delta Lake-format.

Du kan också välja Funktionsinsamling> och välja alternativet Delta Lake under "Utdatahändelse serialiseringsformat" och sedan Starta datainsamlingskonfiguration.

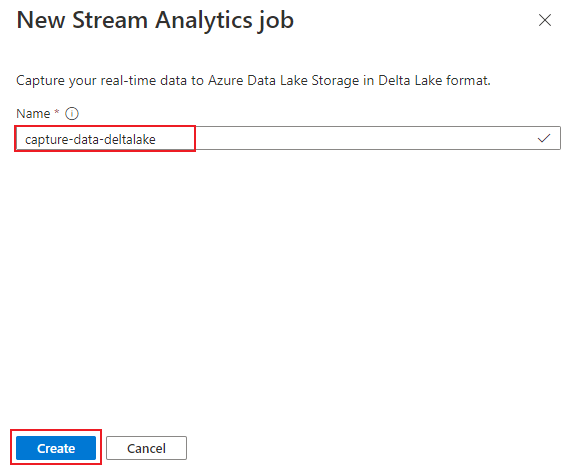

Ange ett namn för att identifiera ditt Stream Analytics-jobb. Välj Skapa.

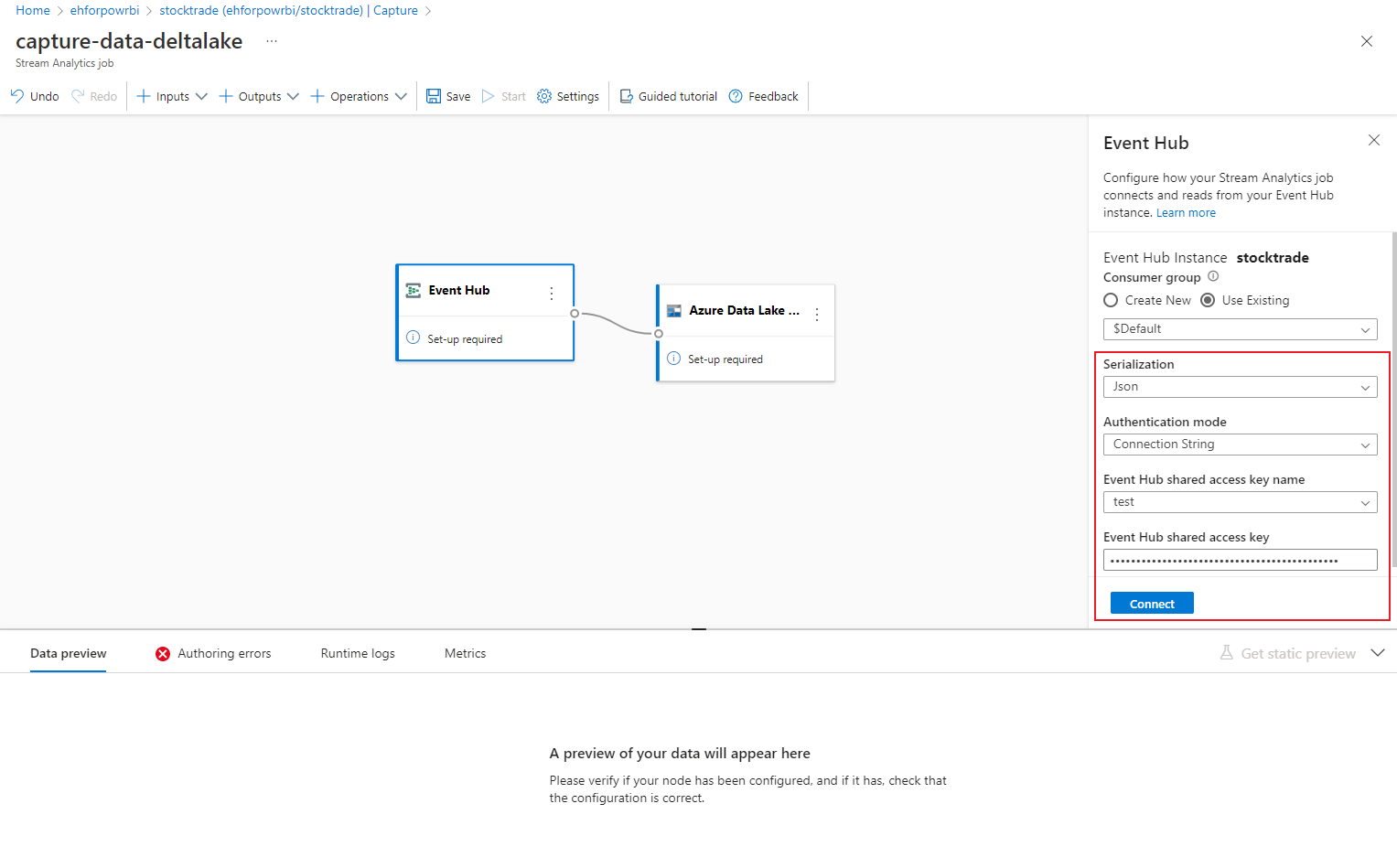

Ange serialiseringstypen för dina data i Event Hubs och den autentiseringsmetod som jobbet använder för att ansluta till Event Hubs. Välj sedan Anslut.

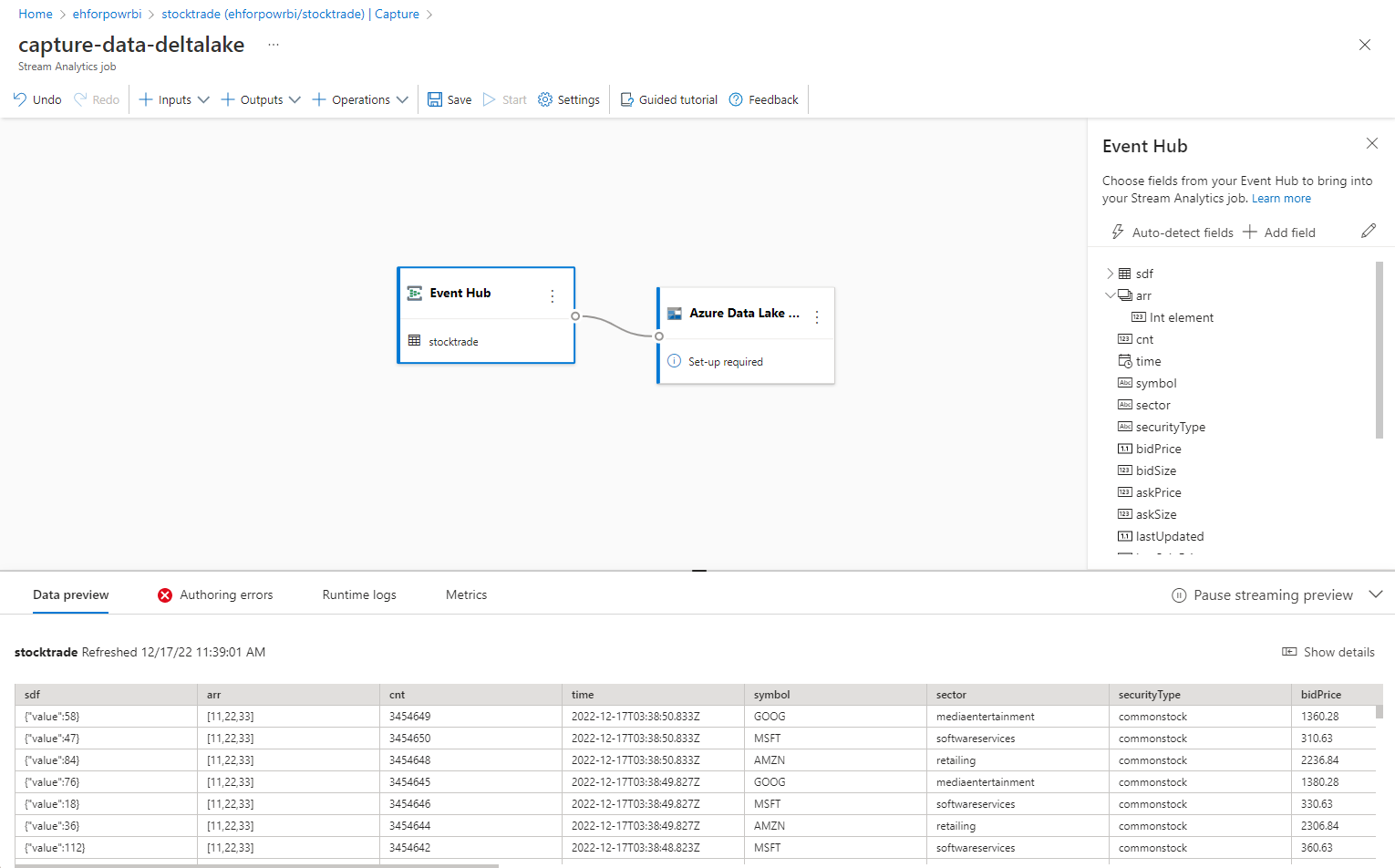

När anslutningen har upprättats visas:

- Fält som finns i indata. Du kan välja Lägg till fält eller välja symbolen med tre punkter bredvid ett fält om du vill ta bort, byta namn på eller ändra dess namn.

- Ett live-exempel på inkommande data i tabellen Dataförhandsgranskning under diagramvyn. Den uppdateras regelbundet. Du kan välja Pausa förhandsversionen av direktuppspelning för att visa en statisk vy över exempelindata.

Välj panelen Azure Data Lake Storage Gen2 för att redigera konfigurationen.

Följ dessa steg på konfigurationssidan för Azure Data Lake Storage Gen2 :

Välj prenumeration, lagringskontonamn och container i den nedrullningsbara menyn.

När prenumerationen har valts ska autentiseringsmetoden och lagringskontonyckeln fyllas i automatiskt.

För Delta-tabellsökväg används den för att ange platsen och namnet på din Delta Lake-tabell som lagras i Azure Data Lake Storage Gen2. Du kan välja att använda ett eller flera sökvägssegment för att definiera sökvägen till deltatabellen och deltatabellnamnet. Mer information finns i Skriva till Delta Lake-tabellen.

Välj Anslut.

När anslutningen upprättas visas fält som finns i utdata.

Spara konfigurationen genom att välja Spara i kommandofältet.

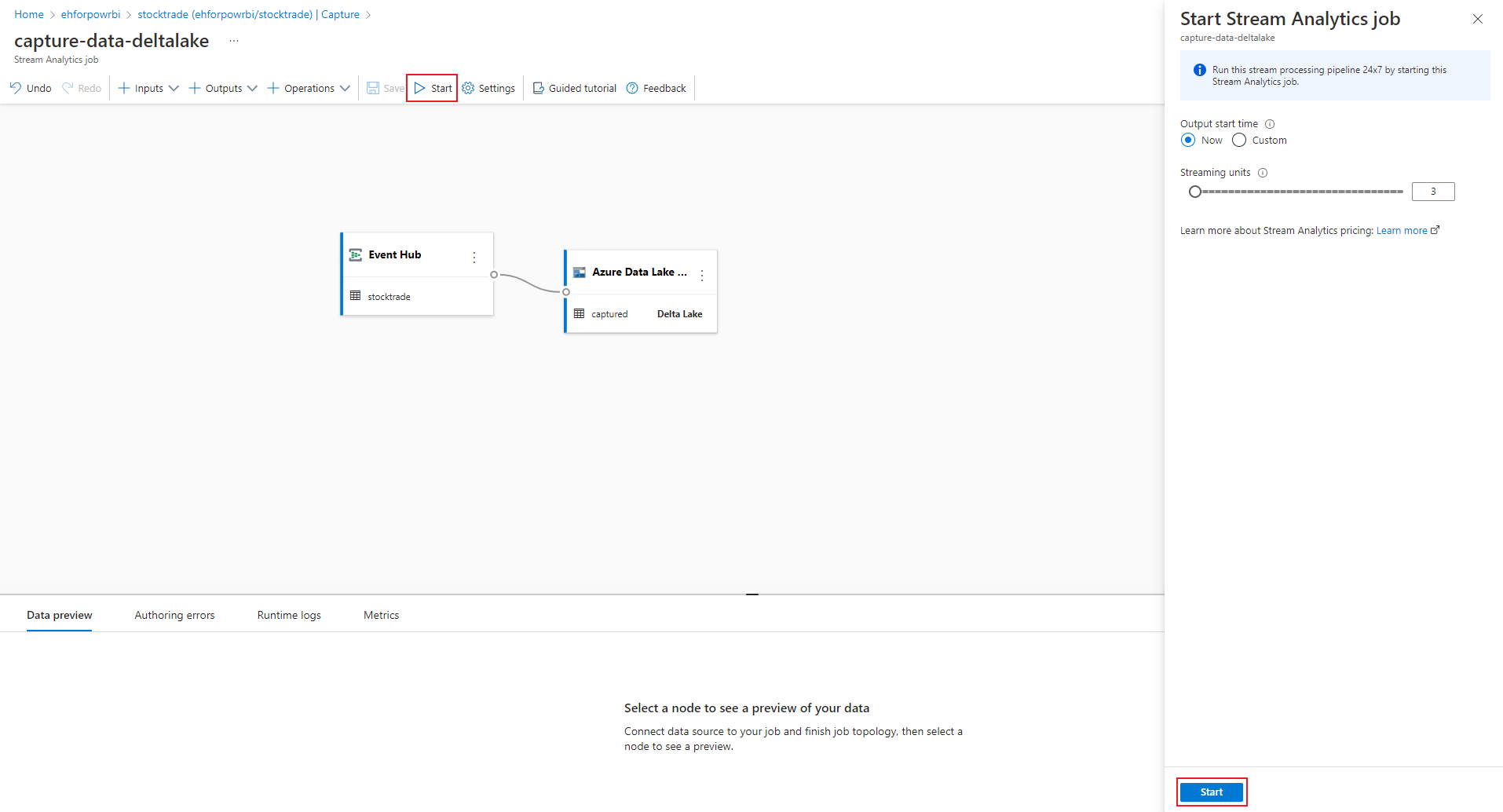

Välj Starta i kommandofältet för att starta strömningsflödet för att samla in data. I fönstret Starta Stream Analytics-jobb:

- Välj starttid för utdata.

- Välj det antal strömningsenheter (SU) som jobbet körs med. SU representerar de beräkningsresurser som allokeras för att köra ett Stream Analytics-jobb. Mer information finns i Strömmande enheter i Azure Stream Analytics.

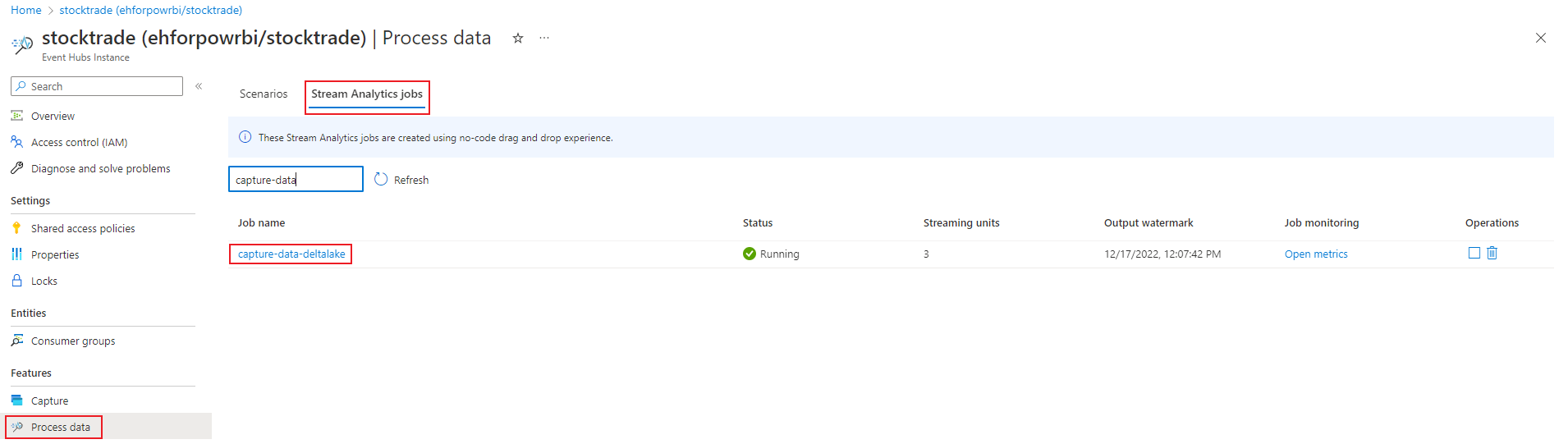

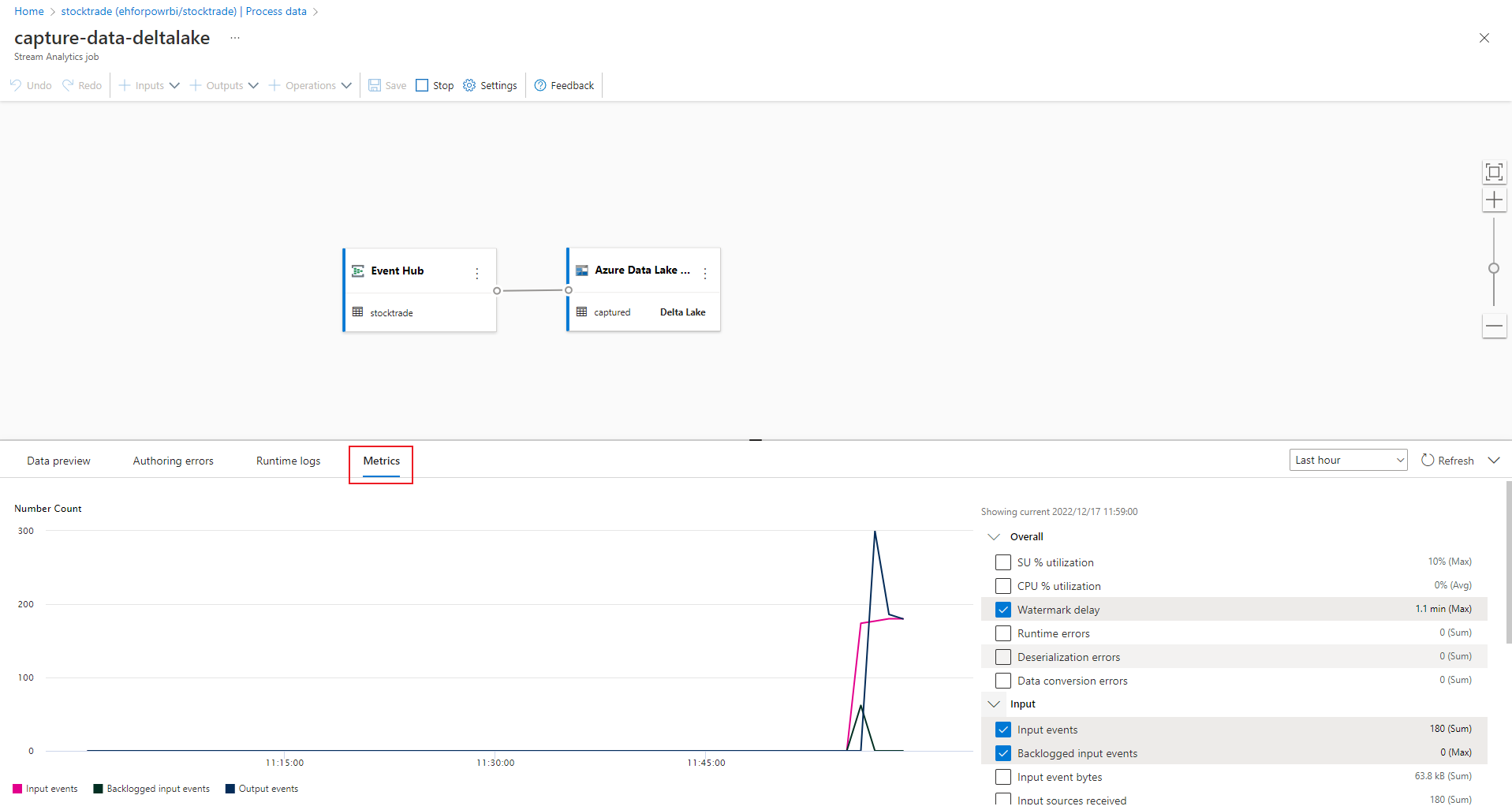

När du har valt Start börjar jobbet köras inom två minuter och måtten öppnas i flikavsnittet enligt följande bild.

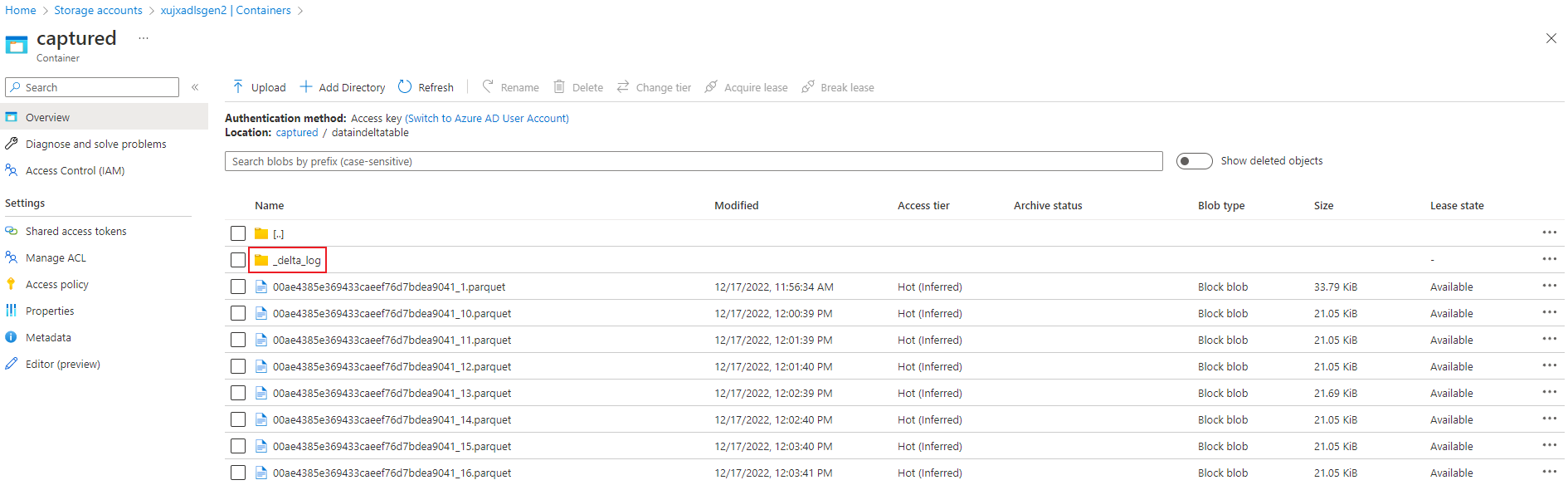

Verifiera utdata

Kontrollera att parquet-filerna med Delta lake-format genereras i Azure Data Lake Storage-containern.

Nästa steg

Nu vet du hur du använder Stream Analytics utan kodredigerare för att skapa ett jobb som samlar in Event Hubs-data till Azure Data Lake Storage Gen2 i Delta lake-format. Sedan kan du lära dig mer om Azure Stream Analytics och hur du övervakar jobbet som du skapade.

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för