Anteckning

Åtkomst till den här sidan kräver auktorisering. Du kan prova att logga in eller ändra kataloger.

Åtkomst till den här sidan kräver auktorisering. Du kan prova att ändra kataloger.

Följande guide vägleder dig genom viktiga steg när du skapar en etablerad distribution med din Azure AI Foundry-resurs. Mer information om begreppen som beskrivs här finns i:

- Registreringsguide för Azure AI Foundry Provisioned Throughput

- Koncept för genomströmning i Azure AI Foundry

Förutsättningar

- En Azure-prenumeration – Skapa en kostnadsfritt

- Rollen Azure-deltagare eller Cognitive Services-deltagare

Hämta/verifiera PTU-kvottillgänglighet.

Distributioner av allokerad genomströmning är dimensionerade i enheter som kallas allokerade genomströmningsenheter (PTU). PTU-kvoten för varje etablerad distributionstyp beviljas till en prenumeration regionalt och begränsar det totala antalet PTU:er som kan distribueras i den regionen för alla modeller och versioner.

För att skapa en ny distribution krävs tillgänglig (oanvänd) kvot för att täcka den önskade storleken på distributionen. Exempel: Om en prenumeration har följande i södra centrala USA:

- Total PTU-kvot = 500 PTUs

- Driftsättningar

- 100 PTUs: GPT-4o, 2024-05-13

- 100 PTUs: DeepSeek-R1, 1

Sedan anses 200 PTU av kvoten vara använda, och det finns 300 PTU tillgängliga för att skapa nya utplaceringar.

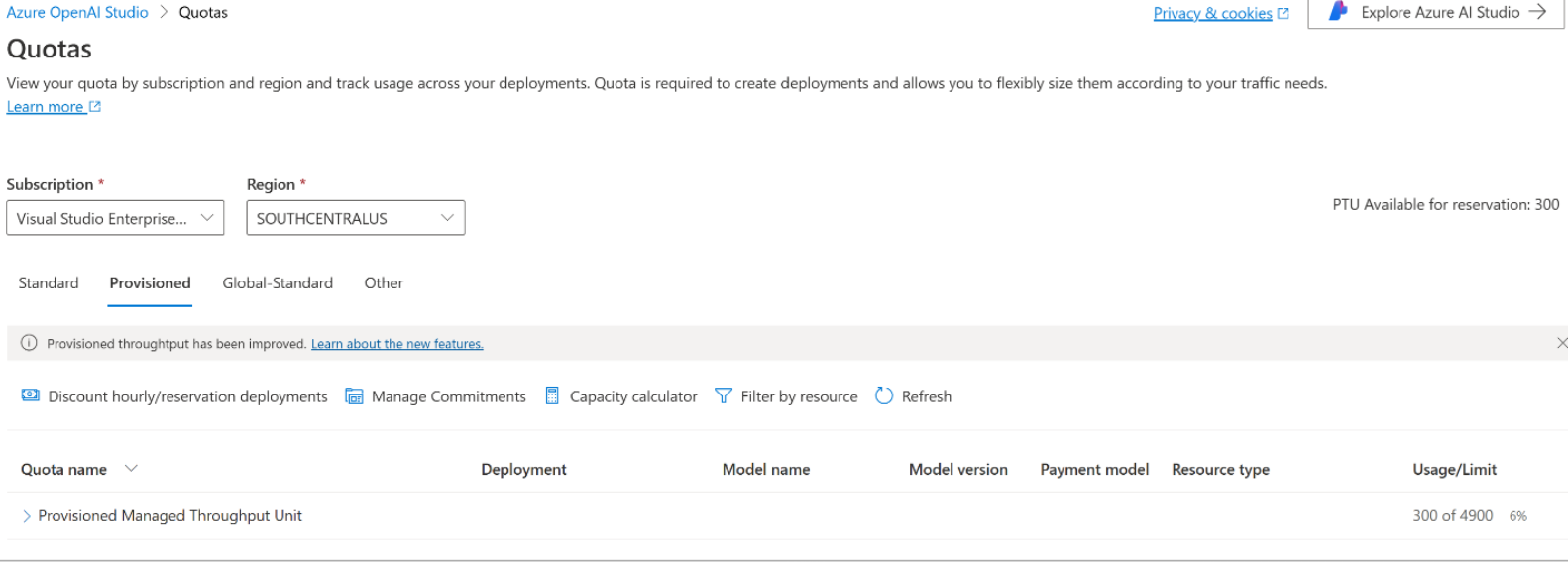

En standardmängd av den globala kvoten, datazonen och den regionala etablerade kvoten tilldelas till berättigade prenumerationer i flera regioner. Du kan visa den tillgängliga kvoten i en region genom att gå till fönstret Kvoter i Azure AI Foundry-portalen och välja önskad prenumeration och region. Skärmbilden nedan visar till exempel en kvotgräns på 300 PTU:er för globalt tillhandahållet dataflöde i västra USA för den valda prenumerationen. Den totala användningen av dessa globala PTU:er är 50, då har du 250 PTU-enheter tillgängliga för distributionstypen Global Provisioned Throughput.

Du kan begära ytterligare kvot genom att klicka på knappen "Begär kvot".

Skapa en Azure AI Foundry-resurs

Etablerade distributioner skapas via Azure AI Foundry-resursobjekt i Azure. Du måste ha en Azure AI Foundry-resurs i varje region där du tänker skapa en distribution. Använd Azure Portal för att skapa en resurs i en region med tillgänglig kvot om det behövs.

Anmärkning

Azure AI Foundry-resurser har stöd för flera typer av Azure AI Foundry-distributioner samtidigt. Det är inte nödvändigt att avsätta nya resurser för dina förberedda distributioner.

Identifiera modeller med etablerat distributionsalternativ

När du har verifierat din kvot kan du skapa en distribution. Gå till Azure AI Foundry-modellkatalogen för att identifiera modellerna med etablerade distributionsalternativ.

- Logga in på Azure AI Foundry-portalen.

- Välj den prenumeration som har aktiverats för etablerade distributioner och välj önskad resurs i en region där du har kvoten.

- Du kan välja modeller genom att filtrera Direkt från Microsoft i modellsamlingsfiltret. Det här är modeller som lagras och hanteras av Azure direkt och stöder distributionsalternativet för etablerat dataflöde.

- Välj den modell som du vill distribuera och kontrollera modellinformationen på modellkortet.

Skapa din beräknade distribution – kapaciteten är tillgänglig

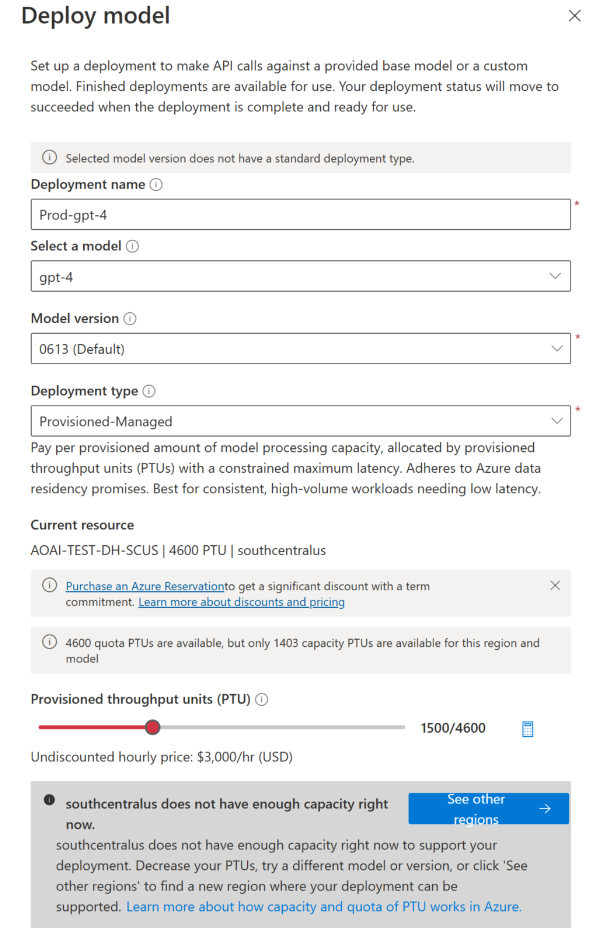

Om du vill skapa en förberedd distribution kan du följa dessa steg; de val som beskrivs återspeglar de poster som visas i skärmbilden.

Klicka på Använd den här modellen och konfigurera följande fält.

Välj "Global etablerad kapacitet", "Datazon etablerad kapacitet" eller "Regional etablerad kapacitet" i rullgardinsmenyn för distributionstypen för din etablerade distribution.

Utöka Avancerade alternativ listrutan.

Fyll i värdena i varje fält. Här är ett exempel:

| Fält | Beskrivning | Exempel |

|---|---|---|

| Välj en modell | Välj den specifika modell som du vill distribuera. | GPT-4 |

| Modellversion | Välj vilken version av modellen som ska distribueras. | 0613 |

| Distributionsnamn | Distributionsnamnet används i koden för att anropa modellen med hjälp av klientbiblioteken och REST-API:erna. | gpt-4 |

| Innehållsfilter | Ange den filtreringsprincip som ska tillämpas på distributionen. Läs mer om hur du filtrerar innehåll. | Förinställning |

| Distributionstyp | Detta påverkar dataflödet och prestandan. Välj Globalt etablerat dataflöde, datazonetablerade dataflöden eller regionalt etablerat dataflöde i distributionsdialogrutan för distributionen | Globalt tilldelad genomströmning |

| Provisionerade genomströmningsenheter | Välj den mängd genomströmning som du vill inkludera i utrullningen. | 100 |

Anmärkning

Distributionsdialogrutan innehåller en påminnelse om att du kan köpa en Azure-reservation för Azure AI Foundry Provisioned Throughput för att få en betydande rabatt för ett termåtagande.

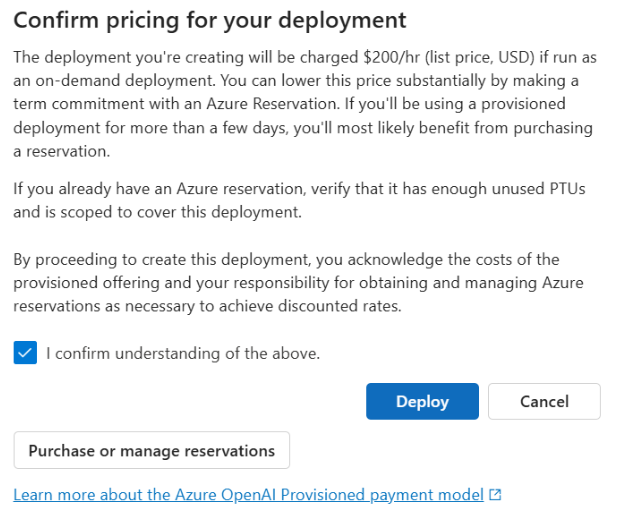

När du har angett distributionsinställningarna klickar du på Bekräfta priser för att fortsätta. En dialogruta för prisbekräftelse visas som visar listpriset för distributionen, om du väljer att betala per timme utan en Azure-reservation som ger termrabatt.

Om du är osäker på kostnaderna avbryter du distributionen och fortsätter när du förstår betalningsmodellen och underliggande kostnader för etablerad distribution. Det här steget kan förhindra oväntade, höga avgifter på din betalningsfaktura. Resurser för att utbilda dig själv är:

Bilden nedan visar den prisbekräftelse som du ser. Det pris som visas är endast ett exempel.

Om du vill skapa distributionen programmatiskt kan du göra det med följande Azure CLI-kommando. Om du vill ange distributionstypen ändrar du sku-name till GlobalProvisionedManaged, DataZoneProvisionedManagedeller ProvisionedManaged baserat på den avsedda distributionstypen. Uppdatera sku-capacity med önskat antal etablerade genomflödesenheter.

az cognitiveservices account deployment create \

--name <myResourceName> \

--resource-group <myResourceGroupName> \

--deployment-name MyModel \

--model-name GPT-4 \

--model-version 0613 \

--model-format OpenAI \

--sku-capacity 100 \

--sku-name ProvisionedManaged

REST, ARM-mall, Bicep och Terraform kan också användas för att skapa distributioner. Se avsnittet om att automatisera distributioner i guiden Hantera kvot och ersätt sku.name med GlobalProvisionedManaged, DataZoneProvisionedManagedeller ProvisionedManaged i stället Standardför .

Skapa din etablerade distribution – Kapaciteten är inte tillgänglig

På grund av den dynamiska karaktären hos kapacitetstillgänglighet är det möjligt att regionen för den valda resursen kanske inte har tjänstkapaciteten för att skapa distributionen av den angivna modellen, versionen och antalet PTU:er.

I så fall dirigerar guiden i Azure AI Foundry-portalen dig till andra regioner med tillgänglig kvot och kapacitet för att skapa en distribution av den önskade modellen. Om detta händer ser distributionsdialogrutan ut så här:

Saker att märka:

- Ett meddelande visas som visar många PTU:er som du har i tillgänglig kvot och hur många som för närvarande kan distribueras just nu.

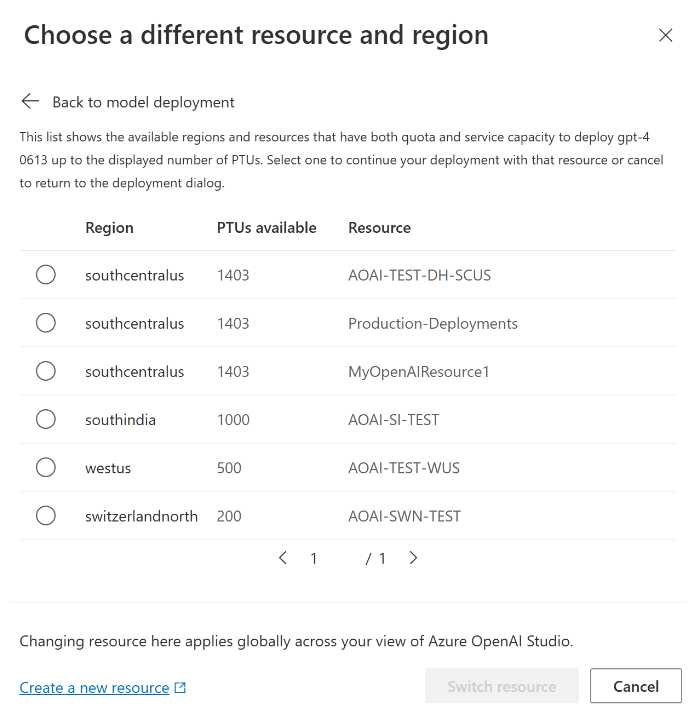

- Om du väljer ett antal PTU:er som är större än tjänstkapaciteten visas ett meddelande som innehåller alternativ för att få mer kapacitet och en knapp som gör att du kan välja en alternativ region. Om du klickar på knappen "Se andra regioner" visas en dialogruta som visar en lista över Azure AI Foundry-resurser där du kan skapa en distribution, tillsammans med den maximala distribution som kan skapas baserat på tillgänglig kvot och tjänstkapacitet i varje region.

Om du väljer en resurs och klickar på Växla resurs kommer distributionsdialogrutan att spelas upp på nytt med hjälp av den valda resursen. Du kan sedan fortsätta att skapa distributionen i den nya regionen.

Skapa en ny distribution eller byta modeller med din kvot

Om du fortfarande har kvoten tillgänglig under prenumerationen och regionen kan du skapa nya förberedda distributioner för andra modeller som är värdsatta och säljs av Microsoft.

Stegen är desamma som exemplet ovan. När du skapar en ny distribution visas den totala tillgängliga kvoten som du kan använda i distributionswidgeten. I skärmbilden nedan är den tillgängliga kvoten 250 enheter.

När du har distribuerat den nya modellen kan du kontrollera kvotanvändningen i AI Foundry-portalen. Du kan hantera din kvot genom att antingen begära en ny kvot eller ta bort befintliga distributioner för att frigöra PTU-kvoter för nya etablerade distributioner.

Köp en reservation om du vill

När du har skapat distributionen kanske du vill köpa en rabatt för en tidsperiod genom en Azure-reservation. En Azure-reservation kan ge en betydande rabatt på timpriset för användare som tänker använda distributionen längre än några dagar.

Mer information om inköpsmodellen och reservationer finns i:

- Spara kostnader med Microsoft Azure AI Foundry och reserverad dataflödeskapacitet.

- Introduktionsguide för azure AI Foundry-etablerat dataflöde

- Guide för azure AI Foundry-etablerade dataflödesreservationer

Viktigt!

Kapacitetstillgängligheten för modelldistributioner är dynamisk och ändras ofta mellan regioner och modeller. Om du vill förhindra att du köper en reservation för fler PTUs än du kan använda skapar du distributioner först och köper sedan Azure-reservationen för att täcka de PTU:er som du har distribuerat. Den här bästa metoden säkerställer att du kan dra full nytta av reservationsrabatten och hindra dig från att köpa ett åtagande som du inte kan använda.

Gör dina första slutsatsdragningsanrop

Inferenskoden för provisionerade distributioner är densamma som för en standarddistributionstyp. Följande kodexempel visar ett anrop för chattkomplettering till en GPT-4-modell. För första gången du använder dessa modeller programmatiskt rekommenderar vi att du börjar med vår snabbstartsguide. Vår rekommendation är att använda OpenAI-biblioteket med version 1.0 eller senare eftersom detta inkluderar omprövningslogik i biblioteket.

import os

from openai import AzureOpenAI

client = AzureOpenAI(

azure_endpoint = os.getenv("AZURE_OPENAI_ENDPOINT"),

api_key=os.getenv("AZURE_OPENAI_API_KEY"),

api_version="2024-10-21"

)

response = client.chat.completions.create(

model="gpt-4", # model = "deployment_name".

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Does Azure OpenAI support customer managed keys?"},

{"role": "assistant", "content": "Yes, customer managed keys are supported by Azure OpenAI."},

{"role": "user", "content": "Do other Azure services support this too?"}

]

)

print(response.choices[0].message.content)

Viktigt!

För produktion använder du ett säkert sätt att lagra och komma åt dina autentiseringsuppgifter som Azure Key Vault. Mer information om säkerhet för autentiseringsuppgifter finns i den här säkerhetsartikeln .

Förstå förväntad genomströmning

Mängden dataflöde som du kan uppnå på slutpunkten är en faktor för antalet distribuerade PTU:er, indatastorlek, utdatastorlek och anropsfrekvens. Antalet samtidiga anrop och totalt antal bearbetade token kan variera beroende på dessa värden. Vårt rekommenderade sätt att fastställa genomströmningen för din distribution är följande:

- Använd kapacitetskalkylatorn för en storleksuppskattning. Du hittar kapacitetskalkylatorn i Azure AI Foundry-portalen under kvotsidan och fliken Etablerad.

- Prestandatesta belastningen med verklig trafikarbetsbelastning. Mer information om benchmarking finns i avsnittet om benchmarking .

Mäta din distributionsutnyttjande

När du distribuerar ett angivet antal etablerade dataflödesenheter (PTUs) görs en viss mängd slutsatsdragningsdataflöde tillgängligt för slutpunkten. Användningen av det här dataflödet baseras på en komplex formel som tar hänsyn till modellen, anropsfrekvensen för modellversionen, promptstorlek och generationsstorlek. För att förenkla den här beräkningen tillhandahåller vi ett användningsmått i Azure Monitor. Din distribution returnerar 429 på alla nya API-anrop när användningen överstiger 100 %. Den etablerade användningen definieras på följande sätt:

PTU-distributionsanvändning = (PTU:er som förbrukats under tidsperioden) / (PTU:er som distribuerats under tidsperioden)

Du hittar användningsmåttet i avsnittet Azure-Monitor för din resurs. Om du vill komma åt övervakningsinstrumentpanelerna loggar du in på https://portal.azure.com, går till din Azure OpenAI-resurs och väljer sidan Mätvärden i den vänstra navigeringsmenyn. På sidan för mått väljer du måttet "Provisionerad och hanterad användning V2". Om du har mer än en distribution i resursen bör du också dela upp värdena efter varje distribution genom att klicka på knappen Tillämpa delning.

Mer information om hur du övervakar dina distributioner finns på sidan Övervakning av Azure OpenAI .

Hantera hög användning

Provisionerade distributioner ger dig en allokerad mängd datorkapacitet för att köra en specifik modell. Måttet "Provisioned-Managed Utilization V2" i Azure Monitor mäter resursutnyttjandet av distributionen med en minuts intervall. Provisionerade och hanterade distributioner optimeras också så att anrop som accepteras bearbetas med en konsekvent maximal svarstid för varje anrop. När arbetsbelastningen överskrider sin allokerade kapacitet returnerar tjänsten en HTTP-statuskod på 429 tills användningen sjunker under 100 %. Tiden innan du försöker igen anges i svarshuvudena retry-after och retry-after-ms som anger tiden i sekunder respektive millisekunder. Den här metoden upprätthåller målen för svarstid per anrop samtidigt som utvecklaren får kontroll över hur man hanterar situationer med hög belastning – till exempel försök igen eller vidarekoppla till en annan upplevelse/slutpunkt.

Vad ska jag göra när jag får ett 429-svar?

Ett 429-svar anger att de allokerade PTU:erna förbrukas fullt ut vid tidpunkten för anropet. Svaret innehåller rubrikerna retry-after-ms och retry-after som talar om att det är dags att vänta innan nästa anrop godkänns. Hur du väljer att hantera ett 429-svar beror på dina programkrav. Här följer några överväganden:

- Om du är okej med längre svarstider per anrop implementerar du logik för återförsök på klientsidan för att vänta

retry-after-mstid och försöka igen. Med den här metoden kan du maximera dataflödet för distributionen. Microsoft-klient-SDK:er hanterar det redan med rimliga standardvärden. Du kan fortfarande behöva ytterligare justering baserat på dina användningsfall. - Överväg att omdirigera trafiken till andra modeller, distributioner eller upplevelser. Den här metoden är lösningen med lägsta svarstid eftersom den här åtgärden kan vidtas så snart du får 429-signalen. 429-signalen är inte ett oväntat felsvar vid hög användning, utan en del av designen för att hantera köer och hög belastning för provisionerade distributioner.

Ändra logik för återförsök i klientbiblioteken

Azure OpenAI-SDK:erna försöker som standard 429 svar igen och i bakgrunden i klienten (upp till maximalt antal återförsök). Biblioteken respekterar retry-after tiden. Du kan också ändra återförsöksbeteendet så att det passar din upplevelse bättre. Här är ett exempel med Python-biblioteket.

Du kan använda alternativet max_retries för att konfigurera eller inaktivera återförsöksinställningar:

from openai import AzureOpenAI

# Configure the default for all requests:

client = AzureOpenAI(

azure_endpoint = os.getenv("AZURE_OPENAI_ENDPOINT"),

api_key=os.getenv("AZURE_OPENAI_API_KEY"),

api_version="2024-10-21",

max_retries=5,# default is 2

)

# Or, configure per-request:

client.with_options(max_retries=5).chat.completions.create(

model="gpt-4", # model = "deployment_name".

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Does Azure OpenAI support customer managed keys?"},

{"role": "assistant", "content": "Yes, customer managed keys are supported by Azure OpenAI."},

{"role": "user", "content": "Do other Azure services support this too?"}

]

)

Kör ett prestandatest

De exakta prestanda- och dataflödesfunktionerna i din instans beror på vilken typ av begäran du gör och den exakta arbetsbelastningen. Det bästa sättet att fastställa genomströmningen för din arbetsbelastning är att köra ett benchmark på dina egna data.

För att hjälpa dig med det här arbetet är benchmarking-verktyget ett sätt att enkelt köra benchmarks på din distribution. Verktyget levereras med flera möjliga förkonfigurerade arbetsbelastningsformer och utdata för viktiga prestandamått. Läs mer om verktygs- och konfigurationsinställningarna i vår GitHub-lagringsplats: https://github.com/Azure/azure-openai-benchmark.

Vi rekommenderar följande arbetsflöde:

- Beräkna dina dataflödes-PTU:er med hjälp av kapacitetskalkylatorn.

- Kör ett prestandatest med det här trafikmönstret under en längre tidsperiod (tio minuter eller mer) för att observera resultaten i ett stabilt läge.

- Observera användningen, den bearbetade token och anropsfrekvensvärdena från benchmark-verktyget och Azure Monitor.

- Kör ett prestandatest med ditt eget trafikmönster och dina arbetsbelastningar med hjälp av din klientimplementering. Se till att implementera omprövningslogik med antingen ett Azure OpenAI-klientbibliotek eller anpassad logik.

Nästa steg

- Mer information om metodtips för molnprogram finns i Metodtips i molnprogram

- Mer information om tilldelade distributioner finns i Vad är tilldelad kapacitet?

- Mer information om logik för återförsök i varje SDK finns i: