Not

Åtkomst till den här sidan kräver auktorisering. Du kan prova att logga in eller ändra kataloger.

Åtkomst till den här sidan kräver auktorisering. Du kan prova att ändra kataloger.

Den här artikeln beskriver prestandabegrepp som Azure NetApp Files-databaser levererar för virtuella maskiner på Azure VMware-lösningen (AVS).

De testade scenarierna är som följer:

- En-till-många virtuella maskiner som körs på en enda AVS-värd och ett enda Azure NetApp Files-datalager

- En-till-flera Azure NetApp Files-databaser med en enda AVS-värd

- Skala ut Azure NetApp Files-databaser med flera AVS-värdar

Följande read:write I/O-förhållanden testades för varje scenario: 100:0, 75:25, 50:50, 25:75, 0:100

De benchmarks som dokumenteras i denna artikel utfördes med tillräcklig volymgenomströmning för att förhindra att mjuka gränser påverkar prestandan. Prestanda kan uppnås med Azure NetApp Files Premium- och Ultra-tjänstenivåer, och i vissa fall med Standard-tjänstenivån. För mer information om överföringskapacitet för volymer, se Prestationsöverväganden för Azure NetApp Files.

Konsultera Azure NetApp Files-datalagring för Azure VMware Solution TCO Estimator för att förstå dimensionering och de kostnadsfördelar som är förknippade med Azure NetApp Files-datalagringar.

Latens

Trafiklatensen från AVS till Azure NetApp Files-databaser varierar från under en millisekund (för miljöer med minimal belastning) upp till 2-3 millisekunder (för miljöer med medium till hög belastning). Latency kan vara potentiellt högre för miljöer som försöker överskrida genomflödesgränserna för olika komponenter. Latens och genomströmning kan variera beroende på faktorer som I/O-storlek, förhållandet mellan läsning och skrivning, konkurrerande nätverkstrafik och andra.

Prestandaskalning

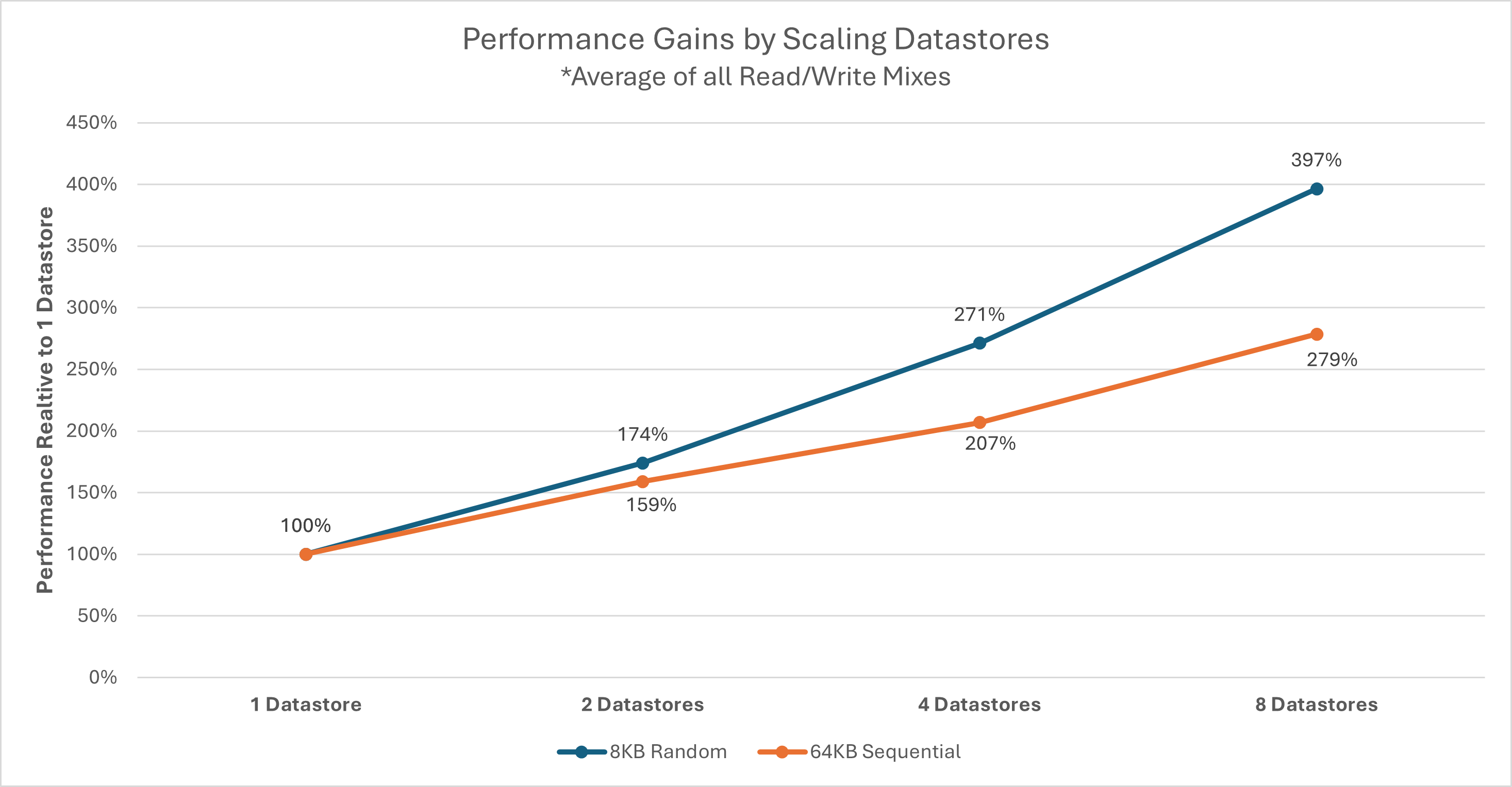

Varje AVS-värd ansluter till varje Azure NetApp Files-datastore med ett fast antal nätverksflöden, vilket kan begränsa en enskild VM-disks (VMDK) eller AVS-värdens genomströmning till varje datastore. Flera datalager kan behövas beroende på en given uppsättning arbetsbelastningar och deras prestandakrav. Den totala lagringsprestandan för varje AVS-värd kan ökas genom att sprida arbetsbelastningar över flera datalagringsplatser. Du kan också öka prestandan genom att sprida arbetsbelastningen till varje datalagringsenhet över AVS-värdar. Grafen nedan visar den relativa prestandaskalningen av ytterligare datalager.

Anmärkning

Genomströmningstak för externa datalagringsplatser kan begränsas av andra faktorer, inklusive nätverksbandbredd, SKU-begränsningar eller tjänstenivåtaken för Azure NetApp Files-volymer.

Genomströmning för varje enskild värd kan påverkas av den valda AVS SKU. AV64 SKU har nätverksgränssnittskort (NIC) med 100-Gigabit Ethernet (GbE). De andra SKU:erna har 25-GbE nätverkskort. Individuella nätverksflöden (såsom NFS-mountar) kan vara begränsade av 25-GbE NIC:ar.

AV64 miljödetaljer

Resultaten i den här artikeln uppnåddes med hjälp av följande miljökonfiguration.

- Azure VMware Solution värdstorlek: AV64 med VMware ESXi version 7u3

- Azure VMware-lösning för anslutning till privat moln: UltraPerformance-gateway med FastPath

- Gästvirtualmaskiner: Rocky Linux 9, 16 vCPU, 64 GB minne

- Belastningsgenerator:

fio3.35

Anmärkning

AV64-testerna fokuserar endast på utvärderingen av en enda ESXi-värd. Skalningen av antalet ESXi-värdar diskuteras i AV36-avsnittet.

En-till-flera Azure NetApp Files-databaser med en enda AV64-värd

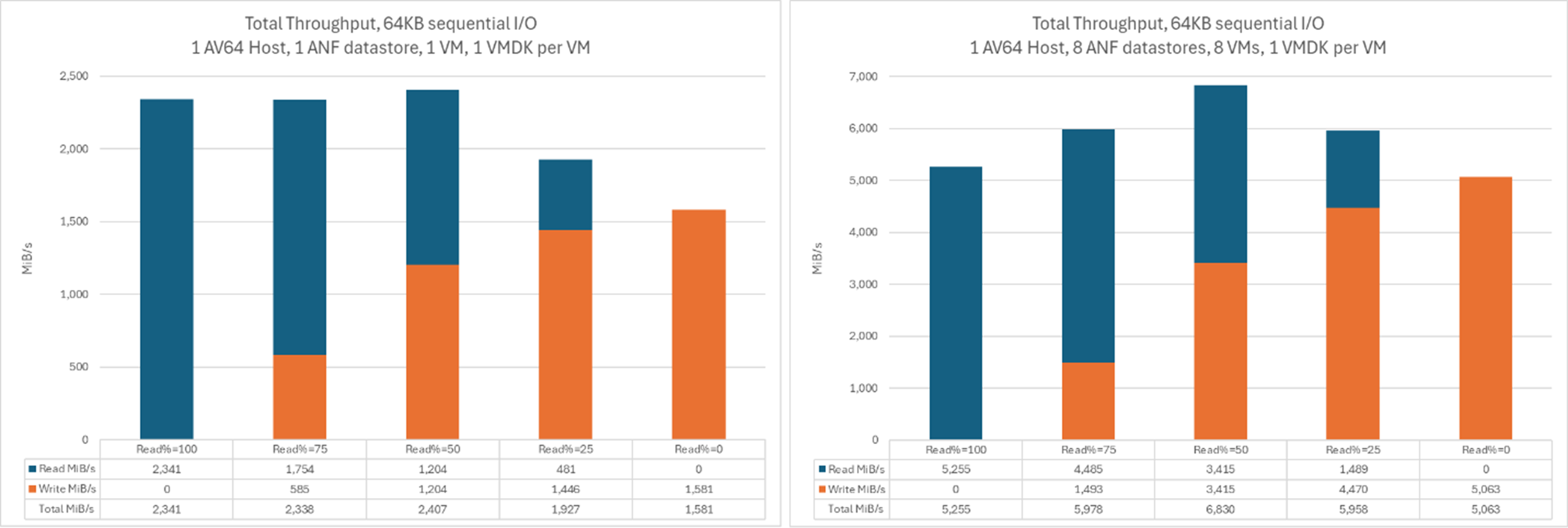

De följande diagrammen jämför genomströmningen för en enskild virtuell maskin på ett enda Azure NetApp Files-datalager med den aggregerade genomströmningen för åtta VM, var och en på sina egna Azure NetApp Files-datalager. Liknande genomströmning kan uppnås genom ett mindre antal virtuella maskiner (VM) med ytterligare virtuella diskkontroller (VMDK) spridda över samma antal datalagringssystem.

Denna graf jämför genomströmning:

Den här grafen jämför I/OPS:

Detaljer om AV36-miljö

Dessa tester genomfördes med en miljökonfiguration som använder

- Azure VMware Solution värdstorlek: AV36 som kör VMware ESXi version 7u3

- Azure VMware-lösning för anslutning till privat moln: UltraPerformance-gateway med FastPath

- Gäst-virtuella maskiner: Ubuntu 21.04, 16 virtuella CPU-kärnor, 64 GB minne

- Arbetsbelastningsgenerator:

fio

Ett-till-flera virtuella maskiner som körs på en enda AV36-värd och ett enda Azure NetApp Files-datalager

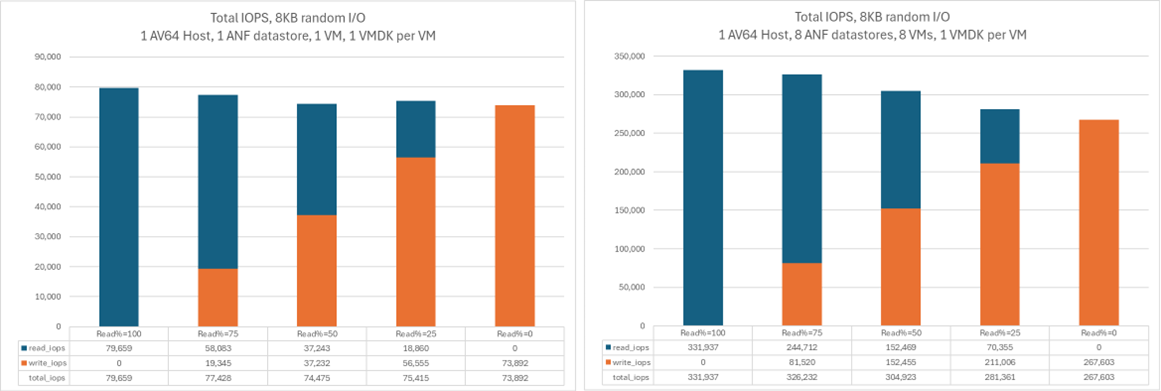

I ett scenario med en enda AVS-värd sker IO från AVS till Azure NetApp Files datalager över ett enda nätverksflöde. Dessa diagram jämför genomströmningen och I/O-operationerna för en enskild virtuell maskin med den aggregerade genomströmningen och I/O-operationerna för fyra virtuella maskiner. I de efterföljande scenarierna ökar antalet nätverksflöden i takt med att fler värdar och datalagrar läggs till.

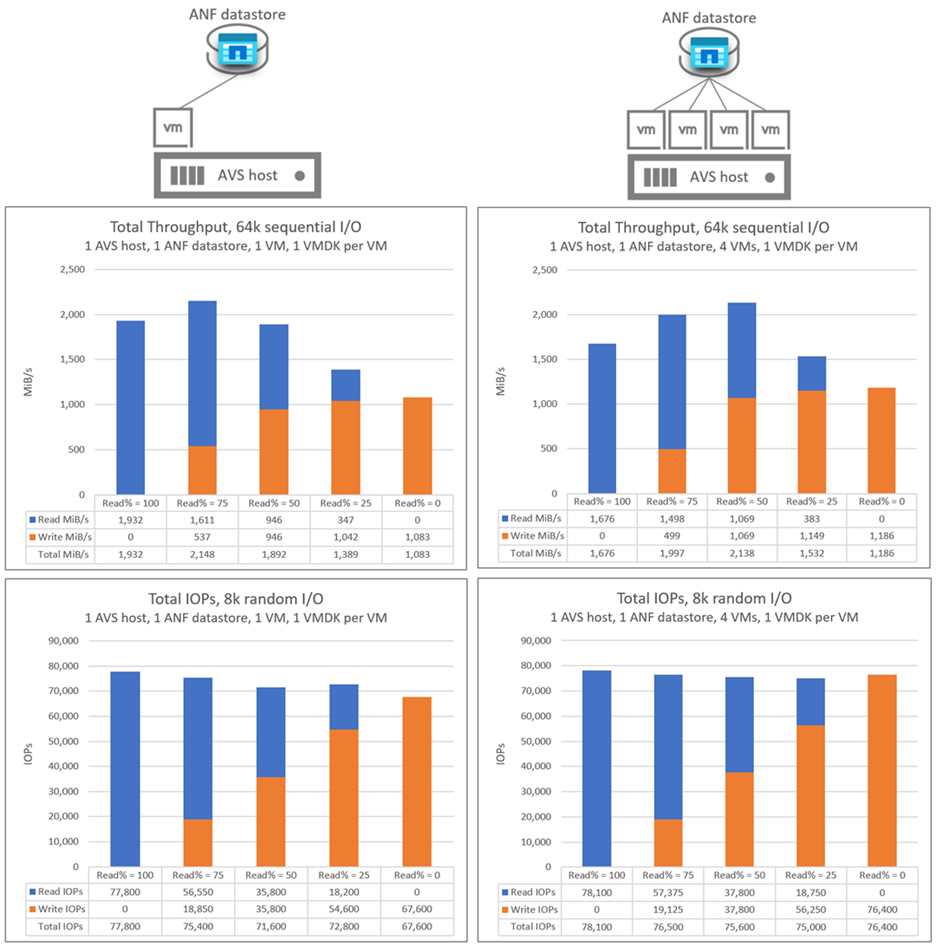

En-till-flera Azure NetApp Files databutiker med en enda AV36 värd

De följande graferna jämför genomströmningen av en enda virtuell maskin på ett enda Azure NetApp Files-datalager med den sammanlagda genomströmningen av fyra Azure NetApp Files-datalager. I båda scenarierna har varje virtuell maskin en VMDK på varje Azure NetApp Files datalager.

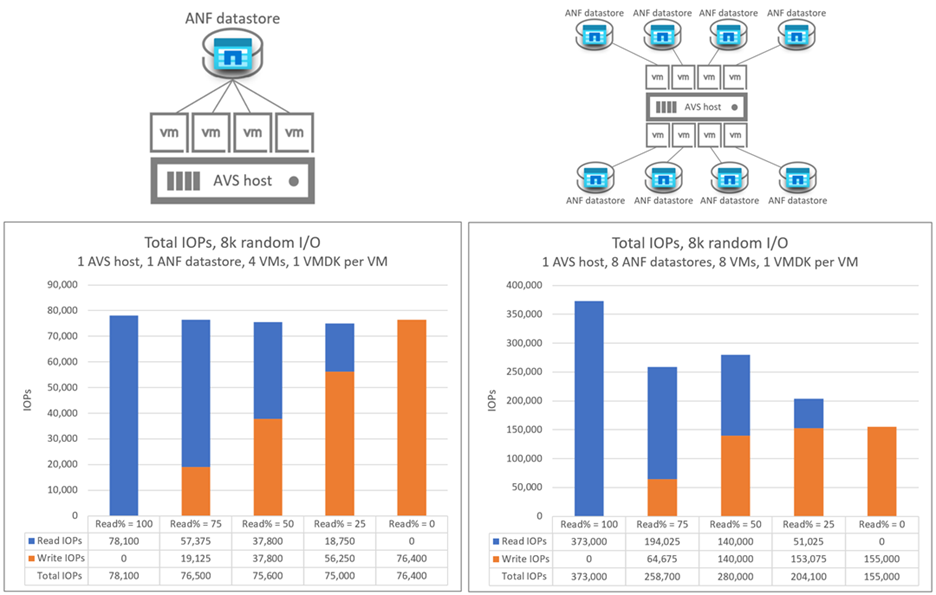

Följande diagram jämför I/OPS för en enda virtuell maskin på ett enda Azure NetApp Files-datastore med den aggregerade I/OPS för åtta Azure NetApp Files-datastore. I båda scenarierna har varje virtuell maskin en VMDK på varje Azure NetApp Files datalager.

Skala ut Azure NetApp Files-databaser med flera AV36-värdar

Följande diagram visar den aggregerade genomströmningen och I/OPS för 16 virtuella maskiner distribuerade över fyra AVS-värdar. Det finns fyra virtuella maskiner per AVS-värd, varje på en annan Azure NetApp Files-datastore. Nästan identiska resultat uppnåddes med en enda virtuell maskin på varje värd, med fyra VMDKs per virtuell maskin och var och en av dessa VMDKs på ett separat datalager.