Multimodala inbäddningar (version 4.0)

Multimodal inbäddning är processen att generera en numerisk representation av en bild som fångar dess funktioner och egenskaper i ett vektorformat. Dessa vektorer kodar innehållet och kontexten för en bild på ett sätt som är kompatibelt med textsökning över samma vektorutrymme.

Bildhämtningssystem har traditionellt använt funktioner som extraherats från bilderna, till exempel innehållsetiketter, taggar och bildbeskrivningar, för att jämföra bilder och rangordna dem efter likhet. Vektorlikhetssökning blir dock mer populärt på grund av ett antal fördelar jämfört med traditionell nyckelordsbaserad sökning och håller på att bli en viktig komponent i populära innehållssökningstjänster.

Vad är skillnaden mellan vektorsökning och nyckelordsbaserad sökning?

Nyckelordssökning är den mest grundläggande och traditionella metoden för informationshämtning. I den metoden söker sökmotorn efter den exakta matchningen av nyckelorden eller fraserna som användaren angav i sökfrågan och jämför den med de etiketter och taggar som tillhandahålls för bilderna. Sökmotorn returnerar sedan bilder som innehåller de exakta nyckelorden som innehållstaggar och bildetiketter. Nyckelordssökning är starkt beroende av användarens möjlighet att använda relevanta och specifika sökord.

Vektorsökning söker i stora samlingar med vektorer i högdimensionellt utrymme för att hitta vektorer som liknar en viss fråga. Vektorsökning söker efter semantiska likheter genom att samla in kontexten och innebörden av sökfrågan. Den här metoden är ofta effektivare än traditionella tekniker för bildhämtning, eftersom den kan minska sökutrymmet och förbättra resultatets noggrannhet.

Företagsprogram

Multimodal inbäddning har en mängd olika program i olika fält, inklusive:

- Hantering av digitala tillgångar: Multimodal inbäddning kan användas för att hantera stora samlingar av digitala bilder, till exempel på museer, arkiv eller onlinegallerier. Användare kan söka efter bilder baserat på visuella funktioner och hämta de bilder som matchar deras kriterier.

- Säkerhet och övervakning: Vektorisering kan användas i säkerhets- och övervakningssystem för att söka efter bilder baserat på specifika funktioner eller mönster, till exempel i, person- och objektspårning eller hotidentifiering.

- Hämtning av kriminaltekniska bilder: Vektorisering kan användas i kriminaltekniska undersökningar för att söka efter bilder baserat på deras visuella innehåll eller metadata, till exempel vid cyberbrott.

- E-handel: Vektorisering kan användas i online-shoppingprogram för att söka efter liknande produkter baserat på deras funktioner eller beskrivningar eller ge rekommendationer baserat på tidigare inköp.

- Mode och design: Vektorisering kan användas i mode och design för att söka efter bilder baserat på deras visuella funktioner, till exempel färg, mönster eller textur. Detta kan hjälpa designers eller återförsäljare att identifiera liknande produkter eller trender.

Varning

Multimodal inbäddning är inte utformad för att analysera medicinska bilder för diagnostiska funktioner eller sjukdomsmönster. Använd inte multimodal inbäddning för medicinska ändamål.

Vad är vektorbäddningar?

Vektorbäddningar är ett sätt att representera innehåll – text eller bilder – som vektorer för verkliga tal i ett högdimensionellt utrymme. Vektorinbäddningar lärs ofta från stora mängder textbaserade och visuella data med hjälp av maskininlärningsalgoritmer, till exempel neurala nätverk.

Varje dimension av vektorn motsvarar en annan funktion eller ett annat attribut för innehållet, till exempel dess semantiska betydelse, syntaktiska roll eller kontext där den ofta visas. I Azure AI Vision har inbäddning av bild- och textvektorer 1 024 dimensioner.

Viktigt!

Vektorinbäddningar kan bara jämföras och matchas om de kommer från samma modelltyp. Bilder som är vektoriserade av en modell kan inte sökas igenom en annan modell. Det senaste API:et för bildanalys erbjuder två modeller, en version 2023-04-15 som stöder textsökning på många språk och den äldre 2022-04-11 modellen som endast stöder engelska.

Hur fungerar det?

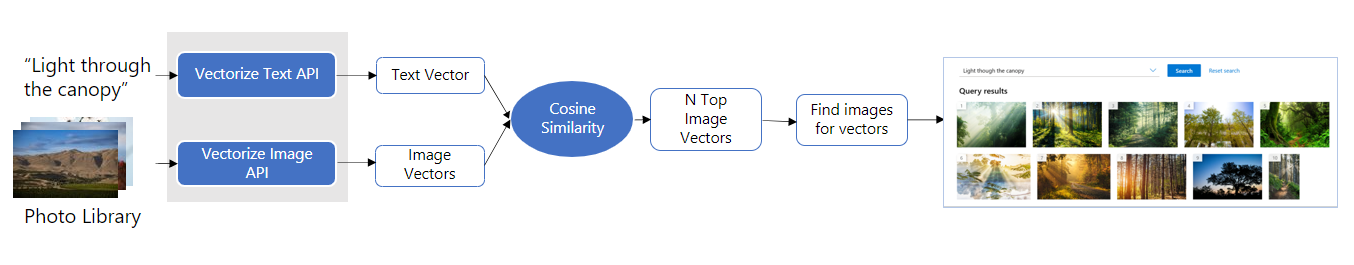

Följande är de viktigaste stegen i avbildningshämtningsprocessen med multimodala inbäddningar.

Vektorisera bilder och text: API:er för multimodala inbäddningar, VectorizeImage och VectorizeText, kan användas för att extrahera funktionsvektorer från en bild respektive text. API:erna returnerar en enda funktionsvektor som representerar hela indata.

Kommentar

Multimodal inbäddning utför inte någon biometrisk bearbetning av mänskliga ansikten. Information om ansiktsidentifiering och identifiering finns i Ansiktstjänsten för Azure AI.

Mät likhet: Vektorsöksystem använder vanligtvis avståndsmått, till exempel cosinusavstånd eller Euklidiska avstånd, för att jämföra vektorer och rangordna dem efter likhet. Vision Studio-demonstrationen använder cosinineavstånd för att mäta likheter.

Hämta bilder: Använd de översta N-vektorerna som liknar sökfrågan och hämta bilder som motsvarar dessa vektorer från ditt fotobibliotek för att tillhandahålla som slutresultatet.

Relevanspoäng

Tjänsterna för bild- och videohämtning returnerar ett fält med namnet "relevans". Termen "relevans" anger ett mått på likhetspoäng mellan en fråga och inbäddningar av bild- eller videoramar. Relevanspoängen består av två delar:

- Cosinélikiteten (som faller inom intervallet [0,1]) mellan inbäddningarna för fråge- och bild- eller videoramar.

- En metadatapoäng som återspeglar likheten mellan frågan och de metadata som är associerade med bilden eller videoramen.

Viktigt!

Relevanspoängen är ett bra mått för att rangordna resultat, till exempel bilder eller videoramar med avseende på en enskild fråga. Relevanspoängen kan dock inte jämföras korrekt mellan frågor. Därför går det inte att enkelt mappa relevanspoängen till en konfidensnivå. Det går inte heller att enkelt skapa en tröskelalgoritm för att eliminera irrelevanta resultat baserat enbart på relevanspoängen.

Indatakrav

Bildinmatning

- Filstorleken för avbildningen måste vara mindre än 20 MB (MB)

- Bildens dimensioner måste vara större än 10 x 10 bildpunkter och mindre än 16 000 x 16 000 bildpunkter

Text input

- Textsträngen måste vara mellan (inkluderande) ett ord och 70 ord.

Nästa steg

Aktivera multimodala inbäddningar för söktjänsten och följ stegen för att generera vektorinbäddningar för text och bilder.