Hur fungerar Azure Data Factory Workflow Orchestration Manager?

GÄLLER FÖR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dricks

Prova Data Factory i Microsoft Fabric, en allt-i-ett-analyslösning för företag. Microsoft Fabric omfattar allt från dataflytt till datavetenskap, realtidsanalys, business intelligence och rapportering. Lär dig hur du startar en ny utvärderingsversion kostnadsfritt!

Kommentar

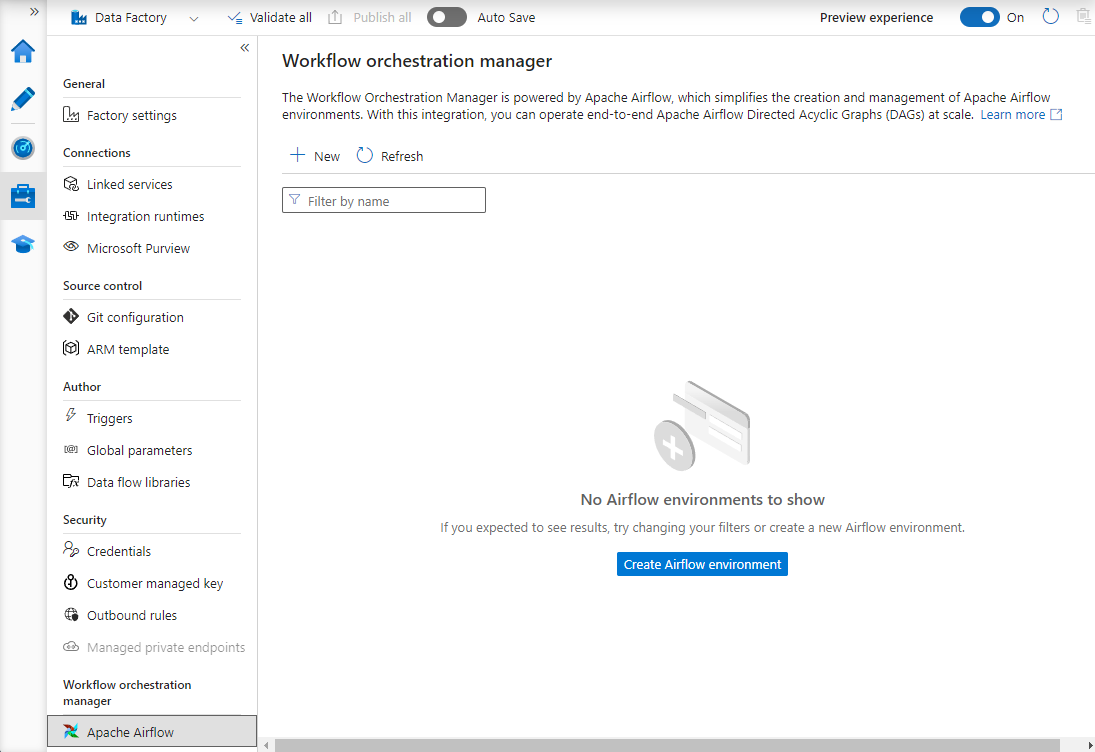

Workflow Orchestration Manager drivs av Apache Airflow.

Kommentar

Workflow Orchestration Manager för Azure Data Factory förlitar sig på öppen källkod Apache Airflow-programmet. Dokumentation och fler självstudier för Airflow finns på Apache Airflow-dokumentationen eller community-sidorna.

Workflow Orchestration Manager i Azure Data Factory använder Python-baserade Acyclic Graphs (DAG:er) för att köra dina orkestreringsarbetsflöden. Om du vill använda den här funktionen måste du ange dina DAG:er och plugin-program i Azure Blob Storage. Du kan starta Airflow-användargränssnittet från ADF med hjälp av ett kommandoradsgränssnitt (CLI) eller ett programutvecklingspaket (SDK) för att hantera dina DAG:er.

Skapa en Arbetsflödesorkestreringshanterare-miljö

Följande steg konfigurerar arbetsflödesorkestreringshanterarens miljö.

Förutsättningar

Azure-prenumeration: Om du inte har någon Azure-prenumeration kan du skapa ett kostnadsfritt konto innan du börjar. Skapa eller välj en befintlig Data Factory i den region där förhandsversionen av Workflow Orchestration Manager stöds.

Anvisningar för att skapa miljön

Skapa en ny Arbetsflödesorkestreringshanterare-miljö. Gå till Hantera hubb ->Airflow (förhandsversion) ->+Ny för att skapa en ny Airflow-miljö

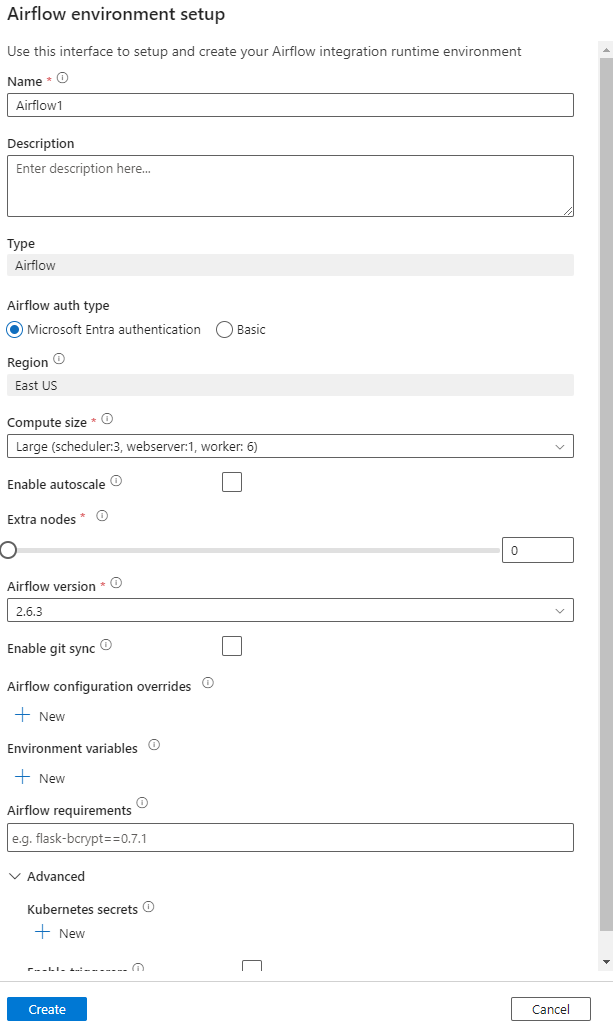

Ange information (Airflow-konfiguration)

Viktigt!

När du använder Grundläggande autentisering ska du komma ihåg användarnamnet och lösenordet som anges på den här skärmen. Du måste logga in senare i arbetsflödet Orchestration Manager-användargränssnittet. Standardalternativet är Microsoft Entra-ID och kräver inte att du skapar användarnamn/lösenord för din Airflow-miljö, utan i stället använder den inloggade användarens autentiseringsuppgifter till Azure Data Factory för att logga in/övervaka DAG:er.

Miljövariabler ett enkelt nyckelvärdelager i Airflow för att lagra och hämta godtyckligt innehåll eller inställningar.

Krav kan användas för att förinstallera Python-bibliotek. Du kan även uppdatera dessa senare.

Importera DAG:er

Följande steg beskriver hur du importerar DAG:er till Workflow Orchestration Manager.

Förutsättningar

Du måste ladda upp en exempel-DAG till ett tillgängligt lagringskonto (bör finnas under mappen dags).

Kommentar

Blob Storage bakom VNet stöds inte under förhandsversionen.

KeyVault-konfiguration i storageLinkedServices stöds inte för import av dags.

Exempel på Apache Airflow v2.x DAG. Exempel på Apache Airflow v1.10 DAG.

Steg för import

Kopiera och klistra in innehållet (antingen v2.x eller v1.10 baserat på airflow-miljön som du har konfigurerat) i en ny fil med namnet tutorial.py.

Ladda upp tutorial.py till en bloblagring. (Ladda upp en fil till blob)

Kommentar

Du måste välja en katalogsökväg från ett bloblagringskonto som innehåller mappar med namnet dags och plugin-program för att importera dem till Airflow-miljön. Plugin-program är inte obligatoriska. Du kan också ha en container med namnet dags och ladda upp alla Airflow-filer i den.

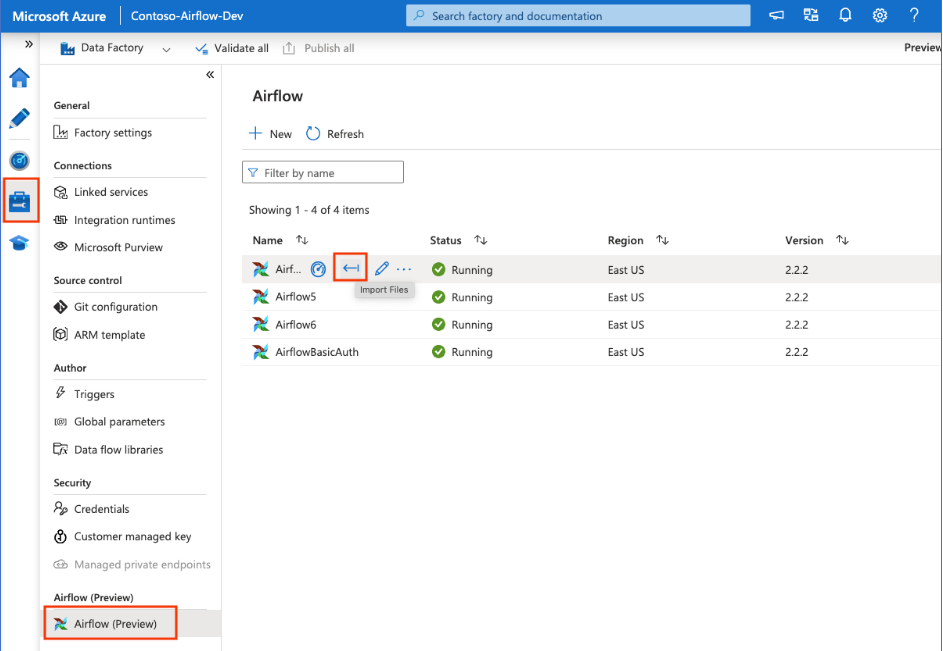

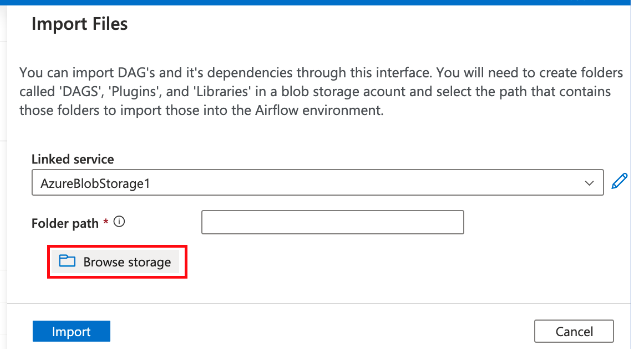

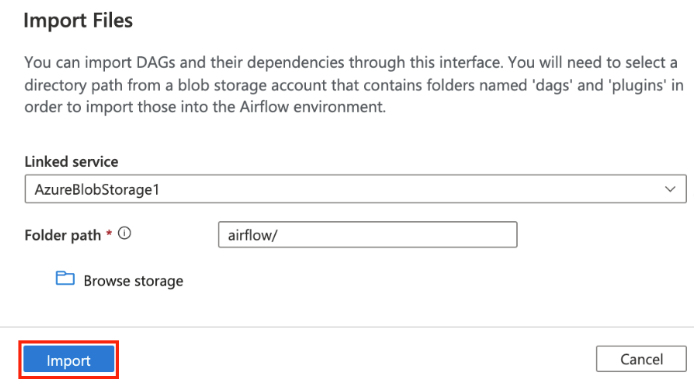

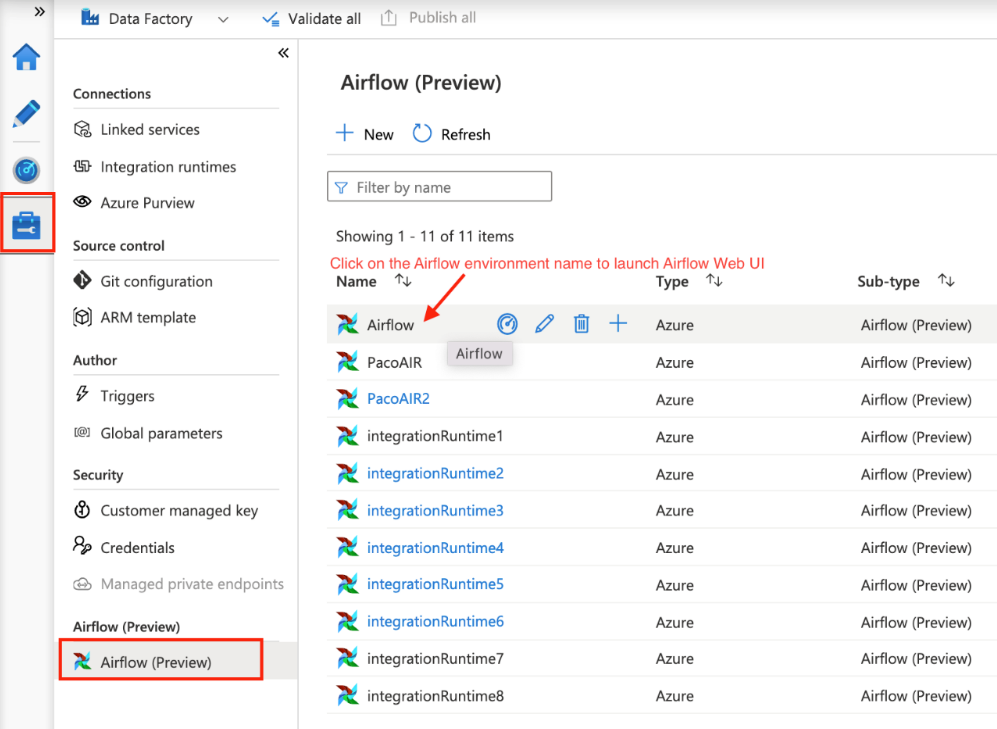

Välj på Airflow (förhandsversion) under Hantera hubb. Hovra sedan över den tidigare skapade Airflow-miljön och välj importera filer för att importera alla DAG:er och beroenden till Airflow-miljön.

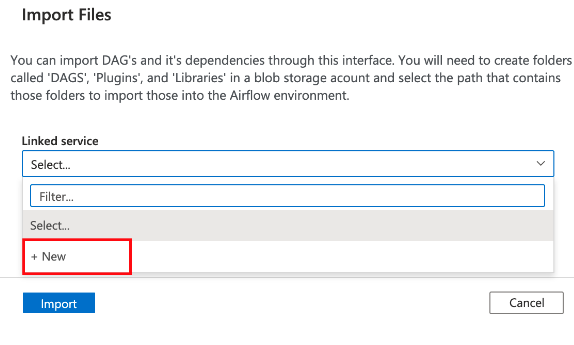

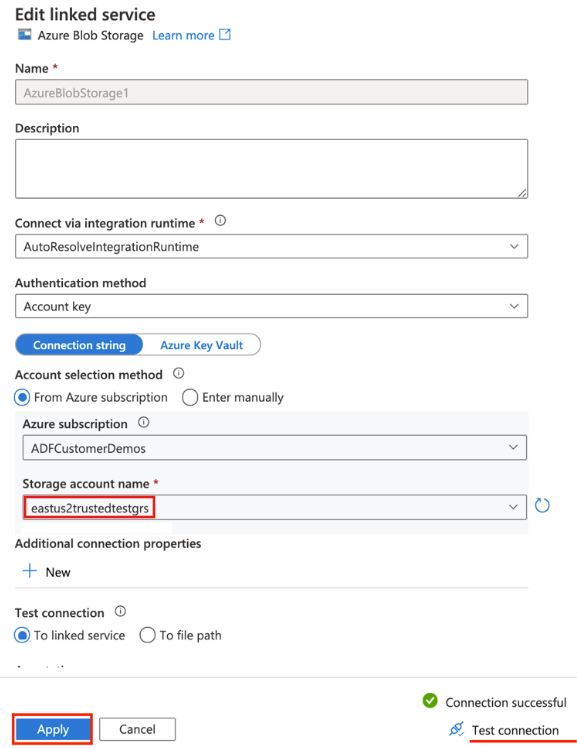

Skapa en ny länkad tjänst till det tillgängliga lagringskontot som anges i förutsättningen (eller använd en befintlig om du redan har egna DAG:er).

Använd lagringskontot där du laddade upp DAG (kontrollera förutsättningen). Testa anslutningen och välj sedan Skapa.

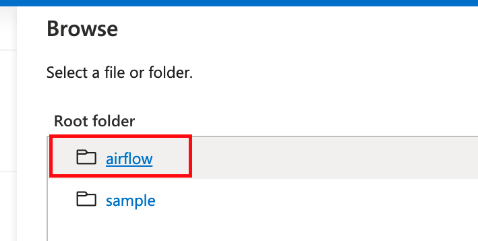

Bläddra och välj luftflöde om du använder SAS-exempel-URL:en eller väljer mappen som innehåller mappen dags med DAG-filer.

Kommentar

Du kan importera DAG:er och deras beroenden via det här gränssnittet. Du måste välja en katalogsökväg från ett bloblagringskonto som innehåller mappar med namnet dags och plugin-program för att importera dem till Airflow-miljön. Plugin-program är inte obligatoriska.

Kommentar

Det kan ta några minuter att importera DAG:er under förhandsversionen. Meddelandecentret (klockikonen i ADF-användargränssnittet) kan användas för att spåra uppdateringar av importstatus.

Felsöka problem med import-DAG

Problem: DAG-importen tar över 5 minuter: Minska storleken på de importerade DAG:erna med en enda import. Ett sätt att uppnå detta är genom att skapa flera DAG-mappar med mindre DAG:er i flera containrar.

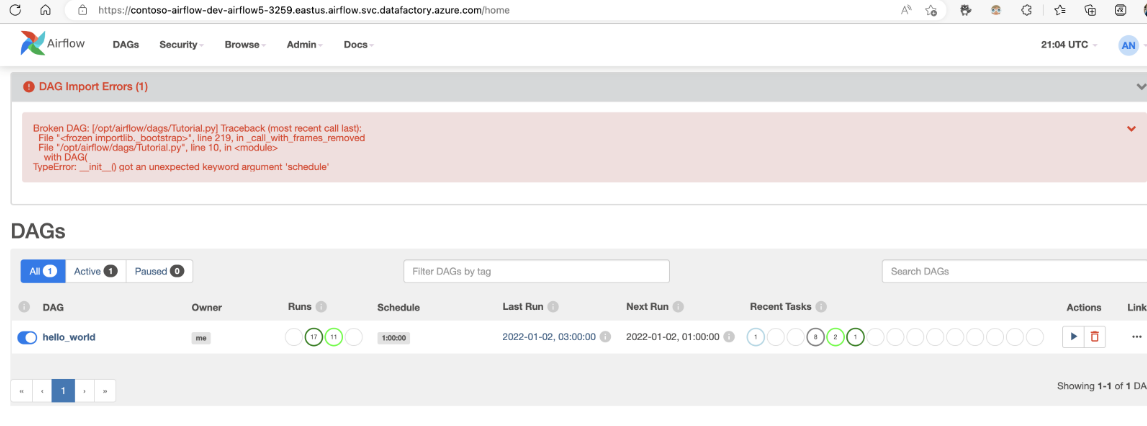

Problem: Importerade DAG:er visas inte när du loggar in i Airflow-användargränssnittet. Åtgärd: Logga in i airflow-användargränssnittet och se om det finns några DAG-parsningsfel. Detta kan inträffa om DAG-filerna innehåller någon inkompatibel kod. Du hittar de exakta radnumren och filerna, som har problemet via Airflow-användargränssnittet.

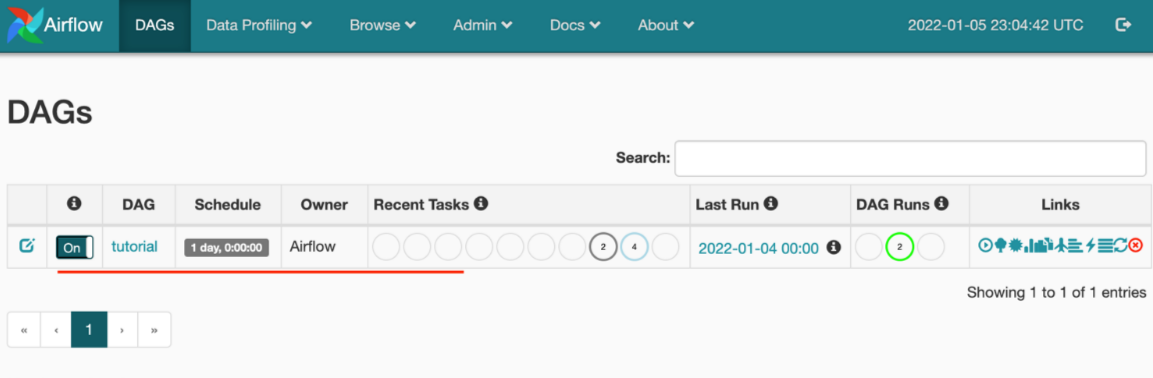

Övervaka DAG-körningar

Om du vill övervaka Airflow DAG:er loggar du in i Airflow-användargränssnittet med det tidigare skapade användarnamnet och lösenordet.

Välj i den Airflow-miljö som skapats.

Logga in med det användarnamn och lösenord som angavs när Airflow Integration Runtime skapades. (Du kan återställa användarnamnet eller lösenordet genom att redigera Airflow Integration-körningen om det behövs)

Ta bort DAG:er från airflow-miljön

Om du använder Airflow version 1.x, tar bort DAG:er som distribueras i valfri Airflow-miljö (IR) måste du ta bort DAG:erna på två olika platser.

- Ta bort DAG från Airflow-användargränssnittet

- Ta bort DAG i ADF-användargränssnittet

Kommentar

Det här är den aktuella upplevelsen under den offentliga förhandsversionen och vi kommer att förbättra den här upplevelsen.