Not

Åtkomst till den här sidan kräver auktorisering. Du kan prova att logga in eller ändra kataloger.

Åtkomst till den här sidan kräver auktorisering. Du kan prova att ändra kataloger.

Viktigt!

Den här sidan innehåller instruktioner för att hantera Azure IoT Operations-komponenter med hjälp av Kubernetes-distributionsmanifest, som finns i förhandsversion. Den här funktionen har flera begränsningar och bör inte användas för produktionsarbetsbelastningar.

Juridiska villkor för Azure-funktioner i betaversion, förhandsversion eller som av någon annan anledning inte har gjorts allmänt tillgängliga ännu finns i kompletterande användningsvillkor för Microsoft Azure-förhandsversioner.

Ett dataflöde är den sökväg som data tar från källan till målet med valfria transformeringar. Du kan konfigurera dataflödet genom att skapa en anpassad dataflödesresurs eller använda webbgränssnittet för driftsmiljön. Ett dataflöde består av tre delar: källan, omvandlingen och målet.

För att definiera källan och målet måste du konfigurera dataflödesslutpunkterna. Omvandlingen är valfri och kan omfatta åtgärder som att berika data, filtrera data och mappa data till ett annat fält.

Viktigt!

Varje dataflöde måste ha standardslutpunkten för Azure IoT Operations local MQTT Broker som antingen källa eller mål.

Du kan använda driftupplevelsen i Azure IoT Operations för att skapa ett dataflöde. Driftupplevelsen ger ett visuellt gränssnitt för att konfigurera dataflödet. Du kan också använda Bicep för att skapa ett dataflöde med en Bicep-fil eller använda Kubernetes för att skapa ett dataflöde med hjälp av en YAML-fil.

Fortsätt läsa för att lära dig hur du konfigurerar källan, omvandlingen och målet.

Förutsättningar

Du kan distribuera dataflöden så snart du har en instans av Azure IoT Operations med hjälp av standardprofilen och slutpunkten för dataflödet. Du kanske dock vill konfigurera dataflödesprofiler och slutpunkter för att anpassa dataflödet.

Dataflödesprofil

Om du inte behöver olika skalningsinställningar för dina dataflöden använder du standardprofilen för dataflöde som tillhandahålls av Azure IoT Operations. Du bör undvika att associera för många dataflöden med en enda dataflödesprofil. Om du har ett stort antal dataflöden distribuerar du dem över flera dataflödesprofiler för att minska risken för att överskrida konfigurationsstorleksgränsen för dataflödesprofilen på 70.

Information om hur du konfigurerar en ny dataflödesprofil finns i Konfigurera dataflödesprofiler.

Slutpunkter för dataflöde

Dataflödesslutpunkter krävs för att konfigurera källan och målet för dataflödet. För att komma igång snabbt kan du använda standardslutpunkten för dataflöde för den lokala MQTT-koordinatorn. Du kan också skapa andra typer av dataflödesslutpunkter som Kafka, Event Hubs, OpenTelemetry eller Azure Data Lake Storage. Information om hur du konfigurerar varje typ av dataflödesslutpunkt finns i Konfigurera dataflödesslutpunkter.

Kom igång

När du har förutsättningar kan du börja skapa ett dataflöde.

Om du vill skapa ett dataflöde i driftmiljön väljer du Dataflöde>Skapa dataflöde.

Välj platshållarnamnet new-data-flow för att ange dataflödesegenskaperna. Ange namnet på dataflödet och välj den dataflödesprofil som ska användas. Standardprofilen för dataflöde är markerad som standard. Mer information om dataflödesprofiler finns i Konfigurera dataflödesprofil.

Viktigt!

Du kan bara välja dataflödesprofilen när du skapar ett dataflöde. Du kan inte ändra dataflödesprofilen när dataflödet har skapats. Om du vill ändra dataflödesprofilen för ett befintligt dataflöde tar du bort det ursprungliga dataflödet och skapar ett nytt med den nya dataflödesprofilen.

Konfigurera käll-, transformerings- och målslutpunkten för dataflödet genom att välja objekten i dataflödesdiagrammet.

Läs följande avsnitt om du vill lära dig hur du konfigurerar åtgärdstyperna för dataflödet.

Källa

Om du vill konfigurera en källa för dataflödet anger du slutpunktsreferensen och en lista över datakällor för slutpunkten. Välj något av följande alternativ som källa för dataflödet.

Om standardslutpunkten inte används som källa måste den användas som mål. Mer information om hur du använder den lokala MQTT-koordinatorslutpunkten finns i Dataflöden måste använda den lokala MQTT-koordinatorslutpunkten.

Alternativ 1: Använd standardslutpunkten för meddelandeköer som källa

Under Källinformation väljer du Meddelandehanterare.

Ange följande inställningar för meddelandemäklarens källa:

Inställning beskrivning Slutpunkt för dataflöde Välj standard för att använda standard MQTT-meddelandemäklarens slutpunkt. Ämne Ämnesfiltret som du vill prenumerera på för inkommande meddelanden. Använd Ämne(er)>Lägg till rad för att lägga till flera ämnen. Mer information om ämnen finns i Konfigurera MQTT- eller Kafka-ämnen. Meddelandeschema Schemat som ska användas för att deserialisera inkommande meddelanden. Se Ange schema för att deserialisera data. Välj Använd.

Eftersom dataSources gör att du kan ange MQTT- eller Kafka-ämnen utan att ändra slutpunktskonfigurationen kan du återanvända slutpunkten för flera dataflöden även om ämnena är olika. Mer information finns i Konfigurera datakällor.

Alternativ 2: Använd tillgången som källa

Du kan använda en tillgång som källa för dataflödet. Användning av en tillgång som källa är endast tillgängligt i driftupplevelsen.

Under Källinformation väljer du Tillgång.

Välj den tillgång som du vill använda som källslutpunkt.

Välj Fortsätt.

En lista över datapunkter för den valda tillgången visas.

Välj Använd för att använda tillgången som källslutpunkt.

När du använder en tillgång som källa används tillgångsdefinitionen för att härleda schemat för dataflödet. Tillgångsdefinitionen innehåller schemat för tillgångens datapunkter. Mer information finns i Hantera tillgångskonfigurationer via fjärranslutning.

När den är konfigurerad når data från enheten dataflödet via den lokala MQTT-mäklaren. När du använder en tillgång som källa använder dataflödet därför den lokala standardslutpunkten för MQTT-koordinatorn som källa i verkligheten.

Alternativ 3: Använd anpassad MQTT- eller Kafka-dataflödesslutpunkt som källa

Om du har skapat en anpassad MQTT- eller Kafka-dataflödesslutpunkt (till exempel för att använda med Event Grid eller Event Hubs) kan du använda den som källa för dataflödet. Kom ihåg att slutpunkter av lagringstyp, till exempel Data Lake eller Fabric OneLake, inte kan användas som källa.

Under Källinformation väljer du Meddelandehanterare.

Ange följande inställningar för meddelandemäklarens källa:

Inställning beskrivning Slutpunkt för dataflöde Använd knappen Välj om för att välja en anpassad MQTT- eller Kafka-dataflödesslutpunkt. Mer information finns i Konfigurera MQTT-dataflödesslutpunkter eller Konfigurera Azure Event Hubs- och Kafka-dataflödesslutpunkter. Ämne Ämnesfiltret som du vill prenumerera på för inkommande meddelanden. Använd Ämne(er)>Lägg till rad för att lägga till flera ämnen. Mer information om ämnen finns i Konfigurera MQTT- eller Kafka-ämnen. Meddelandeschema Schemat som ska användas för att deserialisera inkommande meddelanden. Se Ange schema för att deserialisera data. Välj Använd.

Konfigurera datakällor (MQTT- eller Kafka-ämnen)

Du kan ange flera MQTT- eller Kafka-ämnen i en källa utan att behöva ändra dataflödesslutpunktskonfigurationen. Den här flexibiliteten innebär att samma slutpunkt kan återanvändas i flera dataflöden, även om ämnena varierar. Mer information finns i Återanvända dataflödesslutpunkter.

MQTT-ämnen

När källan är en MQTT-slutpunkt (Event Grid ingår) kan du använda MQTT-ämnesfiltret för att prenumerera på inkommande meddelanden. Ämnesfiltret kan innehålla jokertecken för att prenumerera på flera ämnen. Till exempel thermostats/+/sensor/temperature/# prenumererar på alla temperatursensormeddelanden från termostater. Så här konfigurerar du MQTT-ämnesfilter:

I dataflödesinformationen för operativ erfarenhet väljMeddelandehanterare och använd sedan fältet Topic(s) för att ange MQTT-topicfiltren som ska prenumerera på inkommande meddelanden. Du kan lägga till flera MQTT-ämnen genom att välja Lägg till rad och ange ett nytt ämne.

Delade prenumerationer

Om du vill använda delade prenumerationer med meddelandemäklar-källor kan du ange det delade prenumerationsämnet i form av $shared/<GROUP_NAME>/<TOPIC_FILTER>.

I dataflödet för operativ erfarenhet väljer du Meddelandehanterare och använder fältet Ämne för att ange den delade prenumerationsgruppen och ämnet.

Om antalet instanser i dataflödesprofilen är större än en aktiveras den delade prenumerationen automatiskt för alla dataflöden som använder en meddelandekökälla. I det här fallet läggs prefixet $shared till och namnet på den delade prenumerationsgruppen genereras automatiskt. Om du till exempel har en dataflödesprofil med instansantalet 3 och ditt dataflöde använder en slutpunkt för meddelandekö som källa konfigurerad med ämnen topic1 och topic2konverteras de automatiskt till delade prenumerationer som $shared/<GENERATED_GROUP_NAME>/topic1 och $shared/<GENERATED_GROUP_NAME>/topic2.

Du kan uttryckligen skapa ett ämne med namnet $shared/mygroup/topic i konfigurationen. Det rekommenderas dock inte att lägga till ämnet $shared explicit eftersom prefixet $shared läggs till automatiskt när det behövs. Dataflöden kan göra optimeringar med gruppnamnet om det inte har angetts. Till exempel $share är inte inställt och dataflöden behöver bara köras över ämnesnamnet.

Viktigt!

Dataflöden som kräver delad prenumeration när antalet instanser är större än ett är viktigt när du använder Event Grid MQTT-koordinator som källa eftersom det inte stöder delade prenumerationer. För att undvika att missa meddelanden, ange antalet instanser av dataflödesprofilen till ett när du använder Event Grid MQTT-broker som källa. Det är när dataflödet fungerar som prenumerant och tar emot meddelanden från molnet.

Kafka-ämnen

När källan är en Kafka-slutpunkt (inklusive Event Hubs) anger du de enskilda Kafka-ämnena som ska prenumerera på inkommande meddelanden. Jokertecken stöds inte, så du måste ange varje ämne statiskt.

Anmärkning

När du använder Event Hubs via Kafka-slutpunkten är varje enskild händelsehubb i namnområdet en Kafka-ämne. Om du till exempel har ett Event Hubs-namnområde med två händelsehubbar thermostats och humidifierskan du ange varje händelsehubb som ett Kafka-ämne.

Så här konfigurerar du Kafka-ämnena:

I dataflödet för driftserfarenheter Source details väljer du Meddelandehanterare, använd sedan fältet Ämne för att ange Kafka-ämnesfiltret som du vill prenumerera på för inkommande meddelanden.

Anmärkning

Endast ett ämnesfilter kan anges i driftmiljön. Om du vill använda flera ämnesfilter använder du Bicep eller Kubernetes.

Ange källschema

När du använder MQTT eller Kafka som källa kan du ange ett schema för att visa listan över datapunkter i webbgränssnittet för driftupplevelsen. Det finns för närvarande inte stöd för att använda ett schema för att deserialisera och verifiera inkommande meddelanden.

Om källan är en tillgång härleds schemat automatiskt från tillgångsdefinitionen.

Tips

Om du vill generera schemat från en exempeldatafil använder du schemagenhjälpen.

Så här konfigurerar du schemat som används för att deserialisera inkommande meddelanden från en källa:

I dataflödet för driftserfarenhet väljer du Meddelandemäklare och använder Meddelandeschemafältet för att specificera schemat. Du kan använda knappen Ladda upp för att ladda upp en schemafil först. Mer information finns i Förstå meddelandescheman.

Mer information finns i Förstå meddelandescheman.

Begära diskpersistence

Begäran om diskbeständighet låter datapipelines behålla sitt tillstånd över omstarter. När du aktiverar den här funktionen återhämtar diagrammet bearbetningsstatus om den anslutna mäklaren startar om. Den här funktionen är användbar för tillståndskänsliga bearbetningsscenarier där det är ett problem att förlora mellanliggande data. När du aktiverar begärandediskpersistence bevarar mäklaren MQTT-data, till exempel meddelanden i prenumerantkön, till disken. Den här metoden ser till att dataflödets datakälla inte förlorar data vid strömavbrott eller brokeromstarter. Mäklaren upprätthåller optimala prestanda eftersom beständighet har konfigurerats per dataflöde, så endast de dataflöden som behöver beständighet använder den här funktionen.

Dataflödesdiagrammet begär denna beständighet under prenumerationen med hjälp av en MQTTv5-användaregenskap. Den här funktionen fungerar bara när:

- Dataflödet använder MQTT-mäklaren eller tillgången som källa

- MQTT-koordinatorn har beständighet aktiverad med dynamiskt beständighetsläge inställt på

Enabledför datatypen, som prenumerantköer.

Med den här konfigurationen kan MQTT-klienter som dataflöden begära diskpersistence för sina prenumerationer med hjälp av MQTTv5-användaregenskaper. Mer information om konfiguration av MQTT-koordinatorpersistence finns i Konfigurera MQTT-koordinatorpersistence.

Inställningen accepterar Enabled eller Disabled.

Disabled används som standard.

När du skapar eller redigerar ett dataflöde väljer du Redigera och sedan Ja bredvid Begär datapersistence.

Omvandling

Transformeringsåtgärden är den plats där du kan transformera data från källan innan du skickar dem till målet. Transformeringar är valfria. Om du inte behöver göra ändringar i data ska du inte inkludera transformeringsåtgärden i dataflödeskonfigurationen. Flera transformeringar länkas samman i steg oavsett i vilken ordning de anges i konfigurationen. Stegens ordning är alltid:

- Berika: Lägg till ytterligare data till källdata med en datauppsättning och ett villkor som ska matchas.

- Filter: Filtrera data baserat på ett villkor.

- Mappa, beräkna, byt namn på eller lägg till en ny egenskap: Flytta data från ett fält till ett annat med en valfri konvertering.

Det här avsnittet är en introduktion till dataflödestransformering. Mer detaljerad information finns i Mappa data med hjälp av dataflöden, Konvertera data med hjälp av dataflödeskonverteringar och Berika data med hjälp av dataflöden.

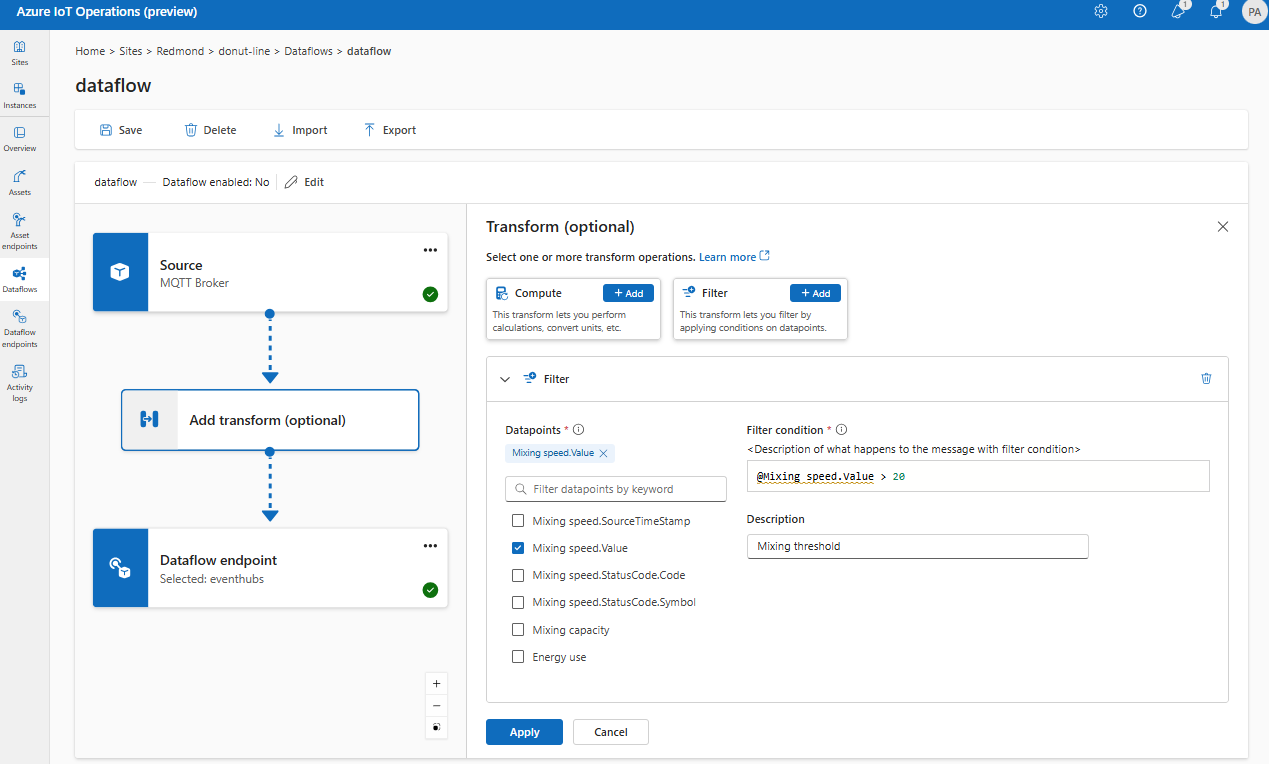

I driftupplevelsen väljer du Dataflöde>Lägg till transformering (valfritt).

Berika: Lägga till referensdata

Om du vill utöka data lägger du först till referensdatauppsättningen i Azure IoT Operations State Store. Datauppsättningen används för att lägga till extra data i källdata baserat på ett villkor. Villkoret anges som ett fält i källdata som matchar ett fält i datamängden.

Du kan läsa in exempeldata i tillståndslagret med hjälp av state store CLI. Nyckelnamn i tillståndslagret motsvarar en datauppsättning i dataflödeskonfigurationen.

För närvarande stöds inte Enrich-fasen i driftupplevelsen.

Om datamängden har en post med fältet asset , ungefär som:

{

"asset": "thermostat1",

"location": "room1",

"manufacturer": "Contoso"

}

Data från källan med fältet som matchar deviceId har fälten thermostat1 och location tillgängliga i filter- och kartläggningsfaser.

Mer information om villkorssyntax finns i Berika data med hjälp av dataflöden och Konvertera data med hjälp av dataflöden.

Filter: Filtrera data baserat på ett villkor

Om du vill filtrera data på ett villkor kan du använda filter fasen. Villkoret anges som ett fält i källdata som matchar ett värde.

Under Transformera (valfritt) väljer du Filtrera>lägg till.

Ange de inställningar som krävs.

Inställning beskrivning Filtervillkor Villkoret för att filtrera data baserat på ett fält i källdata. beskrivning Ange en beskrivning för filtervillkoret. I fältet för filtervillkor anger du

@eller väljer Ctrl + Blanksteg för att välja datapunkter från en listruta.Du kan ange MQTT-metadataegenskaper med formatet

@$metadata.user_properties.<property>eller@$metadata.topic. Du kan också ange $metadata rubriker med formatet@$metadata.<header>. Syntaxen$metadatabehövs bara för MQTT-egenskaper som ingår i meddelandehuvudet. Mer information finns i fältreferenser.Villkoret kan använda fälten i källdata. Du kan till exempel använda ett filtervillkor som

@temperature > 20att filtrera data som är mindre än eller lika med 20 baserat på temperaturfältet.Välj Använd.

Karta: Flytta data från ett fält till ett annat

Om du vill mappa data till ett annat fält med valfri konvertering kan du använda åtgärden map . Konverteringen anges som en formel som använder fälten i källdata.

Inom driftmiljön stöds mappning för närvarande med hjälp av transformeringar av Compute, Byt namn och Ny egenskap.

Räkna ut

Du kan använda beräkningstransformningen för att tillämpa en formel på källdata. Den här åtgärden används för att tillämpa en formel på källdata och lagra resultatfältet.

Under Transformera (valfritt), välj Beräkna>Lägg till.

Ange de inställningar som krävs.

Inställning beskrivning Välj formel Välj en befintlig formel i listrutan eller välj Anpassad för att ange en formel manuellt. Utdata Ange utdatavisningsnamnet för resultatet. Formel Ange formeln som ska tillämpas på källdata. beskrivning Ange en beskrivning för omvandlingen. Senast kända värde Du kan också använda det senast kända värdet om det aktuella värdet inte är tillgängligt. Du kan ange eller redigera en formel i fältet Formel . Formeln kan använda fälten i källdata. Ange

@eller välj Ctrl + Blanksteg för att välja datapunkter i en listruta. För inbyggda formler väljer du<dataflow>platshållaren för att se listan över tillgängliga datapunkter.Du kan ange MQTT-metadataegenskaper med formatet

@$metadata.user_properties.<property>eller@$metadata.topic. Du kan också ange $metadata rubriker med formatet@$metadata.<header>. Syntaxen$metadatabehövs bara för MQTT-egenskaper som ingår i meddelandehuvudet. Mer information finns i fältreferenser.Formeln kan använda fälten i källdata. Du kan till exempel använda

temperaturefältet i källdata för att konvertera temperaturen till Celsius och lagra den itemperatureCelsiusutdatafältet.Välj Använd.

Byt namn

Du kan byta namn på en datapunkt genom att använda transformeringen Byt namn. Den här åtgärden används för att byta namn på en datapunkt i källdata till ett nytt namn. Det nya namnet kan användas i efterföljande steg i dataflödet.

Under Transformera (valfritt) väljer du Byt namn>Lägg till.

Ange de inställningar som krävs.

Inställning beskrivning Datapunkt Välj en datapunkt i listrutan eller ange ett $metadata sidhuvud. Nytt datapunktsnamn Ange det nya namnet för datapunkten. beskrivning Ange en beskrivning för omvandlingen. Du kan ange MQTT-metadataegenskaper med formatet

@$metadata.user_properties.<property>eller@$metadata.topic. Du kan också ange $metadata rubriker med formatet@$metadata.<header>. Syntaxen$metadatabehövs bara för MQTT-egenskaper som ingår i meddelandehuvudet. Mer information finns i fältreferenser.Välj Använd.

Ny egenskap

Du kan lägga till en ny egenskap i källdata med hjälp av transformering av ny egenskap . Den här åtgärden används för att lägga till en ny egenskap i källdata. Den nya egenskapen kan användas i efterföljande steg i dataflödet.

Under Transformera (valfritt) väljer du Ny egenskap>Lägg till.

Ange de inställningar som krävs.

Inställning beskrivning Egenskapsnyckel Ange nyckeln för den nya egenskapen. Egenskapsvärde Ange värdet för den nya egenskapen. beskrivning Ange en beskrivning för den nya egenskapen. Välj Använd.

Mer information finns i Mappa data med hjälp av dataflöden och Konvertera data med hjälp av dataflöden.

Ta bort

Som standard ingår alla datapunkter i utdataschemat. Du kan ta bort valfri datapunkt från målet med hjälp av transformeringen Ta bort .

Under Transformera (valfritt) väljer du Ta bort.

Välj den datapunkt som du vill ta bort från utdataschemat.

Välj Använd.

Mer information finns i Mappa data med hjälp av dataflöden och Konvertera data med hjälp av dataflöden.

Serialisera data enligt ett schema

Om du vill serialisera data innan du skickar dem till målet måste du ange ett schema- och serialiseringsformat. Annars serialiseras data i JSON med de typer som härleds. Lagringsslutpunkter som Microsoft Fabric eller Azure Data Lake kräver ett schema för att säkerställa datakonsekvens. Serialiseringsformat som stöds är Parquet och Delta.

Tips

Om du vill generera schemat från en exempeldatafil använder du schemagenhjälpen.

För driftupplevelse anger du schema- och serialiseringsformatet i information om dataflödesslutpunkten. Slutpunkterna som stöder serialiseringsformat är Microsoft Fabric OneLake, Azure Data Lake Storage Gen 2, Azure Data Explorer och lokal lagring. Om du till exempel vill serialisera data i Delta-format måste du ladda upp ett schema till schemaregistret och referera till dem i slutpunktskonfigurationen för dataflödet.

Mer information om schemaregistret finns i Förstå meddelandescheman.

Resmål

Om du vill konfigurera ett mål för dataflödet anger du slutpunktsreferensen och datamålet. Du kan ange en lista över datamål för slutpunkten.

Om du vill skicka data till ett annat mål än den lokala MQTT-koordinatorn skapar du en dataflödesslutpunkt. Mer information finns i Konfigurera dataflödesslutpunkter. Om målet inte är den lokala MQTT-koordinatorn måste det användas som källa. Mer information om hur du använder den lokala MQTT-koordinatorslutpunkten finns i Dataflöden måste använda den lokala MQTT-koordinatorslutpunkten.

Viktigt!

Lagringsslutpunkter kräver ett schema för serialisering. Om du vill använda dataflöde med Microsoft Fabric OneLake, Azure Data Lake Storage, Azure Data Explorer eller Lokal lagring måste du ange en schemareferens.

Välj den dataflödesslutpunkt som ska användas som mål.

Lagringsslutpunkter kräver ett schema för serialisering. Om du väljer en Microsoft Fabric OneLake-, Azure Data Lake Storage-, Azure Data Explorer- eller Local Storage-målslutpunkt måste du ange en schemareferens. Om du till exempel vill serialisera data till en Microsoft Fabric-slutpunkt i Delta-format måste du ladda upp ett schema till schemaregistret och referera till dem i dataflödets slutpunktskonfiguration.

Välj Fortsätt för att konfigurera målet.

Ange de inställningar som krävs för målet, inklusive det ämne eller den tabell som data ska skickas till. Mer information finns i Konfigurera datamål (ämne, container eller tabell).

Konfigurera datamål (ämne, container eller tabell)

Precis som datakällor är datamål ett begrepp som används för att hålla dataflödesslutpunkterna återanvändbara över flera dataflöden. I princip representerar den underkatalogen i dataflödesslutpunktskonfigurationen. Om dataflödesslutpunkten till exempel är en lagringsslutpunkt är datamålet tabellen i lagringskontot. Om dataflödesslutpunkten är en Kafka-slutpunkt är destinationen för datan Kafka-ämnet.

| Slutpunktstyp | Betydelse av datamål | beskrivning |

|---|---|---|

| MQTT (eller Event Grid) | Ämne | MQTT-ämnet där data skickas. Stöder både statiska ämnen och dynamisk ämnesöversättning med variabler som ${inputTopic} och ${inputTopic.index}. Mer information finns i Avsnitt om dynamiskt mål. |

| Kafka (eller Event Hubs) | Ämne | Kafka-ämnet där data skickas. Endast statiska ämnen stöds, och inga jokertecken är tillåtna. Om slutpunkten är ett Event Hubs-namnområde är datamålet den enskilda händelsehubben i namnområdet. |

| Azure Data Lake Storage | Behållare | Containern i lagringskontot. Inte bordet. |

| Microsoft Fabric OneLake | Tabell eller mapp | Motsvarar den konfigurerade sökvägstypen för slutpunkten. |

| Öppna Azure-datautforskaren | Tabell | Tabellen i Azure Data Explorer-databasen. |

| Lokal lagring | Mapp | Mapp- eller katalognamnet i den lokala lagringsbeständiga volymmonteringen. När du använder Azure Container Storage som aktiveras av Azure Arc Cloud Ingest Edge-volymer måste detta matcha parametern spec.path för den delvolym som du skapade. |

| OpenTelemetry | Ämne | Ämnet OpenTelemetry där data skickas. Endast statiska ämnen stöds. |

Så här konfigurerar du datamålet:

När du använder driftupplevelsen tolkas datamålfältet automatiskt baserat på slutpunktstypen. Om dataflödesslutpunkten till exempel är en lagringsslutpunkt uppmanas du på sidan med målinformation att ange containernamnet. Om dataflödesslutpunkten är en MQTT-slutpunkt uppmanar målinformationssidan dig att ange ämnet och så vidare.

Ämnen om dynamiska destinationer

För MQTT-slutpunkter kan du använda dynamiska ämnesvariabler i dataDestination fältet för att dirigera meddelanden baserat på källämnesstrukturen. Följande variabler är tillgängliga:

-

${inputTopic}– Det fullständiga ursprungliga ingångsämnet -

${inputTopic.index}– Ett segment av ingångsämnet (index börjar vid 1)

Till exempel processed/factory/${inputTopic.2} dirigerar meddelanden från factory/1/data till processed/factory/1. Ämnessegment är 1 indexerade och inledande/avslutande snedstreck ignoreras.

Om det inte går att matcha en ämnesvariabel (till exempel ${inputTopic.5} när indataämnet bara har tre segment) tas meddelandet bort och en varning loggas. Jokertecken (# och +) tillåts inte i målämnen.

Anmärkning

Tecknen $, {och } är giltiga i MQTT-ämnesnamn, så ett ämne som factory/$inputTopic.2 är acceptabelt men felaktigt om du avsåg att använda variabeln dynamiskt ämne.

Exempel

Följande exempel är en dataflödeskonfiguration som använder MQTT-slutpunkten för källan och målet. Källan filtrerar data från MQTT-ämnet azure-iot-operations/data/thermostat. Omvandlingen konverterar temperaturen till Fahrenheit och filtrerar data där temperaturen multiplicerat med luftfuktigheten är mindre än 100000. Mottagaren skickar data till MQTT-ämnet factory.

Fler exempel på dataflödeskonfigurationer finns i Azure REST API – Dataflöde och snabbstarten Bicep.

Kontrollera att ett dataflöde fungerar

Följ Handledning: Bi-directional MQTT-bridge till Azure Event Grid för att verifiera att dataflödet fungerar.

Exportera dataflödeskonfiguration

Om du vill exportera dataflödeskonfigurationen kan du använda driftupplevelsen eller genom att exportera den anpassade dataflödesresursen.

Välj det dataflöde som du vill exportera och välj Exportera i verktygsfältet.

Korrekt dataflödeskonfiguration

Kontrollera följande för att säkerställa att dataflödet fungerar som förväntat:

- Standardslutpunkten för MQTT-dataflöde måste användas som källa eller mål.

- Dataflödesprofilen finns och refereras i dataflödeskonfigurationen.

- Källan är antingen en MQTT-slutpunkt, Kafka-slutpunkt eller en tillgång. Slutpunkter av lagringstyp kan inte användas som källa.

- När du använder Event Grid som källa anges dataflödesprofilens instansantal till 1 eftersom Event Grid MQTT-mäklare inte stöder delade prenumerationer.

- När du använder Event Hubs som källa är varje händelsehubb i namnområdet ett separat Kafka-ämne och måste anges som datakälla.

- Transformering, om den används, konfigureras med rätt syntax, inklusive korrekt undflyende av specialtecken.

- När du använder slutpunkter av lagringstyp som mål, anges ett schema.

- När du använder dynamiska målämnen för MQTT-slutpunkter kontrollerar du att ämnesvariabler refererar till giltiga segment.