Bearbeta data på gränsen med Azure IoT Data Processor Preview-pipelines

Viktigt!

Förhandsversion av Azure IoT Operations – aktiverad av Azure Arc finns för närvarande i FÖRHANDSVERSION. Du bör inte använda den här förhandsgranskningsprogramvaran i produktionsmiljöer.

Juridiska villkor för Azure-funktioner i betaversion, förhandsversion eller som av någon annan anledning inte har gjorts allmänt tillgängliga ännu finns i kompletterande användningsvillkor för Microsoft Azure-förhandsversioner.

Industriella tillgångar genererar data i många olika format och använder olika kommunikationsprotokoll. Den här mångfalden av datakällor, tillsammans med varierande scheman och enhetsmått, gör det svårt att använda och analysera rådata effektivt. Av efterlevnads-, säkerhets- och prestandaskäl kan du inte heller ladda upp alla datauppsättningar till molnet.

För att bearbeta dessa data krävs traditionellt dyr, komplex och tidskrävande datateknik. Förhandsversionen av Azure IoT Data Processor är en konfigurerbar databehandlingstjänst som kan hantera komplexiteten och mångfalden i industriella data. Använd dataprocessorn för att göra data från olika källor mer begripliga, användbara och värdefulla.

Vad är Förhandsversion av Azure IoT Data Processor?

Förhandsversionen av Azure IoT Data Processor är en komponent i förhandsversionen av Azure IoT Operations. Med dataprocessorn kan du aggregera, berika, normalisera och filtrera data från dina enheter. Dataprocessor är en pipelinebaserad databearbetningsmotor som gör att du kan bearbeta data vid gränsen innan du skickar dem till de andra tjänsterna antingen vid gränsen eller i molnet:

Dataprocessorn matar in strömmande data i realtid från källor som OPC UA-servrar, historiker och andra industriella system. Den normaliserar dessa data genom att konvertera olika dataformat till ett standardiserat, strukturerat format, vilket gör det enklare att fråga och analysera. Dataprocessorn kan också kontextualisera data och utöka dem med referensdata eller senast kända värden (LKV) för att ge en omfattande vy över din industriella verksamhet.

Utdata från dataprocessorn är rena, berikade och standardiserade data som är redo för underordnade program, till exempel realtidsanalys- och insiktsverktyg. Dataprocessorn minskar avsevärt den tid som krävs för att omvandla rådata till användbara insikter.

Viktiga funktioner för dataprocessor är:

Flexibel datanormalisering för att konvertera flera dataformat till en standardiserad struktur.

Berika dataströmmar med referens- eller LKV-data för att förbättra kontexten och ge bättre insikter.

Inbyggd Microsoft Fabric-integrering för att förenkla analysen av rena data.

Möjlighet att bearbeta data från olika källor och publicera data till olika mål.

Som en dataagnostisk databearbetningsplattform kan dataprocessorn mata in data i valfritt format, bearbeta data och sedan skriva ut dem till ett mål. För att stödja dessa funktioner kan dataprocessorn deserialisera och serialisera olika format. Den kan till exempel serialisera till parquet för att skriva filer till Microsoft Fabric.

Automatiska och konfigurerbara återförsöksprinciper för att hantera tillfälliga fel när data skickas till molnmål.

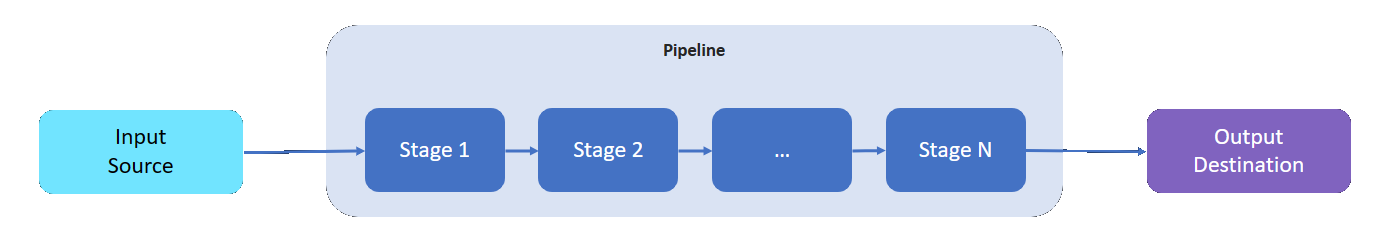

Vad är en pipeline?

En databehandlingspipeline har en indatakälla där den läser data från, ett mål där den skriver bearbetade data till och ett variabelt antal mellanliggande steg för att bearbeta data.

Mellanstegen representerar de olika tillgängliga databehandlingsfunktionerna:

- Du kan lägga till så många mellanliggande steg som du behöver i en pipeline.

- Du kan beställa mellanliggande steg i en pipeline efter behov. Du kan ändra ordning på faserna när du har skapat en pipeline.

- Varje steg följer ett definierat implementeringsgränssnitt och ett schemakontrakt för indata/utdata.

- Varje fas är oberoende av de andra stegen i pipelinen.

- Alla steg fungerar inom omfånget för en partition. Data delas inte mellan olika partitioner.

- Data flödar endast från en fas till nästa.

Dataprocessorpipelines kan använda följande steg:

| Fas | beskrivning |

|---|---|

| Källa – MQ | Hämtar data från en MQTT-koordinator. |

| Källa – HTTP-slutpunkt | Hämtar data från en HTTP-slutpunkt. |

| Källa – SQL | Hämtar data från en Microsoft SQL Server-databas. |

| Källa – InfluxDB | Hämtar data från en InfluxDB-databas. |

| Filter | Filtrerar data som kommer genom fasen. Du kan till exempel filtrera bort alla meddelanden med temperatur utanför 50F-150F intervallet. |

| Omvandla | Normaliserar datastrukturen. Du kan till exempel ändra strukturen från {"Name": "Temp", "value": 50} till {"temp": 50}. |

| LKV | Lagrar valda måttvärden i ett LKV-lager. Lagra till exempel endast temperatur- och luftfuktighetsmätningar i LKV och ignorera resten. En efterföljande fas kan berika ett meddelande med lagrade LKV-data. |

| Berika | Utökar meddelanden med data från referensdatalagret. Du kan till exempel lägga till ett operatornamn och ett partinummer från driftdatauppsättningen. |

| Sammansättning | Aggregerar värden som passerar genom fasen. När temperaturvärden till exempel skickas var 100:e millisekunder avger du ett mått för genomsnittlig temperatur var 30:e sekund. |

| Ta en pratbubb | Anropar en extern HTTP- eller gRPC-tjänst. Anropa till exempel en Azure-funktion för att konvertera från ett anpassat meddelandeformat till JSON. |

| Mål – MQ | Skriver dina bearbetade, rena och kontextualiserade data till ett MQTT-ämne. |

| Mål – referens | Skriver dina bearbetade data till det inbyggda referensarkivet. Andra pipelines kan använda referensarkivet för att utöka sina meddelanden. |

| Mål – gRPC | Skickar dina bearbetade, rena och kontextualiserade data till en gRPC-slutpunkt. |

| Mål – HTTP | Skickar dina bearbetade, rena och kontextualiserade data till en HTTP-slutpunkt. |

| Mål – Fabric Lakehouse | Skickar dina bearbetade, rena och kontextualiserade data till ett Microsoft Fabric Lakehouse i molnet. |

| Mål – Azure Data Explorer | Skickar dina bearbetade, rena och kontextualiserade data till en Azure Data Explorer-slutpunkt i molnet. |

| Mål – Azure Blob Storage | Skickar dina bearbetade, rena och kontextualiserade data till en Azure Blob Storage-slutpunkt i molnet. |

Gå vidare

Information om hur du provar pipelines för databehandling finns i snabbstarterna för Azure IoT Operations.

Mer information om databehandling finns i: