Hämta utökad generation med Hjälp av Azure Mašinsko učenje promptflöde (förhandsversion)

Viktigt!

Den här funktionen är för närvarande i allmänt tillgänglig förhandsversion. Den här förhandsversionen tillhandahålls utan ett serviceavtal och vi rekommenderar det inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade.

Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

RAG (Retrieval Augmented Generation) är ett mönster som fungerar med förtränad storspråksmodeller (LLM) och dina egna data för att generera svar. I Azure Machine Learning kan du nu implementera RAG i ett promptflöde. Stöd för RAG finns för närvarande i en allmänt tillgänglig förhandsversion.

Den här artikeln innehåller några av fördelarna med RAG, ger en teknisk översikt och beskriver RAG-support i Azure Mašinsko učenje.

Kommentar

Är llm- och RAG-begreppen nya? Det här videoklippet från en Microsoft-presentation ger en enkel förklaring.

Varför ska jag använda RAG?

Traditionellt tränas en basmodell med tidpunktsdata för att säkerställa dess effektivitet när det gäller att utföra specifika uppgifter och anpassa sig till önskad domän. Ibland måste du dock arbeta med nyare eller mer aktuella data. Två metoder kan komplettera basmodellen: finjustering eller vidareutbildning av basmodellen med nya data, eller RAG som använder snabbteknik för att komplettera eller vägleda modellen i realtid.

Finjustering är lämplig för kontinuerlig domänanpassning, vilket möjliggör betydande förbättringar av modellkvaliteten men ofta medför högre kostnader. Omvänt erbjuder RAG en alternativ metod som gör det möjligt att använda samma modell som en resonemangsmotor framför nya data som tillhandahålls i en prompt. Den här tekniken möjliggör kontextinlärning utan att behöva dyr finjustering, vilket gör det möjligt för företag att använda LLM:er mer effektivt.

RAG gör det möjligt för företag att uppnå anpassade lösningar samtidigt som de bibehåller datarelevans och optimerar kostnaderna. Genom att använda RAG kan företag använda resonemangsfunktionerna i LLM:er, använda sina befintliga modeller för att bearbeta och generera svar baserat på nya data. RAG underlättar regelbundna datauppdateringar utan behov av finjustering, vilket effektiviserar integreringen av LLM:er i företag.

- Ange kompletterande data som ett direktiv eller en uppmaning till LLM

- Lägger till en faktakontrollkomponent i dina befintliga modeller

- Träna din modell på aktuella data utan att orsaka extra tid och kostnader för finjustering

- Träna på dina affärsspecifika data

Teknisk översikt över hur du använder RAG på stora språkmodeller (LLM: er)

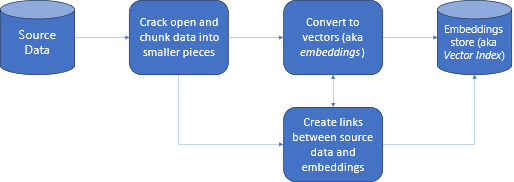

Vid informationshämtning är RAG en metod som gör att du kan utnyttja kraften hos LLM:er med dina egna data. Att aktivera en LLM för åtkomst till anpassade data omfattar följande steg. Först ska stora data delas upp i hanterbara delar. För det andra måste segmenten konverteras till ett sökbart format. För det tredje ska konverterade data lagras på en plats som ger effektiv åtkomst. Dessutom är det viktigt att lagra relevanta metadata för citat eller referenser när LLM tillhandahåller svar.

Låt oss titta närmare på diagrammet.

Källdata: det är här dina data finns. Det kan vara en fil/mapp på datorn, en fil i molnlagring, en Azure Mašinsko učenje-datatillgång, en Git-lagringsplats eller en SQL-databas.

Datasegmentering: Data i källan måste konverteras till oformaterad text. Orddokument eller PDF-filer måste till exempel vara öppna och konverterade till text. Texten segmenteras sedan i mindre delar.

Konvertera texten till vektorer: kallas inbäddningar. Vektorer är numeriska representationer av begrepp som konverteras till talsekvenser, vilket gör det enkelt för datorer att förstå relationerna mellan dessa begrepp.

Länkar mellan källdata och inbäddningar: Den här informationen lagras som metadata i de segment som skapas och används sedan för att hjälpa LLM:erna att generera citat när svar genereras.

RAG med Azure Mašinsko učenje (förhandsversion)

RAG i Azure Mašinsko učenje aktiveras genom integrering med Azure OpenAI Service för stora språkmodeller och vektorisering, med stöd för Faiss och Azure AI Search (tidigare Cognitive Search) som vektorlager och stöd för verktyg och ramverk för erbjudanden med öppen källkod, till exempel LangChain för datasegmentering.

För att implementera RAG måste några viktiga krav uppfyllas. För det första bör data formateras på ett sätt som möjliggör effektiv sökbarhet innan de skickas till LLM, vilket i slutändan minskar tokenförbrukningen. För att säkerställa effektiviteten hos RAG är det också viktigt att regelbundet uppdatera dina data regelbundet. Om du har möjlighet att utvärdera utdata från LLM med hjälp av dina data kan du dessutom mäta effektiviteten i dina tekniker. Med Azure Mašinsko učenje kan du inte bara enkelt komma igång med dessa aspekter, utan du kan också förbättra och produktionsanpassa RAG. Azure Mašinsko učenje-erbjudanden:

- Exempel för att starta RAG-baserade Q&A-scenarier.

- Guidebaserad användargränssnittsupplevelse för att skapa och hantera data och införliva dem i promptflöden.

- Möjlighet att mäta och förbättra RAG-arbetsflöden, inklusive generering av testdata, automatisk skapande av frågor och visualiserade mått för snabbutvärdering.

- Avancerade scenarier med mer kontroll med hjälp av de nya inbyggda RAG-komponenterna för att skapa anpassade pipelines i notebook-filer.

- Kodupplevelse, som möjliggör användning av data som skapats med erbjudanden med öppen källkod, till exempel LangChain.

- Sömlös integrering av RAG-arbetsflöden i MLOps-arbetsflöden med hjälp av pipelines och jobb.

Slutsats

Med Azure Mašinsko učenje kan du införliva RAG i din AI med hjälp av Azure Mašinsko učenje Studio eller använda kod med Azure Mašinsko učenje pipelines. Det erbjuder flera värdetillägg som möjligheten att mäta och förbättra RAG-arbetsflöden, testa datagenerering, skapa automatiska frågor och visualisera mått för snabbutvärdering. Det möjliggör integrering av RAG-arbetsflöden i MLOps-arbetsflöden med hjälp av pipelines. Du kan också använda dina data med erbjudanden med öppen källkod som LangChain.

Nästa steg

Använda Vector Stores med Azure Mašinsko učenje (förhandsversion)

Så här skapar du vektorindex i Azure Mašinsko učenje promptflöde (förhandsversion)

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för