Självstudie: Skriva till en Delta-tabell som lagras i Azure Data Lake Storage Gen2

Den här självstudien visar hur du kan skapa ett Stream Analytics-jobb för att skriva till en Delta-tabell i Azure Data Lake Storage Gen2. I den här självstudien lär du dig att:

- Distribuera en händelsegenerator som skickar exempeldata till din händelsehubb

- Skapa ett Stream Analytics-jobb

- Konfigurera Azure Data Lake Storage Gen2 med en deltatabell

- Köra Stream Analytics-jobbet

Förutsättningar

Slutför följande steg innan du börjar:

- Om du inte har någon Azure-prenumeration kan du skapa ett kostnadsfritt konto.

- Distribuera TollApp-händelsegeneratorn till Azure och använd den här länken för att distribuera TollApp Azure-mall. Ange parametern intervall till 1. Skapa och använd en ny resursgrupp för det här steget.

- Skapa ett Data Lake Storage Gen2-konto.

Skapa ett Stream Analytics-jobb

Logga in på Azure-portalen.

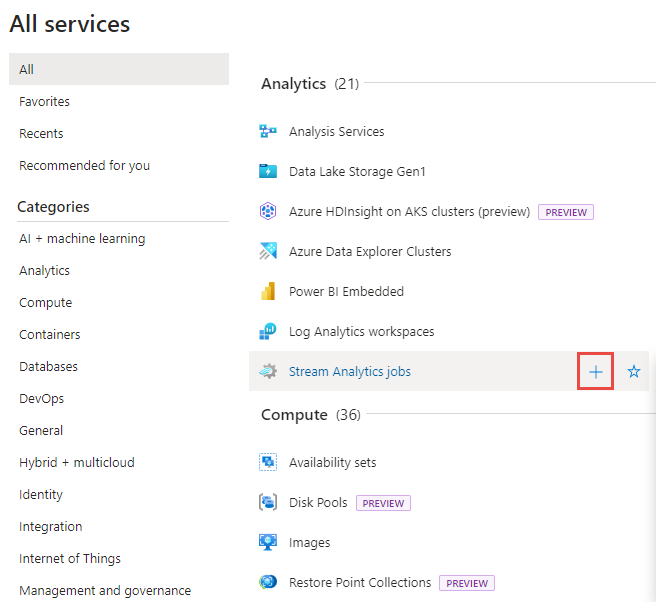

Välj Alla tjänster på den vänstra menyn.

Flytta musen över Stream Analytics-jobb i avsnittet Analys och välj + (plus).

Klicka på Skapa en resurs längst upp till vänster i Azure-portalen.

Välj Analytics>Stream Analytics-jobb i resultatlistan.

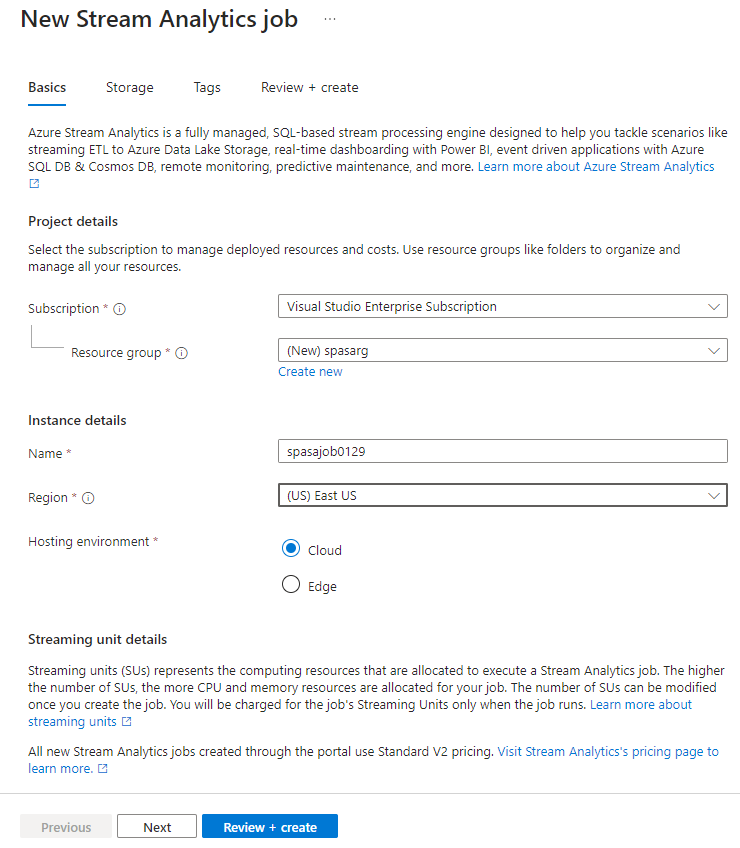

Följ dessa steg på sidan Nytt Stream Analytics-jobb :

- För Prenumeration väljer du din Azure-prenumeration.

- För Resursgrupp väljer du samma resurs som du använde tidigare i TollApp-distributionen.

- Som Namn anger du ett namn för jobbet. Stream Analytics-jobbets namn får enbart innehålla alfanumeriska tecken, bindestreck och understreck och måste vara mellan 3 och 63 tecken långt.

- För Värdmiljö kontrollerar du att Molnet är valt.

- För Stream-enheter väljer du 1. Strömningsenheter representerar de bearbetningsresurser som krävs för att köra ett jobb. Mer information om skalning av strömningsenheter finns i artikeln om att förstå och justera strömningsenheter.

Välj Granska + skapa längst ned på sidan.

På sidan Granska + skapa granskar du inställningarna och väljer Skapa för att skapa en Stream Analytics-sida.

På distributionssidan väljer du Gå till resurs för att navigera till stream analytics-jobbsidan .

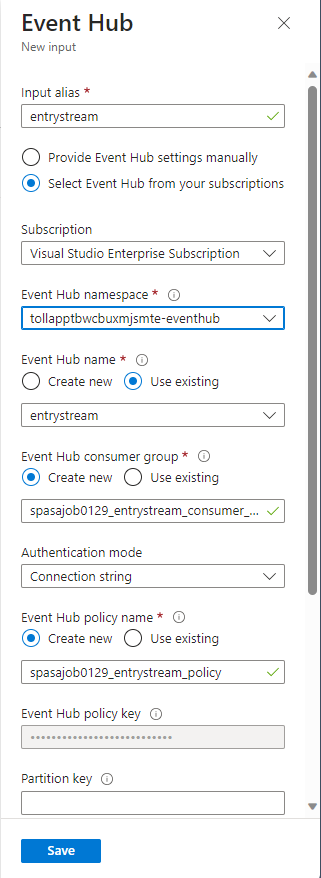

Konfigurera jobbindata

Nästa steg är att definiera en indatakälla för jobbet för att läsa data med hjälp av händelsehubben som skapades i TollApp-distributionen.

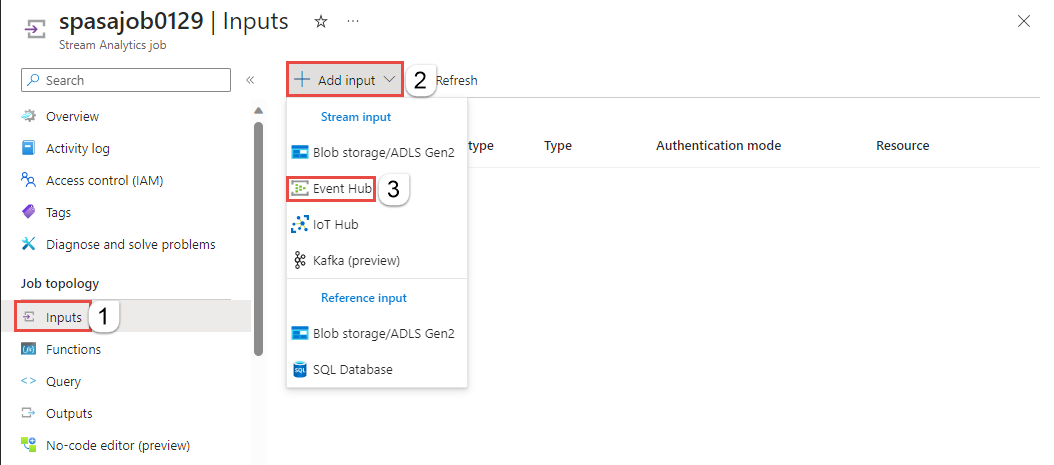

Hitta Stream Analytics-jobbet som skapades i föregående avsnitt.

I avsnittet Jobbtopologi i Stream Analytics-jobbet väljer du Indata.

Välj + Lägg till indata och Händelsehubb.

Fyll i indataformuläret med följande värden som skapats via TollApp Azure Template:

För Indataalias anger du entrystream.

Välj Välj händelsehubb från dina prenumerationer.

För Prenumeration väljer du din Azure-prenumeration.

För Event Hub-namnrymd väljer du händelsehubbens namnområde som du skapade i föregående avsnitt.

Använd standardalternativ för de återstående inställningarna och välj Spara.

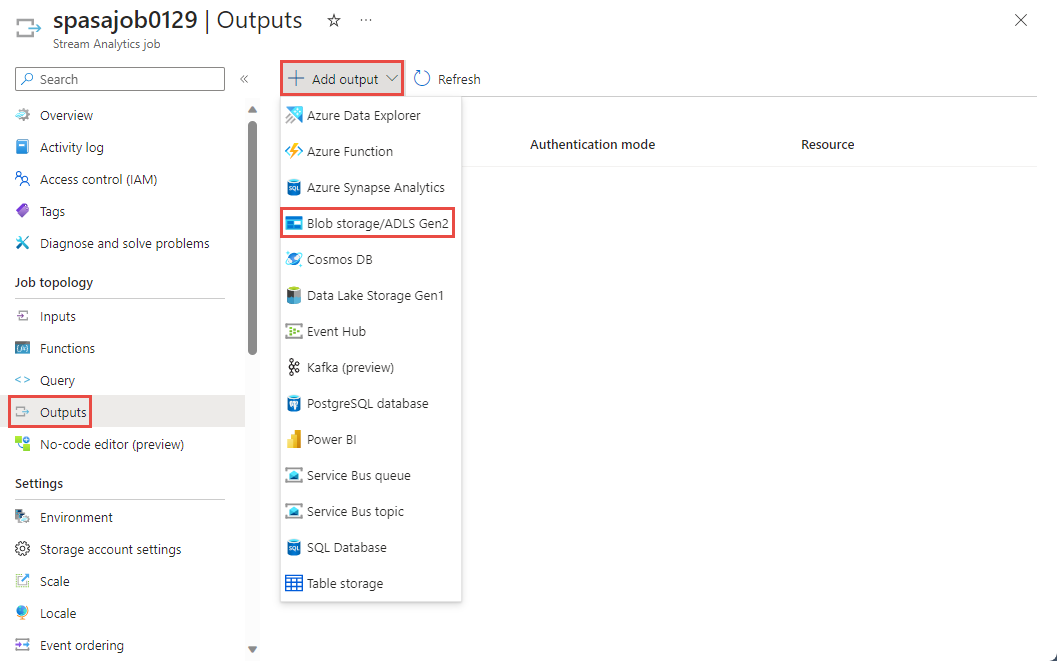

Konfigurera jobbutdata

Nästa steg är att definiera en utdatamottagare där jobbet kan skriva data till. I den här självstudien skriver du utdata till en Delta-tabell i Azure Data Lake Storage Gen2.

I avsnittet Jobbtopologi i Stream Analytics-jobbet väljer du alternativet Utdata .

Välj + Lägg till utdata>Blob Storage/ADLS Gen2.

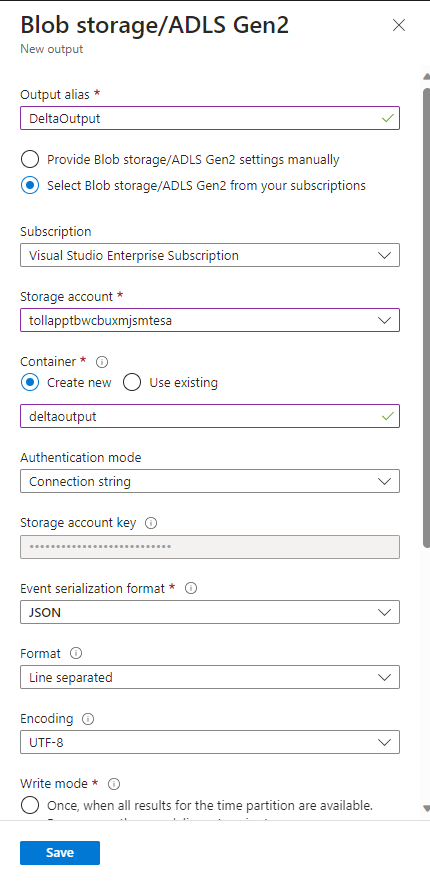

Fyll i utdataformuläret med följande information och välj Spara:

För Utdataalias anger du DeltaOutput.

Välj Välj Blob Storage/ADLS Gen2 från dina prenumerationer.

För Prenumeration väljer du din Azure-prenumeration.

För Lagringskonto väljer du det ADLS Gen2-konto (det som börjar med tollapp) som du skapade.

För container väljer du Skapa ny och anger ett unikt containernamn.

För Format för händelseseriellisering väljer du Delta Lake. Även om Delta Lake visas som ett av alternativen här är det inte ett dataformat. Delta Lake använder versionerade Parquet-filer för att lagra dina data. Om du vill veta mer om Delta Lake.

För Delta-tabellsökväg anger du självstudiemapp/deltatabell.

Använd standardalternativ för de återstående inställningarna och välj Spara.

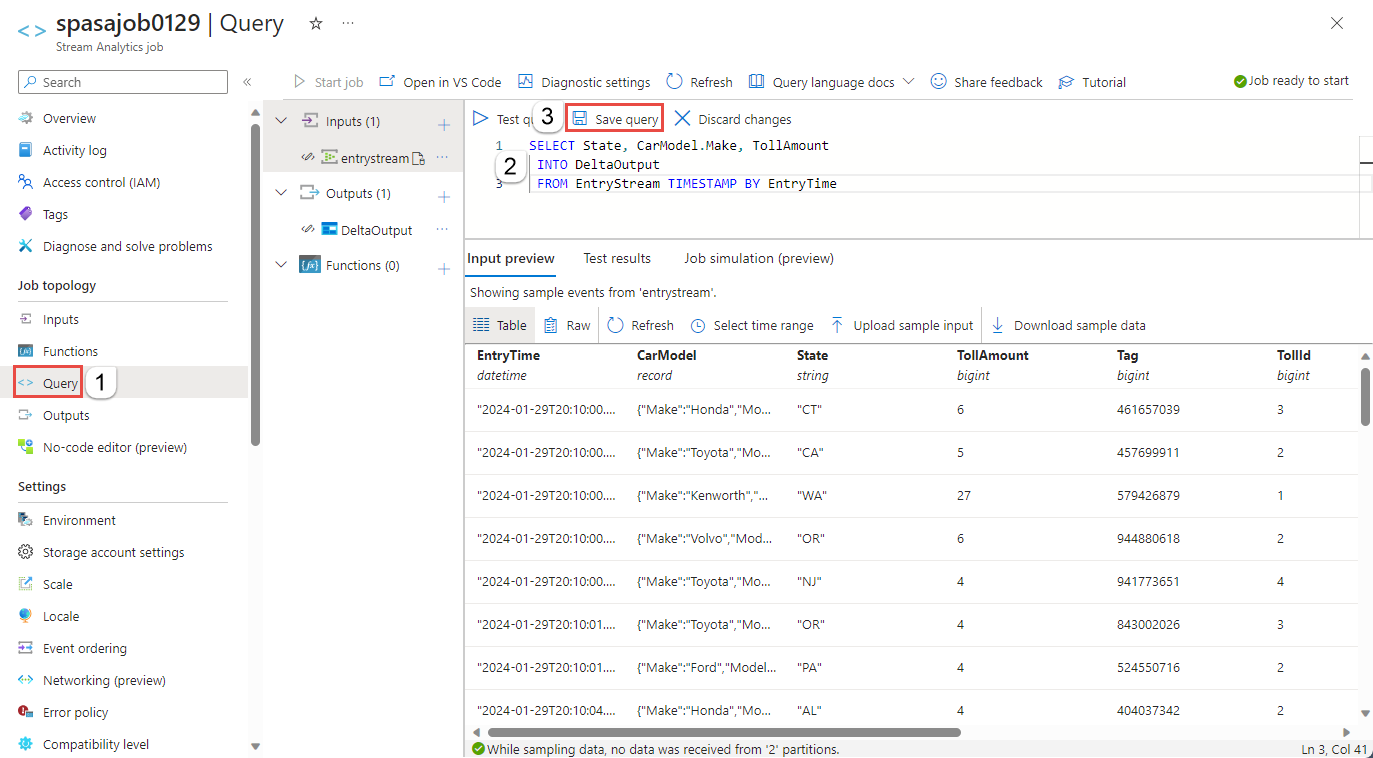

Skapa frågor

Nu har du konfigurerat ett Stream Analytics-jobb för att läsa en inkommande dataström. Nästa steg är att skapa en fråga som analyserar data i realtid. Frågorna använder ett SQL-liknande språk som har vissa tillägg som är specifika för Stream Analytics.

Välj nu Fråga under Jobbtopologi på den vänstra menyn.

Ange följande fråga i frågefönstret. I det här exemplet läser frågan data från Event Hubs och kopierar valda värden till en Delta-tabell i ADLS Gen2.

SELECT State, CarModel.Make, TollAmount INTO DeltaOutput FROM EntryStream TIMESTAMP BY EntryTimeVälj Spara fråga i verktygsfältet.

Starta Stream Analytics-jobbet och kontrollera utdata

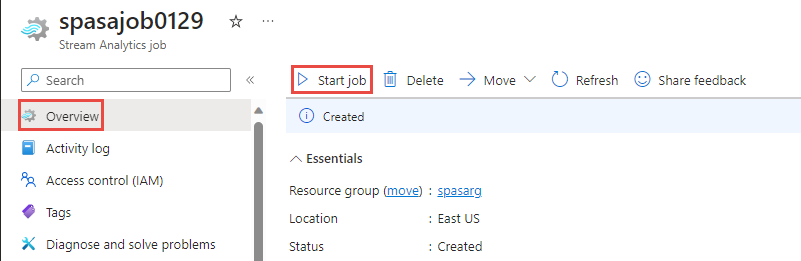

Gå tillbaka till jobböversiktssidan i Azure-portalen och välj Start.

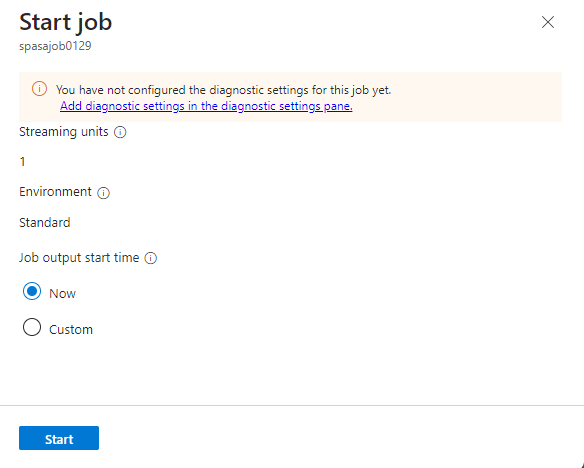

På sidan Starta jobb bekräftar du att Nu är valt för Starttid för jobbutdata och välj sedan Starta längst ned på sidan.

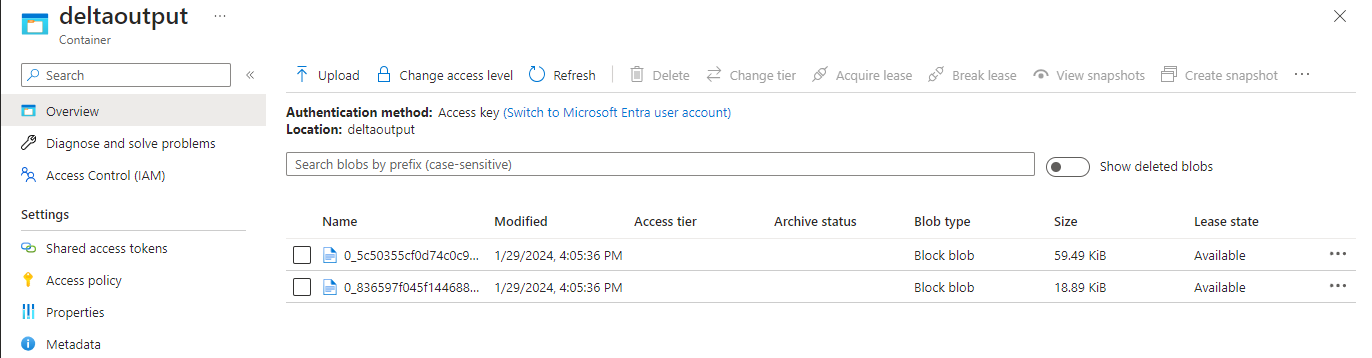

Efter några minuter letar du upp lagringskontot och containern som du har konfigurerat som utdata för jobbet i portalen. Nu kan du se deltatabellen i mappen som anges i containern. Jobbet tar några minuter att starta för första gången. När det har startats fortsätter det att köras när data tas emot.

Rensa resurser

När den inte längre behövs tar du bort resursgruppen, Stream Analytics-jobbet och alla relaterade resurser. Om du tar bort jobbet undviker du att bli fakturerad för de strömmande enheter som används av jobbet. Om du planerar att använda jobbet i framtiden kan du stoppa det och sedan starta det igen när du behöver det. Om du inte kommer att fortsätta att använda det här jobbet tar du bort alla resurser som skapats i den här självstudien med hjälp av följande steg:

- Klicka på Resursgrupper på den vänstra menyn i Azure-portalen och välj sedan namnet på den resurs du skapade.

- På sidan med resursgrupper klickar du på Ta bort, skriver in namnet på resursen som ska tas bort i textrutan och väljer sedan Ta bort.

Nästa steg

I den här självstudien skapade du ett enkelt Stream Analytics-jobb, filtrerade inkommande data och skrev resultat i en Delta-tabell i ADLS Gen2-kontot. Mer information om Stream Analytics-jobb:

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för