Viktig information om CNTK v2.7

Kära community,

Med våra pågående bidrag till ONNX och ONNX Runtime har vi gjort det enklare att samverka inom AI Framework-ekosystemet och få tillgång till högpresterande, plattformsoberoende slutsatsdragningsfunktioner för både traditionella ML-modeller och djupa neurala nätverk. Under de senaste åren har vi varit privilegierade att utveckla sådana viktiga maskininlärningsprojekt med öppen källkod, inklusive Microsoft Cognitive Toolkit, vilket har gjort det möjligt för användarna att utnyttja branschomfattande framsteg inom djupinlärning i stor skala.

Dagens 2.7-version blir den sista huvudversionen av CNTK. Vi kan ha några efterföljande mindre versioner för felkorrigeringar, men dessa utvärderas från fall till fall. Det finns inga planer för ny funktionsutveckling efter den här versionen.

CNTK 2.7-versionen har fullt stöd för ONNX 1.4.1, och vi uppmuntrar dem som vill operationalisera sina CNTK-modeller att dra nytta av ONNX och ONNX Runtime. Framöver kan användarna fortsätta att utnyttja nya ONNX-innovationer via antalet ramverk som stöder det. Användare kan till exempel exportera ONNX-modeller internt från PyTorch eller konvertera TensorFlow-modeller till ONNX med TensorFlow-ONNX-konverteraren.

Vi är otroligt tacksamma för allt stöd vi har fått från deltagare och användare under åren sedan den första versionen av CNTK med öppen källkod. CNTK har gjort det möjligt för både Microsoft-team och externa användare att köra komplexa och storskaliga arbetsbelastningar i alla typer av djupinlärningsprogram, till exempel historiska genombrott i taligenkänning som uppnåtts av Microsoft Speech-forskare, ramverkets upphovsmän.

Eftersom ONNX i allt högre grad används för att betjäna modeller som används i Microsoft-produkter som Bing och Office, är vi dedikerade till att syntetisera innovationer från forskning med rigorösa produktionsbehov för att föra ekosystemet framåt.

Framför allt är vårt mål att göra innovationer inom djupinlärning i programvaru- och maskinvarustackarna så öppna och tillgängliga som möjligt. Vi kommer att arbeta hårt för att både ta med de befintliga styrkorna i CNTK och ny toppmodern forskning i andra projekt med öppen källkod för att verkligen bredda räckvidden för sådan teknik.

Med tacksamhet,

-- CNTK-teamet

Höjdpunkter i den här versionen

- Flyttade till CUDA 10 för både Windows och Linux.

- Stöd för avancerad RNN-loop i ONNX-export.

- Exportera större än 2 GB modeller i ONNX-format.

- Stöd för FP16 i Brain Script-träningsåtgärd.

CNTK-stöd för CUDA 10

CNTK stöder nu CUDA 10. Detta kräver en uppdatering av byggmiljön till Visual Studio 2017 v15.9 för Windows.

Så här konfigurerar du bygg- och körningsmiljö i Windows:

- Installera Visual Studio 2017. Obs! Framöver för CUDA 10 och senare krävs det inte längre att installera och köra med den specifika VC Tools version 14.11.

- Installera Nvidia CUDA 10

- Från PowerShell kör du: DevInstall.ps1

- Starta Visual Studio 2017 och öppna CNTK.sln.

Om du vill konfigurera bygg- och körningsmiljön i Linux med docker skapar du Docker-avbildningen Unbuntu 16.04 med Dockerfiles här. Andra Linux-system finns i Dockerfiles för att konfigurera beroende bibliotek för CNTK.

Stöd för avancerad RNN-loop i ONNX-export

CNTK-modeller med rekursiva loopar kan exporteras till ONNX-modeller med genomsökningsoperativ.

Exportera större än 2 GB modeller i ONNX-format

Om du vill exportera modeller som är större än 2 GB i ONNX-format använder du cntk. Funktions-API: save(self, filename, format=ModelFormat.CNTKv2, use_external_files_to_store_parameters=False) med formatet inställt på ModelFormat.ONNX och use_external_files_to_store_parameters inställt på True. I det här fallet sparas modellparametrar i externa filer. Exporterade modeller ska användas med externa parameterfiler vid modellutvärdering med onnxruntime.

2018-11-26.

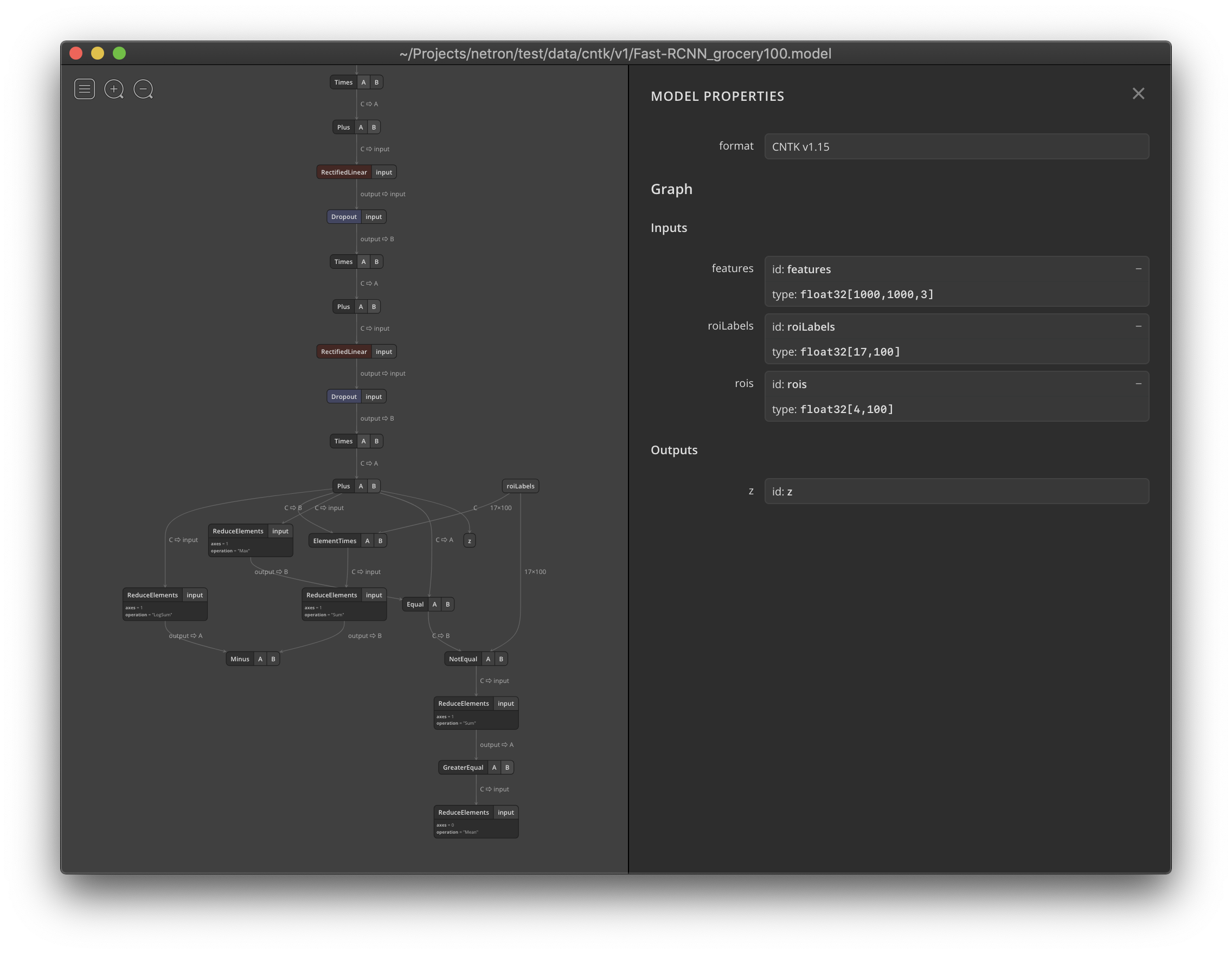

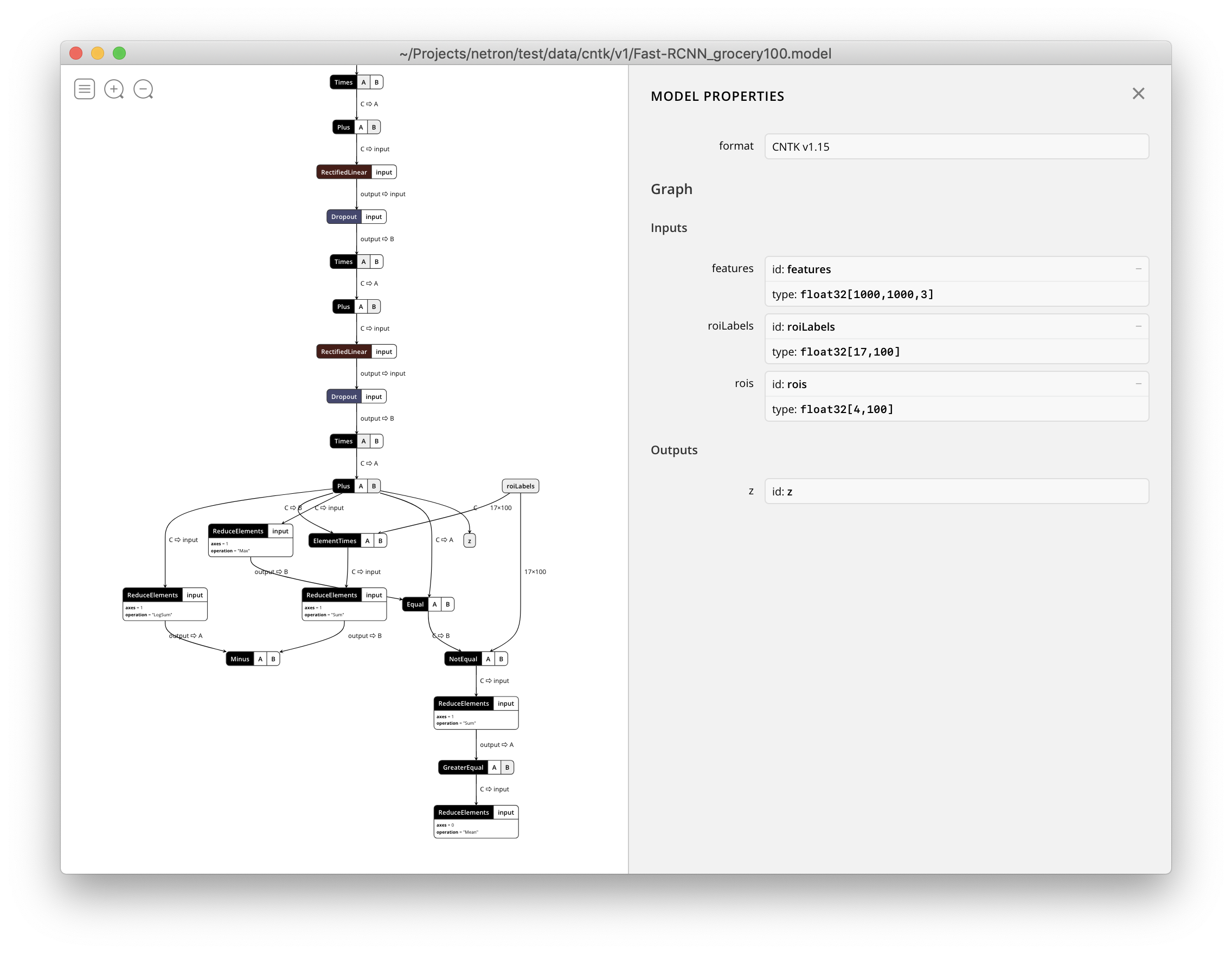

Netron stöder nu visualisering av CNTK v1- och CNTK v2-filer .model .