Övervaka Azure Data Factory-pipelines

När du har skapat och publicerat en pipeline i Azure Data Factory kan du associera den med en utlösare eller starta en körning på begäran manuellt. Du kan övervaka alla pipelinekörningar internt i Azure Data Factory-användarupplevelsen. Öppna övervakningsmiljön genom att välja panelen Övervaka och hantera på bladet datafabrik i Azure-portalen. Om du redan är i Azure Data Factory UX klickar du på ikonen Övervaka i det vänstra sidofältet.

Övervaka pipelinekörningar

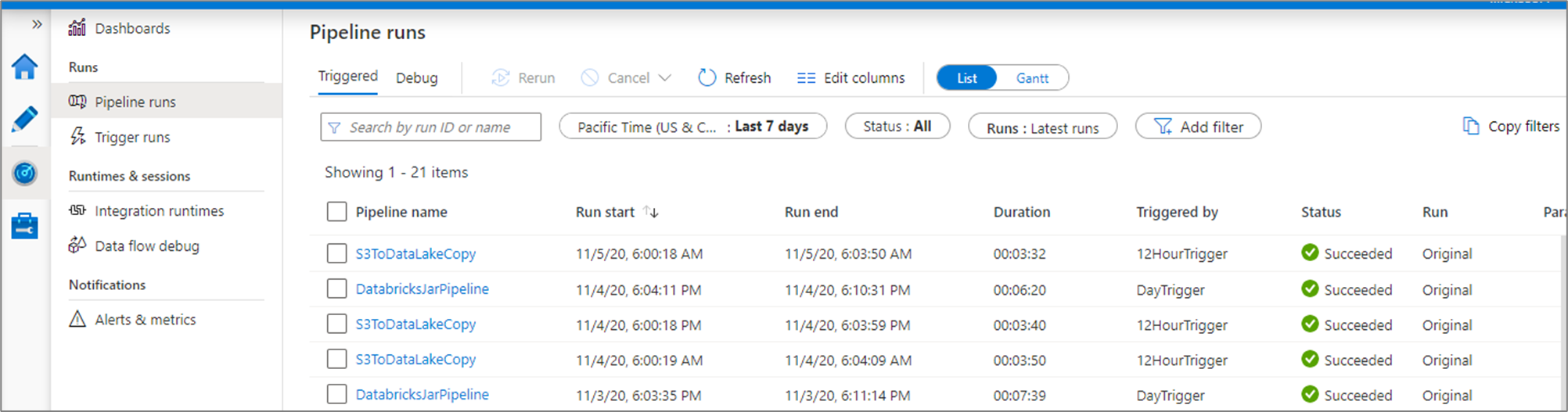

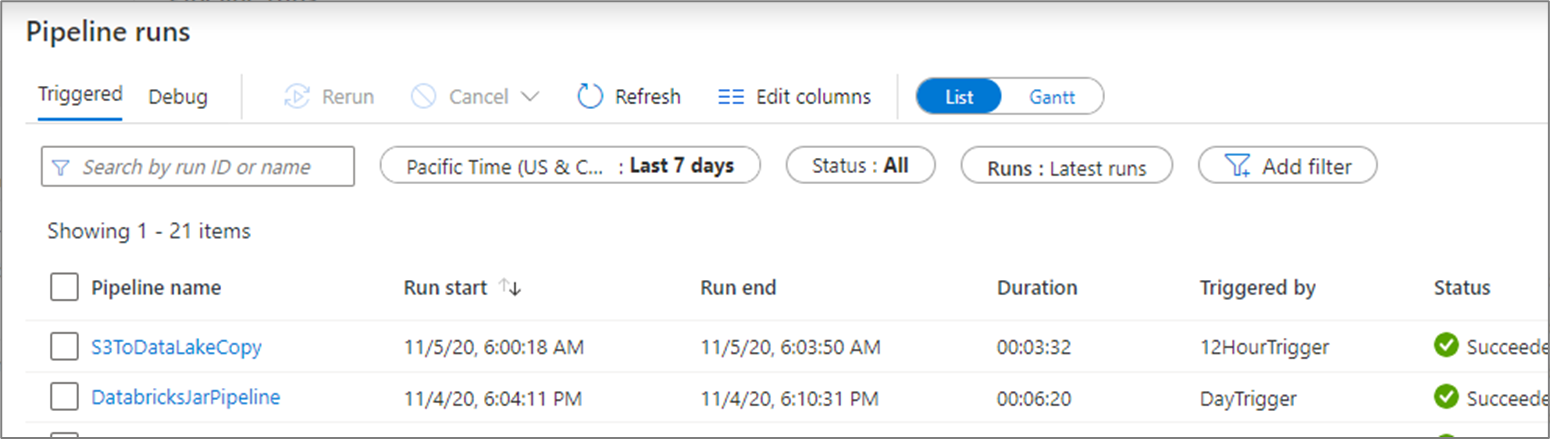

Standardövervakningsvyn är en lista över utlösta pipelinekörningar under den valda tidsperioden. Du kan ändra intervallet och filtrera efter status, pipelinenamn eller anteckning. Hovra över den specifika pipelinekörningen för att hämta körningsspecifika åtgärder, till exempel omkörning och förbrukningsrapport.

Rutnätet för pipelinekörning innehåller följande kolumner:

| Kolumnnamn | Beskrivning |

|---|---|

| Pipelinenamn | Namn på pipelinen |

| Starta körning | Startdatum och tid för pipelinekörningen (MM/DD/ÅÅÅÅ, HH:MM:SS AM/PM) |

| Kör slut | Slutdatum och tid för pipelinekörningen (MM/DD/ÅÅÅÅ, HH:MM:SS AM/PM) |

| Varaktighet | Körningstid (HH:MM:SS) |

| Utlöst av | Namnet på utlösaren som startade pipelinen |

| Status | Misslyckades, lyckades, pågår, avbröts eller köades |

| Kommentarer | Filterbara taggar som är associerade med en pipeline |

| Parametrar | Parametrar för pipelinekörningen (namn/värde-par) |

| Fel | Om pipelinen misslyckades kan körningsfelet |

| Körnings-ID | ID för pipelinekörningen |

Du måste välja knappen Uppdatera manuellt för att uppdatera listan över pipeline- och aktivitetskörningar. Autorefresh stöds för närvarande inte.

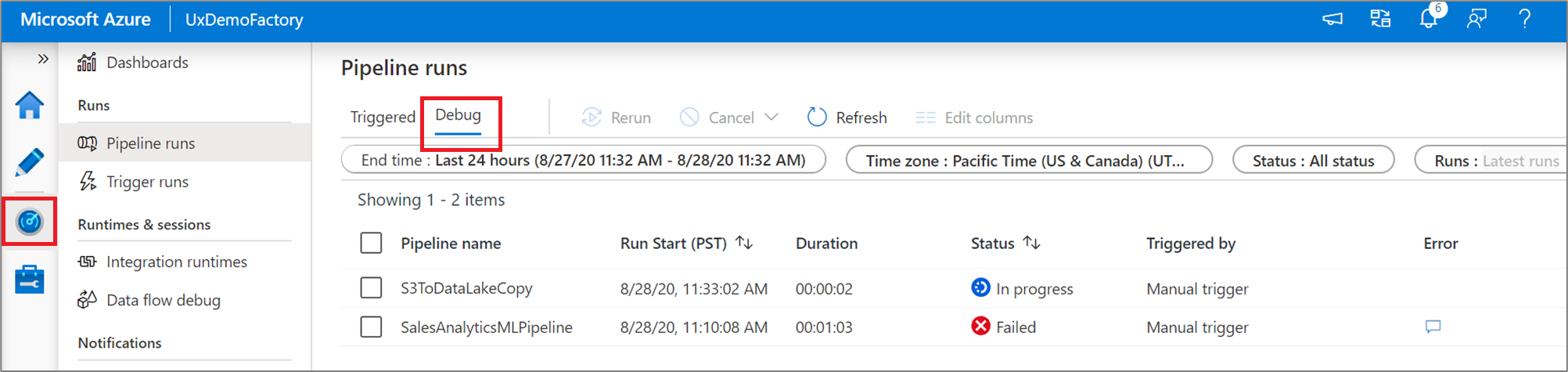

Om du vill visa resultatet av en felsökningskörning väljer du fliken Felsök .

Övervaka aktivitetskörningar

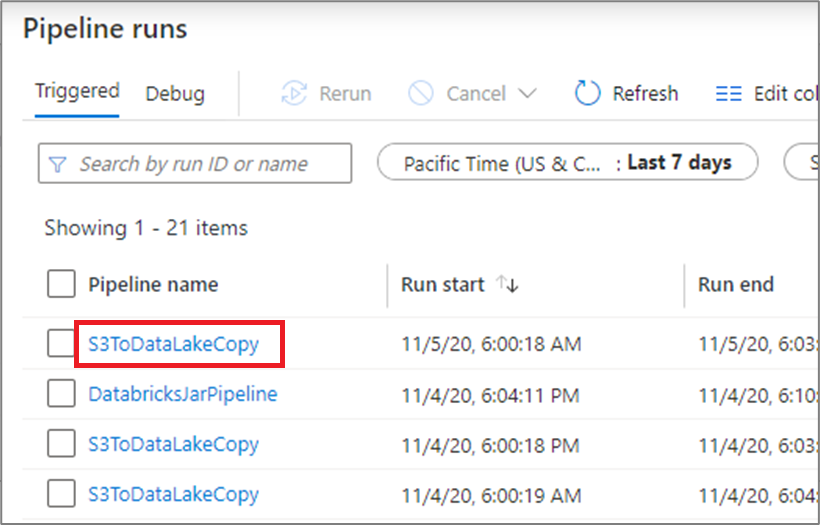

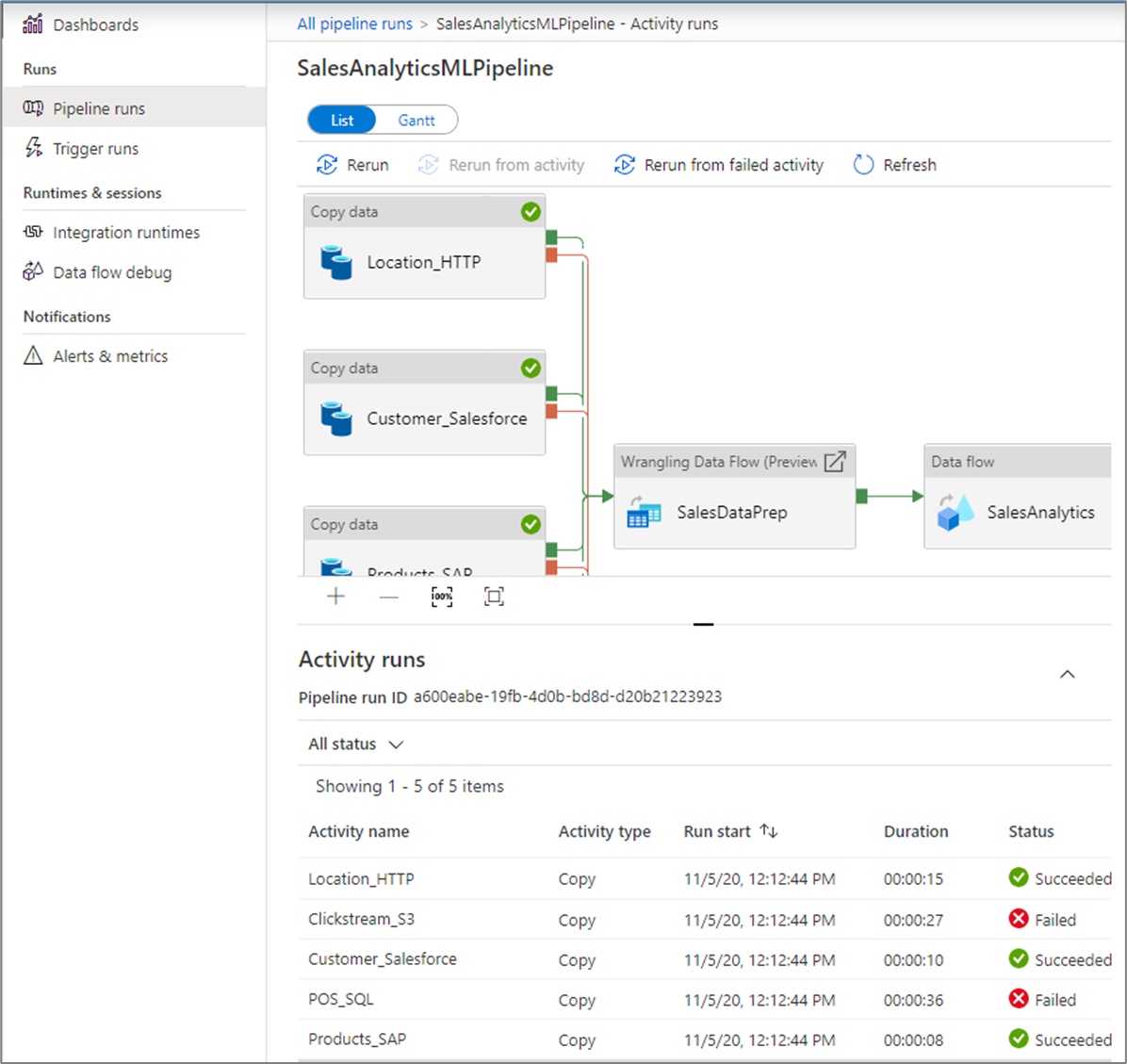

Om du vill få en detaljerad vy över enskilda aktivitetskörningar för en specifik pipelinekörning klickar du på pipelinenamnet.

Listvyn visar aktivitetskörningar som motsvarar varje pipelinekörning. Hovra över den specifika aktivitetskörningen för att hämta körningsspecifik information, till exempel JSON-indata, JSON-utdata och detaljerade aktivitetsspecifika övervakningsupplevelser. Aktiviteter som dataflöde, kopiering och Azure Databricks har en dedikerad vy som du kan se genom att klicka på glasögonikonen.

| Kolumnnamn | Beskrivning |

|---|---|

| Aktivitetsnamn | Namnet på aktiviteten i pipelinen |

| Aktivitetstyp | Typ av aktivitet, till exempel Kopiera, ExecuteDataFlow eller AzureMLExecutePipeline |

| Åtgärder | Ikoner som gör att du kan se JSON-indatainformation, JSON-utdatainformation eller detaljerade aktivitetsspecifika övervakningsupplevelser |

| Starta körning | Startdatum och tid för aktivitetskörningen (MM/DD/ÅÅÅÅ, HH:MM:SS AM/PM) |

| Varaktighet | Körningstid (HH:MM:SS) |

| Status | Misslyckades, lyckades, pågår eller avbröts |

| Integration Runtime | Vilken Integration Runtime som aktiviteten kördes på |

| Egenskaper för användare | Användardefinierade egenskaper för aktiviteten |

| Fel | Om aktiviteten misslyckades kan körningsfelet |

| Körnings-ID | ID för aktivitetskörningen |

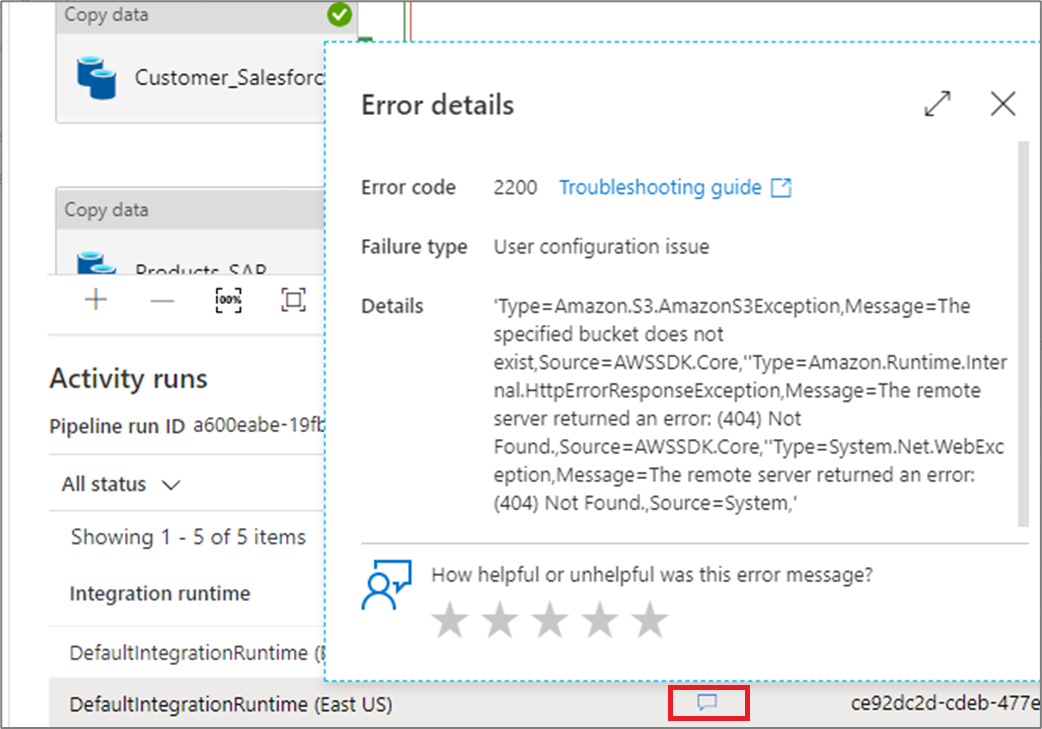

Om en aktivitet misslyckades kan du se det detaljerade felmeddelandet genom att klicka på ikonen i felkolumnen.

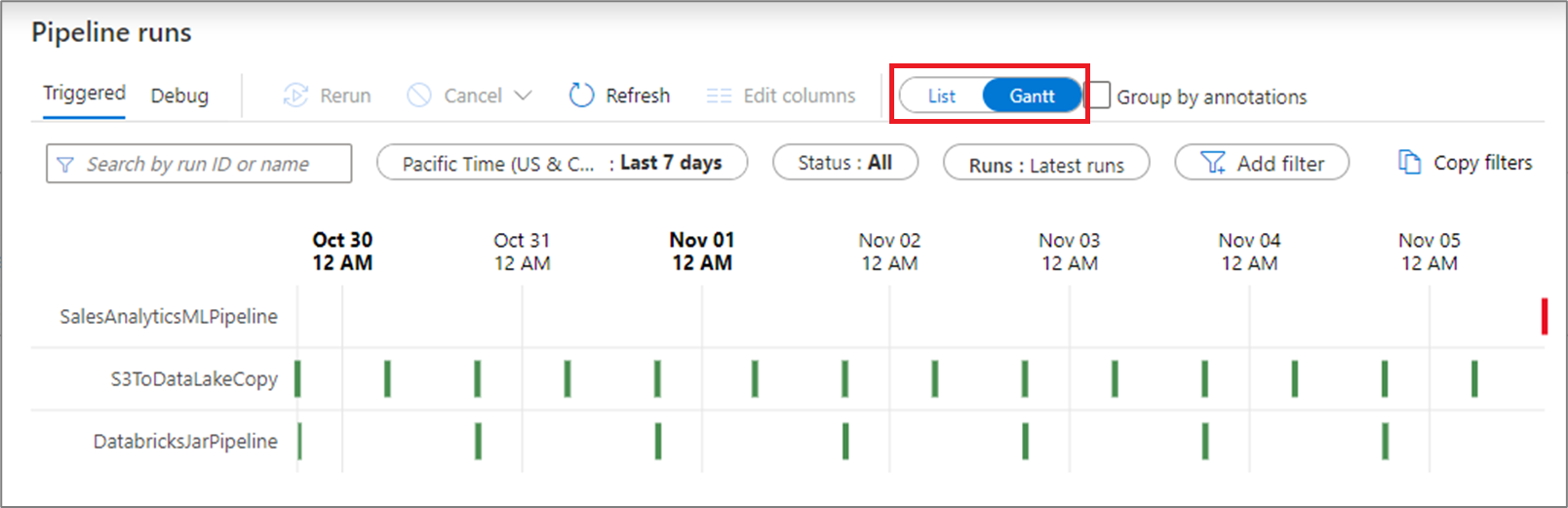

Gantt-vy

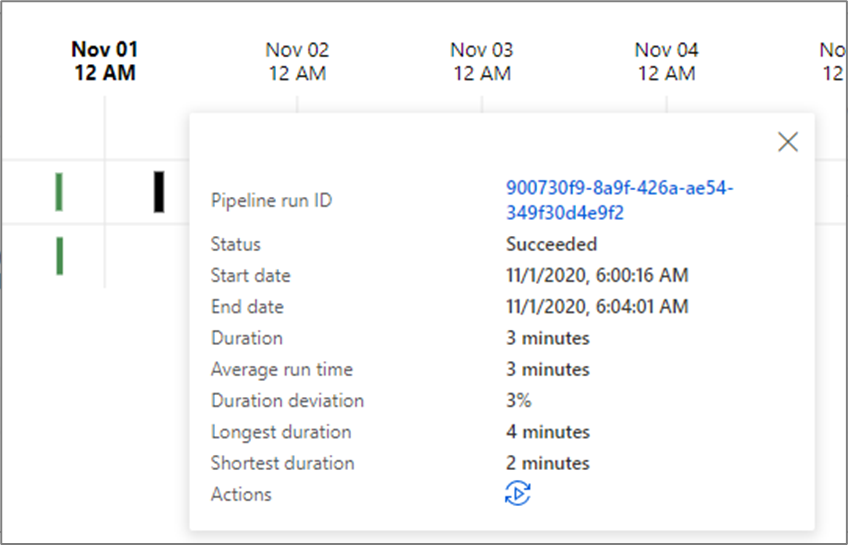

Ett Gantt-diagram är en vy där du kan se körningshistoriken över en tidsperiod. När du växlar till en Gantt-vy visas alla pipelinekörningar grupperade efter namn som staplar i förhållande till hur lång tid körningen tog. Du kan också gruppera efter anteckningar/taggar som du har skapat i din pipeline. Gantt-vyn är också tillgänglig på aktivitetskörningsnivån.

Längden på fältet informerar pipelinens varaktighet. Du kan också välja fältet för att se mer information.

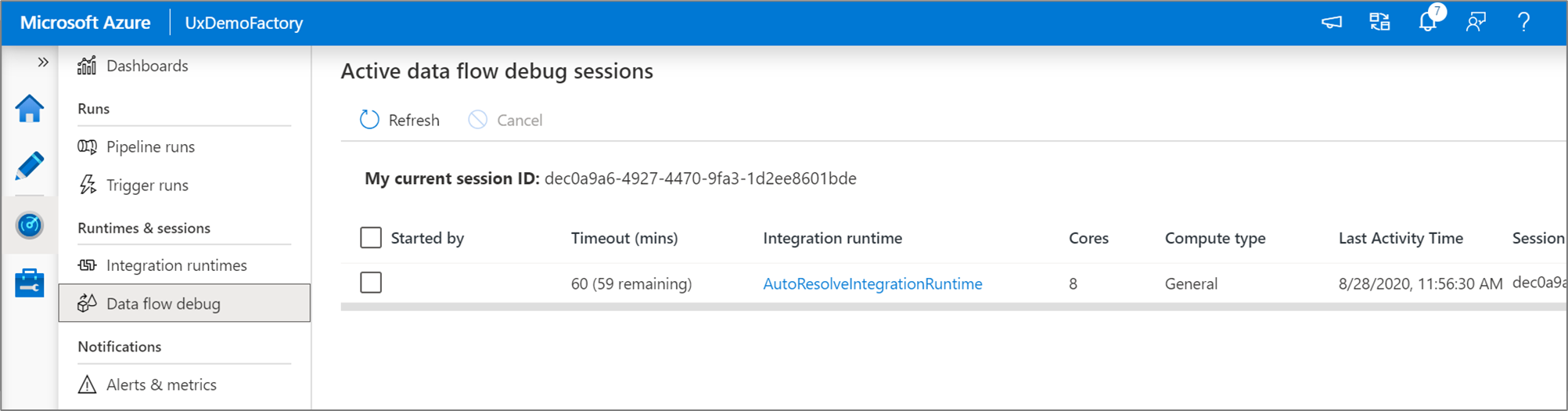

Övervaka felsökningssessioner för dataflöden

Genom att mappa dataflöden kan du skapa kodfri datatransformeringslogik som körs i stor skala. När du skapar din logik kan du aktivera en felsökningssession för att interaktivt arbeta med dina data med hjälp av ett Live Spark-kluster.

Du kan övervaka aktiva dataflödesfelsökningssessioner i en fabrik i övervakningsmiljön.

Övervaka instrumentpaneler

Om du vill visa en visuell visning på hög nivå av pipelinen, aktiviteten och utlösarkörningarna går du till fönstret Instrumentpaneler . Här kan du se antalet lyckade och misslyckade under en angiven tidsperiod.

Övervaka med Azure Monitor

Azure Monitor tillhandahåller infrastrukturmått och loggar på basnivå för de flesta Azure-tjänster. Azure-diagnostikloggar genereras av en resurs och ger innehållsrika och frekventa data om resursens användning. Azure Data Factory (ADF) kan skriva diagnostikloggar i Azure Monitor.

Data Factory lagrar pipelinekörningsdata i endast 45 dagar. Använd Azure Monitor om du vill behålla dessa data under en längre tid. Med Monitor kan du dirigera diagnostikloggar för analys till flera olika mål.

- Lagringskonto: Spara diagnostikloggarna på ett lagringskonto för granskning eller manuell inspektion. Du kan använda diagnostikinställningarna för att ange kvarhållningstiden i dagar.

- Händelsehubb: Strömma loggarna till Azure Event Hubs. Loggarna blir indata till en partnertjänst/anpassad analyslösning som Power BI.

- Log Analytics: Analysera loggarna med Log Analytics. Data Factory-integreringen med Azure Monitor är användbar i följande scenarier:

- Du vill skriva komplexa frågor på en omfattande uppsättning mått som publiceras av Data Factory till Monitor. Du kan skapa anpassade aviseringar för dessa frågor via Monitor.

- Du vill övervaka över datafabriker. Du kan dirigera data från flera datafabriker till en enda Monitor-arbetsyta.

Du kan också använda ett lagringskonto eller ett händelsehubbnamnområde som inte finns i prenumerationen på resursen som genererar loggar. Den användare som konfigurerar inställningen måste ha lämplig åtkomst till båda prenumerationerna med rollbaserad åtkomstkontroll (Azure RBAC).

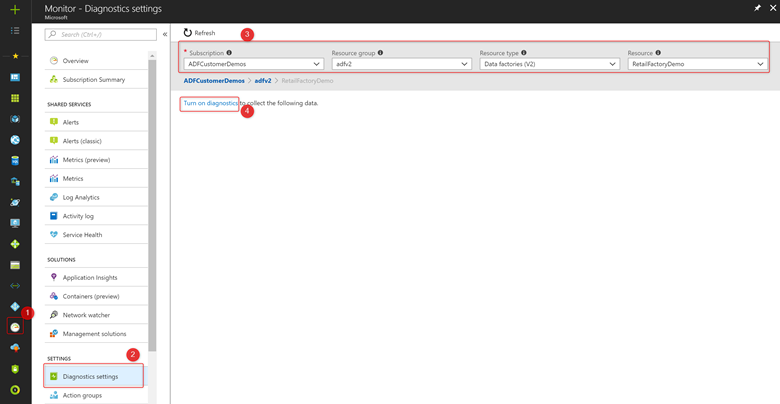

Konfigurera diagnostikinställningar och arbetsyta

Skapa eller lägg till diagnostikinställningar för datafabriken.

Gå till Övervaka i portalen. Välj Inställningar> Diagnostiska inställningar.

Välj den datafabrik som du vill ange en diagnostikinställning för.

Om det inte finns några inställningar på den valda datafabriken uppmanas du att skapa en inställning. Välj Aktivera diagnostik.

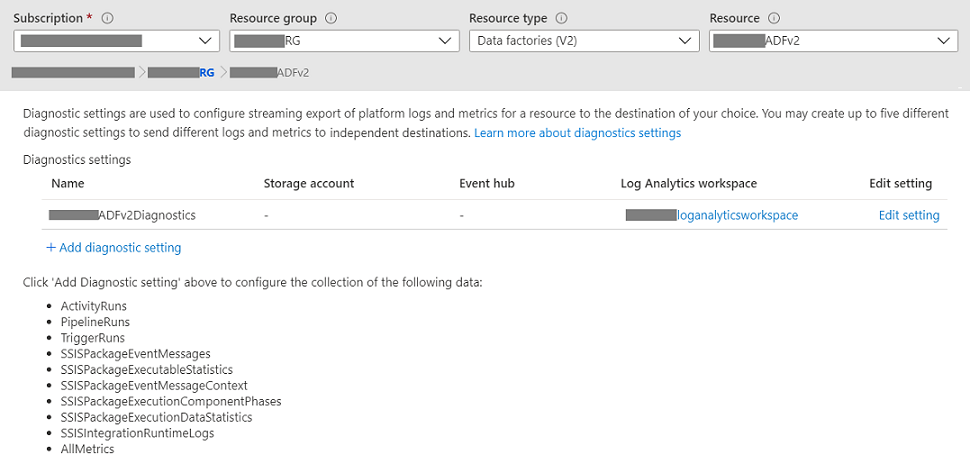

Om det finns befintliga inställningar i datafabriken visas en lista med inställningar som redan har konfigurerats på datafabriken. Välj Lägg till diagnostikinställning.

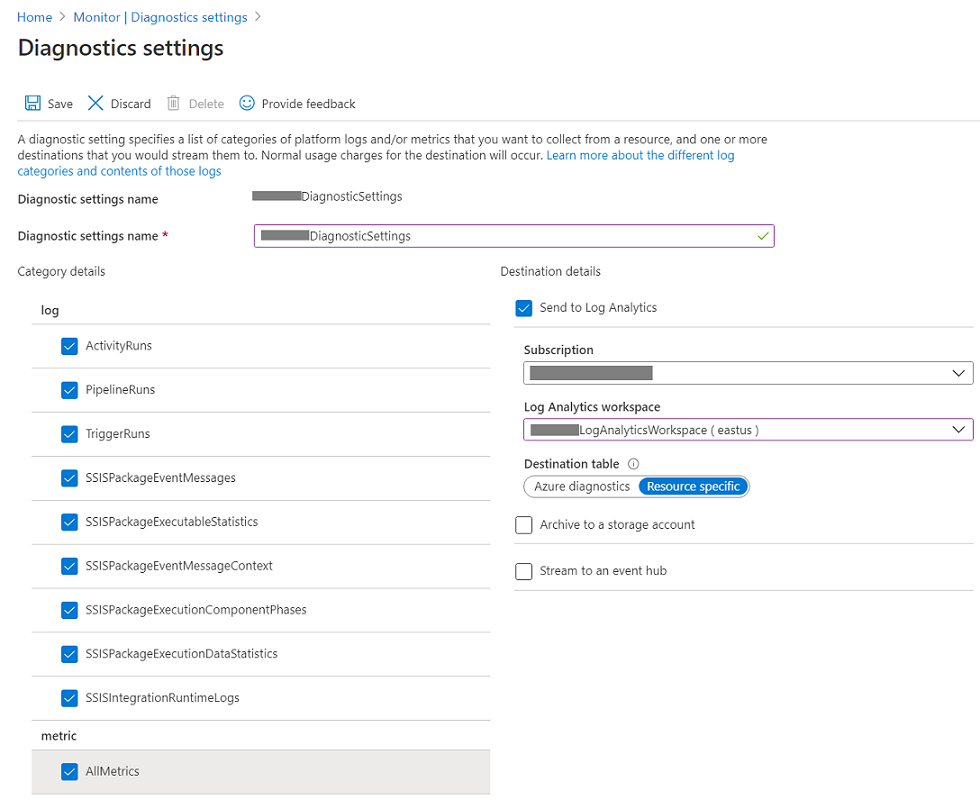

Ge inställningen ett namn, välj Skicka till Log Analytics och välj sedan en arbetsyta från Log Analytics-arbetsytan.

I Azure-Diagnostics-läge flödar diagnostikloggar till tabellen AzureDiagnostics .

I resursspecifikt läge flödar diagnostikloggar från Azure Data Factory till följande tabeller:

- ADFActivityRun

- ADFPipelineRun

- ADFTriggerRun

- ADFSSISIntegrationRuntimeLogs

- ADFSSISPackageEventMessageContext

- ADFSSISPackageEventMessages

- ADFSSISPackageExecutableStatistics

- ADFSSISPackageExecutionComponentPhases

- ADFSSISPackageExecutionDataStatistics

Du kan välja olika loggar som är relevanta för dina arbetsbelastningar som ska skickas till Log Analytics-tabeller. Om du till exempel inte använder SQL Server Integration Services (SSIS) alls behöver du inte välja några SSIS-loggar. Om du vill logga start-/stopp-/underhållsåtgärder för SSIS Integration Runtime (IR) kan du välja SSIS IR-loggar. Om du anropar SSIS-paketkörningar via T-SQL i SQL Server Management Studio (SSMS), SQL Server Agent eller andra avsedda verktyg kan du välja SSIS-paketloggar. Om du anropar SSIS-paketkörningar via Köra SSIS-paketaktiviteter i ADF-pipelines kan du välja alla loggar.

Om du väljer AllMetrics görs olika Azure Data Factory-mått tillgängliga så att du kan övervaka eller skapa aviseringar på, inklusive måtten för Azure Data Factory-aktivitet, pipeline och utlösarkörningar, samt för SSIS IR-åtgärder och SSIS-paketkörningar.

> [!NOTE]

> Because an Azure log table can't have more than 500 columns, Select _Resource-Specific mode_.

- Välj Spara.

Efter en liten stund visas den nya inställningen i listan med inställningar för den här datafabriken. Diagnostikloggar strömmas till den arbetsytan så snart nya händelsedata genereras. Upp till 15 minuter kan förflutit mellan när en händelse genereras och när den visas i Log Analytics.