หมายเหตุ

การเข้าถึงหน้านี้ต้องได้รับการอนุญาต คุณสามารถลอง ลงชื่อเข้าใช้หรือเปลี่ยนไดเรกทอรีได้

การเข้าถึงหน้านี้ต้องได้รับการอนุญาต คุณสามารถลองเปลี่ยนไดเรกทอรีได้

ส่วนขยายโค้ด Fabric Data Engineering Visual Studio (VS) สนับสนุนการดําเนินการสร้าง อ่าน อัปเดต และลบ (CRUD) Spark job definition อย่างเต็มที่ใน Fabric หลังจากที่คุณสร้างข้อกําหนดงาน Spark คุณสามารถอัปโหลดไลบรารีอ้างอิงเพิ่มเติม ส่งคําขอเพื่อเรียกใช้ข้อกําหนดงาน Spark และตรวจสอบประวัติการเรียกใช้

สร้างข้อกําหนดงาน Spark

เมื่อต้องสร้างข้อกําหนดงาน Spark ใหม่:

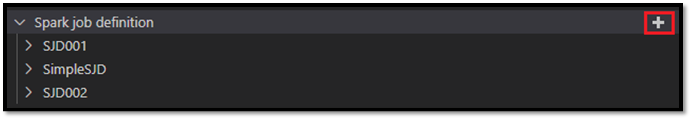

ในตัวสํารวจรหัส VS ให้ เลือกตัวเลือกสร้างข้อกําหนด ของงาน Spark

ใส่เขตข้อมูลที่จําเป็นเบื้องต้น: ชื่อ เลคเฮ้าส์อ้างอิง และเลคเฮ้าส์เริ่มต้น

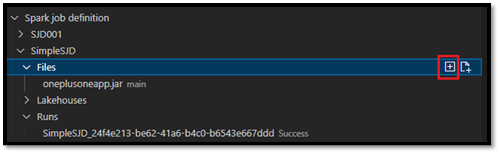

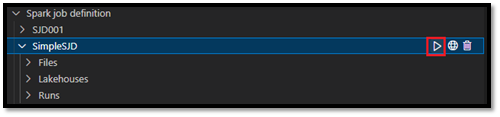

กระบวนการคําขอและชื่อของข้อกําหนดงาน Spark ที่สร้างขึ้นใหม่ของคุณจะปรากฏขึ้นภายใต้โหนดรากของ Spark Job Definition ใน VS Code Explorer ภายใต้โหนดชื่อข้อกําหนดงาน Spark คุณจะเห็นโหนดย่อยสามรายการ:

- ไฟล์: รายการของไฟล์ข้อกําหนดหลักและไลบรารีที่อ้างอิงอื่นๆ คุณสามารถอัปโหลดไฟล์ใหม่จากรายการนี้

-

เลคเฮ้าส์: รายการของเลคเฮ้าส์ทั้งหมดที่อ้างอิงตามข้อกําหนดงาน Spark นี้ เลคเฮ้าส์ตามค่าเริ่มต้นจะถูกทําเครื่องหมายในรายการ และคุณสามารถเข้าถึงได้ผ่าน เส้นทาง

Files/…, Tables/…สัมพัทธ์ - เรียกใช้: รายการประวัติการเรียกใช้ของข้อกําหนดงาน Spark นี้และสถานะงานของแต่ละการเรียกใช้

อัปโหลดไฟล์ข้อกําหนดหลักไปยังไลบรารีที่อ้างอิง

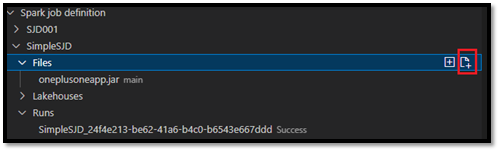

หากต้องการอัปโหลดหรือเขียนทับไฟล์ข้อกําหนดหลัก ให้ เลือกตัวเลือก เพิ่มไฟล์ หลัก

หากต้องการอัปโหลดไฟล์ไลบรารีที่อ้างอิงไฟล์ข้อกําหนดหลัก ให้ เลือกตัวเลือก เพิ่มไฟล์ Lib

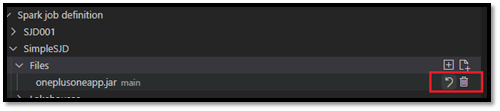

หลังจากที่คุณอัปโหลดไฟล์แล้ว คุณสามารถแทนที่ได้โดยคลิกที่ตัวเลือก อัปเดตไฟล์ และอัปโหลดไฟล์ใหม่ หรือคุณสามารถลบไฟล์ผ่านตัวเลือก ลบ

ส่งคําขอการเรียกใช้

หากต้องการส่งคําขอเพื่อเรียกใช้ข้อกําหนดงาน Spark จากรหัส VS:

จากตัวเลือกทางด้านขวาของชื่อข้อกําหนดงาน Spark ที่คุณต้องการเรียกใช้ ให้ เลือกตัวเลือก เรียกใช้งาน Spark

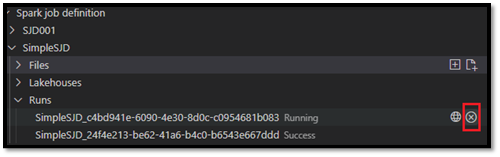

หลังจากที่คุณส่งคําขอ แอปพลิเคชัน Apache Spark ใหม่จะปรากฏใน โหนด Runs ในรายการ Explorer คุณสามารถยกเลิกงานที่กําลังทํางานอยู่โดยการเลือกตัวเลือก ยกเลิกงาน Spark

เปิดข้อกําหนดงาน Spark ในพอร์ทัล Fabric

คุณสามารถเปิดหน้าการเขียนข้อกําหนดงาน Spark ในพอร์ทัล Fabric โดยการเลือกตัวเลือก เปิดในเบราว์เซอร์

คุณยังสามารถเลือก เปิดในเบราว์เซอร์ ถัดจากการเรียกใช้ที่เสร็จสมบูรณ์ เพื่อดูหน้าตัวตรวจสอบรายละเอียดของการเรียกใช้นั้น

ดีบักรหัสแหล่งที่มาของข้อกําหนดงาน Spark (Python)

ถ้าข้อกําหนดงาน Spark ถูกสร้างขึ้นด้วย PySpark (Python) คุณสามารถดาวน์โหลดสคริปต์.py ของไฟล์ข้อกําหนดหลักและไฟล์อ้างอิง และดีบักสคริปต์ต้นฉบับใน VS Code ได้

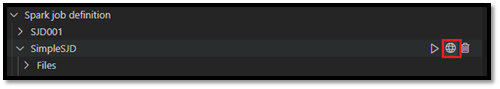

หากต้องการดาวน์โหลดโค้ดต้นฉบับ ให้ เลือกตัวเลือก แก้จุดบกพร่องข้อกําหนด งาน Spark ทางด้านขวาของข้อกําหนดงาน Spark

หลังจากการดาวน์โหลดเสร็จสมบูรณ์ โฟลเดอร์ของซอร์สโค้ดจะเปิดขึ้นโดยอัตโนมัติ

เลือกตัวเลือก เชื่อถือผู้เขียน เมื่อได้รับพร้อมท์ (ตัวเลือกนี้จะปรากฏในครั้งแรกที่คุณเปิดโฟลเดอร์เท่านั้น หากคุณไม่ได้เลือกตัวเลือกนี้ คุณจะไม่สามารถแก้จุดบกพร่องหรือเรียกใช้สคริปต์ต้นฉบับได้ สําหรับข้อมูลเพิ่มเติม ให้ดู Visual Studio Code Workspace Trust security)

ถ้าคุณเคยดาวน์โหลดโค้ดต้นฉบับมาก่อน คุณจะได้รับพร้อมท์ให้ยืนยันว่าคุณต้องการเขียนทับเวอร์ชันภายในเครื่องด้วยการดาวน์โหลดใหม่

หมายเหตุ

ในโฟลเดอร์รากของสคริปต์ต้นทาง ระบบสร้างโฟลเดอร์ย่อยที่ชื่อว่า conf ภายในโฟลเดอร์นี้ แฟ้มที่ ชื่อ lighter-config.json มีเมตาดาต้าของระบบบางอย่างที่จําเป็นสําหรับการเรียกใช้ระยะไกล อย่าทําการเปลี่ยนแปลงใดๆ

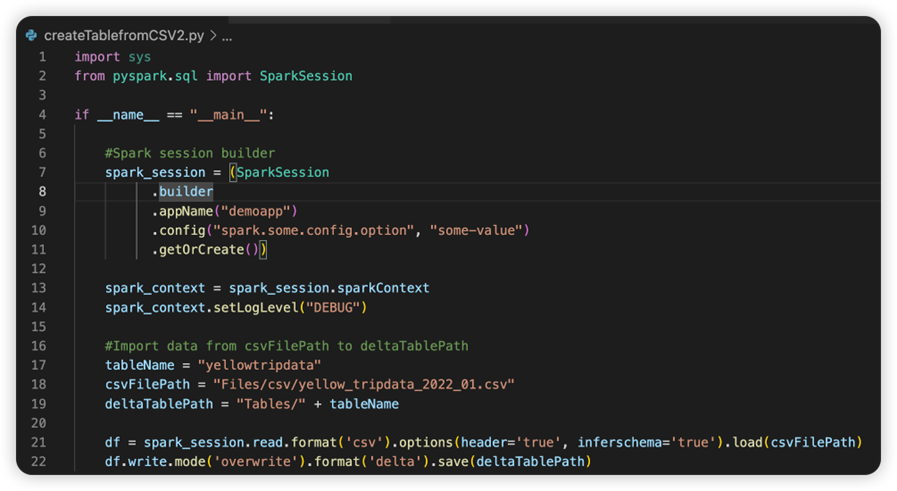

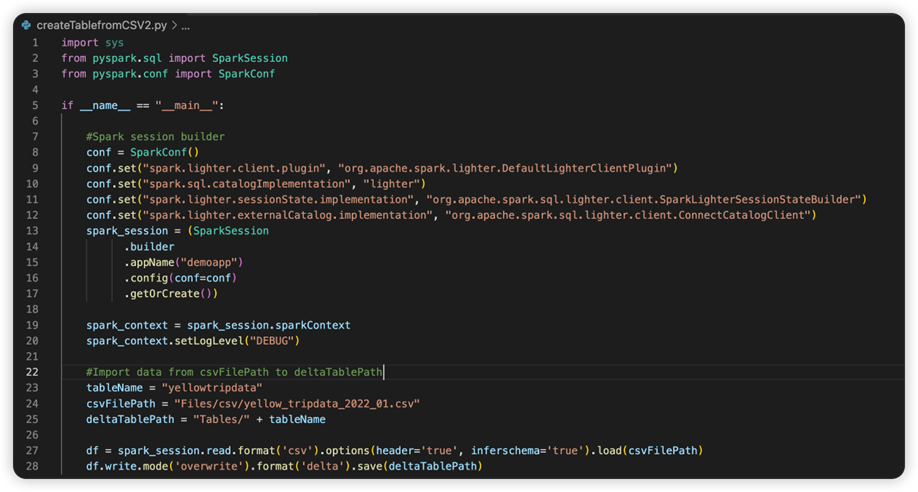

ไฟล์ที่มีชื่อว่า sparkconf.py ประกอบด้วยส่วนย่อยของโค้ดที่คุณจําเป็นต้องเพิ่มเพื่อตั้งค่าวัตถุ SparkConf เมื่อต้องการเปิดใช้งานดีบักระยะไกล ตรวจสอบให้แน่ใจว่ามี การตั้งค่าวัตถุ SparkConf อย่างถูกต้อง รูปภาพต่อไปนี้แสดงเวอร์ชันเดิมของโค้ดต้นฉบับ

รูปภาพถัดไปคือโค้ดต้นทางที่อัปเดตแล้วหลังจากที่คุณคัดลอกและวางส่วนย่อย

หลังจากที่คุณได้อัปเดตโค้ดต้นฉบับด้วยความสับสนที่จําเป็นแล้ว คุณต้องเลือก Python Interpreter ที่ถูกต้อง ตรวจสอบให้แน่ใจว่าได้เลือกตัวที่ติดตั้งจาก สภาพแวดล้อม conda เคอร์เนล synapse-spark

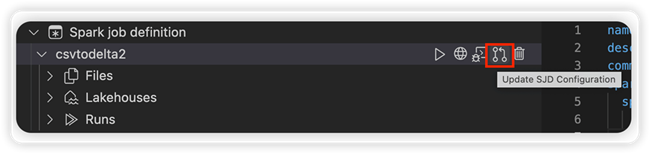

แก้ไขคุณสมบัติข้อกําหนดงาน Spark

คุณสามารถแก้ไขคุณสมบัติรายละเอียดของข้อกําหนดงาน Spark เช่น อาร์กิวเมนต์บรรทัดคําสั่ง

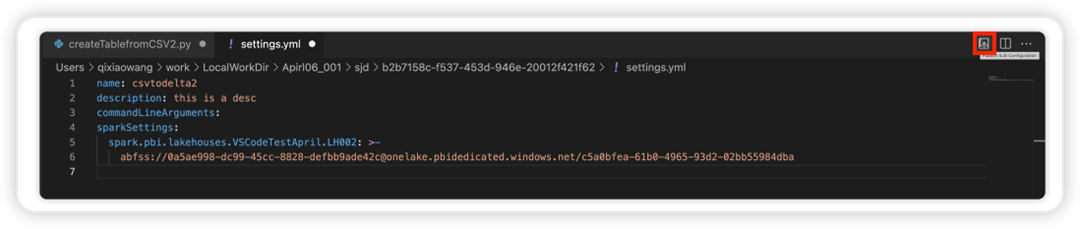

เลือกตัวเลือก อัปเดตการกําหนดค่า SJD เพื่อเปิดไฟล์ settings.yml คุณสมบัติที่มีอยู่จะเติมเนื้อหาของไฟล์นี้

อัปเดตและบันทึกไฟล์.yml

เลือกตัวเลือก เผยแพร่คุณสมบัติ SJD ที่มุมบนขวาเพื่อซิงค์การเปลี่ยนแปลงกลับไปยังพื้นที่ทํางานระยะไกล