วิธีการสร้างข้อกําหนดงาน Apache Spark ใน Fabric

ในบทช่วยสอนนี้ คุณจะได้เรียนรู้วิธีการสร้างข้อกําหนดงาน Spark ใน Microsoft Fabric

ข้อกำหนดเบื้องต้น

ก่อนที่คุณเริ่มต้นใช้งาน คุณต้องการ:

- บัญชีผู้เช่า Fabric ที่มีการสมัครใช้งานที่ใช้งานอยู่ สร้างบัญชีฟรี

เคล็ดลับ

เมื่อต้องการเรียกใช้รายการข้อกําหนดงาน Spark คุณต้องมีไฟล์ข้อกําหนดหลักและบริบทของเลคเฮ้าส์ตามค่าเริ่มต้น ถ้าคุณไม่มีเลคเฮ้าส์ คุณสามารถสร้างได้โดยทําตามขั้นตอนใน สร้างเลคเฮ้าส์

สร้างข้อกําหนดงาน Spark

กระบวนการสร้างข้อกําหนดงาน Spark ทําได้ง่ายและรวดเร็ว มีหลายวิธีในการเริ่มต้นใช้งาน

ตัวเลือกเพื่อสร้างข้อกําหนดงาน Spark

มีสองสามวิธีที่คุณสามารถเริ่มต้นด้วยกระบวนการสร้าง:

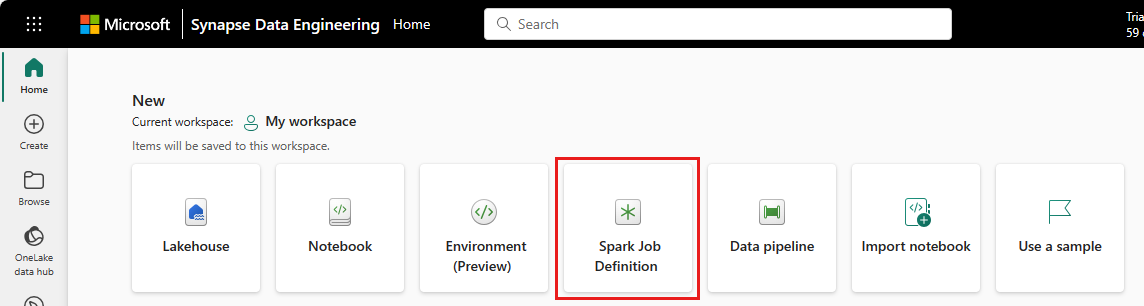

โฮมเพจวิศวกรรมข้อมูล: คุณสามารถสร้างข้อกําหนดงาน Spark ได้อย่างง่ายดายผ่าน การ์ด ข้อกําหนด งาน Spark ภายใต้ ส่วน ใหม่ ในโฮมเพจ

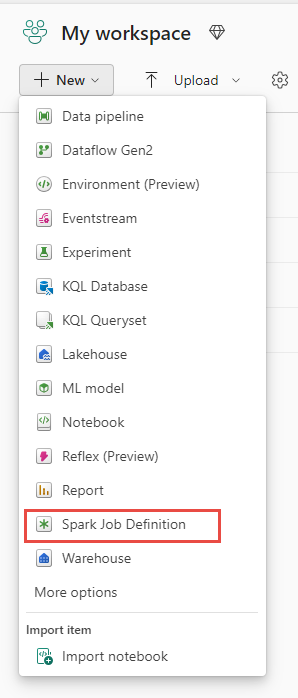

มุมมองพื้นที่ทํางาน: คุณยังสามารถสร้างข้อกําหนดงาน Spark ผ่านพื้นที่ทํางานในวิศวกรข้อมูลโดยใช้เมนูดรอปดาวน์ใหม่ได้

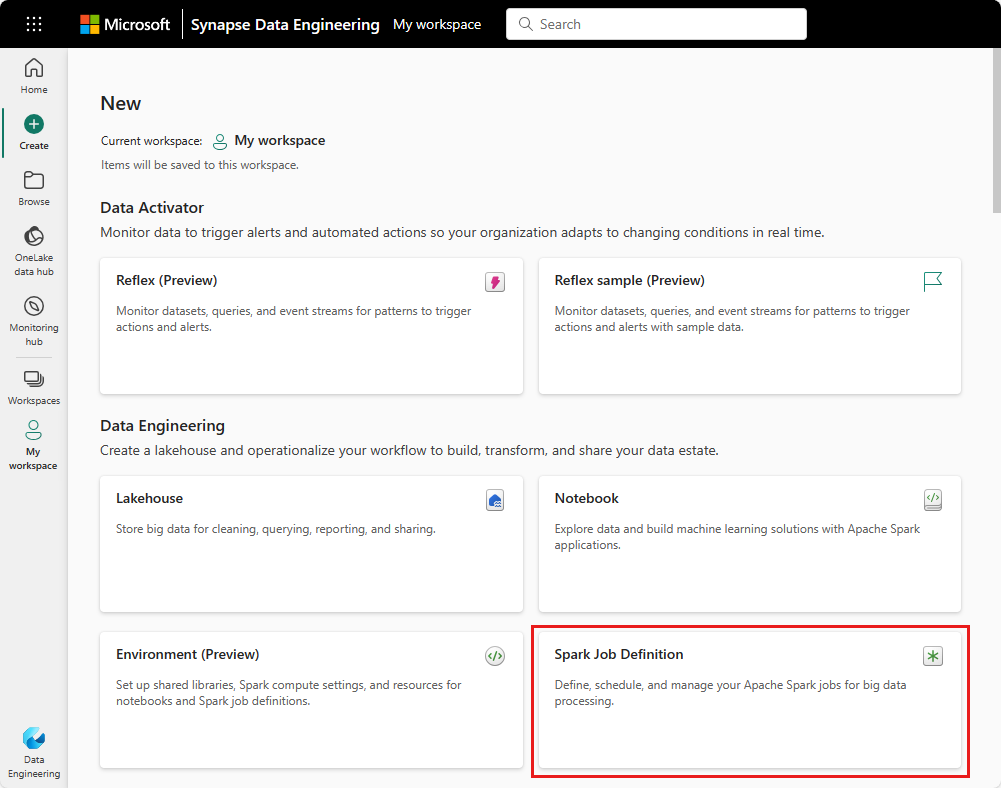

สร้างมุมมอง: อีกจุดหนึ่งเพื่อสร้างข้อกําหนดงาน Spark คือหน้า สร้าง ภายใต้วิศวกรข้อมูล

คุณต้องตั้งชื่อให้ข้อกําหนดงาน Spark ของคุณเมื่อสร้างงาน ชื่อต้องไม่ซ้ํากันภายในพื้นที่ทํางานปัจจุบัน ข้อกําหนดงาน Spark ใหม่จะถูกสร้างขึ้นในพื้นที่ทํางานปัจจุบันของคุณ

สร้างข้อกําหนดงาน Spark สําหรับ PySpark (Python)

เมื่อต้องสร้างข้อกําหนดงาน Spark สําหรับ PySpark:

ดาวน์โหลด yellow_tripdata_2022_01.csv ไฟล์ CSV ตัวอย่าง และอัปโหลดไปยังส่วนไฟล์ของ lakehouse

สร้างข้อกําหนดงาน Spark ใหม่

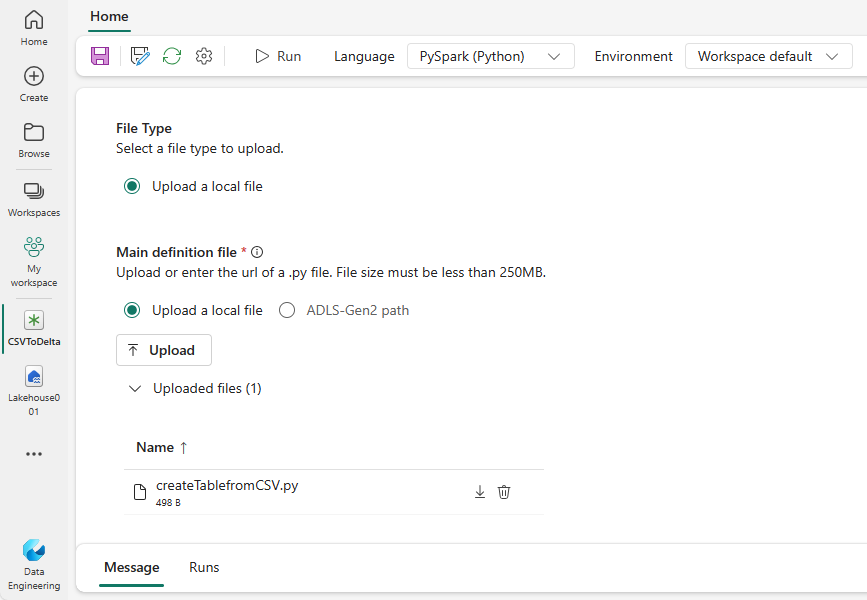

เลือก PySpark (Python) จากรายการแบบเลื่อนลง ของภาษา

ดาวน์โหลดตัวอย่าง createTablefromCSV.py และอัปโหลดเป็นไฟล์ข้อกําหนดหลัก แฟ้มข้อกําหนดหลัก (งาน) หลัก) เป็นไฟล์ที่มีตรรกะของแอปพลิเคชันและเป็นข้อบังคับในการเรียกใช้งาน Spark สําหรับแต่ละข้อกําหนดงาน Spark คุณสามารถอัปโหลดได้เพียงหนึ่งไฟล์ข้อกําหนดหลักเท่านั้น

คุณสามารถอัปโหลดไฟล์ข้อกําหนดหลักจากเดสก์ท็อปภายในเครื่องของคุณ หรือคุณสามารถอัปโหลดจาก Azure Data Lake Storage (ADLS) Gen2 ที่มีอยู่ได้โดยกําหนดเส้นทาง ABFSS แบบเต็มของไฟล์ ตัวอย่างเช่น:

abfss://your-storage-account-name.dfs.core.windows.net/your-file-pathอัปโหลดไฟล์อ้างอิงเป็นไฟล์.py ไฟล์อ้างอิงคือโมดูล python ที่นําเข้าโดยไฟล์ข้อกําหนดหลัก เช่นเดียวกับไฟล์ข้อกําหนดหลัก คุณสามารถอัปโหลดจากเดสก์ท็อปของคุณหรือ ADLS Gen2 ที่มีอยู่ได้ รองรับไฟล์อ้างอิงหลายรายการ

เคล็ดลับ

หากคุณใช้เส้นทาง ADLS Gen2 เพื่อให้แน่ใจว่าไฟล์สามารถเข้าถึงได้คุณต้องให้บัญชีผู้ใช้ที่ทํางานสิทธิ์ที่เหมาะสมกับบัญชีเก็บข้อมูล เราขอแนะนําสองวิธีในการทําเช่นนี้:

- กําหนดบัญชีผู้ใช้บทบาทผู้สนับสนุนสําหรับบัญชีเก็บข้อมูล

- ให้สิทธิ์การอ่านและการดําเนินการแก่บัญชีผู้ใช้สําหรับไฟล์ผ่านรายการควบคุมการเข้าถึง ADLS Gen2 (ACL)

สําหรับการเรียกใช้ด้วยตนเอง บัญชีของผู้ใช้เข้าสู่ระบบปัจจุบันจะถูกใช้เพื่อเรียกใช้งาน

ระบุอาร์กิวเมนต์บรรทัดคําสั่งสําหรับงาน ถ้าจําเป็น ใช้ช่องว่างเป็นตัวแยกเพื่อแยกอาร์กิวเมนต์

เพิ่มการอ้างอิงของเลคเฮ้าส์ไปยังงาน คุณต้องมีการอ้างอิงของเลคเฮ้าส์อย่างน้อยหนึ่งรายการในงาน เลคเฮ้าส์นี้เป็นบริบทของเลคเฮาส์เริ่มต้นสําหรับงาน

การอ้างอิงของเลคเฮ้าส์หลายรายการได้รับการรองรับ ค้นหาชื่อเลคเฮ้าส์ที่ไม่ใช่ค่าเริ่มต้นและ URL ของ OneLake ทั้งหมดในหน้า Spark การตั้งค่า

สร้างข้อกําหนดงาน Spark สําหรับ Scala/Java

การสร้างข้อกําหนดงาน Spark สําหรับ Scala/Java:

สร้างข้อกําหนดงาน Spark ใหม่

เลือก Spark(Scala/Java) จากรายการแบบเลื่อนลงของ ภาษา

อัปโหลดไฟล์ข้อกําหนดหลักเป็นไฟล์.jar ไฟล์ข้อกําหนดหลักคือไฟล์ที่มีตรรกะของแอปพลิเคชันของงานนี้และเป็นข้อบังคับในการเรียกใช้งาน Spark สําหรับแต่ละข้อกําหนดงาน Spark คุณสามารถอัปโหลดได้เพียงหนึ่งไฟล์ข้อกําหนดหลักเท่านั้น ใส่ชื่อคลาสหลัก

อัปโหลดไฟล์อ้างอิงเป็นไฟล์.jar ไฟล์อ้างอิงคือไฟล์ที่อ้างอิง/นําเข้าโดยไฟล์คํานิยามหลัก

ระบุอาร์กิวเมนต์บรรทัดคําสั่งสําหรับงาน ถ้าจําเป็น

เพิ่มการอ้างอิงของเลคเฮ้าส์ไปยังงาน คุณต้องมีการอ้างอิงของเลคเฮ้าส์อย่างน้อยหนึ่งรายการในงาน เลคเฮ้าส์นี้เป็นบริบทของเลคเฮาส์เริ่มต้นสําหรับงาน

สร้างข้อกําหนดงาน Spark สําหรับ R

เมื่อต้องสร้างข้อกําหนดงาน Spark สําหรับ SparkR(R):

สร้างข้อกําหนดงาน Spark ใหม่

เลือก SparkR(R) จากรายการแบบเลื่อนลง ภาษา

อัปโหลดไฟล์ข้อกําหนดหลักเป็น ไฟล์ R ไฟล์ข้อกําหนดหลักคือไฟล์ที่มีตรรกะของแอปพลิเคชันของงานนี้และเป็นข้อบังคับในการเรียกใช้งาน Spark สําหรับแต่ละข้อกําหนดงาน Spark คุณสามารถอัปโหลดได้เพียงหนึ่งไฟล์ข้อกําหนดหลักเท่านั้น

อัปโหลดไฟล์อ้างอิงเป็น ไฟล์ R ไฟล์อ้างอิงคือไฟล์ที่อ้างอิง/นําเข้าโดยไฟล์คํานิยามหลัก

ระบุอาร์กิวเมนต์บรรทัดคําสั่งสําหรับงาน ถ้าจําเป็น

เพิ่มการอ้างอิงของเลคเฮ้าส์ไปยังงาน คุณต้องมีการอ้างอิงของเลคเฮ้าส์อย่างน้อยหนึ่งรายการในงาน เลคเฮ้าส์นี้เป็นบริบทของเลคเฮาส์เริ่มต้นสําหรับงาน

หมายเหตุ

ข้อกําหนดงาน Spark จะถูกสร้างขึ้นในพื้นที่ทํางานปัจจุบันของคุณ

ตัวเลือกเพื่อกําหนดข้อกําหนดงาน Spark

มีตัวเลือกสองสามตัวเพื่อกําหนดการดําเนินการตามข้อกําหนดงาน Spark เพิ่มเติม

- การคํานวณ Spark: ภายใน แท็บ Spark Compute คุณสามารถดู เวอร์ชัน รันไทม์ซึ่งเป็นเวอร์ชันของ Spark ที่จะใช้เพื่อเรียกใช้งานได้ คุณยังสามารถดูการตั้งค่าการกําหนดค่า Spark ที่จะใช้เพื่อเรียกใช้งานได้ คุณสามารถกําหนดการตั้งค่าการกําหนดค่า Spark เองได้โดยการคลิกที่ปุ่ม เพิ่ม

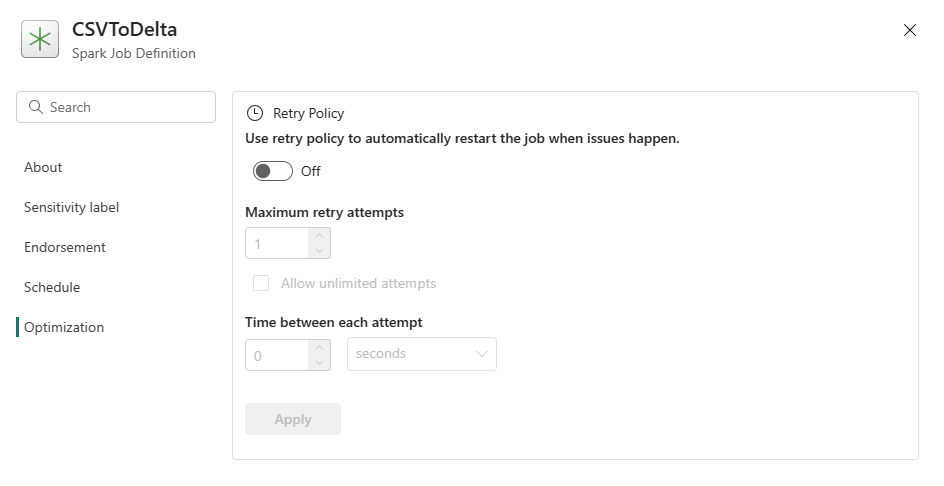

การปรับให้เหมาะสม: บนแท็บ การปรับให้เหมาะสม คุณสามารถเปิดใช้งานและตั้งค่า นโยบาย การลองใหม่สําหรับงานได้ เมื่อเปิดใช้งาน ระบบจะลองงานใหม่หากล้มเหลว คุณยังสามารถตั้งค่าจํานวนสูงสุดของการลองใหม่และช่วงเวลาระหว่างการลองใหม่ สําหรับแต่ละความพยายามอีกครั้ง งานจะเริ่มต้นใหม่ ตรวจสอบให้แน่ใจว่างานเป็น นิจพล

เนื้อหาที่เกี่ยวข้อง

คำติชม

เร็วๆ นี้: ตลอดปี 2024 เราจะขจัดปัญหา GitHub เพื่อเป็นกลไกคำติชมสำหรับเนื้อหา และแทนที่ด้วยระบบคำติชมใหม่ สำหรับข้อมูลเพิ่มเติม ให้ดู: https://aka.ms/ContentUserFeedback

ส่งและดูข้อคิดเห็นสำหรับ