แปลงข้อมูลโดยการเรียกใช้กิจกรรม Azure Databricks

กิจกรรม Azure Databricks ใน Data Factory สําหรับ Microsoft Fabric ช่วยให้คุณสามารถประสานงาน Azure Databricks ต่อไปนี้:

- โน้ตบุ๊ก

- เหยือก

- Python

บทความนี้ให้คําแนะนําทีละขั้นตอนที่อธิบายวิธีการสร้างกิจกรรม Azure Databricks โดยใช้อินเทอร์เฟซ Data Factory

ข้อกำหนดเบื้องต้น

เมื่อต้องการเริ่มต้นใช้งาน คุณต้องดําเนินการข้อกําหนดเบื้องต้นต่อไปนี้ให้เสร็จสมบูรณ์:

- บัญชีผู้เช่าที่มีการสมัครใช้งานที่ใช้งานอยู่ สร้างบัญชีฟรี

- พื้นที่ทํางานจะถูกสร้างขึ้น

การกําหนดค่ากิจกรรม Azure Databricks

เมื่อต้องการใช้กิจกรรม Azure Databricks ในไปป์ไลน์ ให้ทําตามขั้นตอนต่อไปนี้:

การกําหนดค่าการเชื่อมต่อ

สร้างไปป์ไลน์ใหม่ในพื้นที่ทํางานของคุณ

คลิกที่ เพิ่มกิจกรรมของไปป์ไลน์ และค้นหา Azure Databricks

อีกวิธีหนึ่งคือ คุณสามารถค้นหา Azure Databricks ในบานหน้าต่างกิจกรรมไปป์ไลน์ และเลือกเพื่อเพิ่มลงในพื้นที่ทํางานของไปป์ไลน์

เลือกกิจกรรม Azure Databricks ใหม่บนพื้นที่ทํางานถ้ายังไม่ได้เลือกไว้

โปรดดูคําแนะนําการตั้งค่าทั่วไปเพื่อกําหนดค่าแท็บ การตั้งค่าทั่วไป

การกําหนดค่าคลัสเตอร์

เลือกแท็บคลัสเตอร์ จากนั้นคุณสามารถเลือกที่มีอยู่ หรือสร้างการเชื่อมต่อ Azure Databricks ใหม่ แล้วเลือกคลัสเตอร์งานใหม่ คลัสเตอร์แบบโต้ตอบที่มีอยู่ หรือกลุ่มอินสแตนซ์ที่มีอยู่

ขึ้นอยู่กับสิ่งที่คุณเลือกสําหรับคลัสเตอร์ กรอกข้อมูลในเขตข้อมูลสอดคล้องกันตามที่แสดง

- ภายใต้คลัสเตอร์งานใหม่และกลุ่มอินสแตนซ์ที่มีอยู่ คุณยังสามารถกําหนดค่าจํานวนของผู้ปฏิบัติงานและเปิดใช้งานอินสแตนซ์สปอต

คุณยังสามารถระบุการตั้งค่าคลัสเตอร์เพิ่มเติม เช่น นโยบายคลัสเตอร์ การกําหนดค่า Spark ตัวแปรสภาพแวดล้อม Spark และแท็กแบบกําหนดเอง ตามที่จําเป็นสําหรับคลัสเตอร์ที่คุณกําลังเชื่อมต่อ นอกจากนี้ยังสามารถเพิ่มสคริปต์เริ่มต้น Databricks และ เส้นทาง ปลายทางบันทึกคลัสเตอร์ภายใต้การตั้งค่าคลัสเตอร์เพิ่มเติมได้

หมายเหตุ

คุณสมบัติคลัสเตอร์ขั้นสูงทั้งหมดและนิพจน์แบบไดนามิกที่ได้รับการสนับสนุนใน Azure Data Factory Azure Databricks ที่เชื่อมโยงบริการในขณะนี้ยังได้รับการสนับสนุนในกิจกรรม Azure Databricks ใน Microsoft Fabric ภายใต้ส่วน 'การกําหนดค่าคลัสเตอร์เพิ่มเติม' ใน UI เมื่อคุณสมบัติเหล่านี้รวมอยู่ภายใน UI ของกิจกรรม ซึ่งสามารถใช้กับนิพจน์ (เนื้อหาแบบไดนามิก) ได้อย่างง่ายดายโดยไม่จําเป็นต้องมีข้อกําหนด JSON ขั้นสูงในบริการ Azure Data Factory Databricks ที่เชื่อมโยงกัน

กิจกรรม Azure Databricks ในขณะนี้ยังสนับสนุน นโยบายคลัสเตอร์และการสนับสนุนแค็ตตาล็อก Unity

- ภายใต้การตั้งค่าขั้นสูง คุณมีตัวเลือกใน การเลือกนโยบาย คลัสเตอร์เพื่อให้คุณสามารถระบุการกําหนดค่าคลัสเตอร์ที่ได้รับอนุญาตให้

- นอกจากนี้ภายใต้การตั้งค่าขั้นสูงคุณมีตัวเลือกใน การกําหนดค่าโหมด การเข้าถึงแค็ตตาล็อก Unity สําหรับความปลอดภัยที่เพิ่ม ชนิดของโหมดการเข้าถึงที่พร้อมใช้งานคือ:

- โหมด การเข้าถึงผู้ใช้เดี่ยว โหมดนี้ถูกออกแบบมาสําหรับสถานการณ์ที่แต่ละคลัสเตอร์ใช้โดยผู้ใช้คนเดียว ตรวจสอบให้แน่ใจว่าการเข้าถึงข้อมูลภายในคลัสเตอร์ถูกจํากัดให้ผู้ใช้รายนั้นเท่านั้น โหมดนี้มีประโยชน์สําหรับงานที่จําเป็นต้องแยกและการจัดการข้อมูลแต่ละรายการ

- โหมด การเข้าถึงที่ใช้ร่วมกันในโหมดนี้ ผู้ใช้หลายคนสามารถเข้าถึงคลัสเตอร์เดียวกันได้ ซึ่งจะรวมการกํากับดูแลข้อมูลของ Unity Catalog เข้ากับรายการควบคุมการเข้าถึงตารางเดิม (ACL) โหมดนี้ช่วยให้สามารถทํางานร่วมกันในการเข้าถึงข้อมูลในขณะที่ยังคงกํากับดูแลและโปรโตคอลความปลอดภัย อย่างไรก็ตาม มีข้อจํากัดบางอย่าง เช่น ไม่สนับสนุน Databricks Runtime ML งาน Spark-submit และ Spark APIs และ UDF เฉพาะ

- ไม่มีโหมด การเข้าถึง โหมดนี้จะปิดใช้งานการโต้ตอบกับแค็ตตาล็อก Unity ซึ่งหมายความว่าคลัสเตอร์ไม่สามารถเข้าถึงข้อมูลที่จัดการโดย Unity Catalog ได้ โหมดนี้มีประโยชน์สําหรับปริมาณงานที่ไม่จําเป็นต้องมีคุณลักษณะการกํากับดูแลของแค็ตตาล็อก Unity

การกําหนดค่า

เลือกแท็บการตั้งค่า คุณสามารถเลือกระหว่าง 3 ตัวเลือกที่ Azure Databricks ชนิดที่คุณต้องการจัดลําดับได้

การประยุกต์ประเภทสมุดบันทึกในกิจกรรม Azure Databricks:

ภายใต้แท็บ การตั้งค่า คุณสามารถเลือก ปุ่มตัวเลือก สมุดบันทึก เพื่อเรียกใช้สมุดบันทึกได้ คุณจะต้องระบุเส้นทางสมุดบันทึกที่จะดําเนินการบน Azure Databricks พารามิเตอร์ฐานที่เลือกได้ที่จะส่งผ่านไปยังสมุดบันทึกและไลบรารีเพิ่มเติมใด ๆ ที่จะติดตั้งบนคลัสเตอร์เพื่อดําเนินงาน

การจัดเรียงชนิด Jar ในกิจกรรม Azure Databricks:

ภายใต้ แท็บการตั้งค่า คุณสามารถเลือก ปุ่มตัวเลือก Jar เพื่อเรียกใช้ Jar ได้ คุณจะต้องระบุชื่อคลาสที่จะดําเนินการบน Azure Databricks พารามิเตอร์ฐานที่เลือกได้ที่จะส่งผ่านไปยัง Jar และไลบรารีเพิ่มเติมใด ๆ ที่จะติดตั้งบนคลัสเตอร์เพื่อดําเนินงาน

การประสานประเภท Python ในกิจกรรม Azure Databricks:

ภายใต้แท็บ การตั้งค่า คุณสามารถเลือกปุ่มตัวเลือก Python เพื่อเรียกใช้ไฟล์ Python ได้ คุณจะต้องระบุเส้นทางภายใน Azure Databricks ไปยังไฟล์ Python ที่จะดําเนินการ พารามิเตอร์พื้นฐานทางเลือกที่จะส่งผ่าน และไลบรารีเพิ่มเติมใด ๆ ที่จะติดตั้งบนคลัสเตอร์เพื่อดําเนินงาน

ไลบรารีที่สนับสนุนสําหรับกิจกรรม Azure Databricks

ในคําจํากัดความกิจกรรม Databricks ข้างต้น คุณสามารถระบุประเภทไลบรารีเหล่านี้ได้: jar, ไข่, whl, maven, pypi, cran

สําหรับข้อมูลเพิ่มเติม ให้ดูเอกสาร ประกอบ Databricks สําหรับชนิดไลบรารี

การส่งผ่านพารามิเตอร์ระหว่างกิจกรรม Azure Databricks และไปป์ไลน์

คุณสามารถส่งผ่านพารามิเตอร์ไปยังสมุดบันทึกได้โดยใช้ คุณสมบัติ baseParameters ในกิจกรรม databricks

ในบางกรณี คุณอาจต้องส่งค่าบางอย่างกลับจากสมุดบันทึกกลับไปยังบริการ ซึ่งสามารถใช้สําหรับควบคุมโฟลว์ (การตรวจสอบตามเงื่อนไข) ในบริการหรือโดยกิจกรรมปลายทาง (ขีดจํากัดขนาดคือ 2 MB)

ตัวอย่างเช่น ในสมุดบันทึกของคุณ คุณอาจเรียกใช้ dbutils.notebook.exit("returnValue") และ "returnValue" ที่สอดคล้องกันจะถูกส่งกลับไปยังบริการ

คุณสามารถใช้เอาต์พุตในบริการโดยใช้นิพจน์ เช่น

@{activity('databricks activity name').output.runOutput}

บันทึกและเรียกใช้หรือจัดกําหนดการไปป์ไลน์

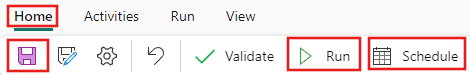

หลังจากที่คุณกําหนดค่ากิจกรรมอื่น ๆ ที่จําเป็นสําหรับไปป์ไลน์ของคุณแล้ว ให้สลับไปยัง แท็บ หน้าแรก ที่ด้านบนของตัวแก้ไขไปป์ไลน์และเลือกปุ่มบันทึกเพื่อบันทึกไปป์ไลน์ของคุณ เลือก เรียกใช้ เพื่อเรียกใช้โดยตรง หรือ กําหนดเวลา เพื่อกําหนดเวลา คุณยังสามารถดูประวัติการเรียกใช้ที่นี่ หรือกําหนดค่าการตั้งค่าอื่นๆ ได้