Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

Nesne REST API özelliği, Azure Databricks'in Verileri Okumasına ve Azure NetApp Files birimlerine yazmasına olanak tanır ve veri alımından model dağıtımına kadar uçtan uca veri bilimi iş akışlarını destekler.

Azure Databricks'e bağlanmak için, Databricks işlem uç noktalarına SSL sertifikasını yüklemek için bir başlatma (init) betiği yapılandırırsınız. Bu kurulumun kullanılması, Azure Databricks ile Azure NetApp Files nesnesi REST API özellikli biriminiz arasında güvenli iletişim sağlar.

Başlamadan önce

Şu durumlara sahip olduğunuzdan emin olun:

- REST API özellikli bir Azure NetApp Files nesnesi birimini yapılandırın

- Etkin bir Azure Databricks çalışma alanı

init betiğini oluşturma

Init betiği küme başlatma sırasında çalışır. Başlatma betikleri hakkında daha fazla bilgi için bkz. Başlatma betikleri nedir?

SSL sertifikasını yüklemek için bir bash betiği yazın. Betiği .sh uzantısıyla kaydedin. Örneğin:

#!/bin/bash cat << 'EOF' > /usr/local/share/ca-certificates/myca.crt -----BEGIN CERTIFICATE----- -----END CERTIFICATE----- EOF update-ca-certificates PEM_FILE="/etc/ssl/certs/myca.pem" PASSWORD="changeit" JAVA_HOME=$(readlink -f /usr/bin/java | sed "s:bin/java::") KEYSTORE="$JAVA_HOME/lib/security/cacerts" CERTS=$(grep 'END CERTIFICATE' $PEM_FILE| wc -l) # To process multiple certificates with keytool, you need to extract each one from the PEM file and import it into the Java KeyStore. for N in $(seq 0 $(($CERTS - 1))); do ALIAS="$(basename $PEM_FILE)-$N" echo "Adding to keystore with alias:$ALIAS" cat $PEM_FILE | awk "n==$N { print }; /END CERTIFICATE/ { n++ }" | keytool -noprompt -import -trustcacerts \ -alias $ALIAS -keystore $KEYSTORE -storepass $PASSWORD done echo "export REQUESTS_CA_BUNDLE=/etc/ssl/certs/ca-certificates.crt" >> /databricks/spark/conf/spark-env.sh echo "export SSL_CERT_FILE=/etc/ssl/certs/ca-certificates.crt" >> /databricks/spark/conf/spark-env.sh #echo "volume IP URL of the bucket >> /etc/hostsBash betiğini Databricks Dosya Sistemi'ne (DBFS) yüklemek için Databricks CLI veya Databricks kullanıcı arabirimini kullanın. Daha fazla bilgi için bkz. Azure Databricks'te dosyalarla çalışma.

Kümeyi yapılandırma

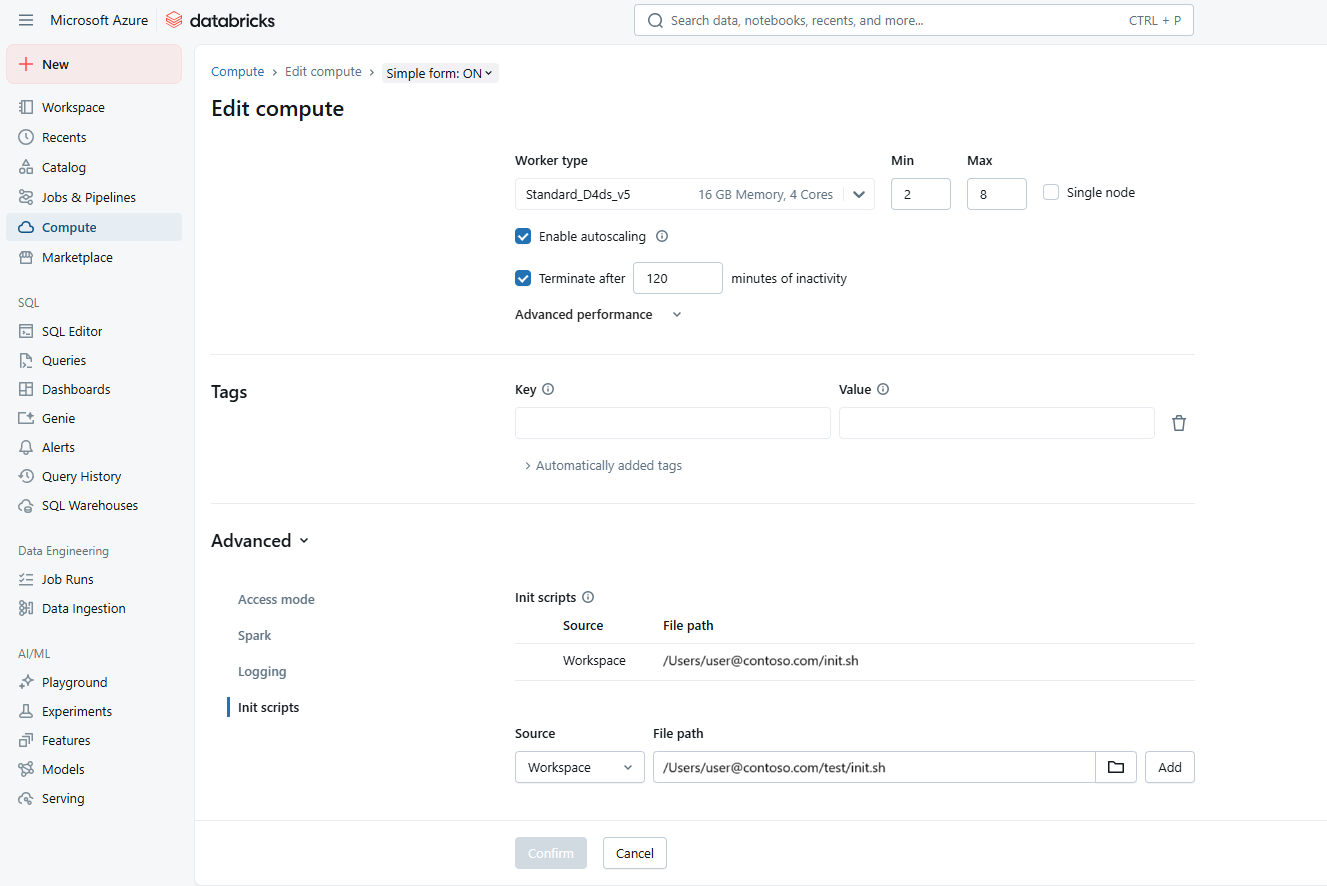

Azure Databricks çalışma alanınıza gidin. Küme yapılandırma ayarlarını açın.

Gelişmiş Seçenekler bölümünde, Init Betikleri'nin altına init betiğinin yolunu ekleyin. Örneğin:

dbfs:/path/to/your/script.shinit.sh betiğini seçin. Ekle'yi ve ardından Onayla'yı seçin.

Değişiklikleri uygulamak ve SSL sertifikasını yüklemek için kümeyi yeniden başlatın.

Günlüklerde sertifikanın doğru yerleştirilip yerleştirilmediğini doğrulayın.

Azure NetApp Files demetine bağlanma

Databricks, kimlik bilgilerini depolamak için gizli kapsamların kullanılmasını önerir. Daha fazla bilgi için bkz. Gizli dizin kapsamlarını yönetme.

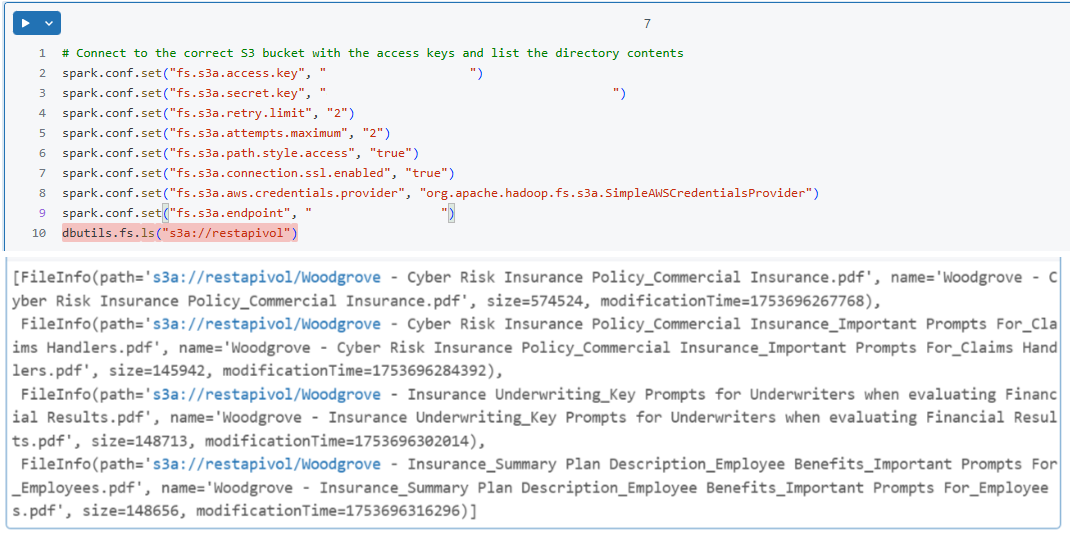

Databricks not defterinizde Spark oturumunu Azure NetApp Files demetine bağlanacak şekilde yapılandırın. Örneğin:

spark.conf.set("fs.s3a.endpoint", "https://your-s3-endpoint") spark.conf.set("fs.s3a.access.key", "your-access-key") spark.conf.set("fs.s3a.secret.key", "your-secret-key") spark.conf.set("fs.s3a.connection.ssl.enabled", "true")Basit bir okuma işlemi gerçekleştirerek bağlantıyı doğrulayın. Örneğin:

df = spark.read.csv("s3a://your-bucket/path/to/data.csv") df.show()