Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

Azure Container Apps, temel alınan altyapıyı yönetmek zorunda kalmadan gpu'lara isteğe bağlı erişim sağlar. Sunucusuz bir özellik olarak yalnızca kullanımdaki GPU'lar için ödeme alırsınız. Etkinleştirildiğinde, uygulamanız için kullanılan GPU sayısı artar ve uygulamanızın yük taleplerini karşılamak için düşer. Sunucusuz GPU'lar otomatik ölçeklendirme, iyileştirilmiş soğuk başlangıç, kullanımda olmadığında ölçeği sıfıra indirerek saniye başına faturalama ve daha az işlem yükü ile iş yüklerinizi sorunsuz bir şekilde çalıştırmanızı sağlar.

Sunucusuz GPU'lar yalnızca Tüketim iş yükü profilleri için desteklenir. Özellik yalnızca tüketim ortamları için desteklenmez.

Not

GPU'lara erişmek için GPU kotaları istemeniz gerekir. GPU kota isteğinizi bir müşteri destek talebi aracılığıyla gönderebilirsiniz.

Sosyal haklar

Sunucusuz GPU'lar, çekirdek yapay zeka kodunuz üzerinde odaklanmanıza ve GPU'ları kullanırken altyapıyı yönetmeye daha az odaklanmanıza olanak tanıyarak yapay zeka geliştirmeyi hızlandırır. Bu özellik, Azure AI model kataloğunun sunucusuz API'leri ile yönetilen işlemdeki barındırma modelleri arasında bir orta katman seçeneği sağlar.

Container Apps sunucusuz GPU desteği, verileriniz kapsayıcınızın sınırlarını asla terk etmediği için tam veri idaresi sağlarken, yine de uygulamalarınızı oluşturmak için yönetilen, sunucusuz bir platform sağlar.

Container Apps'te sunucusuz GPU'ları kullandığınızda, uygulamalarınız şunları alır:

Sıfıra ölçeklendirilen GPU'lar: NVIDIA A100 ve NVIDIA T4 GPU'larının otomatik sunucusuz ölçeklendirme desteği.

Saniye başına faturalama: Yalnızca kullandığınız GPU işlem için ödeme yapın.

Yerleşik veri idaresi: Verileriniz hiçbir zaman kapsayıcı sınırından ayrılmaz.

Esnek işlem seçenekleri: NVIDIA A100 veya T4 GPU türleri arasında seçim yapabilirsiniz.

Yapay zeka geliştirme için orta katman: Yönetilen, sunucusuz bir işlem platformunda kendi modelinizi getirin.

Genel senaryolar

Aşağıdaki senaryolarda sunucusuz GPU'lar için yaygın kullanım örnekleri açıklanmaktadır.

Gerçek zamanlı ve toplu çıkarım: Hızlı başlangıç süreleri, otomatik ölçeklendirme ve saniye başına faturalama modeli ile özel açık kaynak modelleri kullanın. Sunucusuz GPU'lar dinamik uygulamalar için idealdir. Yalnızca kullandığınız bilgi işlem kapasitesi için ödeme yapılır ve uygulamalarınız talebi karşılamak için otomatik olarak ölçeklendirilir.

Makine öğrenmesi senaryoları: hassas ayarlı özel yapay zeka modelleri, derin öğrenme, sinir ağları veya büyük ölçekli veri analizi uygulayan uygulamaları önemli ölçüde hızlandırabilirsiniz.

High-Performance Bilgi İşlem (HPC):Bilimsel bilgi işlem, finansal modelleme veya hava durumu tahmini gibi karmaşık hesaplamalar ve simülasyonlar gerektiren uygulamalarda yüksek hesaplama talepleri için GPU'ları kaynak olarak kullanın.

İşleme ve Görselleştirme: 3B işleme, görüntü işleme veya video kodlama içeren uygulamalarda işleme sürecini hızlandırmak ve gerçek zamanlı görselleştirmeyi etkinleştirmek için GPU'ları kullanın.

Büyük Veri Analizi: GPU'lar büyük veri kümeleri arasında veri işleme ve analiz işlemlerini hızlandırabilir.

Dikkat edilmesi gereken noktalar

Sunucusuz GPU'ları kullanırken aşağıdaki öğeleri göz önünde bulundurun:

CUDA sürümü: Sunucusuz GPU'lar en son CUDA sürümünü destekler.

Destek sınırlamaları:

- Bir uygulamadaki yalnızca bir kapsayıcı GPU'ları aynı anda kullanabilir. Bir uygulamada birden çok kapsayıcınız varsa, ilk kapsayıcı GPU'ya erişim elde eder.

- Birden çok uygulama aynı GPU iş yükü profilini paylaşabilir ancak her biri kendi kopyasını gerektirir.

- Birden fazla ve kısmi GPU kopyaları desteklenmez.

- Uygulamanızdaki ilk kapsayıcı GPU'ya erişim kazanır.

IP adresleri: Tüketim GPU'ları, kendi sanal ağınızla tümleştirmeyi ayarlarken çoğaltma başına bir IP adresi kullanır.

Desteklenen bölgeler

Sunucusuz GPU'lar aşağıdaki bölgelerde kullanılabilir:

| Bölge | A100 | T4 |

|---|---|---|

| Doğu Avustralya | Evet | Evet |

| Güney Brezilya | Evet | Evet |

| Orta Hindistan | Hayı | Evet |

| East US | Evet | Evet |

| Orta Fransa | Hayı | Evet |

| Italy North | Evet | Evet |

| Japonya Doğu | Hayı | Evet |

| ABD'nin Kuzey Orta Bölgesi | Hayı | Evet |

| ABD'nin Güney Merkez Bölgesi | Hayı | Evet |

| Güneydoğu Asya | Hayı | Evet |

| South India | Hayı | Evet |

| Orta İsveç | Evet | Evet |

| Batı Avrupa1 | Hayı | Evet |

| Batı ABD | Evet | Evet |

| Batı ABD 2 | Hayı | Evet |

| Batı ABD 3 | Evet | Evet |

1 Batı Avrupa'da T4 sunucusuz GPU iş yükü profili eklemek için bölgede yeni bir iş yükü profili ortamı oluşturmanız gerekir.

Sunucusuz GPU'ları kullanma

Azure portalı aracılığıyla bir kapsayıcı uygulaması oluşturduğunuzda, kapsayıcınızı GPU kaynaklarını kullanacak şekilde ayarlayabilirsiniz.

Oluşturma işleminin Kapsayıcı sekmesinde aşağıdaki ayarları yapın:

Kapsayıcı kaynağı ayırma bölümünün altında GPU onay kutusunu seçin.

GPU Türü için NVIDIA A100 veya NVIDIA T4 seçeneğini belirleyin.

Sunucusuz GPU iş yükü profilini yönetme

Sunucusuz GPU'lar tüketim GPU iş yükü profillerinde çalışır. Tüketim GPU iş yükü profilini diğer iş yükü profilleriyle aynı şekilde yönetirsiniz. CLI veya Azure portalını kullanarak iş yükü profilinizi yönetebilirsiniz.

Sunucusuz GPU kotası isteme

Not

Kurumsal anlaşmaları olan müşteriler ve kullandıkça öde müşterilerinin A100 ve T4 kotası varsayılan olarak etkinleştirilmiştir.

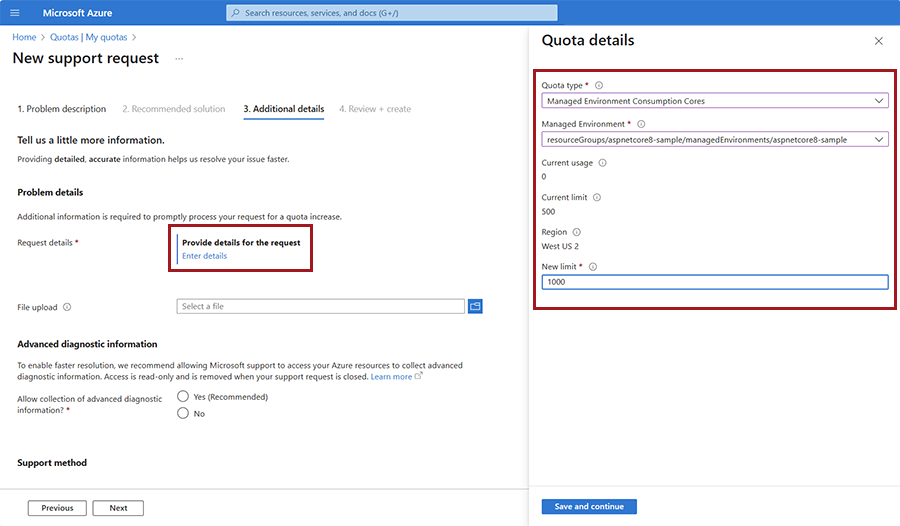

Bu özelliğe erişmek için sunucusuz GPU kotanız olmalıdır. GPU kota isteğinizi bir müşteri destek talebi aracılığıyla gönderebilirsiniz. GPU kota isteği için bir destek talebi açtığınızda, aşağıdaki seçenekleri belirleyin:

Azure portalında Yeni destek isteği formunu açın.

Forma aşağıdaki değerleri girin:

Mülkiyet Değer Sorun türü Hizmet ve abonelik sınırlarını (kotalar) seçin Subscription Aboneliğinizi seçin. Kota türü Container Apps'i seçin. sonrakiseçin.

Ek ayrıntılar penceresinde Ayrıntıları girin'i seçerek istek ayrıntıları penceresini açın.

Kota türü içinYönetilen Ortamda Tüketim NCA100 GPU'lar veya Yönetilen Ortamda Tüketim T4 GPU'lar seçin. Diğer değerlerinizi girin.

Kaydet ve devam et’i seçin.

İlgili ayrıntıların geri kalanını Ek ayrıntılar penceresinde doldurun.

sonrakiseçin.

Oluştur'i seçin.

GPU soğuk başlatmayı geliştirme

Depolama bağlamasında yapıt akışını etkinleştirerek ve büyük dil modelleri gibi büyük dosyaları bularak soğuk başlangıç sürelerini önemli ölçüde geliştirebilirsiniz.

Yapıt akışı: Azure Container Registry, görüntü başlatma sürelerini önemli ölçüde hızlandırabilen görüntü akışı sunar. Yapıt akışını kullanmak için kapsayıcı görüntülerinizi premium Azure Container Registry'de barındırmanız gerekir.

Depolama bağlamaları: Büyük dosyaları kapsayıcı uygulamanızla ilişkilendirilmiş bir Azure depolama hesabında depolayarak ağ gecikme süresinin etkilerini azaltın.

Foundry modellerini sunucusuz GPU'lara dağıtma (önizleme)

Azure Container Apps sunucusuz GPU'lar artık genel önizlemede Azure AI Foundry modellerini destekliyor. Azure AI Foundry Modellerinin iki dağıtım seçeneği vardır:

En popüler modellerden bazıları için kullandıkça öde faturalaması sağlayan sunucusuz API'ler.

GPU başına ödeme ile Foundry modellerinin tamamını dağıtmanıza olanak sağlayan yönetilen işlem.

Azure Container Apps sunucusuz GPU, Foundry modellerini dağıtmanız için sunucusuz API'ler ve yönetilen işlem arasında dengeli bir dağıtım seçeneği sunar. Bu seçenek, sunucusuz ölçeklendirme ile ihtiyaç üzerine çalışır, kullanılmadığında sıfıra kadar ölçeklenir ve veri yerleşimi gereksinimlerinize uyar. Sunucusuz GPU'larda, Dökümhane modellerini kullanmak, otomatik ölçeklendirme, saniye başına ödeme fiyatlandırması, tam veri idaresi, kurumsal ağ ve güvenlik desteği ile desteklenen tüm modelleri çalıştırma esnekliği sağlar.

Türdeki MLFLOW dil modelleri desteklenir. Modellerin MLFLOW listesini görmek için azureml kayıt defterinde kullanılabilen modellerin listesine gidin. Modelleri bulmak için aşağıdaki adımları kullanarak modeller için MLFLOW bir filtre ekleyin:

Filtre'yi seç.

Filtre Ekle'yi seçin.

Filtre kuralı için Tür = MLFLOW girin.

Burada Azure Container Apps deposunda listelenen modeller için, aşağıdaki CLI komutunu kullanarak kendi görüntünüzü oluşturmanıza gerek kalmadan bunları doğrudan sunucusuz GPU'lara dağıtabilirsiniz:

az containerapp up \

--name <CONTAINER_APP_NAME> \

--location <LOCATION> \

--resource-group <RESOURCE_GROUP_NAME> \

--model-registry <MODEL_REGISTRY_NAME> \

--model-name <MODEL_NAME> \

--model-version <MODEL_VERSION>

Bu listede olmayan herhangi bir model için şunları yapmanız gerekir:

Azure Container Apps deposundan model görüntüsü için GitHub şablonunu indirin.

score.py dosyasını model türünüzle eşleşecek şekilde değiştirin. Puanlama betiği ( score.py olarak adlandırılır), modelle nasıl etkileşim kurabileceğinizi tanımlar. Aşağıdaki örnekte özel bir score.py dosyasının nasıl kullanılacağı gösterilmektedir.

Görüntüyü oluşturun ve bir kapsayıcı kayıt defterine yükleyin.

Modeli sunucusuz GPU'lara dağıtmak için önceki CLI komutunu kullanın, ancak değerini

--imagebelirtin.--model-registry,--model-nameve--model-versionparametrelerini kullandığınızda, temel çevresel değişkenler, uygulamanızın soğuk başlangıç performansını optimize etmeniz için ayarlanır.

Geri bildirim gönderin

Azure Container Apps GitHub deposuna sorun gönderin.