Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

UYGULANANLAR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

İpucu

Kuruluşlar için hepsi bir arada analiz çözümü olan Microsoft Fabric'te Data Factory'yi deneyin. Microsoft Fabric , veri taşımadan veri bilimine, gerçek zamanlı analize, iş zekasına ve raporlamaya kadar her şeyi kapsar. Yeni bir deneme sürümünü ücretsiz olarak başlatmayı öğrenin!

İşlem hattındaki Azure Databricks Jar Etkinliği, Azure Databricks kümenizde Spark Jar çalıştırır. Bu makale , veri dönüştürme ve desteklenen dönüştürme etkinliklerine genel bir genel bakış sunan veri dönüştürme etkinlikleri makalesini oluşturur. Azure Databricks, Apache Spark çalıştırmaya yönelik yönetilen bir platformdur.

Bu özelliğe yönelik on bir dakikalık bir giriş ve tanıtım için, aşağıdaki videoyu izleyin:

Kullanıcı arabirimiyle bir işlem hattına Azure Databricks için Jar etkinliği ekleme

İşlem hattında Azure Databricks için Jar etkinliği kullanmak için aşağıdaki adımları tamamlayın:

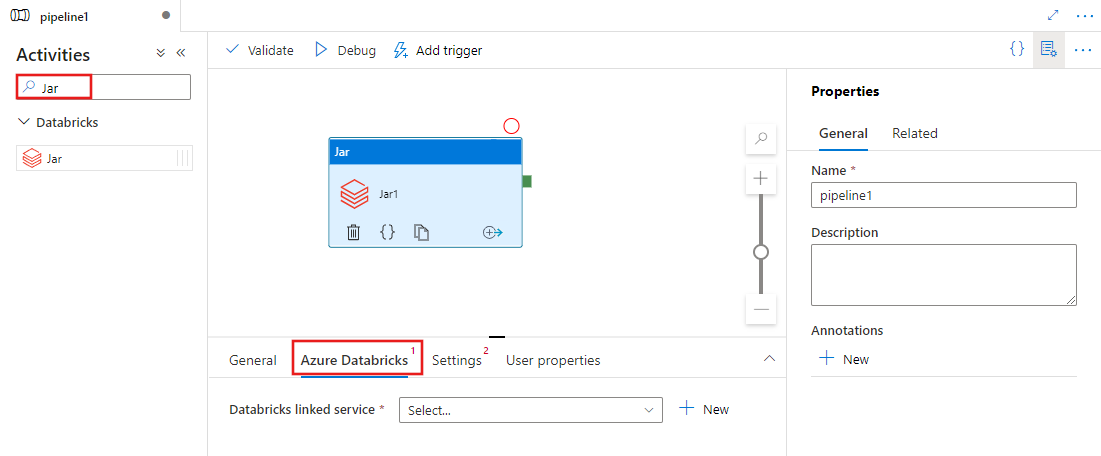

İşlem hattı Etkinlikleri bölmesinde Jar araması yapıp Jar etkinliğini işlem hattı tuvaline sürükleyin.

Henüz seçili değilse tuvaldeki yeni Jar etkinliğini seçin.

Jar etkinliğini yürütecek yeni bir Azure Databricks bağlı hizmeti seçmek veya oluşturmak için Azure Databricks sekmesini seçin.

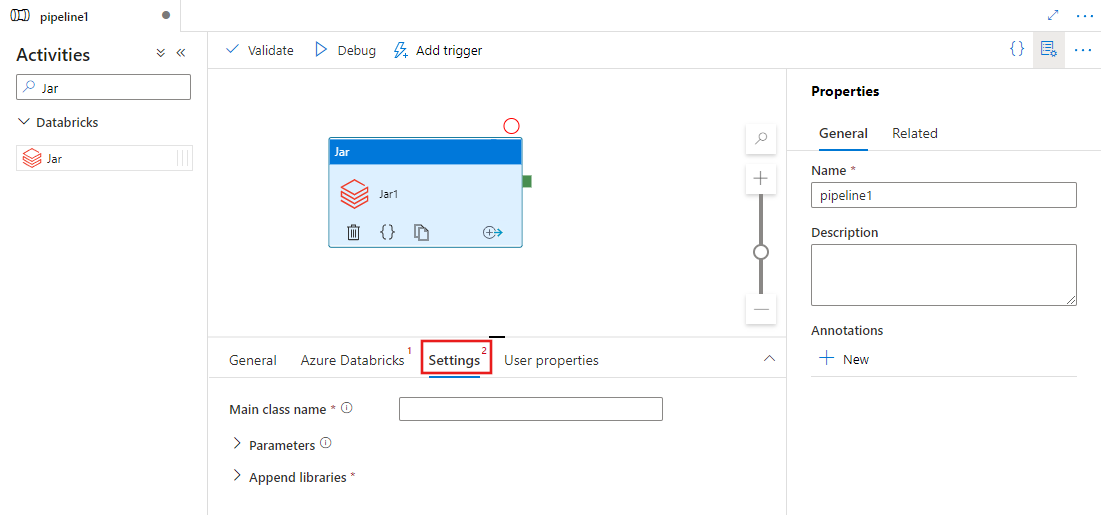

Ayarlar sekmesini seçin ve Azure Databricks'te yürütülecek bir sınıf adı, Jar'a geçirilecek isteğe bağlı parametreler ve işi yürütmek için kümeye yüklenecek kitaplıkları belirtin.

Databricks Jar etkinlik tanımı

Databricks Jar Etkinliğinin örnek JSON tanımı aşağıda verilmiştir:

{

"name": "SparkJarActivity",

"type": "DatabricksSparkJar",

"linkedServiceName": {

"referenceName": "AzureDatabricks",

"type": "LinkedServiceReference"

},

"typeProperties": {

"mainClassName": "org.apache.spark.examples.SparkPi",

"parameters": [ "10" ],

"libraries": [

{

"jar": "dbfs:/docs/sparkpi.jar"

}

]

}

}

Databricks Jar etkinlik özellikleri

Aşağıdaki tabloda JSON tanımında kullanılan JSON özellikleri açıklanmaktadır:

| Özellik | Açıklama | Gerekli |

|---|---|---|

| Adı | İşlem hattındaki etkinliğin adı. | Yes |

| açıklama | Etkinliğin ne yaptığını açıklayan metin. | Hayır |

| Tür | Databricks Jar Etkinliği için etkinlik türü DatabricksSparkJar'dır. | Yes |

| linkedServiceName | Jar etkinliğinin üzerinde çalıştığı Databricks Bağlı Hizmeti'nin adı. Bu bağlı hizmet hakkında bilgi edinmek için bkz . Bağlı hizmetleri hesaplama makalesi. | Yes |

| mainClassName | Yürütülecek ana yöntemi içeren sınıfın tam adı. Bu sınıf, kitaplık olarak sağlanan bir JAR içinde yer almalıdır. JAR dosyası birden çok sınıf içerebilir. Sınıfların her biri bir ana yöntem içerebilir. | Yes |

| parametreler | Main yöntemine geçirilecek parametreler. Bu özellik bir dize dizisidir. | Hayır |

| kitaplıklar | İşi yürütecek kümeye yüklenecek kitaplıkların listesi. Dize, nesne dizisi <olabilir> | Evet (mainClassName yöntemini içeren en az bir tane) |

Not

Bilinen Sorun - Eşzamanlı Databricks Jar etkinliklerini çalıştırmak için aynı Etkileşimli kümeyi kullanırken (küme yeniden başlatma olmadan), Databricks'te 1. etkinliğin parametrelerinde de aşağıdaki etkinliklerin kullanılmasıyla ilgili bilinen bir sorun vardır. Bu nedenle, sonraki işlere yanlış parametreler geçirilir. Bunu azaltmak için bunun yerine bir İş kümesi kullanın.

Databricks etkinlikleri için desteklenen kitaplıklar

Önceki Databricks etkinlik tanımında şu kitaplık türlerini belirttiniz: jar, egg, maven, pypi, . cran

{

"libraries": [

{

"jar": "dbfs:/mnt/libraries/library.jar"

},

{

"egg": "dbfs:/mnt/libraries/library.egg"

},

{

"maven": {

"coordinates": "org.jsoup:jsoup:1.7.2",

"exclusions": [ "slf4j:slf4j" ]

}

},

{

"pypi": {

"package": "simplejson",

"repo": "http://my-pypi-mirror.com"

}

},

{

"cran": {

"package": "ada",

"repo": "https://cran.us.r-project.org"

}

}

]

}

Daha fazla bilgi için kitaplık türleri için Databricks belgelerine bakın.

Databricks'te kitaplık yükleme

Çalışma Alanı kullanıcı arabirimini kullanabilirsiniz:

Kullanıcı arabirimi kullanılarak eklenen kitaplığın dbfs yolunu almak için Databricks CLI kullanabilirsiniz.

Jar kitaplıkları genellikle kullanıcı arabirimi kullanılırken dbfs:/FileStore/jars altında depolanır. Cli aracılığıyla tümünü listeleyebilirsiniz: databricks fs ls dbfs:/FileStore/job-jars

Databricks CLI'yi de kullanabilirsiniz:

Databricks CLI kullanma (yükleme adımları)

Örneğin, BIR JAR dosyasını dbfs'ye kopyalamak için:

dbfs cp SparkPi-assembly-0.1.jar dbfs:/docs/sparkpi.jar

İlgili içerik

Bu özelliğin on bir dakikalık tanıtımı ve tanıtımı için videoyu izleyin.