Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

Lakeflow Connect, yerel dosyalardan, popüler kurumsal uygulamalardan, veritabanlarından, bulut depolamadan, ileti veri verilerinden ve daha fazlasından veri almak için basit ve verimli bağlayıcılar sunar. Bu sayfada, Lakeflow Connect'in ETL performansını geliştirme yollarından bazıları özetlenmiştir. Ayrıca, tam yönetimli bağlayıcılardan tamamen özelleştirilebilir çerçevelere kadar, en yaygın kullanım senaryolarını ve desteklenen alım araçlarını kapsar.

Esnek hizmet modelleri

Lakeflow Connect kurumsal uygulamalar, bulut depolama alanı, veritabanları, ileti veri yolları ve daha fazlası için çok çeşitli bağlayıcılar sunar. Ayrıca aşağıdakiler arasında seçim yapma esnekliği sağlar:

| Seçenek | Açıklama |

|---|---|

| Tam olarak yönetilen bir hizmet | Hemen kullanıma hazır bağlayıcılar, basit arayüzler ve güçlü API'ler ile veri erişimini demokratikleştirir. Bu, uzun vadeli bakım maliyetlerini en aza indirirken hızlı bir şekilde güçlü alım işlem hatları oluşturmanıza olanak tanır. |

| Özelleştirilmiş işlem hattı | Daha fazla özelleştirmeye ihtiyacınız varsa Lakeflow Spark Bildirimli İşlem Hatlarını veya Yapılandırılmış Akış'ı kullanabilirsiniz. Sonuç olarak, bu çok yönlülük Lakeflow Connect'in kuruluşunuzun özel gereksinimlerini karşılamasını sağlar. |

Temel Databricks araçlarıyla birleştirme

Lakeflow Connect, kapsamlı veri yönetimi sağlamak için temel Databricks özelliklerini kullanır. Örneğin Unity Kataloğu'nu kullanarak yönetişim, Lakeflow Görevleri kullanarak orkestrasyon ve işlem hatlarınız çapında bütünsel izleme sunar. Bu, kuruluşunuzun veri güvenliğini, kalitesini ve maliyetini yönetmeye yardımcı olurken diğer veri mühendisliği araçlarınızla alım süreçlerinizi birleştirir. Lakeflow Connect, tercih ettiğiniz üçüncü taraf araçları dahil etme esnekliğine sahip açık bir Veri Zekası Platformu üzerine kurulmuştur. Bu, mevcut altyapınızla ve gelecekteki veri stratejilerinizle uyumlu uyarlanmış bir çözüm sağlar.

Hızlı, ölçeklenebilir alım

Lakeflow Connect, verimli alım sağlamak için artımlı okuma ve yazma işlemleri kullanır. Artımlı dönüşümler aşağı akışla birleştirildiğinde bu durum ETL performansını önemli ölçüde iyileştirebilir.

Yaygın kullanım örnekleri

Müşteriler, kuruluşlarının en zorlu sorunlarını çözmek için verileri alır. Örnek kullanım örnekleri şunlardır:

| Kullanım örneği | Açıklama |

|---|---|

| Müşteri 360 | Kampanya performansını ve müşteri adayı puanlamasını ölçme |

| Portföy yönetimi | Geçmiş ve tahmin modelleriyle yatırım getirisini en üst düzeye çıkarma |

| Tüketici analizi | Müşterilerinizin satın alma deneyimlerini kişiselleştirme |

| Merkezi insan kaynakları | Kuruluşunuzun iş gücünü destekleme |

| Dijital ikizler | Üretim verimliliğini artırma |

| RAG sohbet botları | Kullanıcıların ilkeleri, ürünleri ve daha fazlasını anlamasına yardımcı olmak için sohbet botları oluşturma |

ETL yığınının katmanları

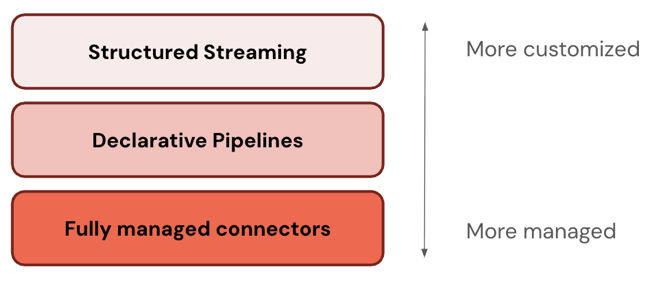

Bazı bağlayıcılar ETL yığınının bir düzeyinde çalışır. Örneğin Databricks, Salesforce gibi kurumsal uygulamalar ve SQL Server gibi veritabanları için tam olarak yönetilen bağlayıcılar sunar. Diğer bağlayıcılar ETL yığınının birden çok katmanında çalışır. Örneğin, tam özelleştirme için Yapılandırılmış Akış'ta standart bağlayıcıları veya daha yönetilen bir deneyim için Lakeflow Spark Bildirimli İşlem Hatları'nı kullanabilirsiniz. Benzer şekilde Apache Kafka, Amazon Kinesis, Google Pub/Sub ve Apache Pulsar'dan veri akışı için özelleştirme düzeyinizi seçebilirsiniz.

Databricks, en yönetilen katmandan başlamanızı önerir. Gereksinimlerinizi karşılamıyorsa (örneğin, veri kaynağınızı desteklemiyorsa), bir sonraki katmana geçin. Databricks, üç katmanda da daha fazla bağlayıcı desteğini genişletmeyi planlıyor.

Aşağıdaki tabloda, en özelleştirilebilenden en fazla yönetilene kadar sıralanmış olan üç istifleme ürünü katmanı açıklanmaktadır.

| Katman | Açıklama |

|---|---|

| Yapılandırılmış Akış | Yapılandırılmış Akış, neredeyse gerçek zamanlı olarak artımlı akış işlemeye yönelik bir API'dir. Güçlü performans, ölçeklenebilirlik ve hataya dayanıklılık sağlar. |

| Lakeflow Spark Deklaratif İşlem Hatları | Lakeflow Spark Bildirimli İşlem Hatları Yapılandırılmış Akış üzerine derlenir ve veri işlem hatları oluşturmak için bildirim temelli bir çerçeve sunar. Verileriniz üzerinde gerçekleştirilecek dönüştürmeleri tanımlayabilirsiniz ve Lakeflow Spark Bildirimli İşlem Hatları düzenlemeyi, izlemeyi, veri kalitesini, hataları ve daha fazlasını yönetir. Bu nedenle, Yapılandırılmış Akış'tan daha fazla otomasyon ve daha az ek yük sunar. |

| Tam olarak yönetilen bağlayıcılar | Tam yönetilen bağlayıcılar, Lakeflow Spark Deklaratif Boru Hatları üzerinde derlenir ve en popüler veri kaynakları için daha fazla otomasyon sunar. Lakeflow Spark Bildirimli İşlem Hatları işlevselliğini kaynağa özgü kimlik doğrulaması, CDC, uç olay işleme, uzun süreli API bakımı, otomatik yeniden denemeler, otomatik şema evrimi vb. içerecek şekilde genişletir. Bu nedenle, desteklenen tüm veri kaynakları için daha da fazla otomasyon sunar. |

Yönetilen bağlayıcılar

Kurumsal uygulamalardan ve veritabanlarından almak için tam olarak yönetilen bağlayıcılar kullanabilirsiniz.

Desteklenen bağlayıcılar şunlardır:

Desteklenen arabirimler şunlardır:

- Databricks kullanıcı arabirimi

- Databricks Varlık Paketleri

- Databricks API'leri

- Databricks SDK'ları

- Databricks Komut Satırı Arayüzü (CLI)

Standart bağlayıcılar

Yönetilen bağlayıcılara ek olarak Databricks, bulut nesne depolaması ve ileti veri yolları için özelleştirilebilir bağlayıcılar sunar. Bkz. Lakeflow Connect'te standart bağlayıcılar.

Dosya yükleme ve indirme

Yerel ağınızda bulunan dosyaları, bir birime yüklenmiş dosyaları veya İnternet konumundan indirilen dosyaları edinip işleyebilirsiniz. Bkz. Dosyalar.

Veri alma iş ortakları

Birçok üçüncü taraf araç, Databricks'e toplu veya akış veri alımını destekler. Databricks çeşitli üçüncü taraf tümleştirmelerini doğrular, ancak kaynak sistemlere erişimi yapılandırma ve verileri alma adımları araçlara göre farklılık gösterir. Doğrulanmış araçların listesi için bkz. Veri Alma İş Ortakları. Bazı teknoloji iş ortakları, üçüncü taraf araçlarını Lakehouse verilerine bağlamayı kolaylaştıran bir kullanıcı arabirimine sahip Databricks İş Ortağı Bağlantısı'nda da yer alır.

DIY işleme

Databricks genel bir işlem platformu sağlar. Sonuç olarak, Python veya Java gibi Databricks tarafından desteklenen herhangi bir programlama dilini kullanarak kendi alım bağlayıcılarınızı oluşturabilirsiniz. Ayrıca veri yükleme aracı, Airbyte ve Debezium gibi popüler açık kaynak bağlayıcı kitaplıklarını içeri aktarabilir ve kullanabilirsiniz.

Alternatif alım yöntemleri

Databricks, yüksek veri hacimlerine, düşük gecikme süreli sorgulamaya ve üçüncü taraf API sınırlarına uyacak şekilde ölçeklendirildiğinden çoğu kullanım örneği için alımı önerir. Veri alımı, kaynak sistemlerinizdeki verileri Azure Databricks'e kopyalar ve bu da zaman içinde eskimiş olabilecek yinelenen verilere neden olur. Verileri kopyalamak istemiyorsanız aşağıdaki araçları kullanabilirsiniz:

| Araç | Açıklama |

|---|---|

| Lakehouse Federasyonu | Verilerinizi taşımadan dış veri kaynaklarını sorgulamanıza olanak tanır. |

| Delta Paylaşımı | Verileri platformlar, bulutlar ve bölgeler arasında güvenli bir şekilde paylaşmanızı sağlar. |