Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

Lakeflow Spark Bildirimli İşlem Hatları'nın (SDP) ne olduğunu, bunu tanımlayan temel kavramları (işlem hatları, akış tabloları ve gerçekleştirilmiş görünümler gibi), bu kavramlar arasındaki ilişkileri ve veri işleme iş akışlarınızda kullanmanın avantajlarını öğrenin.

Uyarı

Lakeflow Spark Deklaratif İşlem Hatları Premium planı gerektirir. Daha fazla bilgi için Databricks hesap ekibinize başvurun.

SDP nedir?

Lakeflow Spark Bildirimli İşlem Hatları, SQL ve Python'da toplu işlem ve akış veri işlem hatlarını geliştirmeye ve çalıştırmaya yönelik bildirim temelli bir çerçevedir. Lakeflow SDP, performans açısından iyileştirilmiş Databricks Runtime üzerinde çalışırken Apache Spark Bildirimli İşlem Hatları ile genişletilir ve birlikte çalışabilir ve Lakeflow Spark Bildirimli İşlem Hatları flows API'si Apache Spark ve Yapılandırılmış Akış ile aynı DataFrame API'sini kullanır. SDP için yaygın kullanım örnekleri arasında bulut depolama (Amazon S3, Azure ADLS 2. Nesil ve Google Cloud Storage dahil) ve ileti veri yolları (Apache Kafka, Amazon Kinesis, Google Pub/Sub, Azure EventHub ve Apache Pulsar gibi) kaynaklardan artımlı veri alımı, durum bilgisi olmayan ve durum bilgisi olan operatörlerle artımlı toplu iş ve akış dönüştürmeleri ve ileti veri yolları ve veritabanları gibi işlem depoları arasında gerçek zamanlı akış işleme sayılabilir.

Bildirim temelli veri işleme hakkında daha fazla bilgi için bkz . Databricks'te yordamsal ve bildirim temelli veri işleme.

SDP'nin avantajları nelerdir?

SDP'nin bildirim temelli yapısı , Apache Spark ve Spark Yapılandırılmış Akış API'leri ile veri işlemleri geliştirmeye ve Bunları Lakeflow İşleri aracılığıyla el ile düzenlemeyi kullanarak Databricks Runtime ile çalıştırmaya kıyasla aşağıdaki avantajları sağlar.

- Otomatik düzenleme: SDP, doğru yürütme sırasını ve en iyi performans için en yüksek paralellik düzeyini sağlamak için işleme adımlarını ("akışlar" olarak adlandırılır) otomatik olarak düzenler. Ayrıca, işlem hatları geçici hataları otomatik ve verimli bir şekilde yeniden dener. Yeniden deneme işlemi en ayrıntılı ve uygun maliyetli birim olan Spark göreviyle başlar. Görev düzeyi yeniden deneme başarısız olursa, SDP akışı yeniden denemeye devam eder ve gerekirse son olarak işlem hattının tamamını dener.

- Bildirim temelli işleme: SDP, yüzlerce hatta binlerce satırlık el ile Spark ve Yapılandırılmış Akış kodunu yalnızca birkaç satıra indirgeyebilen bildirim temelli işlevler sağlar. SDP AUTO CDC API'si , Değişiklik Veri Yakalama (CDC) olaylarının işlenmesini hem SCD Tür 1 hem de SCD Tür 2 desteğiyle basitleştirir. Manuel kodlamayı sıra dışı olayları işlemek için ortadan kaldırır ve akış semantiğini veya filigranlar gibi kavramları bilmeyi gerektirmez.

- Artımlı işleme: SDP, gerçekleştirilmiş görünümler için artımlı işleme altyapısı sağlar. Bunu kullanmak için dönüştürme mantığınızı toplu iş semantiğiyle yazarsınız ve motor, mümkün olduğunda yalnızca veri kaynaklarındaki yeni verileri ve değişiklikleri işler. Artımlı işleme, kaynaklarda yeni veriler veya değişiklikler gerçekleştiğinde verimsiz yeniden işlemeyi azaltır ve artımlı işlemeyi işlemek için el ile kod gereksinimini ortadan kaldırır.

Önemli Kavramlar

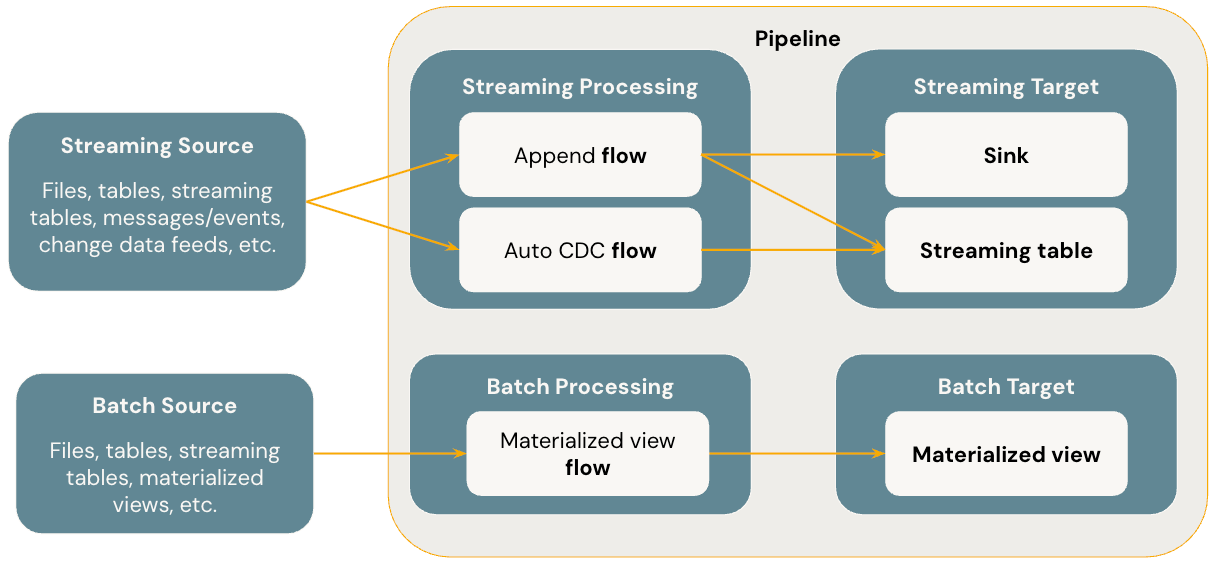

Aşağıdaki diyagramda Lakeflow Spark Bildirimli İşlem Hatları'nın en önemli kavramları gösterilmektedir.

Flows

Akış, SDP'de hem akış hem de toplu iş semantiğini destekleyen temel veri işleme kavramıdır. Akış bir kaynaktan verileri okur, kullanıcı tanımlı işleme mantığını uygular ve sonucu bir hedefe yazar. SDP, Spark Yapılandırılmış Akış ile aynı akış akış türünü (Ekleme, Güncelleştirme, Tamamlama) paylaşır. (Şu anda yalnızca Ekleme akışı kullanıma sunulur.) Daha fazla ayrıntı için bkz. Yapılandırılmış Akış'taki çıkış modları.

Lakeflow Spark Bildirimli İşlem Hatları ek akış türleri de sağlar:

- AUTO CDC , Lakeflow SDP'de sıra dışı CDC olaylarını işleyen ve hem SCD Tür 1 hem de SCD Tür 2'yi destekleyen benzersiz bir akış akışıdır. Otomatik CDC, Apache Spark Bildirimli İşlem Hatlarında kullanılamaz.

- Gerçekleştirilmiş görünüm , SDP'de yalnızca yeni verileri ve kaynak tablolardaki değişiklikleri mümkün olduğunca işleyen bir toplu iş akışıdır.

Daha fazla ayrıntı için bkz:

Akış tabloları

Akış tablosu, Unity Kataloğu tarafından yönetilen bir tablodur ve aynı zamanda Lakeflow SDP için bir akış hedefi olarak kullanılır. Akış tablosunda bir veya daha fazla akış akışı (Ekle, AUTO CDC) yazılabilir. AUTO CDC , yalnızca Databricks'teki akış tablolarında kullanılabilen benzersiz bir akış akışıdır. Akış akışlarını hedef akış tablosundan açıkça ve ayrı olarak tanımlayabilirsiniz. Akış akışlarını, akış tablosu tanımının bir parçası olarak örtük olarak da tanımlayabilirsiniz.

Daha fazla ayrıntı için bkz:

Gerçekleştirilmiş görünümler

Gerçekleştirilmiş görünüm aynı zamanda Unity Catalog tarafından yönetilen tablonun bir türüdür ve bir toplu iş hedefidir. Gerçekleştirilmiş görünümde bir veya daha fazla görünüm akışı yazılabilir. Gerçekleştirilmiş görünümler, akış tablolarından farklıdır ve akışları her zaman örtük olarak gerçekleştirilmiş görünüm tanımının bir parçası olarak tanımlarsınız.

Daha fazla ayrıntı için bkz:

Sinks

Havuz, işlem hattı için bir akış hedefidir ve Delta tablolarını, Apache Kafka konularını, Azure EventHubs konularını ve özel Python veri kaynaklarını destekler. Bir havuza bir veya daha fazla akış akışı (Ekle) yazılabilir.

Daha fazla ayrıntı için bkz:

Boru Hatları

İşlem hattı, Lakeflow Spark Bildirimli İşlem Hatlarında geliştirme ve yürütme birimidir. İşlem hattı bir veya daha fazla akış, akış tabloları, gerçekleştirilmiş görünümler ve havuz içerebilir. İşlem hattı kaynak kodunuzda akışları, akış tablolarını, malzeme edilmiş görünümleri ve alıcıları tanımlayıp ardından işlem hattını çalıştırarak SDP'yi kullanırsınız. İşlem hattınız çalışırken tanımlı akışlarınızın, akış tablolarınızın, gerçekleştirilmiş görünümlerinizin ve havuzlarınızın bağımlılıklarını analiz eder ve bunların yürütme ve paralelleştirme sırasını otomatik olarak düzenler.

Daha fazla ayrıntı için bkz:

Databricks SQL işlem hatları

Akış tabloları ve gerçekleştirilmiş görünümler Databricks SQL'deki iki temel özelliktir. Databricks SQL'de akış tabloları ve gerçekleştirilmiş görünümler oluşturmak ve yenilemek için standart SQL kullanabilirsiniz. Databricks SQL'deki akış tabloları ve gerçekleştirilmiş görünümler, aynı Azure Databricks altyapısında çalışır ve Lakeflow Spark Bildirimli İşlem Hatlarıyla aynı işleme semantiğine sahiptir. Databricks SQL'de akış tablolarını ve gerçekleştirilmiş görünümleri kullandığınızda akış tabloları ve gerçekleştirilmiş görünüm tanımı kapsamında akışlar örtük olarak tanımlanır.

Daha fazla ayrıntı için bkz: