SAP NetWeaver için Red Hat Enterprise Linux üzerinde Azure Sanal Makineler'de GlusterFS

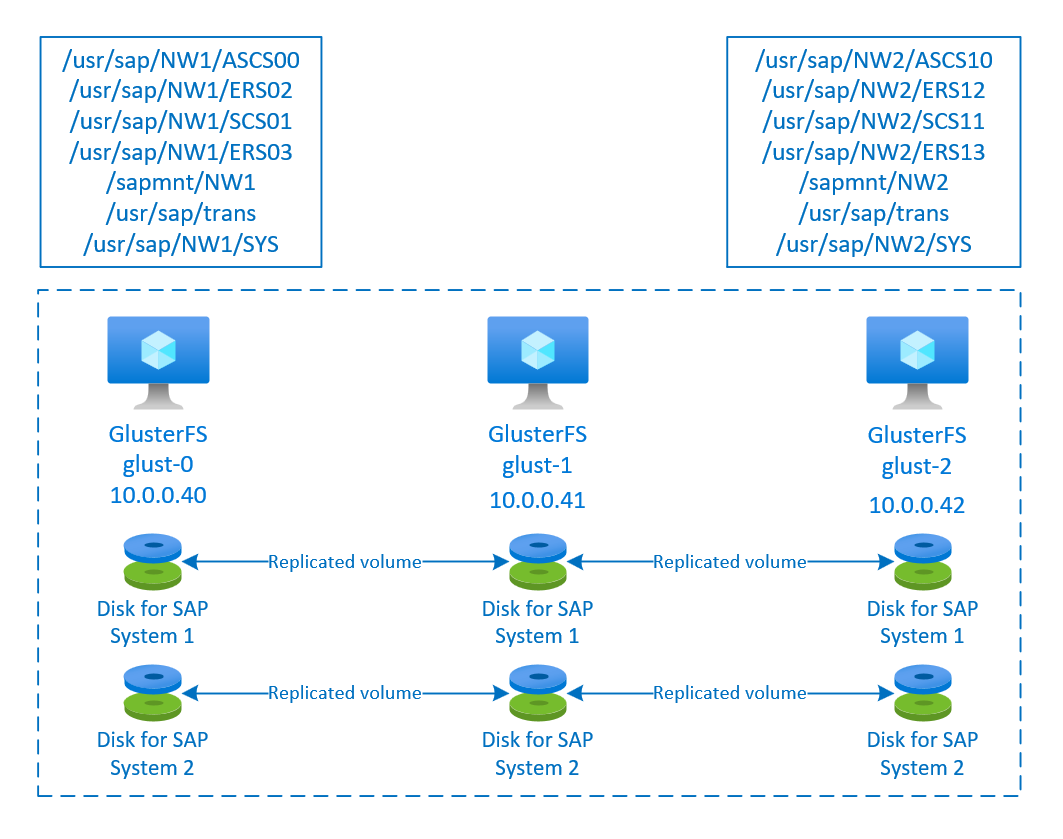

Bu makalede, sanal makinelerin nasıl dağıtılacağı, sanal makinelerin nasıl yapılandırılacağı ve yüksek oranda kullanılabilir bir SAP sisteminin paylaşılan verilerini depolamak için kullanılabilecek bir GlusterFS kümesinin nasıl yükleneceği açıklanır. Bu kılavuzda, NW1 ve NW2 olmak üzere iki SAP sistemi tarafından kullanılan GlusterFS'nin nasıl ayarlanacağı açıklanmaktadır. Örnekteki kaynakların (örneğin sanal makineler, sanal ağlar) adları, SAP dosya sunucusu şablonunu kaynak ön eki glust ile kullandığınızı varsayar.

Red Hat Gluster Depolama Yaşam Döngüsü Red Hat Gluster Storage'da belgelendiği gibi 2024'ün sonunda ömrünün sonuna ulaşacağını unutmayın. Yapılandırma, kullanım ömrü sona erene kadar Azure'da SAP için desteklenecektir. GlusterFS yeni dağıtımlar için kullanılmamalıdır. AZURE NetApp Files ile Azure Dosyalar'da NFS ile RHEL üzerinde SAP NW için HA veya RHEL üzerinde SAP NW için HA'da belgelendiği gibi, Azure Dosyalar veya Azure NetApp Files birimlerinde NFS üzerinde SAP paylaşılan dizinlerini dağıtmanızı öneririz.

Önce aşağıdaki SAP Notlarını ve kağıtlarını okuyun

SAP Not 1928533, şunlara sahiptir:

- SAP yazılımının dağıtımı için desteklenen Azure VM boyutlarının listesi

- Azure VM boyutları için önemli kapasite bilgileri

- Desteklenen SAP yazılımı, işletim sistemi (OS) ve veritabanı birleşimleri

- Microsoft Azure'da Windows ve Linux için gerekli SAP çekirdek sürümü

SAP Not 2015553 , Azure'da SAP tarafından desteklenen SAP yazılım dağıtımları için önkoşulları listeler.

SAP Note 2002167 , Red Hat Enterprise Linux için işletim sistemi ayarlarını önermiştir

SAP Not 2009879 , Red Hat Enterprise Linux için SAP HANA Yönergelerine sahiptir

SAP Not 2178632 , Azure'da SAP için bildirilen tüm izleme ölçümleri hakkında ayrıntılı bilgiler içerir.

SAP Not 2191498 , Azure'da Linux için gerekli SAP Konak Aracısı sürümüne sahiptir.

SAP Not 2243692 , Azure'da Linux üzerinde SAP lisanslama hakkında bilgi içerir.

SAP Not 1999351 , SAP için Azure Gelişmiş İzleme Uzantısı için ek sorun giderme bilgileri içerir.

SAP Community WIKI'de Linux için tüm gerekli SAP Notları bulunur.

Linux üzerinde SAP için Azure Sanal Makineler planlama ve uygulama

Linux üzerinde SAP için Azure Sanal Makineler dağıtımı (bu makale)

Genel RHEL belgeleri

Azure'a özgü RHEL belgeleri:

Genel bakış

Yüksek kullanılabilirlik elde etmek için SAP NetWeaver paylaşılan depolama gerektirir. GlusterFS ayrı bir kümede yapılandırılır ve birden çok SAP sistemi tarafından kullanılabilir.

GlusterFS'i ayarlama

Bu örnekte kaynaklar Azure portalı aracılığıyla el ile dağıtılmıştır.

Azure portalı aracılığıyla Linux'ı el ile dağıtma

Bu belgede zaten bir kaynak grubu, Azure Sanal Ağ ve alt ağ dağıttığınız varsayılır.

GlusterFS için sanal makineleri dağıtın. Gluster depolama için desteklenen uygun bir RHEL görüntüsü seçin. Vm'yi kullanılabilirlik seçeneklerinden herhangi birinde (ölçek kümesi, kullanılabilirlik alanı veya kullanılabilirlik kümesi) dağıtabilirsiniz.

GlusterFS'yi yapılandırma

Aşağıdaki öğelere [A] - tüm düğümler için geçerlidir, [1] - yalnızca düğüm 1, [2] için geçerlidir - yalnızca düğüm 2, [3] için geçerlidir - yalnızca düğüm 3 için geçerlidir.

[A] Konak adı çözümlemesi ayarlama

Bir DNS sunucusu kullanabilir veya tüm düğümlerde /etc/hosts dosyasını değiştirebilirsiniz. Bu örnekte /etc/hosts dosyasının nasıl kullanılacağı gösterilmektedir. Aşağıdaki komutlarda IP adresini ve ana bilgisayar adını değiştirin

sudo vi /etc/hosts/etc/hosts öğesine aşağıdaki satırları ekleyin. IP adresini ve ana bilgisayar adını ortamınızla eşleşecek şekilde değiştirme

# IP addresses of the Gluster nodes 10.0.0.40 glust-0 10.0.0.41 glust-1 10.0.0.42 glust-2[A] Kayıt

Sanal makinelerinizi kaydedin ve RHEL 7 ve GlusterFS depolarını içeren bir havuza ekleyin

sudo subscription-manager register sudo subscription-manager attach --pool=<pool id>[A] GlusterFS depolarını etkinleştirme

Gerekli paketleri yüklemek için aşağıdaki depoları etkinleştirin.

sudo subscription-manager repos --disable "*" sudo subscription-manager repos --enable=rhel-7-server-rpms sudo subscription-manager repos --enable=rh-gluster-3-for-rhel-7-server-rpms[A] GlusterFS paketlerini yükleme

Bu paketleri tüm GlusterFS düğümlerine yükleyin

sudo yum -y install redhat-storage-serverYüklemeden sonra düğümleri yeniden başlatın.

[A] Güvenlik Duvarını Değiştir

GlusterFS düğümlerine istemci trafiğine izin vermek için güvenlik duvarı kuralları ekleyin.

# list the available zones firewall-cmd --get-active-zones sudo firewall-cmd --zone=public --add-service=glusterfs --permanent sudo firewall-cmd --zone=public --add-service=glusterfs[A] GlusterFS hizmetini etkinleştirme ve başlatma

Tüm düğümlerde GlusterFS hizmetini başlatın.

sudo systemctl start glusterd sudo systemctl enable glusterd[1] GluserFS Oluşturma

GlusterFS kümesini oluşturmak için aşağıdaki komutları çalıştırın

sudo gluster peer probe glust-1 sudo gluster peer probe glust-2 # Check gluster peer status sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-1 # Uuid: 10d43840-fee4-4120-bf5a-de9c393964cd # State: Accepted peer request (Connected) # # Hostname: glust-2 # Uuid: 9e340385-12fe-495e-ab0f-4f851b588cba # State: Accepted peer request (Connected)[2] Eş durumunu test edin

İkinci düğümde eş durumunu test edin

sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-0 # Uuid: 6bc6927b-7ee2-461b-ad04-da123124d6bd # State: Peer in Cluster (Connected) # # Hostname: glust-2 # Uuid: 9e340385-12fe-495e-ab0f-4f851b588cba # State: Peer in Cluster (Connected)[3] Eş durumunu test edin

Üçüncü düğümde eş durumunu test edin

sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-0 # Uuid: 6bc6927b-7ee2-461b-ad04-da123124d6bd # State: Peer in Cluster (Connected) # # Hostname: glust-1 # Uuid: 10d43840-fee4-4120-bf5a-de9c393964cd # State: Peer in Cluster (Connected)[A] LVM Oluşturma

Bu örnekte GlusterFS iki SAP sistemi için kullanılır: NW1 ve NW2. Bu SAP sistemleri için LVM yapılandırmaları oluşturmak için aşağıdaki komutları kullanın.

NW1 için bu komutları kullanın

sudo pvcreate --dataalignment 1024K /dev/disk/azure/scsi1/lun0 sudo pvscan sudo vgcreate --physicalextentsize 256K rhgs-NW1 /dev/disk/azure/scsi1/lun0 sudo vgscan sudo lvcreate -l 50%FREE -n rhgs-NW1/sapmnt sudo lvcreate -l 20%FREE -n rhgs-NW1/trans sudo lvcreate -l 10%FREE -n rhgs-NW1/sys sudo lvcreate -l 50%FREE -n rhgs-NW1/ascs sudo lvcreate -l 100%FREE -n rhgs-NW1/aers sudo lvscan sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/sapmnt sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/trans sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/sys sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/ascs sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/aers sudo mkdir -p /rhs/NW1/sapmnt sudo mkdir -p /rhs/NW1/trans sudo mkdir -p /rhs/NW1/sys sudo mkdir -p /rhs/NW1/ascs sudo mkdir -p /rhs/NW1/aers sudo chattr +i /rhs/NW1/sapmnt sudo chattr +i /rhs/NW1/trans sudo chattr +i /rhs/NW1/sys sudo chattr +i /rhs/NW1/ascs sudo chattr +i /rhs/NW1/aers echo -e "/dev/rhgs-NW1/sapmnt\t/rhs/NW1/sapmnt\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/trans\t/rhs/NW1/trans\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/sys\t/rhs/NW1/sys\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/ascs\t/rhs/NW1/ascs\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/aers\t/rhs/NW1/aers\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab sudo mount -aNW2 için bu komutları kullanın

sudo pvcreate --dataalignment 1024K /dev/disk/azure/scsi1/lun1 sudo pvscan sudo vgcreate --physicalextentsize 256K rhgs-NW2 /dev/disk/azure/scsi1/lun1 sudo vgscan sudo lvcreate -l 50%FREE -n rhgs-NW2/sapmnt sudo lvcreate -l 20%FREE -n rhgs-NW2/trans sudo lvcreate -l 10%FREE -n rhgs-NW2/sys sudo lvcreate -l 50%FREE -n rhgs-NW2/ascs sudo lvcreate -l 100%FREE -n rhgs-NW2/aers sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/sapmnt sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/trans sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/sys sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/ascs sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/aers sudo mkdir -p /rhs/NW2/sapmnt sudo mkdir -p /rhs/NW2/trans sudo mkdir -p /rhs/NW2/sys sudo mkdir -p /rhs/NW2/ascs sudo mkdir -p /rhs/NW2/aers sudo chattr +i /rhs/NW2/sapmnt sudo chattr +i /rhs/NW2/trans sudo chattr +i /rhs/NW2/sys sudo chattr +i /rhs/NW2/ascs sudo chattr +i /rhs/NW2/aers sudo lvscan echo -e "/dev/rhgs-NW2/sapmnt\t/rhs/NW2/sapmnt\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/trans\t/rhs/NW2/trans\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/sys\t/rhs/NW2/sys\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/ascs\t/rhs/NW2/ascs\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/aers\t/rhs/NW2/aers\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab sudo mount -a[1] Dağıtılmış birimi oluşturma

NW1 için GlusterFS birimini oluşturmak ve başlatmak için aşağıdaki komutları kullanın.

sudo gluster vol create NW1-sapmnt replica 3 glust-0:/rhs/NW1/sapmnt glust-1:/rhs/NW1/sapmnt glust-2:/rhs/NW1/sapmnt force sudo gluster vol create NW1-trans replica 3 glust-0:/rhs/NW1/trans glust-1:/rhs/NW1/trans glust-2:/rhs/NW1/trans force sudo gluster vol create NW1-sys replica 3 glust-0:/rhs/NW1/sys glust-1:/rhs/NW1/sys glust-2:/rhs/NW1/sys force sudo gluster vol create NW1-ascs replica 3 glust-0:/rhs/NW1/ascs glust-1:/rhs/NW1/ascs glust-2:/rhs/NW1/ascs force sudo gluster vol create NW1-aers replica 3 glust-0:/rhs/NW1/aers glust-1:/rhs/NW1/aers glust-2:/rhs/NW1/aers force sudo gluster volume start NW1-sapmnt sudo gluster volume start NW1-trans sudo gluster volume start NW1-sys sudo gluster volume start NW1-ascs sudo gluster volume start NW1-aersNW2 için GlusterFS birimini oluşturmak ve başlatmak için aşağıdaki komutları kullanın.

sudo gluster vol create NW2-sapmnt replica 3 glust-0:/rhs/NW2/sapmnt glust-1:/rhs/NW2/sapmnt glust-2:/rhs/NW2/sapmnt force sudo gluster vol create NW2-trans replica 3 glust-0:/rhs/NW2/trans glust-1:/rhs/NW2/trans glust-2:/rhs/NW2/trans force sudo gluster vol create NW2-sys replica 3 glust-0:/rhs/NW2/sys glust-1:/rhs/NW2/sys glust-2:/rhs/NW2/sys force sudo gluster vol create NW2-ascs replica 3 glust-0:/rhs/NW2/ascs glust-1:/rhs/NW2/ascs glust-2:/rhs/NW2/ascs force sudo gluster vol create NW2-aers replica 3 glust-0:/rhs/NW2/aers glust-1:/rhs/NW2/aers glust-2:/rhs/NW2/aers force sudo gluster volume start NW2-sapmnt sudo gluster volume start NW2-trans sudo gluster volume start NW2-sys sudo gluster volume start NW2-ascs sudo gluster volume start NW2-aers

Sonraki adımlar

- SAP ASCS ve veritabanını yükleme

- SAP için Azure Sanal Makineler planlama ve uygulama

- SAP için Azure Sanal Makineler dağıtımı

- SAP için Azure Sanal Makineler DBMS dağıtımı

- Azure'da (büyük örnekler) yüksek kullanılabilirlik sağlamayı ve SAP HANA'nın olağanüstü durum kurtarmasını planlamayı öğrenmek için bkz . AZURE'da SAP HANA (büyük örnekler) yüksek kullanılabilirlik ve olağanüstü durum kurtarma.

- Azure VM'lerinde SAP HANA'nın olağanüstü durum kurtarmasını planlama ve yüksek kullanılabilirlik oluşturma hakkında bilgi edinmek için bkz. Azure Sanal Makineler'de SAP HANA'nın Yüksek Kullanılabilirliği (VM'ler)