Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

Bu makalede, Parquet biçiminde bir Azure Data Lake Storage 2. Nesil hesabındaki Event Hubs'ta akış verilerini otomatik olarak yakalamak için kod düzenleyicisi yok özelliğinin nasıl kullanılacağı açıklanmaktadır.

Önkoşullar

Yakalanan verileri depolamak için kapsayıcı içeren bir olay hub'ı ve Azure Data Lake Storage 2. Nesil hesabı olan bir Azure Event Hubs ad alanı. Bu kaynakların genel olarak erişilebilir olması ve azure sanal ağında bir güvenlik duvarının arkasında veya güvenliği sağlanamaz olması gerekir.

Olay hub'larınız yoksa Hızlı Başlangıç: Olay hub'ı oluşturma başlığı altındaki yönergeleri izleyerek bir tane oluşturun.

Data Lake Storage 2. Nesil hesabınız yoksa Depolama hesabı oluşturma başlığındaki yönergeleri izleyerek bir hesap oluşturun

Event Hubs örneğinizdeki (olay hub'ı) veriler JSON, CSV veya Avro biçiminde seri hale getirilmelidir. Olay hub'ınızın Event Hubs Örneği sayfasında şu adımları izleyin:

Verileri yakalamak için iş yapılandırma

Azure Data Lake Storage 2. Nesil'da veri yakalamak üzere bir Stream Analytics işi yapılandırmak için aşağıdaki adımları kullanın.

Azure portalında olay hub'ınıza gidin.

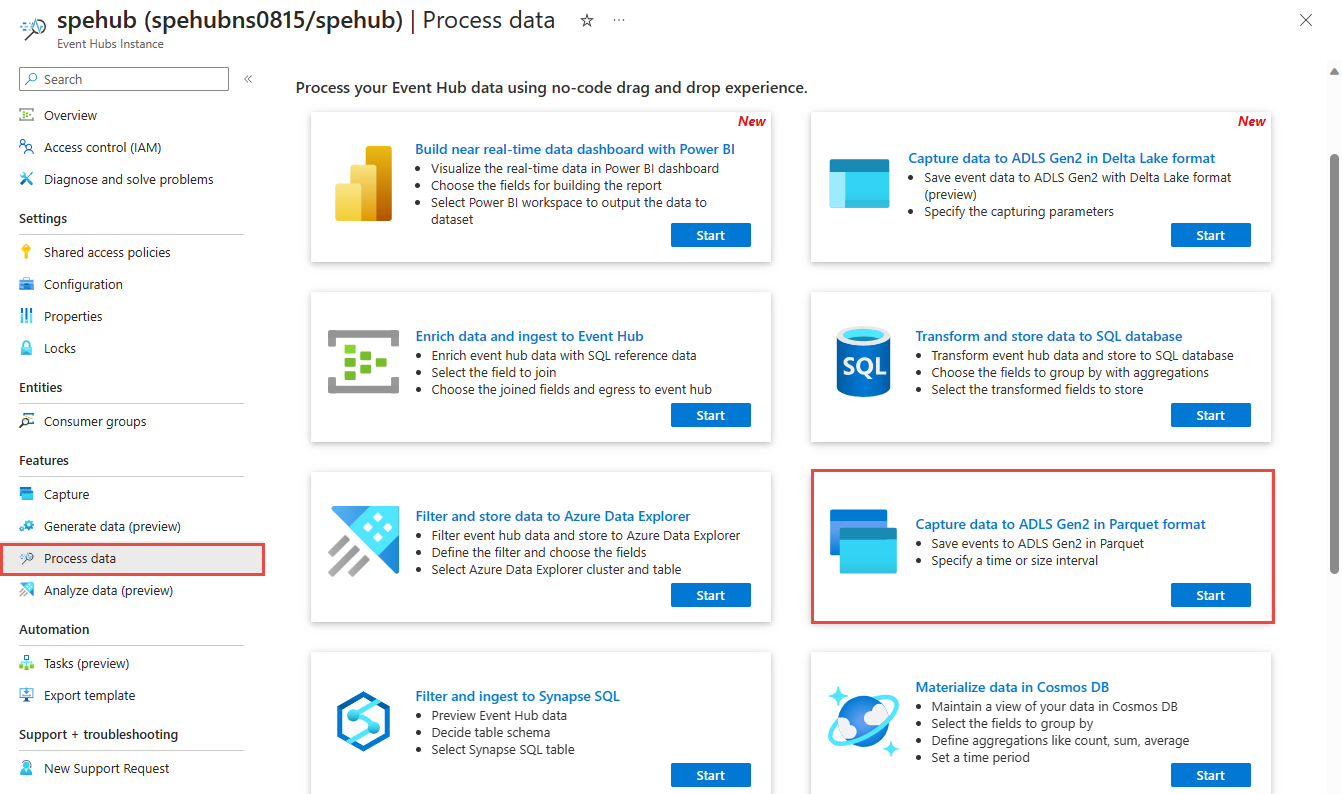

Soldaki menüde Özellikler'in altında verileri işle'yi seçin. Ardından, Verileri Parquet biçiminde ADLS 2. Nesil'e yakala kartında Başlat'ı seçin.

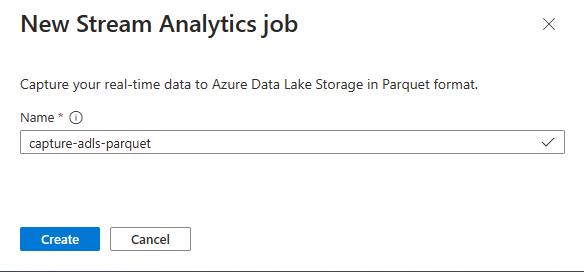

Stream Analytics işiniz için bir ad girin ve Oluştur'u seçin.

Event Hubs'da verilerinizin Serileştirme türünü ve işin Event Hubs'a bağlanmak için kullandığı Kimlik doğrulama yöntemini belirtin. Bu öğretici için varsayılan ayarları koruyun. Ardından Bağlan'ı seçin.

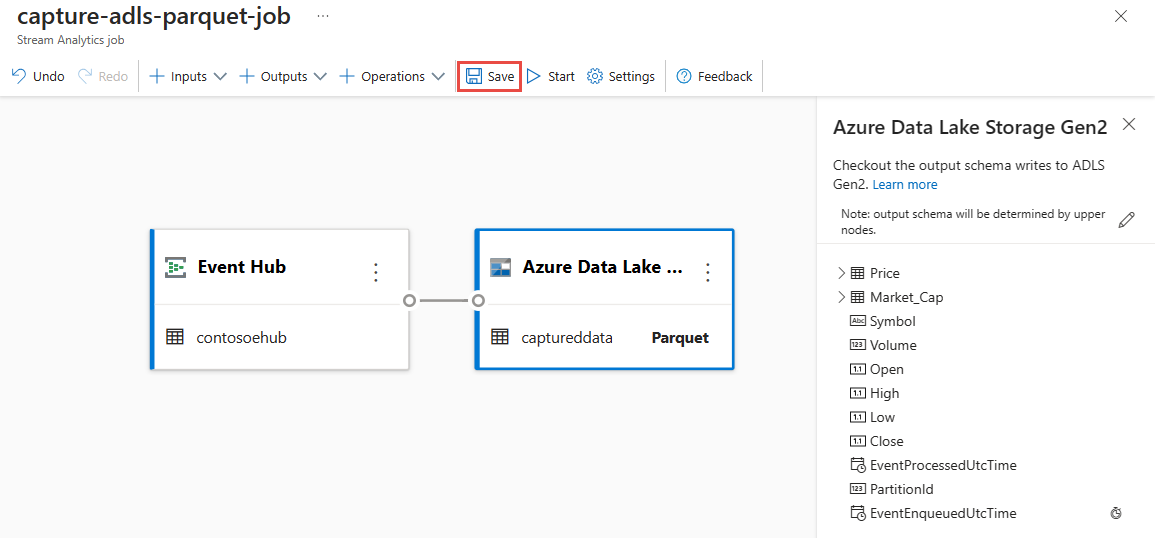

Bağlantı başarıyla kurulduğunda şunları görürsünüz:

Giriş verilerinde bulunan alanlar. Alan ekle'yi seçebilir veya isteğe bağlı olarak alanın adını kaldırmak, yeniden adlandırmak veya değiştirmek için alanın yanındaki üç nokta simgesini seçebilirsiniz.

Diyagram görünümünün altındaki Veri önizleme tablosundaki gelen verilerin canlı örneği. Düzenli aralıklarla yenilenir. Örnek girişin statik görünümünü görüntülemek için Akış önizlemesini duraklat'ı seçebilirsiniz.

Yapılandırmayı düzenlemek için Azure Data Lake Storage 2. Nesil kutucuğunu seçin.

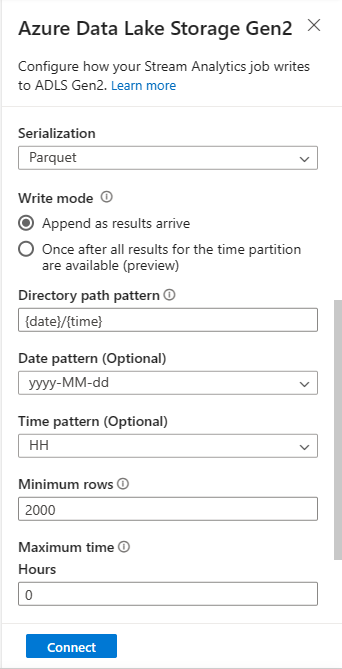

Azure Data Lake Storage 2. Nesil yapılandırma sayfasında şu adımları izleyin:

Açılan menüden aboneliği, depolama hesabı adını ve kapsayıcıyı seçin.

Abonelik seçildikten sonra kimlik doğrulama yöntemi ve depolama hesabı anahtarı otomatik olarak doldurulmalıdır.

Serileştirme biçimi için Parquet'i seçin.

Akış blobları için dizin yolu deseninin dinamik bir değer olması beklenir. Tarihin blob için dosya yolunun bir parçası olması gerekir; olarak başvurulur

{date}. Özel yol desenleri hakkında bilgi edinmek için bkz. Azure Stream Analytics özel blob çıkış bölümleme.Bağlan'ı seçin.

Bağlantı kurulduğunda, çıkış verilerinde bulunan alanları görürsünüz.

Yapılandırmanızı kaydetmek için komut çubuğunda Kaydet'i seçin.

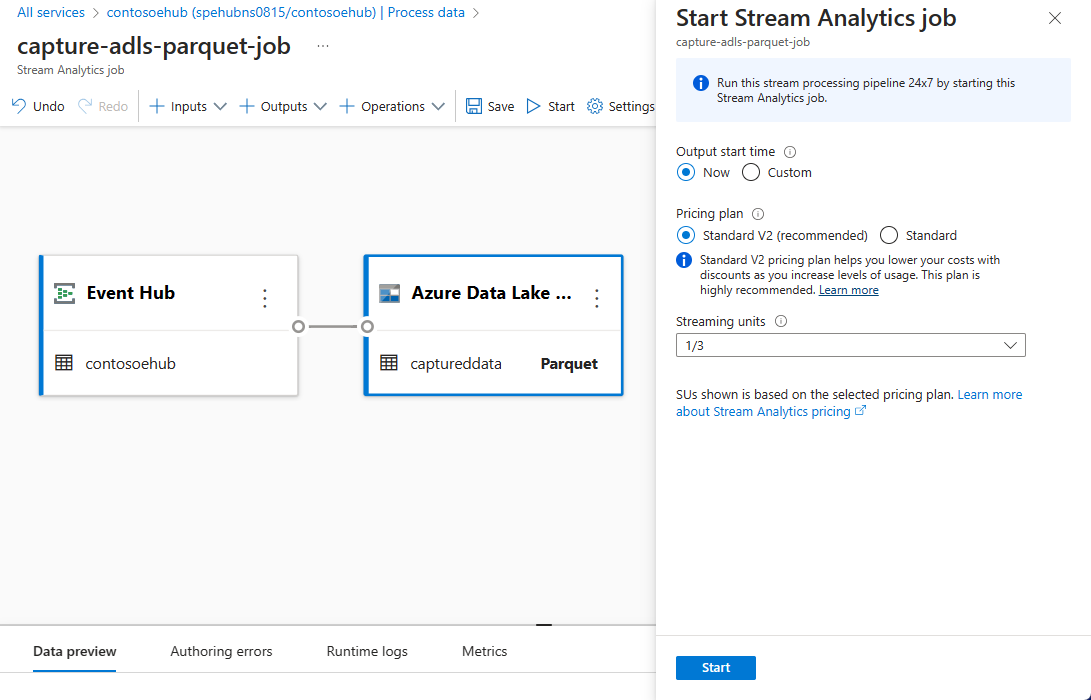

Veri yakalamak için akış akışını başlatmak için komut çubuğunda Başlat'ı seçin. Ardından Stream Analytics'i başlat iş penceresinde:

Çıkış başlangıç saatini seçin.

Fiyatlandırma planını seçin.

İşin birlikte çalıştığı Akış Birimi (SU) sayısını seçin. SU, Stream Analytics işini yürütmek için ayrılan bilgi işlem kaynaklarını temsil eder. Daha fazla bilgi için bkz . Azure Stream Analytics'te Akış Birimleri.

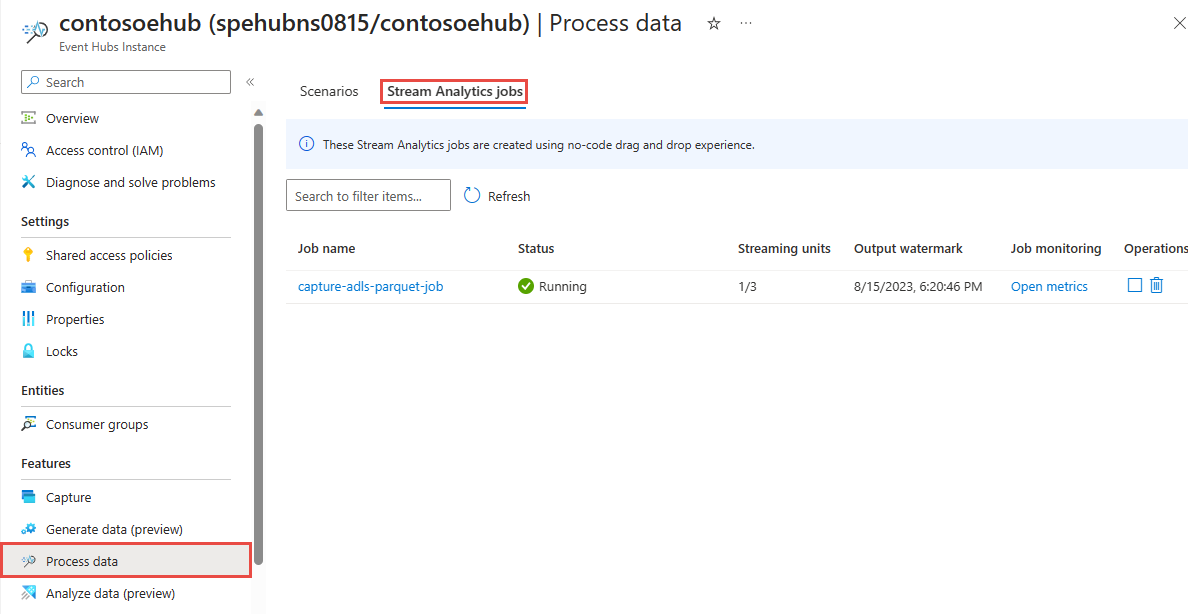

Olay hub'ınızın Verileri işleme sayfasının Stream Analytics iş sekmesinde Stream Analytics işini görmeniz gerekir.

Çıkışı doğrulama

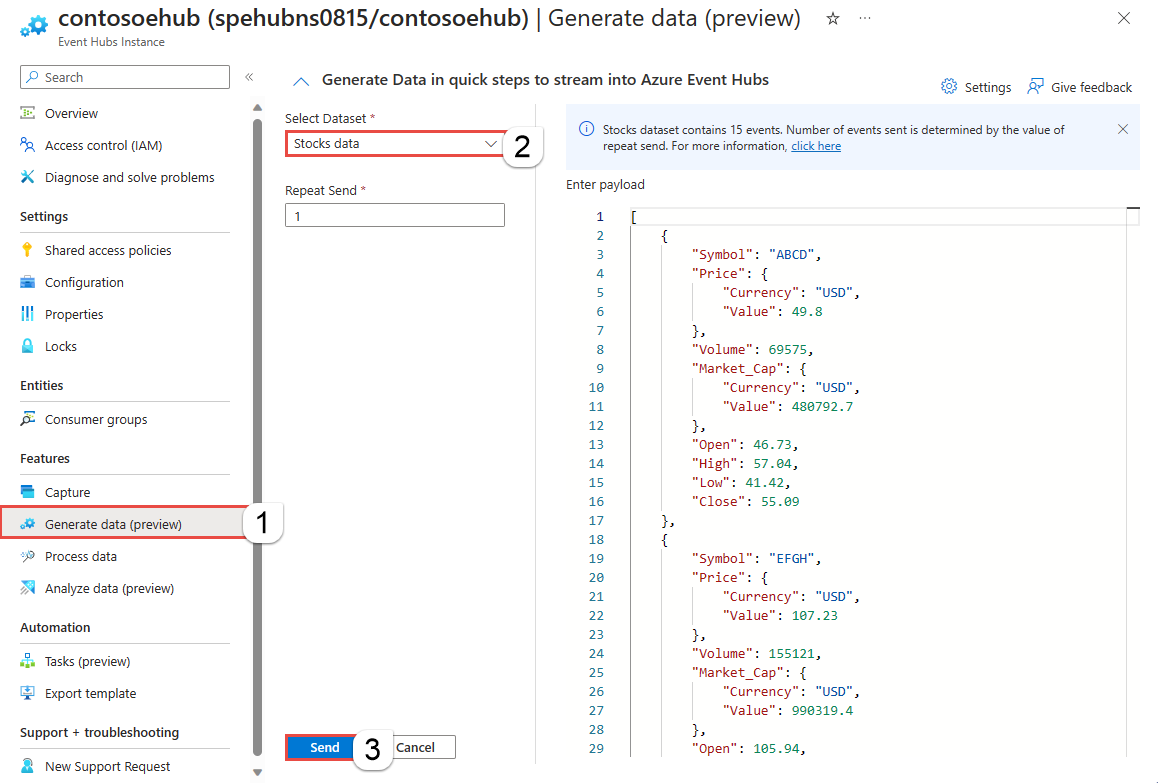

Olay hub'ınızın Event Hubs örneği sayfasında şu adımları izleyin:

- Soldaki menüden Veri Gezgini'ı seçin.

- Orta bölmede Olayları gönder'i seçin.

- Olayları gönder bölmesindeki Veri kümesini seçin alanında Hisse senetleri verileri'ni seçin.

- Gönder'i seçin.

Parquet dosyalarının Azure Data Lake Storage kapsayıcısında oluşturulduğunu doğrulayın.

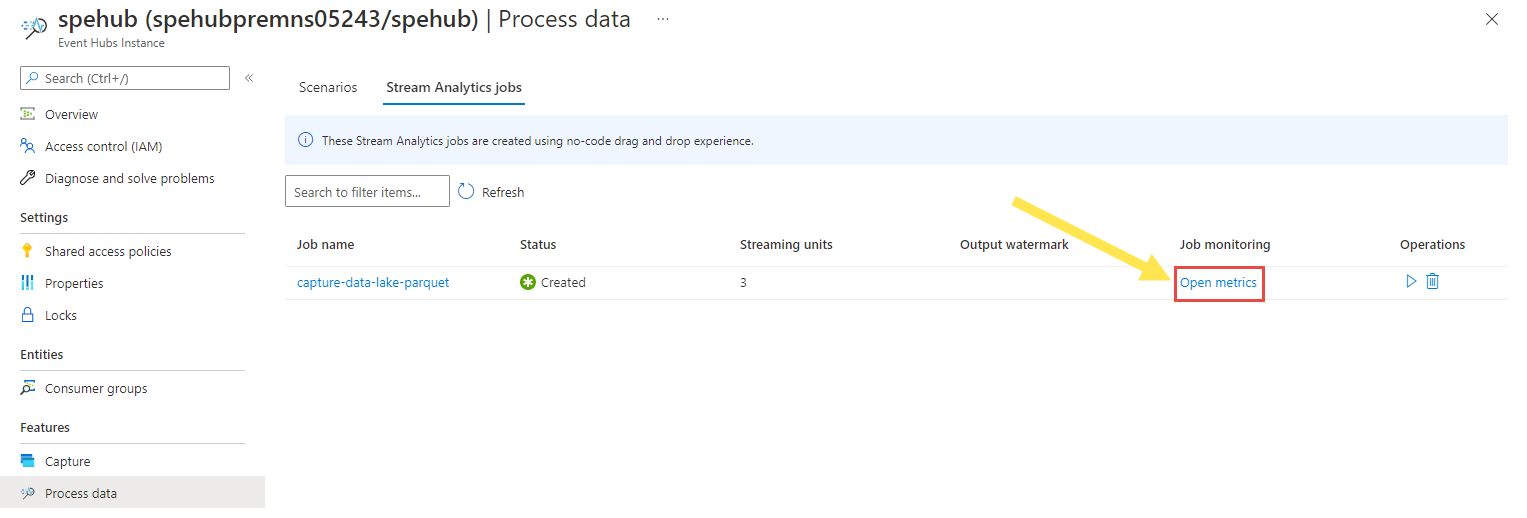

Event Hubs örneği sayfasına dönüp soldaki menüden verileri işle'yi seçin. Stream Analytics işleri sekmesine geçin. İzlemek için Ölçümleri aç'ı seçin. Araç çubuğundaki Ölçüm ekle'yi kullanarak grafiğe Giriş ölçümleri ekleyin. Grafikte ölçümleri görmüyorsanız birkaç dakika bekleyin ve sayfayı yenileyin.

Giriş ve çıkış olaylarını gösteren ölçümlerin örnek ekran görüntüsü aşağıda verilmiştir.

Event Hubs Coğrafi çoğaltma özelliğini kullanırken dikkat edilmesi gerekenler

Azure Event Hubs kısa süre önce genel önizlemede Coğrafi Çoğaltma özelliğini başlattı. Bu özellik, Azure Event Hubs'ın Coğrafi Olağanüstü Durum Kurtarma özelliğinden farklıdır.

Yük devretme türü Zorlamalı olduğunda ve çoğaltma tutarlılığı Zaman Uyumsuz olduğunda, Stream Analytics işi bir Azure Event Hubs çıkışının tam olarak bir kez çıkışını garanti etmez.

Azure Stream Analytics, bir olay hub'ı çıktısı olan bir üretici olarak yük devretme süresi ve birincil ile ikincil arasında çoğaltma gecikmesinin yapılandırılan maksimum gecikmeye ulaşması durumunda Event Hubs tarafından azaltma sırasında iş üzerinde filigran gecikmesi gözlemlenebilir.

Azure Stream Analytics, Event Hubs giriş olarak tüketici olarak yük devretme süresi boyunca iş üzerinde filigran gecikmesi gözlemler ve yük devretme tamamlandıktan sonra verileri atlayabilir veya yinelenen verileri bulabilir.

Bu uyarılar nedeniyle, Event Hubs yük devretme tamamlandıktan hemen sonra Stream Analytics işini uygun başlangıç zamanıyla yeniden başlatmanızı öneririz. Ayrıca Event Hubs Coğrafi çoğaltma özelliği genel önizleme aşamasında olduğundan, bu noktada üretim Stream Analytics işleri için bu desenin kullanılmasını önermiyoruz. Event Hubs Coğrafi çoğaltma özelliği genel kullanıma sunulmadan önce geçerli Stream Analytics davranışı geliştirilecektir ve Stream Analytics üretim işlerinde kullanılabilir.

İlgili içerik

Artık Event Hubs verilerini Parquet biçiminde Azure Data Lake Storage 2. Nesil yakalayan bir iş oluşturmak için Kod düzenleyicisi olmayan Stream Analytics'i nasıl kullanacağınızı biliyorsunuz. Ardından Azure Stream Analytics ve oluşturduğunuz işi izleme hakkında daha fazla bilgi edinebilirsiniz.