Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

Doku Veri Mühendisliği Visual Studio (VS) Code uzantısı, Doku'da oluşturma, okuma, güncelleştirme ve silme (CRUD) Spark iş tanımı işlemlerini tam olarak destekler. Bir Spark iş tanımı oluşturduktan sonra daha fazla başvuruda bulunılan kitaplık yükleyebilir, Spark iş tanımını çalıştırmak için bir istek gönderebilir ve çalıştırma geçmişini de kontrol edebilirsiniz.

Spark iş tanımı oluşturma

Yeni bir Spark iş tanımı oluşturmak için:

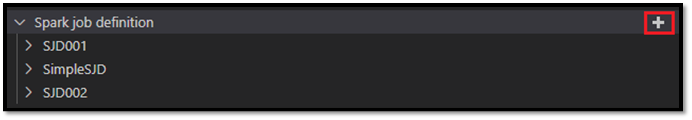

VS Code Gezgini'nde Spark İş Tanımı Oluştur seçeneğini belirleyin.

İlk gerekli alanları girin: name, referenced lakehouse ve default lakehouse.

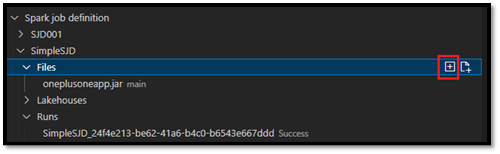

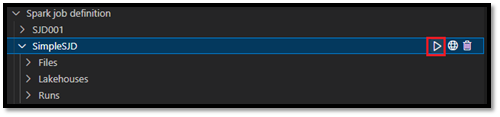

İstek işlemleri ve yeni oluşturduğunuz Spark iş tanımınızın adı VS Code Explorer'daki Spark İş Tanımı kök düğümü altında görünür. Spark iş tanımı adı düğümü altında üç alt düğüm görürsünüz:

- Dosyalar: Ana tanım dosyasının ve başvuruda bulunılan diğer kitaplıkların listesi. Bu listeden yeni dosyaları karşıya yükleyebilirsiniz.

-

Lakehouse: Bu Spark iş tanımı tarafından başvuruda yer alan tüm lakehouse'ların listesi. Varsayılan lakehouse listede işaretlenir ve buna göreli yolu

Files/…, Tables/…üzerinden erişebilirsiniz. - Çalıştırma: Bu Spark iş tanımının çalıştırma geçmişinin ve her çalıştırmanın iş durumunun listesi.

Başvuruda bulunılan kitaplığa ana tanım dosyası yükleme

Ana tanım dosyasını karşıya yüklemek veya üzerine yazmak için Ana Dosya Ekle seçeneğini belirleyin.

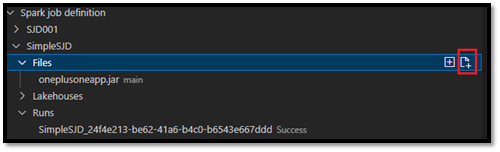

Ana tanım dosyasının başvurduğunu kitaplık dosyasını karşıya yüklemek için Lib Dosyası Ekle seçeneğini belirleyin.

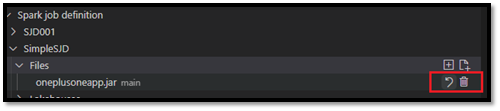

Dosyayı karşıya yükledikten sonra, Dosyayı Güncelleştir seçeneğine tıklayıp yeni bir dosya yükleyerek dosyayı geçersiz kılabilir veya Sil seçeneğiyle dosyayı silebilirsiniz.

Çalıştırma isteği gönderme

VS Code'dan Spark iş tanımını çalıştırma isteği göndermek için:

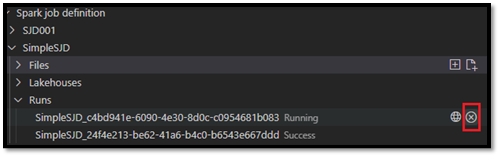

Çalıştırmak istediğiniz Spark iş tanımının adının sağındaki seçeneklerden Spark İşi Çalıştır seçeneğini belirleyin.

İsteği gönderdikten sonra, Gezgin listesindeki Çalıştırmalar düğümünde yeni bir Apache Spark uygulaması görüntülenir. Spark İşini İptal Et seçeneğini belirleyerek çalışan işi iptal edebilirsiniz.

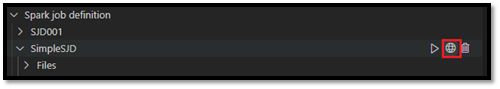

Doku portalında Spark iş tanımı açma

Tarayıcıda Aç seçeneğini belirleyerek Doku portalında Spark iş tanımı yazma sayfasını açabilirsiniz.

Ayrıca tamamlanan çalıştırmanın yanındaki Tarayıcıda Aç'ı seçerek bu çalıştırmanın ayrıntı izleyici sayfasını görebilirsiniz.

Spark iş tanımı kaynak kodunda hata ayıklama (Python)

Spark iş tanımı PySpark (Python) ile oluşturulduysa, ana tanım dosyasının ve başvuruda bulunılan dosyanın .py betiğini indirebilir ve VS Code'da kaynak betiğin hatalarını ayıklayabilirsiniz.

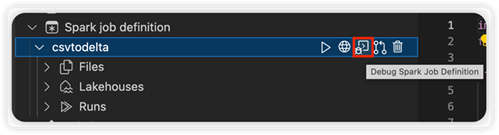

Kaynak kodu indirmek için Spark iş tanımının sağındaki Spark İş Tanımında Hata Ayıkla seçeneğini belirleyin.

İndirme tamamlandıktan sonra kaynak kodun klasörü otomatik olarak açılır.

İstendiğinde Yazarlara güven seçeneğini belirleyin. (Bu seçenek yalnızca klasörü ilk kez açtığınızda görünür. Bu seçeneği belirlemezseniz, kaynak betiğin hatalarını ayıklayamaz veya çalıştıramazsınız. Daha fazla bilgi için bkz. Visual Studio Code Çalışma Alanı Güveni güvenliği.)

Kaynak kodu daha önce indirdiyseniz, yeni indirme ile yerel sürümün üzerine yazmak istediğinizi onaylamanız istenir.

Not

Kaynak betiğin kök klasöründe sistem conf adlı bir alt klasör oluşturur. Bu klasörde, lighter-config.json adlı bir dosya, uzaktan çalıştırma için gereken bazı sistem meta verilerini içerir. Hiçbir değişiklik YAPMAYIN.

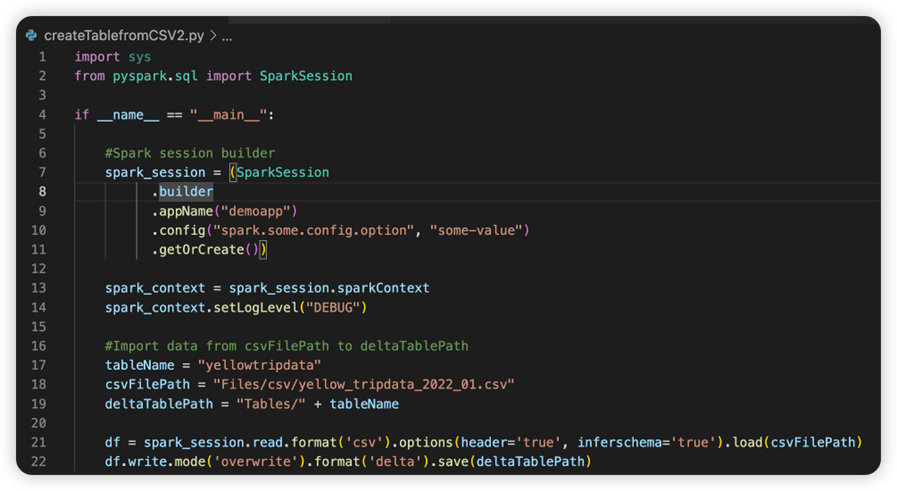

sparkconf.py adlı dosya, SparkConf nesnesini ayarlamak için eklemeniz gereken bir kod parçacığı içerir. Uzaktan hata ayıklamayı etkinleştirmek için SparkConf nesnesinin düzgün ayarlandığından emin olun. Aşağıdaki görüntüde kaynak kodun özgün sürümü gösterilmektedir.

Sonraki görüntü, kod parçacığını kopyalayıp yapıştırdıktan sonra güncelleştirilmiş kaynak kodudur.

Kaynak kodu gerekli konfederasyonla güncelleştirdikten sonra doğru Python Yorumlayıcısını seçmeniz gerekir. Synapse-spark-kernel conda ortamından yükleneni seçtiğinizden emin olun.

Spark iş tanımı özelliklerini düzenleme

Komut satırı bağımsız değişkenleri gibi Spark iş tanımlarının ayrıntı özelliklerini düzenleyebilirsiniz.

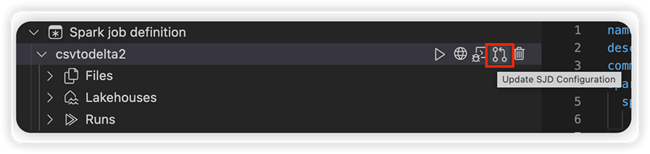

settings.yml dosyasını açmak için SJD Yapılandırmasını Güncelleştir seçeneğini belirleyin. Mevcut özellikler bu dosyanın içeriğini doldurur.

.yml dosyasını güncelleştirin ve kaydedin.

Değişikliği uzak çalışma alanına geri eşitlemek için sağ üst köşedeki SJD Özelliğini Yayımla seçeneğini belirleyin.