Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

Uyarı

Fabric Runtime 2.0 şu anda deneysel bir önizleme aşamasındadır. Daha fazla bilgi için sınırlamalara ve notlara bakın.

Fabric Runtime, Microsoft Fabric ekosisteminde sorunsuz tümleştirme sağlayarak Apache Spark tarafından desteklenen veri mühendisliği ve veri bilimi projeleri için sağlam bir ortam sunar.

Bu makalede, Microsoft Fabric'teki büyük veri hesaplamaları için tasarlanmış en son çalışma zamanı olan Fabric Runtime 2.0 Experimental (Önizleme) tanıtıldı. Bu sürümü ölçeklenebilir analiz ve gelişmiş iş yükleri için önemli bir adım haline getiren temel özellikleri ve bileşenleri vurgular.

Fabric Runtime 2.0, veri işleme özelliklerinizi geliştirmek için tasarlanmış aşağıdaki bileşenleri ve yükseltmeleri içerir:

- Apache Spark 4.0

- İşletim Sistemi: Azure Linux 3.0 (Mariner 3.0)

- Java: 21

- Scala: 2.13

- Python: 3.12

- Delta Gölü: 4.0

Çalışma Zamanı 2.0'i etkinleştirme

Çalışma zamanı 2.0'i çalışma alanı düzeyinde veya ortam öğesi düzeyinde etkinleştirebilirsiniz. Çalışma alanınızdaki tüm Spark iş yükleri için varsayılan olarak Çalışma Zamanı 2.0'ı uygulamak için çalışma alanı ayarını kullanın. Alternatif olarak, belirli not defterleri veya Spark iş tanımlarıyla kullanmak üzere Çalışma Zamanı 2.0 ile çalışma alanı varsayılanını geçersiz kılacak bir Ortam öğesi oluşturun.

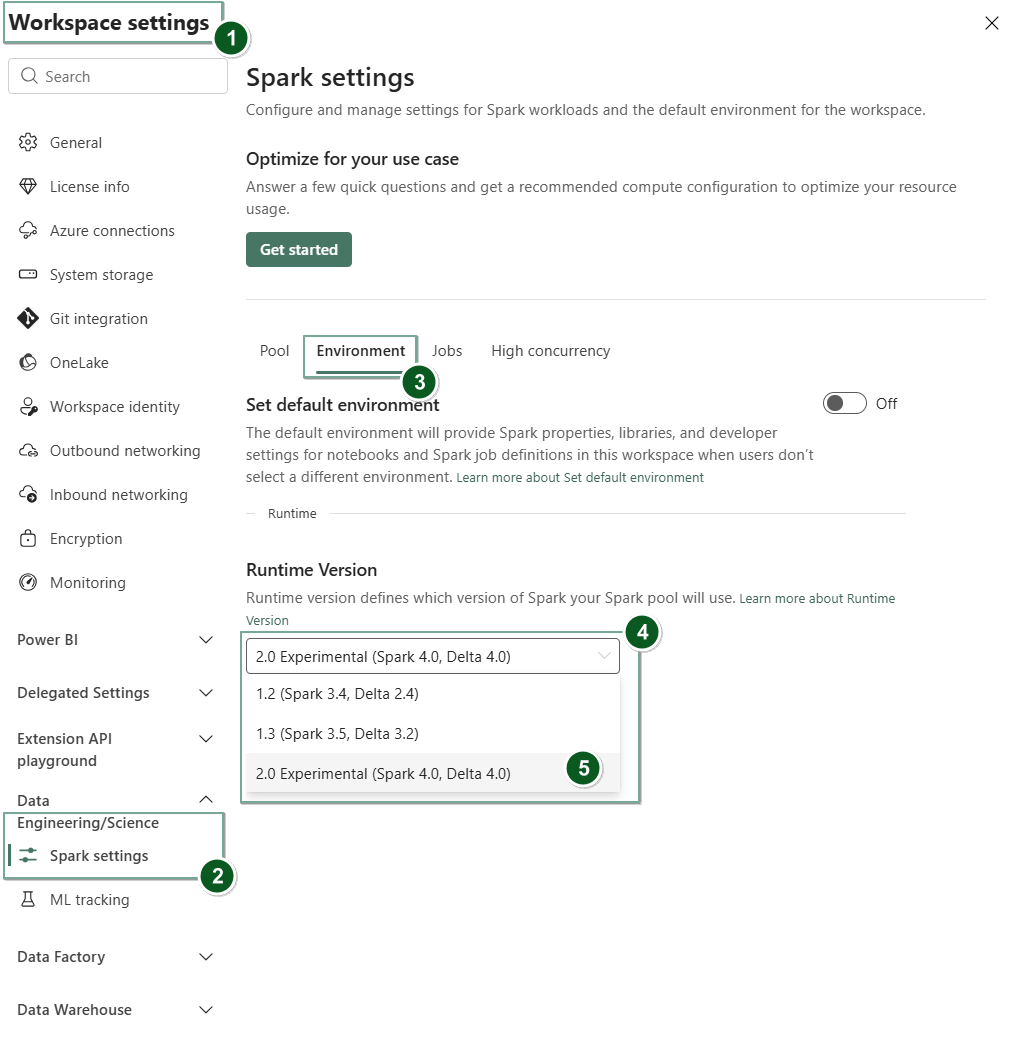

Çalışma Alanı ayarlarında Çalışma Zamanı 2.0'ı etkinleştirme

Çalışma Zamanı 2.0'ı tüm çalışma alanınız için varsayılan olarak ayarlamak için:

Doku çalışma alanınızın içindeki Çalışma Alanı ayarları sekmesine gidin.

Veri Mühendisliği/Bilim sekmesine gidin ve Spark ayarları'nı seçin.

Ortam sekmesini seçin.

Çalışma zamanı sürümü açılan listesinden 2.0 Deneysel (Spark 4.0, Delta 4.0) öğesini seçin ve değişikliklerinizi kaydedin. Bu eylem Çalışma Zamanı 2.0'i çalışma alanınız için varsayılan çalışma zamanı olarak ayarlar.

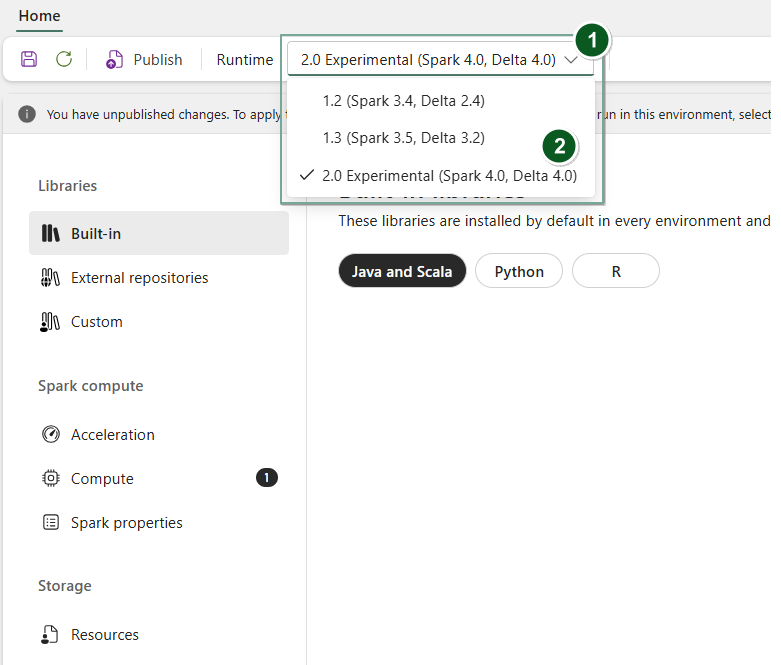

Ortam öğesinde Çalışma Zamanı 2.0'i etkinleştirme

Çalışma Zamanı 2.0'ı belirli not defterleriyle veya Spark iş tanımlarıyla kullanmak için:

Yeni bir Ortam öğesi oluşturun veya mevcut bir öğeyi açın.

Çalışma Zamanı açılır listesinden 2.0 Deneysel (Spark 4.0, Delta 4.0) öğesini seçin ve

Savedeğişikliklerinizi kaydedin.Önemli

Başlangıç havuzları erken deneysel sürümün bir parçası olmadığından Spark 2.0 oturumlarının başlatılması yaklaşık 2-5 dakika sürebilir.

Ardından, bu Ortam öğesini

NotebookveyaSpark Job Definitionile kullanabilirsiniz.

Artık Fabric Runtime 2.0'da (Spark 4.0 ve Delta Lake 4.0) sunulan en yeni iyileştirmeler ve işlevlerle denemeler yapmaya başlayabilirsiniz.

Deneysel Genel Önizleme

Fabric çalışma zamanı 2.0 deneysel önizleme evresi, hem Spark 4.0 hem de Delta Lake 4.0'dan yeni özellikler ve API'lere erken erişim sağlar. Önizleme, yeni Java, Scala ve Python sürümleri gibi gelecekteki değişiklikler için sorunsuz bir hazır olma ve geçiş sağlama amacıyla en son Spark tabanlı geliştirmeleri hemen kullanmanıza olanak tanır.

İpucu

Güncel bilgiler, değişikliklerin ayrıntılı listesi ve Doku çalışma zamanları için belirli sürüm notları için Spark Çalışma Zamanları Yayınları ve Güncelleştirmeleri'ne göz atın ve abone olun.

Sınırlamalar ve Notlar

Fabric Runtime 2.0 şu anda kullanıcıların geliştirme veya test ortamlarında Spark ve Delta Lake'ten en son özellikleri ve API'leri keşfetmesi ve denemesi için tasarlanmış deneysel bir genel önizleme aşamasındadır. Bu sürüm temel işlevlere erişim sunsa da bazı sınırlamalar vardır:

Spark 4.0 oturumlarını kullanabilir, not defterlerine kod yazabilir, Spark iş tanımlarını zamanlayabilir ve PySpark, Scala ve Spark SQL ile kullanabilirsiniz. Ancak bu erken sürümde R dili desteklenmez.

Pip ve conda ile doğrudan kodunuzda kitaplıkları yükleyebilirsiniz. Spark ayarlarını, not defterlerindeki ve Spark İş Tanımlarındaki (SJD) %%configure seçenekleri aracılığıyla ayarlayabilirsiniz.

Delta Lake 4.0 ile Lakehouse'da okuyup yazabilirsiniz, ancak V sırası, yerel Parquet yazma, otomatik düzenleme, yazma optimizasyonu, düşük karıştırmalı birleştirme, birleşim, şema evrimi ve zaman yolculuğu gibi bazı gelişmiş özellikler bu erken sürüme dahil değildir.

Spark Danışmanı şu anda kullanılamıyor. Ancak Spark kullanıcı arabirimi ve günlükler gibi izleme araçları bu erken sürümde desteklenir.

Copilot dahil Veri Bilimi tümleştirmeleri ve Kusto, SQL Analytics, Cosmos DB ve MySQL Java Bağlayıcısı gibi bağlayıcılar gibi özellikler şu anda bu erken sürümde desteklenmemektedir. Veri Bilimi kitaplıkları PySpark ortamlarında desteklenmez. PySpark yalnızca ek kitaplıklar olmadan yalnızca PySpark'ı içeren temel bir Conda kurulumuyla çalışır.

Bu erken sürümde ortam öğesi ve Visual Studio Code ile tümleştirmeler desteklenmez.

WASB veya ABFS protokollerine sahip Genel Amaçlı v2 (GPv2) Azure Depolama hesaplarına veri okumayı ve yazmayı desteklemez.

Uyarı

Doku Çalışma Zamanı ile ilgili geri bildiriminizi Fikirler platformunda paylaşın. Bahsettiğiniz sürüm ve sürüm aşamasından bahsetmeyi unutmayın. Topluluk geri bildirimlerine değer verir ve oylara göre iyileştirmelere öncelik vererek kullanıcı gereksinimlerini karşıladığımızdan emin oluruz.

Önemli noktalar

Apache Spark 4.0

Apache Spark 4.0, 4.x serisinin ilk sürümü olarak önemli bir kilometre taşını işaret ediyor ve canlı açık kaynak topluluğunun kolektif çalışmasını somutlaştırıyor.

Bu sürümde Spark SQL, DEĞIŞKEN veri türü desteği, SQL kullanıcı tanımlı işlevler, oturum değişkenleri, kanal söz dizimi ve dize harmanlaması gibi SQL iş yükleri için ifade ve çok yönlülüğü artırmak üzere tasarlanmış güçlü yeni özelliklerle önemli ölçüde zenginleştirilmiştir. PySpark'in hem işlevsel genişliğini hem de genel geliştirici deneyimini iyileştirmeye yönelik sürekli bağlılığı, yerleşik bir çizim API'si, yeni bir Python Veri Kaynağı API'si, Python UDTF'ler için destek ve PySpark UDF'leri için birleşik profil oluşturmanın yanı sıra birçok başka geliştirme getiriyor. Yapılandırılmış Akış, özellikle daha esnek durum yönetimi için Rastgele Durum API'sinin v2 ve daha kolay hata ayıklama için Durum Veri Kaynağı'nın kullanıma sunulması gibi daha fazla denetim ve hata ayıklama kolaylığı sağlayan temel eklemelerle gelişir.

Tam listeyi ve ayrıntılı değişiklikleri burada kontrol edebilirsiniz: https://spark.apache.org/releases/spark-release-4-0-0.html.

Uyarı

Spark 4.0'da SparkR kullanım dışıdır ve gelecekteki bir sürümde kaldırılabilir.

Delta Lake 4.0

Delta Lake 4.0, Delta Lake'i biçimler arasında birlikte çalışabilir, daha kolay çalışılabilir ve daha yüksek performanslı hale getirmek için kolektif bir taahhüdü işaret ediyor. Delta 4.0, açık data lakehouse'ların geleceği için güçlü yeni özellikler, performans iyileştirmeleri ve temel iyileştirmelerle dolu bir kilometre taşı sürümüdür.

Delta Lake 3.3 ve 4.0 ile sunulan tam listeyi ve ayrıntılı değişiklikleri buradan de kontrol edebilirsiniz: https://github.com/delta-io/delta/releases/tag/v3.3.0. https://github.com/delta-io/delta/releases/tag/v4.0.0.

Önemli

Delta Lake 4.0'a özgü özellikler deneyseldir ve yalnızca Not Defterleri ve Spark İş Tanımları gibi Spark deneyimlerinde çalışır. Birden çok Microsoft Fabric iş yükünde aynı Delta Lake tablolarını kullanmanız gerekiyorsa bu özellikleri etkinleştirmeyin. Tüm Microsoft Fabric deneyimlerinde hangi protokol sürümlerinin ve özelliklerinin uyumlu olduğu hakkında daha fazla bilgi edinmek için Delta Lake tablo biçimi birlikte çalışabilirliği makalesini okuyun.

İlgili içerik

- Fabric'teki Apache Spark Çalışma Ortamları - Genel Bakış, Sürüm Oluşturma ve Birden Çok Çalışma Ortamı Desteği

- Spark Core geçiş kılavuzu

- SQL, Veri Kümeleri ve DataFrame geçiş kılavuzları

- Yapılandırılmış Akış geçiş kılavuzu

- MLlib (Machine Learning) geçiş kılavuzu

- PySpark (Spark üzerinde Python) geçiş kılavuzu

- SparkR (R on Spark) geçiş kılavuzu