Not

Bu sayfaya erişim yetkilendirme gerektiriyor. Oturum açmayı veya dizinleri değiştirmeyi deneyebilirsiniz.

Bu sayfaya erişim yetkilendirme gerektiriyor. Dizinleri değiştirmeyi deneyebilirsiniz.

Şunlar için geçerlidir:✅ Microsoft Fabric'te Veri Madenciliği ve Veri Bilimi

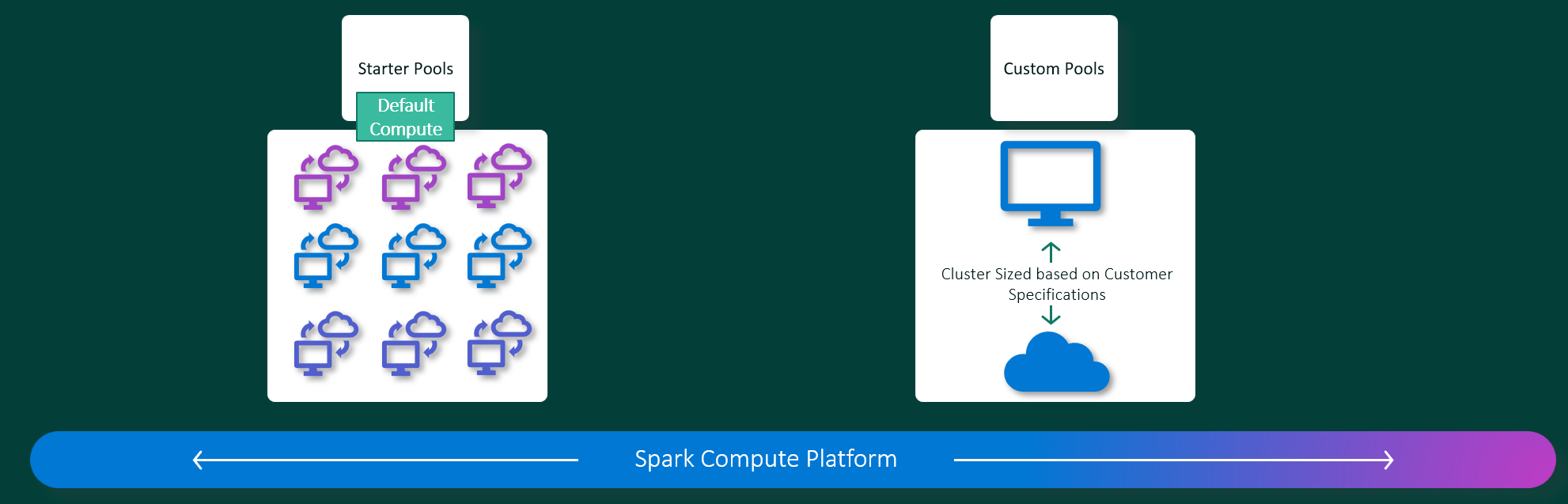

Microsoft Fabric Veri Madenciliği ve Veri Bilimi deneyimleri, tam olarak yönetilen bir Apache Spark işlem platformunda çalışır. Bu platform benzersiz hız ve verimlilik sunmak için tasarlanmıştır. Başlangıç havuzlarıyla, el ile kuruluma gerek olmadan genellikle 5-10 saniye içinde hızlı Apache Spark oturumu başlatmayı bekleyebilirsiniz. Ayrıca Apache Spark havuzlarını özel veri mühendisliği ve veri bilimi gereksinimlerinize göre özelleştirme esnekliğine de sahiptirsiniz. Platform, iyileştirilmiş ve uyarlanmış bir analiz deneyimi sağlar. Kısacası başlangıç havuzu önceden yapılandırılmış Spark'ı kullanmanın hızlı bir yoludur, Spark havuzu ise özelleştirme ve esneklik sunar.

Yeni başlayanlar için havuzlar

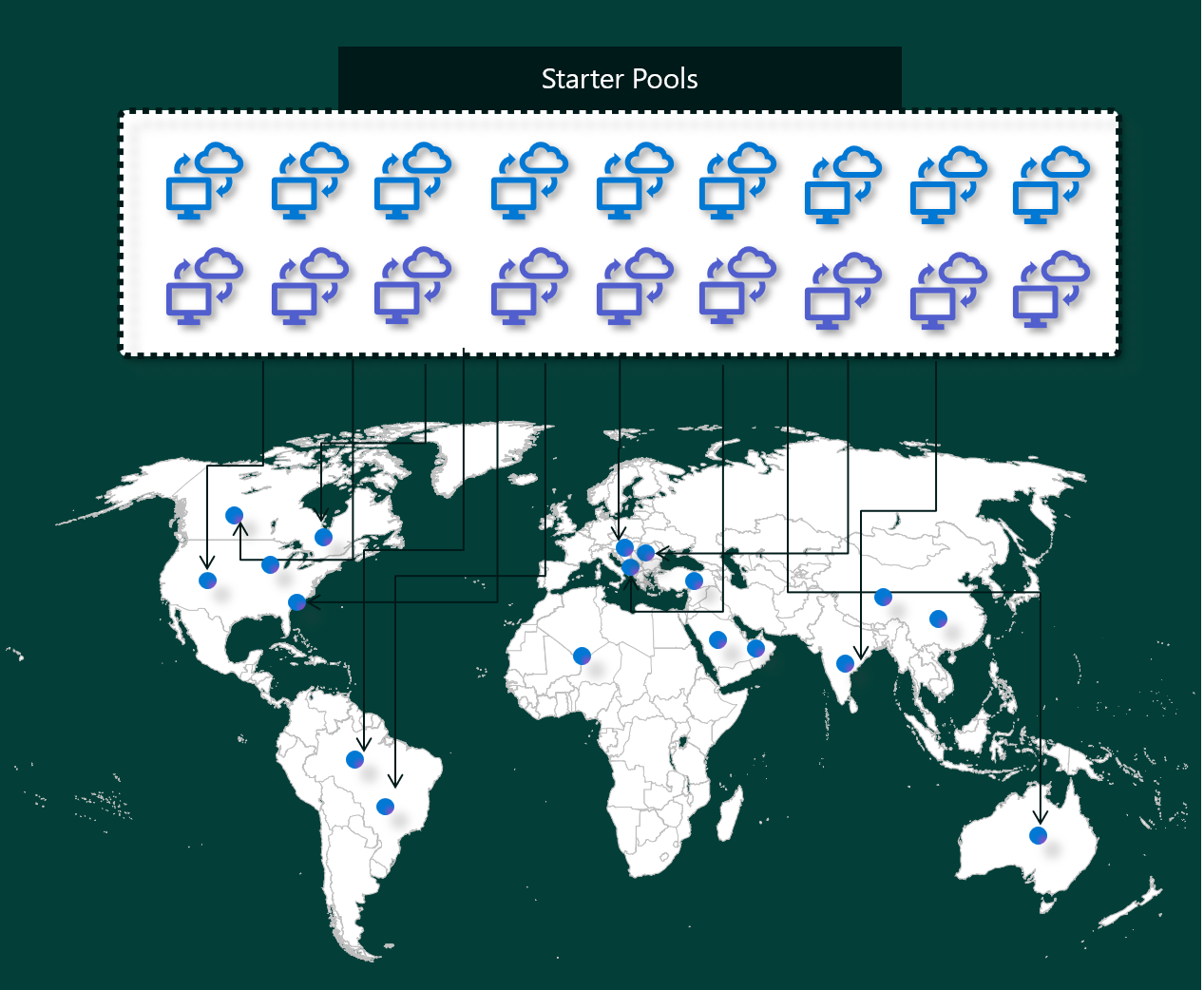

Başlangıç havuzları, Saniyeler içinde Microsoft Fabric platformunda Spark'ı kullanmanın hızlı ve kolay bir yoludur. Spark'ın düğümleri sizin için ayarlamasını beklemek yerine Spark oturumlarını hemen kullanabilirsiniz. Bu da verilerle daha fazlasını yapmanıza ve daha hızlı içgörüler elde etmenize yardımcı olur.

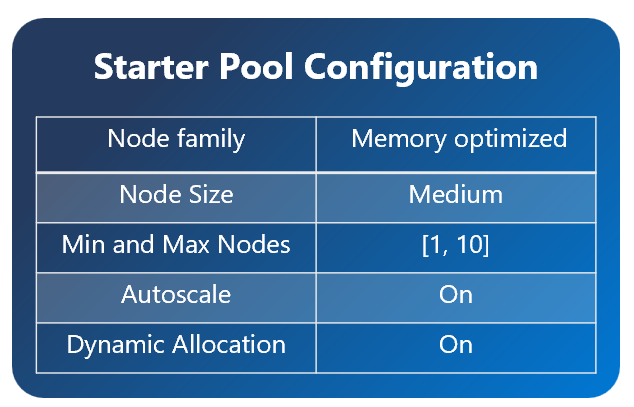

Başlangıç havuzlarında, istekleriniz için her zaman açık ve hazır oturumlara sahip Apache Spark kümeleri vardır. Spark iş gereksinimlerinize göre dinamik olarak ölçeklendirilen orta düzey düğümler kullanır.

ek kitaplık bağımlılıkları veya özel Spark özellikleri olmadan Başlangıç Havuzukullandığınızda, oturumunuz genellikle 5-10 saniye içinde başlar. Küme zaten çalıştığından ve sağlama süresi gerektirmediğinden bu hızlı başlangıç mümkündür.

Uyarı

Başlangıç havuzları yalnızca Orta Düğüm boyutları için desteklenir ve diğer düğüm boyutlarının seçilmesi veya işlem yapılandırmalarının özelleştirilmesi isteğe bağlı oturum başlatma deneyimine neden olur ve bu işlem 2-5 dakika sürebilir

Ancak oturumunuzun başlatılmasının daha uzun sürebileceği birkaç senaryo vardır:

Özel kitaplıklarınız veya Spark özellikleriniz

Ortamınızda kitaplıkları veya özel ayarları yapılandırdıysanız Spark, oturumu oluşturduktan sonra kişiselleştirir. Bu işlem, kitaplık bağımlılıklarınızın sayısına ve boyutuna bağlı olarak başlangıç sürenize yaklaşık 30 saniye ile 5 dakika ekleyebilir.Bölgenizdeki Başlangıç Havuzları tamamen kullanılmış

Nadir durumlarda, yüksek trafik nedeniyle bölgenin Başlangıç Havuzları geçici olarak tükenebilir. Bu durumda Doku, isteğinizi karşılamak için yeni bir küme oluşturur ve bu da yaklaşık2 ile 5 dakika sürer. Yeni küme kullanıma sunulduktan sonra oturumunuz başlar. Ayrıca yüklenecek özel kitaplıklarınız varsa, kişiselleştirme için gereken 30 saniye ile 5 dakika bekleme süresini eklemeniz gerekiyor.Gelişmiş ağ veya güvenlik özellikleri (Özel Bağlantılar veya Yönetilen Sanal Ağlar)

Çalışma alanınızda Kiracı Özel Bağlantıları veya Yönetilen VNetsgibi ağ özellikleri varsa, Başlangıç Havuzları desteklenmez. Bu durumda Doku isteğe bağlı olarak bir küme oluşturmalıdır ve bu küme oturum başlangıç saatinize 2 ile 5 dakika ekler. Kitaplık bağımlılıklarınız da varsa, bu kişiselleştirme adımı 30 saniye ile 5 dakika arasında birdaha ekleyebilir.

Olası başlangıç zamanlarını göstermek için birkaç örnek senaryo aşağıda verilmiştir:

| Senaryo | Tipik Başlangıç Zamanı |

|---|---|

| Varsayılan ayarlar, kitaplık yok | 5 – 10 saniye |

| Varsayılan ayarlar + kitaplık bağımlılıkları | 5 – 10 saniye + 30 saniye – 5 dakika (kitaplığın kurulumu için) |

| Bölgede yüksek trafik var, kitaplık yok | 2 – 5 dakika |

| Yüksek trafik + kitaplık bağımlılıkları | 2 – 5 dakika + 30 saniye – 5 dakika (kütüphaneler için) |

| Ağ güvenliği (Özel Bağlantılar/Sanal Ağlar), kütüphane yok | 2 – 5 dakika |

| Ağ güvenliği + kitaplık bağımlılıkları | 2 – 5 dakika + 30 saniye – 5 dakika (kütüphaneler için) |

Faturalama ve kapasite tüketimi söz konusu olduğunda, not defterinizi veya Apache Spark iş tanımınızı yürütmeye başladığınızda kapasite tüketimi için ücretlendirilirsiniz. Kümeler havuzda boşta olduğu süre boyunca sizden ücret alınmaz.

Örneğin, bir başlangıç havuzuna not defteri işi gönderirseniz, yalnızca not defteri oturumunun etkin olduğu süre boyunca faturalandırılırsınız. Faturalanan süre boşta kalma süresini veya Spark bağlamı ile oturumu kişiselleştirmek için geçen süreyi içermez. Daha fazla bilgi edinmek için bkz. Doku'da başlangıç havuzlarını yapılandırma.

Spark havuzları

Spark havuzu, Spark'a veri çözümleme görevleriniz için ne tür kaynaklara ihtiyacınız olduğunu söylemenin bir yoludur. Spark havuzunuza bir ad verebilir ve düğümlerin (işi yapacak makineler) kaç ve ne kadar büyük olduğunu seçebilirsiniz. Spark'a, sahip olduğunuz çalışma miktarına bağlı olarak düğüm sayısını nasıl ayarlayabileceğini de söyleyebilirsiniz. Spark havuzu oluşturmak ücretsizdir; yalnızca havuzda bir Spark işi çalıştırdığınızda ödeme yapın ve ardından Spark düğümleri sizin için ayarlar.

Oturum süreniz dolduktan iki dakika sonra Spark havuzunuzu kullanmazsanız, Spark havuzunuzun tahsisi iptal edilecektir. Bu varsayılan oturum süre sonu süresi 20 dakika olarak ayarlanır ve isterseniz bunu değiştirebilirsiniz. Çalışma alanı yöneticisiyseniz, çalışma alanınız için özel Spark havuzları oluşturabilir ve bunları diğer kullanıcılar için varsayılan seçenek haline getirebilirsiniz. Bu şekilde, her not defteri veya Spark işi çalıştırdığınızda zamandan tasarruf edebilir ve yeni bir Spark havuzu ayarlamaktan kaçınabilirsiniz. Spark'ın düğümleri Azure'dan alması gerektiğinden özel Spark havuzlarının başlatılması yaklaşık üç dakika sürer.

En az düğüm sayısını bir olarak ayarlayarak tek düğümlü Spark havuzları bile oluşturabilirsiniz; böylece sürücü ve yürütücü, geri yüklenebilen HA ile birlikte gelen ve küçük iş yükleri için uygun olan tek bir düğümde çalışır.

Özel Spark havuzunuzda sahip olabileceğiniz düğümlerin boyutu ve sayısı Microsoft Fabric kapasitenize bağlıdır. Kapasite, Azure'da ne kadar bilgi işlem gücü kullanabileceğinizi gösteren bir ölçüdür. Bunu düşünmenin bir yolu, iki Apache Spark sanal çekirdeğinin (Spark için işlem gücü birimi) bir kapasite birimine eşit olmasıdır.

Uyarı

Apache Spark'ta kullanıcılar, SKU'larının bir parçası olarak ayırdıkları her kapasite birimi için iki Apache Spark sanal çekirdeği alır. Bir Kapasite Birimi = İki Spark Sanal Çekirdek, bu nedenle F64 => 128 Spark Sanal Çekirdek ve buna 3x Patlama Çarpanı uygulanarak toplam 384 Spark Sanal Çekirdek elde edilir.

Örneğin, Fabric kapasite SKU F64'ün 64 kapasite birimi vardır ve bu birim 384 Spark sanal çekirdeğine eşdeğerdir (64 * 2 * 3X Patlama Çarpanı). Toplam Spark sanal çekirdek sayısı 384'ü aşmadığı sürece bu Spark sanal çekirdeklerini kullanarak özel Spark havuzunuz için farklı boyutlarda düğümler oluşturabilirsiniz.

Spark havuzları başlangıç havuzları gibi faturalandırılır; bir not defterini veya Spark iş tanımını çalıştırmak için oluşturulmuş etkin bir Spark oturumunun olmadığı sürece, oluşturduğunuz özel Spark havuzları için ödeme yapmazsınız. Yalnızca işinizin çalıştığı süre boyunca faturalandırılırsınız. İş tamamlandıktan sonra küme oluşturma ve serbest bırakma gibi aşamalarda faturalandırılmazsınız.

Örneğin, bir not defteri işini özel bir Spark havuzuna gönderirseniz yalnızca oturumun etkin olduğu süre boyunca ücretlendirilirsiniz. Spark oturumu durdurulduktan veya süresi dolduktan sonra bu not defteri oturumu için faturalama durdurulur. Buluttan küme örneklerini almak için geçen süre veya Spark bağlamını başlatmak için geçen süre için sizden ücret alınmaz.

Önceki örne göre F64 için olası özel havuz yapılandırmaları. Daha küçük düğüm boyutları daha fazla düğüme yayılmış kapasiteye sahiptir, bu nedenle maksimum düğüm sayısı daha yüksektir. Büyük düğümler kaynak açısından zengindir, bu nedenle daha az düğüm gerekir:

| Kumaş kapasitesi SKU'su | Kapasite birimleri | Maks Spark Sanal Çekirdekleri Burst Factor ile | Düğüm boyutu | En fazla düğüm sayısı |

|---|---|---|---|---|

| F64 | 64 | 384 | Küçük | 96 |

| F64 | 64 | 384 | Orta | 48 |

| F64 | 64 | 384 | Büyük | yirmi dört |

| F64 | 64 | 384 | X-Large | 12 |

| F64 | 64 | 384 | XX-Büyük | 6 |

Uyarı

Özel havuzlar oluşturmak için çalışma alanı için yönetici izinlerine sahip olmanız gerekir. Ayrıca Microsoft Fabric kapasite yöneticisinin çalışma alanı yöneticilerinin özel Spark havuzlarını boyutlandırmasına izin vermek için izin vermesi gerekir. Daha fazla bilgi edinmek için bkz. Fabric'teki özel Spark havuzlarıyla çalışmaya başlama.

Düğümler

Apache Spark havuz örneği, bir baş düğüm ve işçi düğümlerinden oluşur; bir Spark örneği, en az bir düğümle başlatılabilir. Ana düğüm, Livy, Yarn Resource Manager, Zookeeper ve Apache Spark sürücüsü gibi ek yönetim hizmetlerini çalıştırır. Tüm düğümler Node Aracısı ve Yarn Node Manager gibi hizmetleri çalıştırır. Tüm çalışan düğümleri Apache Spark Yürütücüsü hizmetini çalıştırır.

Uyarı

Fabric'de düğümlerin yürütücülere oranı her zaman 1:1'dir. Bir havuz ayarladığınızda, bir düğüm sürücüye ayrılmıştır ve diğer düğümler yürütücüler için kullanılır. Tek özel durum, hem sürücü hem de yürütücü için kaynakların yarıya indirildiği tek düğümlü bir yapılandırmadır.

Düğüm boyutları

Spark havuzu, küçük bir işlem düğümünden (4 sanal çekirdek ve 32 GB bellekle) çift fazla büyük işlem düğümüne (düğüm başına 64 sanal çekirdek ve 512 GB bellek ile) değişen düğüm boyutlarıyla tanımlanabilir. Havuz oluşturulduktan sonra düğüm boyutları değiştirilebilir, ancak bu durumda etkin oturumun yeniden başlatılması gerekir.

| Boyut | Sanal Çekirdek | Bellek |

|---|---|---|

| Küçük | 4 | 32GB |

| Orta | 8 | 64GB |

| Büyük | 16 | 128 GB |

| X-Large | 32 | 256 GB |

| XX-Büyük | 64 | 512 GB |

Uyarı

Deneme sürümü dışında olan Doku SKU'ları için yalnızca X-Large ve XX-Large düğüm boyutlarına izin verilir.

Otomatik Ölçeklendirme

Apache Spark havuzları için otomatik ölçeklendirme, etkinlik miktarına göre işlem kaynaklarının ölçeğini otomatik olarak artırmaya ve azaltmaya olanak tanır. Otomatik ölçeklendirme özelliğini etkinleştirdiğinizde, ölçeklendirilecek en az ve en fazla düğüm sayısını ayarlarsınız. Otomatik ölçeklendirme özelliğini devre dışı bırakdığınızda, ayarlanan düğüm sayısı sabit kalır. Havuz oluşturulduktan sonra bu ayarı değiştirebilirsiniz, ancak örneği yeniden başlatmanız gerekebilir.

Uyarı

Varsayılan olarak spark.yarn.executor.decommission.enabled true olarak ayarlanır ve işlem verimliliğini iyileştirmek için az kullanılan düğümlerin otomatik olarak kapatılmasını sağlar. Daha az agresif azaltma tercih edilirse, bu yapılandırma false olarak ayarlanabilir

Dinamik ayırma

Dinamik ayırma, görevler geçerli yürütücülerin taşıyabileceği yükü aşarsa Apache Spark uygulamasının daha fazla yürütücü istemesine olanak tanır. Ayrıca işler tamamlandığında ve Spark uygulaması boşta durumuna geçiyorsa yürütücüleri serbest bırakır. Spark iş yürütme işleminin farklı aşamalarında büyük ölçüde farklı olduklarından, kurumsal kullanıcılar genellikle yürütücü yapılandırmalarını ayarlamayı zor bulur. Bu yapılandırmalar, zaman zaman değişen işlenen veri hacmine de bağlıdır. Yürütücülerin dinamik ayırmasını havuz yapılandırmasının bir parçası olarak etkinleştirebilirsiniz. Bu seçenek, Spark havuzundaki kullanılabilir düğümleri temel alarak yürütücülerin Spark uygulamasına otomatik olarak ayrılmasını sağlar.

Gönderilen her Spark uygulaması için dinamik ayırma seçeneğini etkinleştirdiğinizde, sistem en düşük düğümleri temel alarak iş gönderme adımı sırasında yürütücüleri ayırır. Başarılı otomatik ölçeklendirme senaryolarını desteklemek için en fazla düğüm sayısını belirtirsiniz.