本教程将指导你设置适用于 Visual Studio Code 的 Databricks 扩展,然后在 Azure Databricks 群集上以及在远程工作区中作为 Azure Databricks 作业运行 Python。 请参阅什么是 Visual Studio Code 的 Databricks 扩展?。

要求

本教程要求:

- 已安装适用于 Visual Studio Code 的 Databricks 扩展。 请参阅安装适用于 Visual Studio Code 的 Databricks 扩展。

- 有一个要使用的远程 Azure Databricks 群集。 记下群集的名称。 若要查看可用的群集,请在 Azure Databricks 工作区边栏中单击“计算”。 请参阅计算。

步骤 1:创建新的 Databricks 项目

在此步骤中,创建一个新的 Databricks 项目,并配置与远程 Azure Databricks 工作区的连接。

- 启动 Visual Studio Code,然后单击“文件”>“打开文件夹”,并在本地开发计算机上打开一些空文件夹。

- 在边栏上,单击“Databricks”徽标图标。 这将打开 Databricks 扩展。

- 在“配置”视图中,单击“创建配置”。

- 此时会打开用于配置 Databricks 工作区的“命令面板”。 对于“Databricks 主机”,输入或选择每工作区 URL,例如

https://adb-1234567890123456.7.azuredatabricks.net。 - 为项目选择一个身份验证配置文件。 请参阅为适用于 Visual Studio Code 的 Databricks 扩展设置身份验证。

步骤 2:将群集信息添加到 Databricks 扩展并启动群集

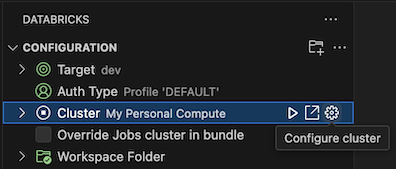

在已打开的“配置”视图中,单击“选择群集”或单击齿轮(“配置群集”)图标。

在“命令面板”中,选择之前创建的群集的名称。

如果尚未启动,请单击播放图标(“启动群集”)。

步骤 3:创建并运行 Python 代码

创建本地 Python 代码文件:在边栏上,单击文件夹(资源管理器)图标。

在主菜单上,单击“文件”>“新建文件”并选择一个 Python 文件。 将文件 命名为 demo.py ,并将其保存到项目的根目录中。

将以下代码添加到文件,然后将其保存。 此代码将创建并显示基本 PySpark 数据帧的内容:

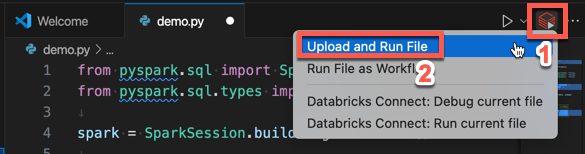

from pyspark.sql import SparkSession from pyspark.sql.types import * spark = SparkSession.builder.getOrCreate() schema = StructType([ StructField('CustomerID', IntegerType(), False), StructField('FirstName', StringType(), False), StructField('LastName', StringType(), False) ]) data = [ [ 1000, 'Mathijs', 'Oosterhout-Rijntjes' ], [ 1001, 'Joost', 'van Brunswijk' ], [ 1002, 'Stan', 'Bokenkamp' ] ] customers = spark.createDataFrame(data, schema) customers.show()# +----------+---------+-------------------+ # |CustomerID|FirstName| LastName| # +----------+---------+-------------------+ # | 1000| Mathijs|Oosterhout-Rijntjes| # | 1001| Joost| van Brunswijk| # | 1002| Stan| Bokenkamp| # +----------+---------+-------------------+单击编辑器选项卡列表旁边的“在 Databricks 上运行”图标,然后单击“上传并运行文件”。 输出将显示在“调试控制台”视图中。

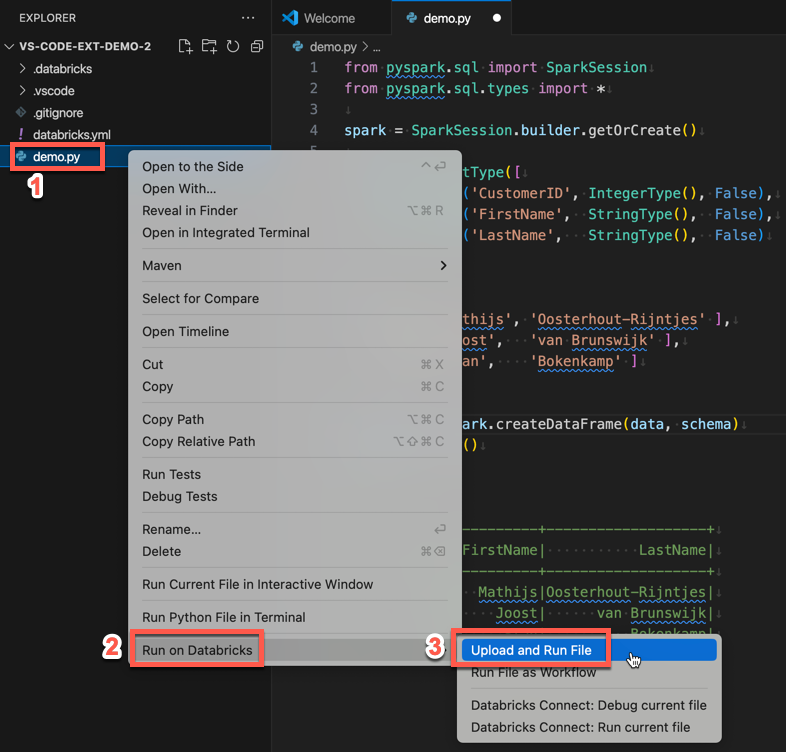

或者,在“资源管理器”视图中,右键单击

demo.py文件,然后单击“在 Databricks 上运行”>“上传和运行文件”。

步骤 4:将代码作为作业运行

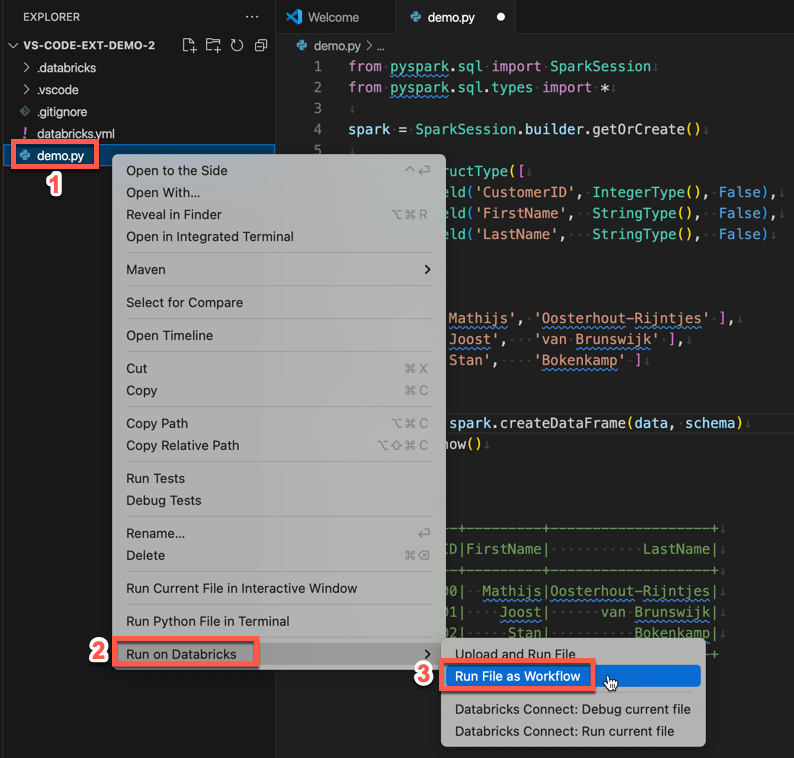

若要作为作业运行 demo.py,请单击编辑器选项卡列表旁边的“在 Databricks 上运行”图标,然后单击“将文件作为工作流运行”。 输出会显示在 demo.py 文件编辑器旁边单独的编辑器选项卡中。

![]()

或者,右键单击“demo.py”面板中的 文件,然后选择“在 Databricks 上运行”>“将文件作为工作流运行”。

后续步骤

现在,你已成功使用适用于 Visual Studio Code 的 Databricks 扩展上传本地 Python 文件并远程运行它,还可以:

- 使用扩展 UI 浏览 Databricks 资产捆绑包资源和变量。 请参阅 Databricks 资产捆绑包扩展功能。

- 使用 Databricks Connect 运行或调试 Python 代码。 请参阅使用 Databricks Connect 为 Visual Studio Code 的 Databricks 扩展调试代码。

- 将文件或笔记本作为 Azure Databricks 作业运行。 请参阅在 Azure Databricks 中使用适用于 Visual Studio Code 的 Databricks 扩展在群集上运行文件或将文件或笔记本作为作业运行。

- 使用

pytest运行测试。 请参阅 使用用于 Visual Studio Code 的 Databricks 扩展运行 Python 测试。