根据 Fabric 事件流中的内容路由数据流(预览版)

本文介绍如何根据 Microsoft Fabric 事件流中的内容路由事件。

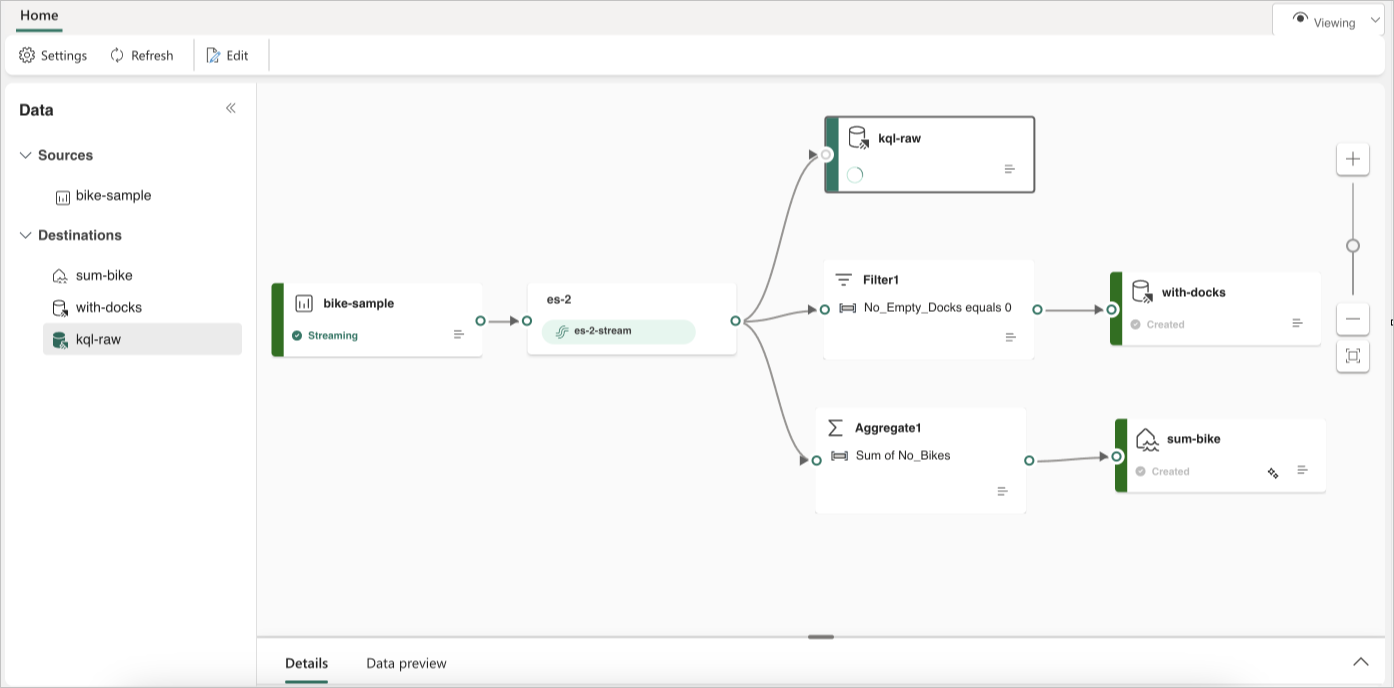

现在,你可以使用 Fabric 事件流主画布中的无代码编辑器来创建复杂的流处理逻辑,而无需编写任何代码。 使用此功能,你可以更轻松地定制、转换和管理数据流。 设置流处理操作后,你可以根据特定的架构和流数据顺利地将数据流发送到不同的目的地。

重要

Fabric 事件流的增强功能目前以预览版方式提供。

不支持的操作

下面是支持实时数据处理的操作列表:

聚合:支持对值列执行计算并返回单个结果的 SUM、AVG、MIN 和 MAX 函数。

扩展:扩展数组值并为数组中的每个值创建一个新行。

筛选器:根据条件从数据流中选择或筛选特定行。

分组依据:聚合某个时间范围内的所有事件数据,并可以选择对一个或多个列进行分组。

管理字段:添加、删除或更改数据流字段或列的数据类型。

合并:将两个或多个具有相同名称和数据类型的共享字段的数据流合并到一个数据流。 删除不匹配的字段。

联接:根据两个流之间的匹配条件合并这两个流中的数据。

支持的目标

支持的目标有:

Lakehouse:此目标使你能够在引入湖屋之前转换实时事件。 实时事件会转换为 Delta Lake 格式,然后存储在指定的湖屋表中。 此目标有助于数据仓库应用场景。

KQL 数据库:此目标使你能够将实时事件数据引入 KQL 数据库中,可以在该库中使用强大的 Kusto 查询语言 (KQL) 来查询和分析数据。 借助 KQL 数据库中的数据,可以更深入了解事件数据并创建丰富的报表和仪表板。

Reflex:借助此目标,可以将实时事件数据直接连接到 Reflex。 Reflex 是一种智能代理,其中包含连接到数据、监视条件和操作所需的所有信息。当数据达到特定阈值或匹配其他模式时,Reflex 会自动采取适当的操作,例如提醒用户或启动 Power Automate 工作流。

自定义终结点(以前的自定义应用):使用此目的地,可以轻松地将实时事件路由到自定义应用程序。 借助此模板,你可以将自己的应用程序连接到事件流,并实时使用事件数据。 如果要将实时数据传出到 Microsoft Fabric 外部的外部系统,这会非常有用。

流:此目标表示由一系列操作转换的默认原始事件流,也称为派生流。 创建后,你可以从实时中心查看流。

以下示例演示三个不同的 Fabric 事件流目标如何为单个数据流源提供单独的函数。 一个 KQL 数据库被指定用于存储原始数据,另一个 KQL 数据库用于保留筛选的数据流,Lakehouse 则用于存储聚合值。

要根据内容转换和路由数据流,请按照编辑并发布事件流中的步骤操作并开始为数据流设计流处理逻辑。

相关内容

反馈

即将发布:在整个 2024 年,我们将逐步淘汰作为内容反馈机制的“GitHub 问题”,并将其取代为新的反馈系统。 有关详细信息,请参阅:https://aka.ms/ContentUserFeedback。

提交和查看相关反馈