每小時複製資料並使用動態參數進行轉換

適用於: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

提示

試用 Microsoft Fabric 中的 Data Factory,這是適用於企業的全方位分析解決方案。 Microsoft Fabric 涵蓋從資料移動到資料科學、即時分析、商業智慧和報告的所有項目。 了解如何免費開始新的試用!

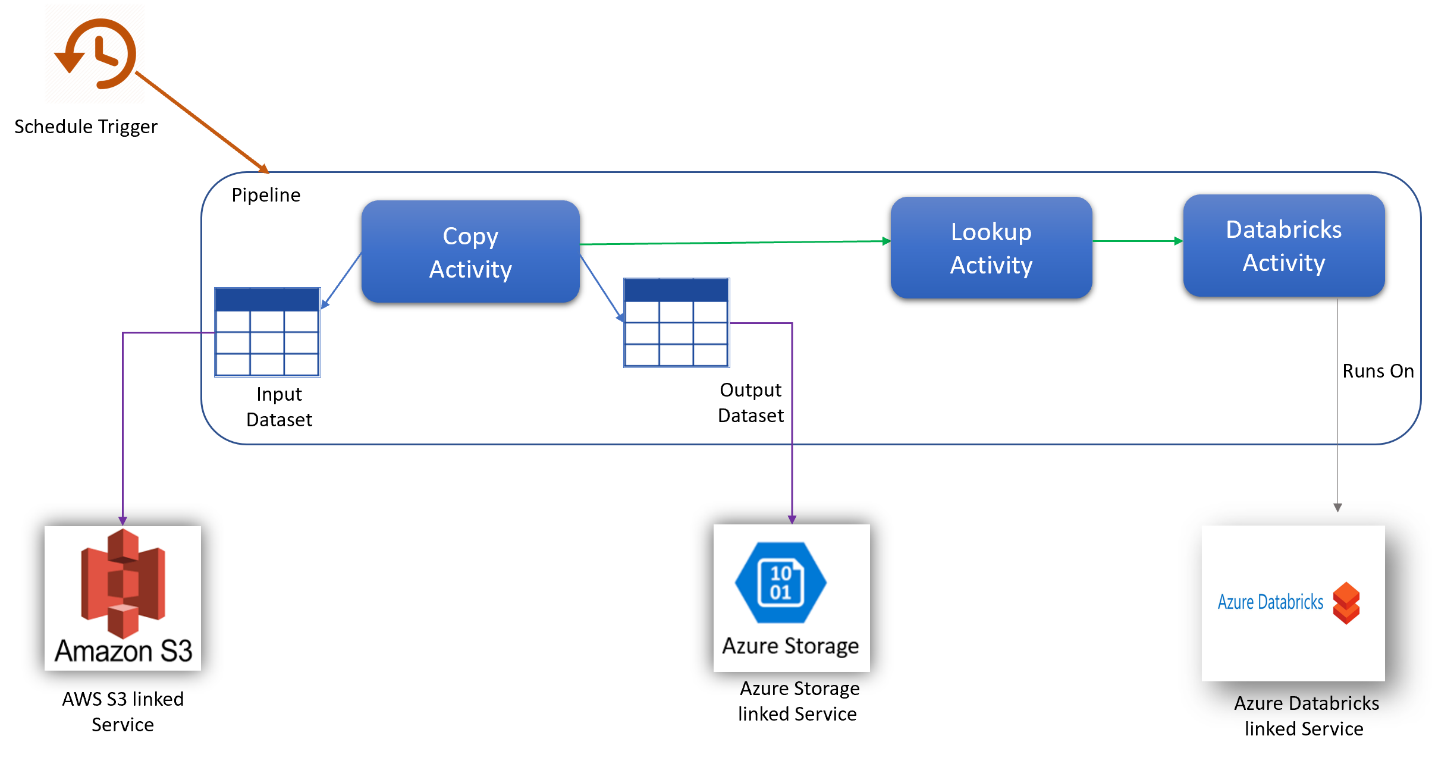

在此案例中,您想要依每天 8 小時的小時排程將資料從 AWS S3 複製至 Azure Blob 儲存體,並使用 Azure Databricks (透過指令碼中的動態參數) 進行轉換,持續 30 天。

下面這個範例中所使用的價格是假設值,並非表示確切實際價格。 系統不會顯示讀取/寫入和監視成本,因為這些成本通常是可忽略的,而且不會對整體成本造成太大的影響。 在定價計算機估計值中,活動執行也會四捨五入至最接近的 1000。

請參閱 Azure 定價計算機以取得更明確的案例,並估計未來使用服務的成本。

組態

若要完成案例,您需要使用下列項目建立管線:

- 一個複製活動,包含要從 AWS S3 複製資料的輸入資料集、Azure 儲存體上之資料的輸出資料集。

- 一個 Lookup 活動,用於以動態方式將參數傳遞到轉換指令碼。

- 一個用於資料轉換的 Azure Databricks 活動。

- 一個每天 8 小時每小時執行管線的排程觸發程序。 當您想要執行管線時,您可以立即加以觸發或安排排程。 除了管線本身之外,每個觸發程序執行個體都會被視為單一活動執行。

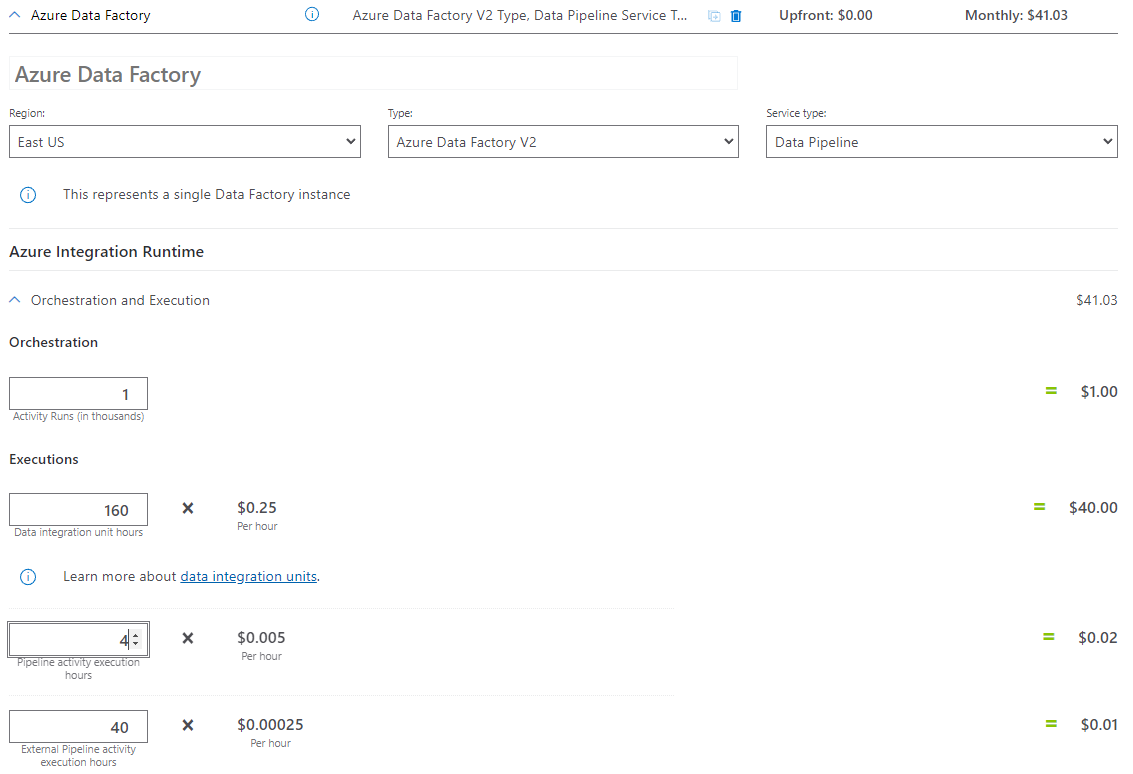

成本估計

| Operations | 類型與單位 |

|---|---|

| 執行管線 | 「每次執行」都有 4 個活動執行 (1 個用於觸發程序執行,3 個則用於活動執行) = 960 個活動執行,並會無條件進位至 1000,因為這是允許的最少遞增單位。 |

| 複製資料假設:「每次執行」的 DIU 小時 = 10 分鐘 | 10 分鐘\60 分鐘 * 4 Azure 整合執行階段 (預設 DIU 設定 = 4) 如需資料整合單位以及最佳化複製效能的詳細資訊,請參閱此文章 |

| 執行查閱活動假設:「每次執行」的管線活動時數 = 1 分鐘 | 1 分鐘/60 分鐘管線活動執行 |

| 執行 Databricks 活動假設:「每次執行」的外部執行時數 = 10 分鐘 | 10 分鐘/60 分鐘外部管線活動執行 |

定價範例:定價計算機範例

30 天的案例定價總計:$41.03